作者 | 袁峻峰

大数据文摘欢迎各类优质稿件

请联系[email protected]

本文基于大数据文摘免费公开课分享之-智能助理探讨。点击文末

阅读原文

查看当天视频回放。公开课总长近1小时,请在wifi环境下观看。暂时无法观看的读者请直接查看ppt和文字摘要。

人工智能已离我们的生活越来越近,各样的智能助理已慢慢融入我们的生活,包括微软小娜,亚马逊

Echo, Facebook M

,苹果

Siri

等。那需要什么样的智能助理,一直是个值探讨的问题。

研究者虽然不从事智能助理研发工作,但也是从事机器学习金融领域应用工作。

本次分享将结合经济、机器学习领域多位大神观点,包括诺贝尔经济学奖哈耶克,

图灵奖、诺贝尔经济学奖赫伯特·西蒙,人工智能先驱图灵奖马文

·

明斯基等,以及最新《未来简史》作者瓦尔

·

赫拉利相关观点。抛砖引玉,欢迎参与讨论。

一 需要什么样的智能助理

是《棋魂》中的佐为还是蜡笔小新?

前些日子,中国诗词大会 也掀起了不小热评, 原来中文诗词那么优美。

对于闲聊机器人来说,如果告诉其你失恋了,能回个

“

蓝瘦,香菇

”

。那这聊天机器人挺牛。一定是经常更新训练数据,与时俱进。

情感是难以描述的,“我们的精神状态是如此复杂,只能以类比的方式来描述”

[1]

,中国历来的文人墨客最是擅长比兴手法,我们不排除

“

蓝瘦,香菇

”

是一种表达,但中文中那么更优美的表达也不该忽略。

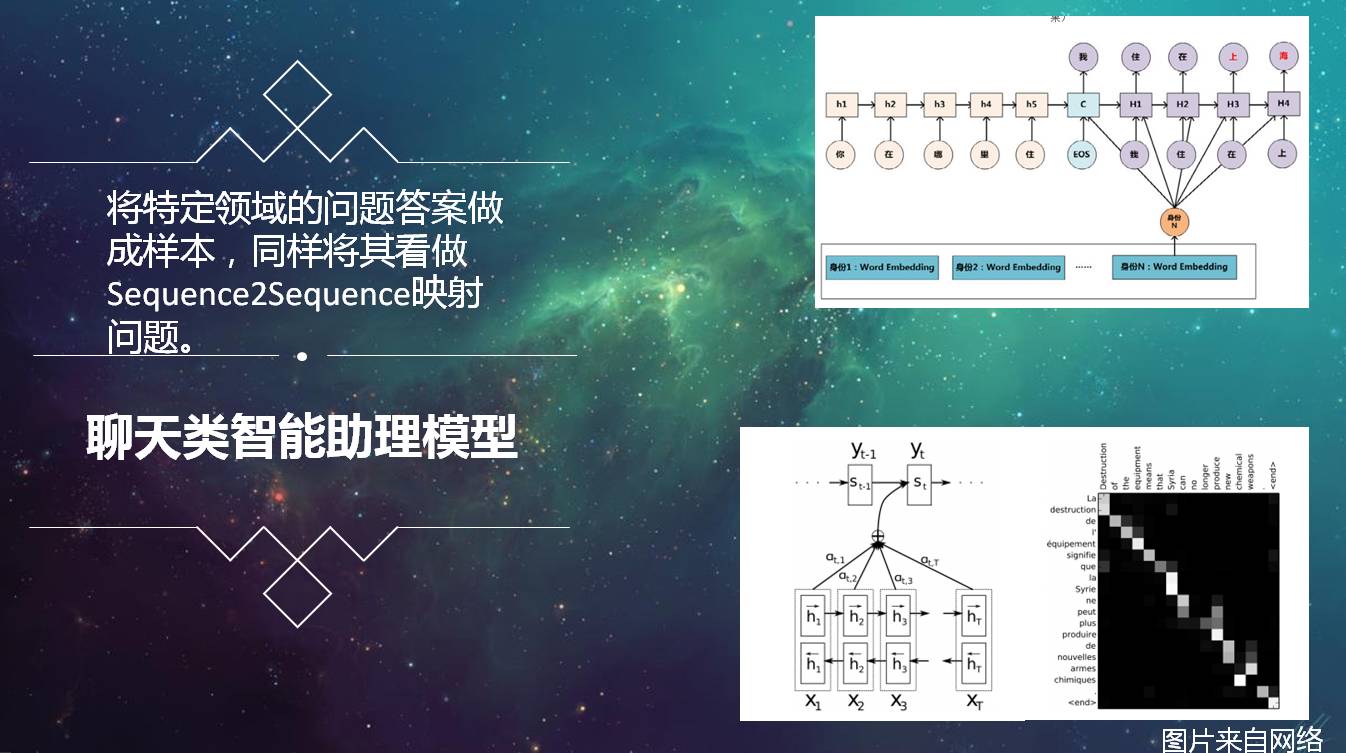

那我们如将特定领域的问题答案做成样本,同样将其看做

Sequence2Sequence

映射问题。通过深度学习模型去拟合这个复杂映射函数。且不说这是个有多少人工就有多少智能的方案。可以想象这种方式《棋魂》中的佐为肯定也是训练不出来的。

右边这是常用的端到端模型

:

RNN, LSTM, Atention

模型等

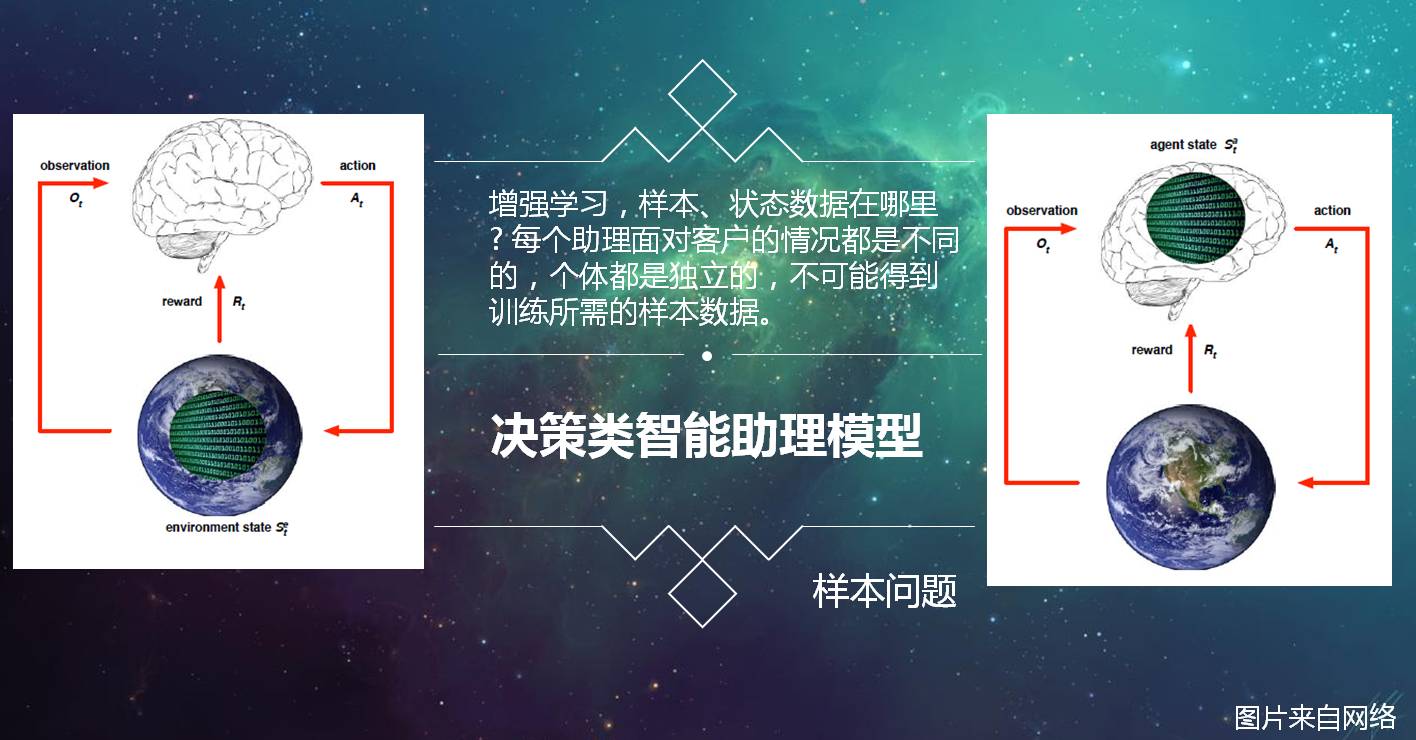

强化学习把学习看作试探评价过程,

Agent

选择一个动作用于环境,环境接受该动作后状态发生变化,同时产生一个强化信号

(

奖或惩

)

反馈给

Agent

,

Agent

根据强化信号和环境当前状态再选择下一个动作,选择的原则是使受到正强化

(

奖

)

的概率增大。选择的动作不仅影响立即强化值,而且影响环境下一时刻的状态及最终的强化值。

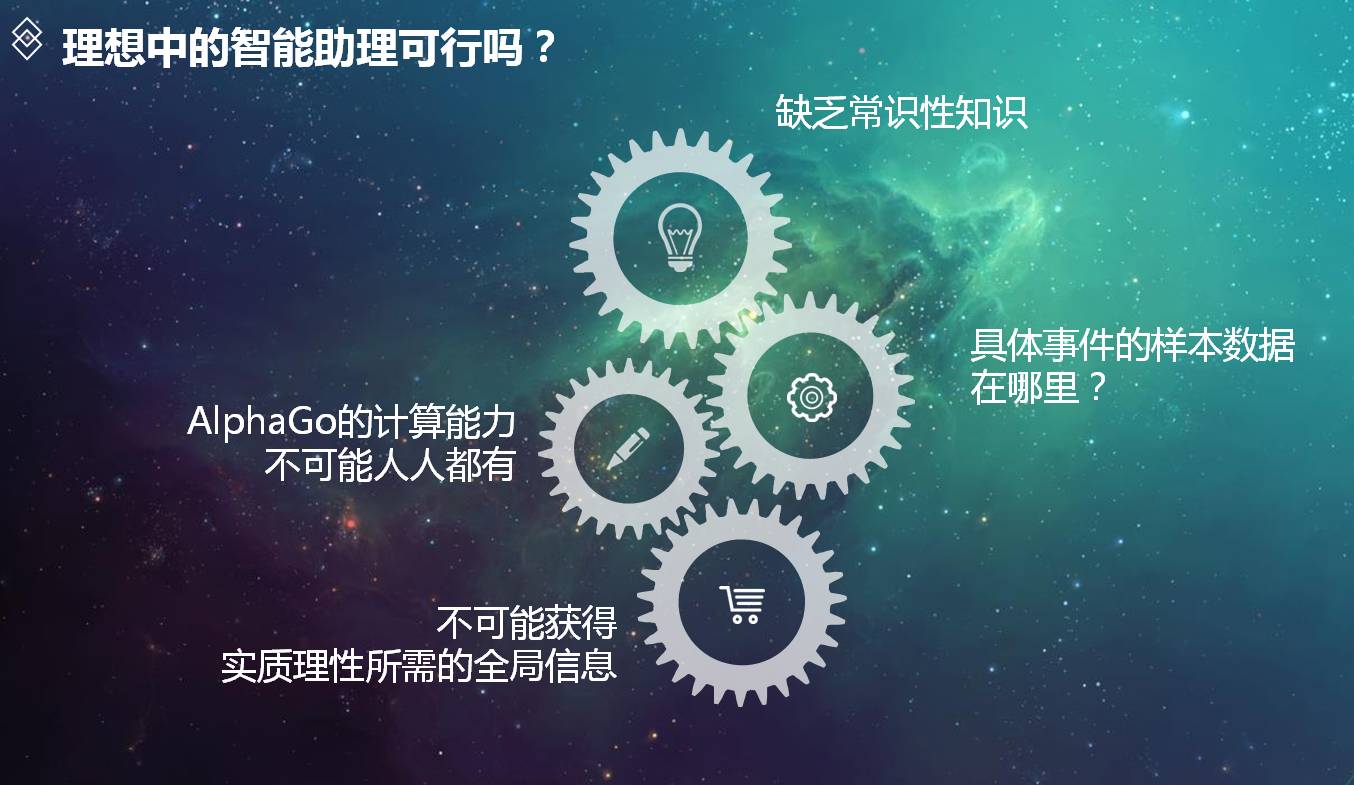

而智能助理面对的个人方方面面的任务,事件,无法得到那些专业的正样本数据

,

并且每个助理面对客户的情况都是不同的,个体都是独立的,更不可能得到训练所需的样本数据。

二

理想中的智能助理

之前有篇比较火的智能助理文章《为什么智能助理都像智障》,

“人工智能助理:这里指的是Intelligent personal assistant/agent (IPA)

,指帮助个人完成多项任务或多项服务的虚拟助理”

[2],

如何帮助?在文章

[2]

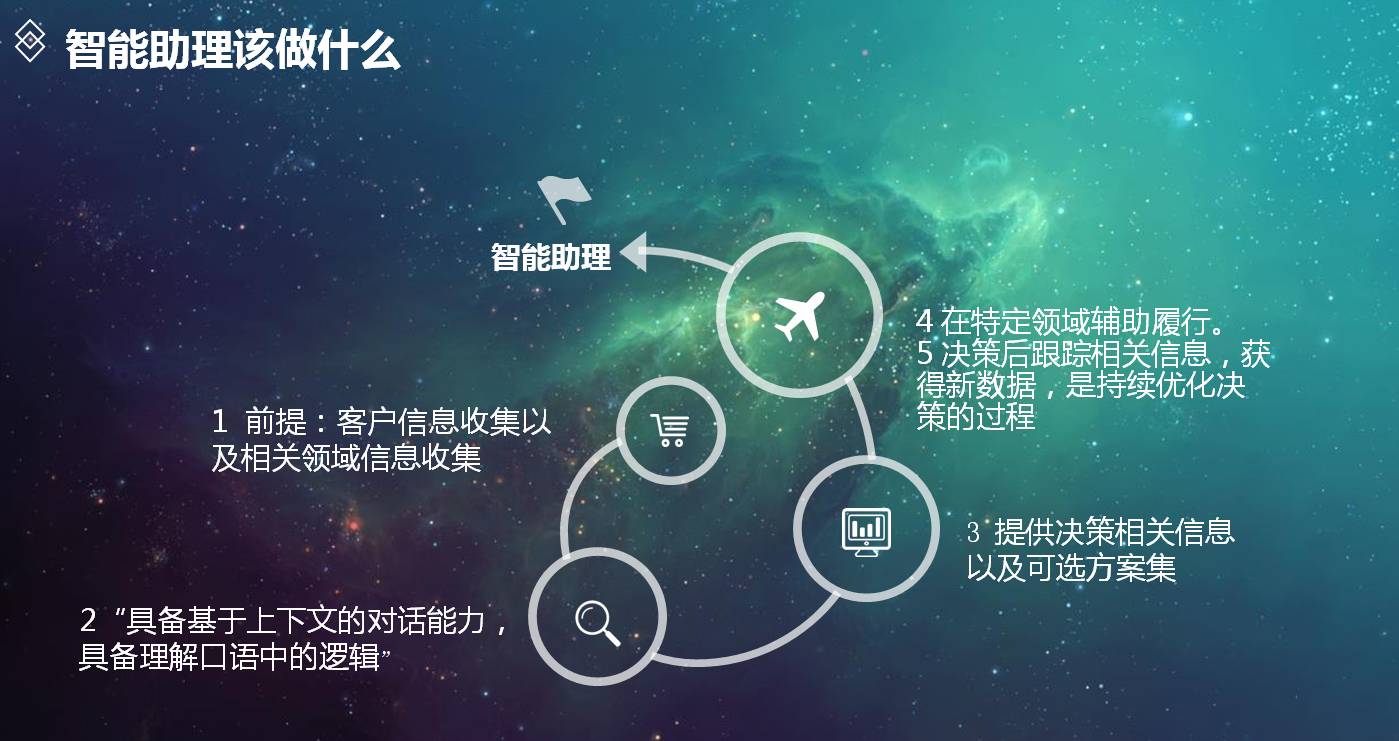

中,提出对话式助理至少满足这几点功能:

”

具备基于上下文的对话能力,具备理解口语中的逻辑,所有能理解的需求,都要有能力履行。

”[2]

能不能像

YY

玄幻小说中的深山偶获老法师灵体,之后在你修行中的方方面面问题中提供指导。比方《斗破苍穹》中的药老 。

三

理想中的智能助理的可行吗?

接下来是本次分享的一个重点内容,也是一个没有答案的探讨内容。

书中提到很多很有意思的观点:

等到无意识的人工智能算法

监测我们的身体、大脑的每个子系统,

会比

我们自我意识

清楚的掌握我们每个人需要什么。

我们日常中的决策大部分都是靠直觉,情感, 道德可以认为那是也是一种算法,

按照这种假设, 为我们方方面面决策提供建议的智能助理就是可行的。

可以认为市场也是一种算法,哈耶克是奥地利经济学派代表人物,诺贝尔经济学奖,他们认为,由于没有人有全局知识,主观的需求也无法量化,市场作为一种过程,也是一种分布式计算的方式,每个人都是从自己的利益出发,执行自己的最优选择,“看不见的手”。

百度百科中描述:莫拉维克悖论(

Moravec's paradox

)是由汉斯

·

莫拉维克、布鲁克斯、马文

·

明斯基等人于

1980

年代所阐释。人类所独有的高阶智慧能力只需要非常少的计算能力,例如推理,但是无意识的技能和直觉却需要极大的运算能力。如莫拉维克所写

“

要让电脑如成人般地下棋是相对容易的,但是要让电脑有如一岁小孩般的感知和行动能力却是相当困难甚至是不可能的。

”

马文

·

明斯基在其著作《情感机器》

[1]

中讨论了人类大脑思维运行方式,尝试设计能理解、会思考的人工智能,也讨论为什么会有莫拉维克悖论。书中明斯基提出

“

所有的现代程序都不具备常识性知识

(Commonsense

Knowledge)”[1]

所以会给人感觉有时不够智能。

“

专家是一位无须思考就知道结果的人

”[1],

所谓常识可以认为是一种直觉。爱迪生说过“天才就是

99%

的汗水

+1%

的灵感,但没有这

1%

的灵感那

99%

的汗水也是徒劳

”

,灵感既大师在决策时的直觉。“

目前要让人工智能有如小孩般的学习能力与通用常识都很遥远。更别说像大师、领域专家为各样的决策提供建议。扎克伯格在搭建他的智能助理

Jarvis

时也说

“

我们距离了解学习的本质仍然很遥远

…

我们仍然不知道将从一个领域中获得的想法应用到另一个完全不同的领域中去。

“[3]

四

智能助理该做什么

既然智能助理定位不是在收集各样信息的基础上,结合其强大的计算能力和人类已有的决策样本数据提供预测与决策建议。那是不是可以退一步,定位在收集各样信息,并辅助人类决策呢?根据诺贝尔经济学奖,图灵奖获得者郝伯特

·

西蒙的不确定性环境下决策理论:应当是有限的理性,而不是全知全能的理性;应当是过程合理性。

五 总结

-

基于端到端样本数据的深度学习模型并不是智能助理的唯一模型。

-

智能助理的定位不是提供各领域问题的专家建议与预测。是在收集相关信息的基础上,结合其强大的计算能力为决策提供合适的事实信息以及可选的方案。

-

符合郝伯特·西蒙的不确定性环境下决策理论,以过程理性解决问题的持续优化的过程。不只是预测。

参考文献:

[1] 马文·明斯基. 情感机器[M]. 浙江人民出版社.2015,12.

[2] Mingke.为什么现在的人工智能助理都像人工智障?[OL].S先生.2016-11-21.

[3] 扎克伯格.扎克伯格开发笔记:打造Jarvis的日子,我庆幸自己从未停止过编程