课程包括RL/RLHF、LLM加速、LLM分布式训练、手撕多模态VLM、手撕o1推理等内容,且提供了完整的知识体系,拒绝知识碎片化。

课程提供源码工程、Notebook等学习资源,方便学生随时学习,并且可以通过图解复杂公式、代码实现细节等方式加深理解。

我是

小冬瓜AIGC

,原创超长文知识分享

原创课程已帮助多名同学上岸

LLM

赛道

知乎

/

小红书

:

小冬瓜AIGC

o1模型展现了惊艳的推理能力

RL+搜索起到了关键的的作用

【手撕LLM】课程更新第14章节

手撕o1推理

部分手撕算法notebook

文档

以上仅摘选第14章节内容

完整课程详情如下

一、课程概况

-

课程内容:直播 + 往期录播 + 手撕级Notebook + 非调包Code + 算法图解 + 课程PPT

-

课程项目:垂域大模型实操 + DeepSpeed多卡RLHF训练

-

进阶专题

:

手撕o1推理、手撕

RL

、手撕

RLHF

、手撕多模态VLM

、LLM加速、LLM分布式训练、手撕RLHF-PPO Notebook

-

实操效果

:本课程Code仓库,

实战多卡训练,已全线支持Llama-3-8B/70B的

SFT

/

DPO

/

PPO

训练;

低成本百元 8B DPO训练

-

LLM社群

:

学员超过50%来自海外

。部分就业于北美大厂

META、微软、亚麻、苹果、谷歌、TikTok

和eBay等,海外学历背景PhD居多,

MIT、宾大、UIUC、NYU、UCL

等;国内

清华、复旦

居多。(

教学成果详见下文

)

-

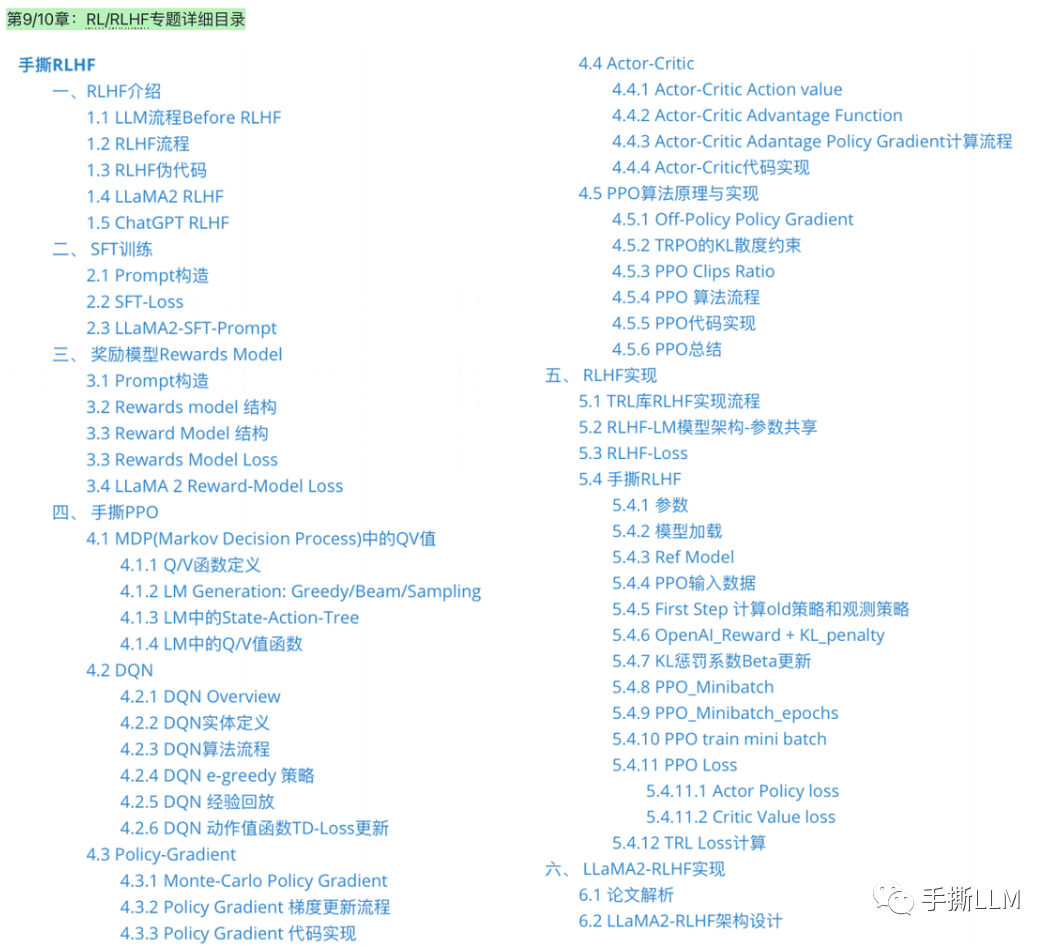

详细目录:第9/10章节-RL/RLHF

第11章节-LLM加速(以长文档形式授课)

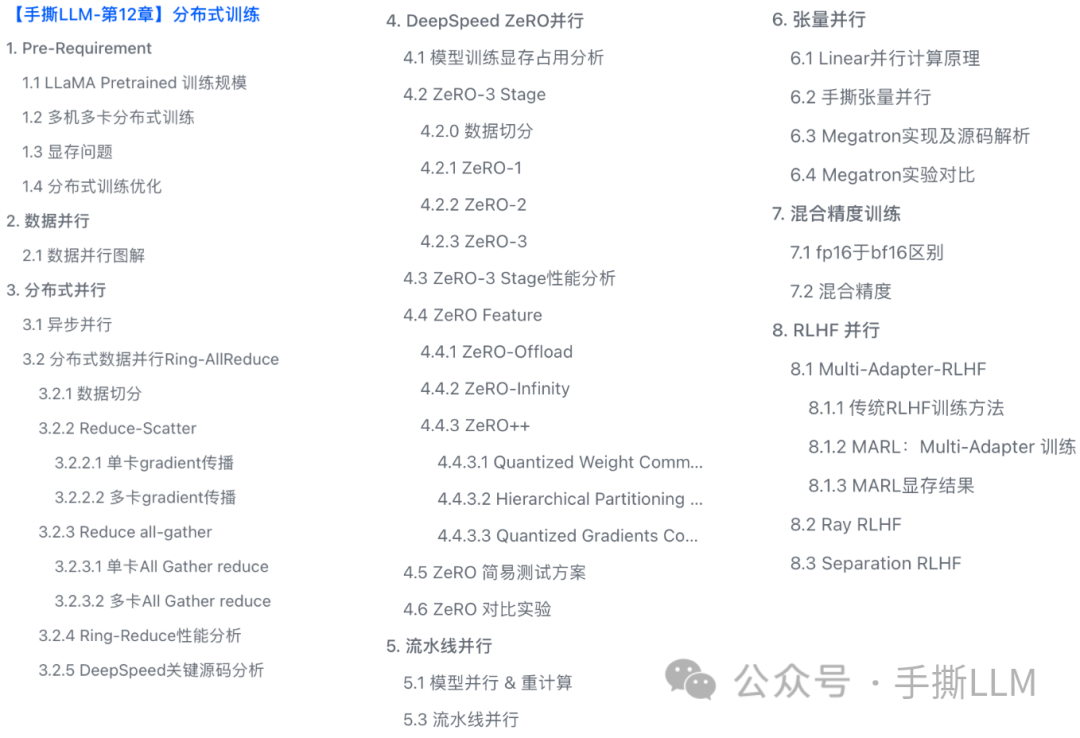

第12

章节-LLM分布式训练(

以

长文档形式授课

)

第13章节-手撕多模态VLM(以长文档+手撕代码形式授课)

第14章节-手撕o1推理(

以长文档+手撕代码形式

授课)

其他新增内容

-

Notebook:

MCTS, BPE, BeamSearch, AutoGrad, CrossEntropy, PPL

,

Layernorm Backward

,

Tensor Parallel

,

BTModel

,

DPO

,

IPO

,

KTO

,

NTK-RoPE

,

Llama-3-GQA

,

MoE

-

测评:

vllm推理部署、

CMMLU、MMLU、CEVAL、safety测评

三、课程内容详情

3.1 实操项目

实操项目1 :垂域LLM微调Notebook

实操项目2 :DeepSpeed + SFT + DPO + RLHF-PPO 代码仓库

D

eepSpeed多卡RLHF-PPO训练实操代码仓库

Llama-3-8B 全流程实操训练效果

基于Llama-3-8B 预训练模型,混合中英alpaca和ruozhiba数据;

全参微调SFT,轻松回复ruozhiba问题

QLoRA高效微调DPO、Reward Model和PPO

项目新增70B SFT/DPO/PPO 训练方案

70B 模型PPO 训练耗时

实践平台:A100(80G)x8

3.2 课程直播+录播

3.3 课件PPT

3.4 源码工程+Notebook

-

pytorch工程,代码精简,全部调试可运行,CPU都能Run的代码

-

复杂代码Notebook随手debug,不惧手撕代码

-

非调包级工程、坚持逐行代码剖析算法原理,从代码视角,解密复杂的公式原理。

手撕RLHF PPO代码-Pytorch实现, 不依赖RL库

LLM中的RLHF-PPO算法复杂,

逐行手撕LLM中的PPO算法,

主要

通过Pytorch实现。

包含

4个模型:Ref/Actor/Critic/Reward、

PPO采样及训练流程、

Loss计算Actor Loss+Critic Loss+Entropy、

reward+KL散度...

四、LLM社群 & 教学成果

4.1 内部LLM社群

-

-

部分学员就职:

META

、微软、亚麻、苹果、谷歌、TikTok、高通

和eBay等,部分阿里、百度、腾讯和华为等

-

学历背景:海外

MIT、宾大、UIUC、NYU、UCL

等;国内

清华、复旦

居多。

-

部分学员本身从事 LLM 相关岗位精进,有的本身就在各大厂做 LLM 相关的负责人,手上也有HC,能直接接触到一线的机会

4.2 教学成果(已知部分展示)

-

1️⃣ 【海外】META E5 Senior

-

2️⃣【海外】TikTok核心部门,总包翻番至200+,DS转MLE

-

3️⃣【国内】清华硕0LLM经验,总包70翻番至130+,成功上岸LLM

-

4️⃣【海外】应届PhD上岸亚麻做 Researcher

-

5️⃣【海外】制药公司获得晋升拿下GenAI组Leader

-

6️⃣【国内】科大讯飞高岗

-

7️⃣【国内】社科女PhD凭借RLHF成功拿到国内多家高校副教授教职及北航师资博后

-

8️⃣【国内】40岁失业,0 LLM经验,撸课后成功入职深圳某LLM公司(非大厂)