作者在整理

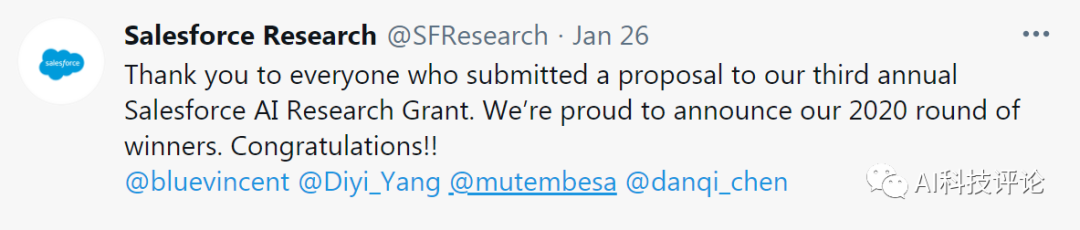

Salesforce研究院宣布了2020年度Salesforce人工智能研究基金的获奖者

情况时,发现往届华人获奖者职位屡新。其中包括

主要研究方向包括自然语言处理和计算社会科学

的

谭宸浩博士

。

谭宸浩

博士,刚刚离任美国科罗拉多大学博尔德分校助理教授,现任

芝加哥大学社计算机科学

系

助理教授。同时兼任于

芝加哥大学哈里斯公共政策学院

。

同时指导

芝加哥人类+ AI实验室

(CHAI)

。

谭宸浩

博士

此前于康奈尔大学获得计算机博士学位,本科毕业于清华大学获计算机和经济学双学位。在科罗拉多大学就职之前曾在华盛顿大学任博士后。主要研究方向包括自然语言处理和计算社会科学。论文主要发表在ACL,WWW,KDD,WSDM和ICWSM。很多工作得到著名媒体报道,如纽约时报和华盛顿邮报。被选为Facebook fellow,荣获Yahoo!关键科学挑战奖。

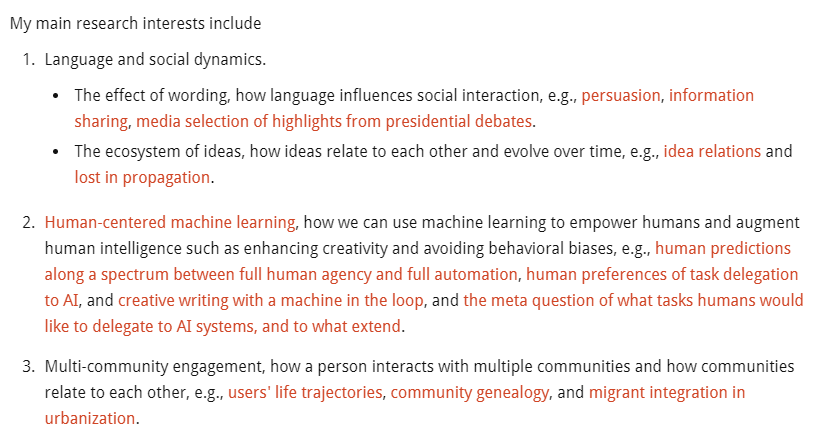

主要研究自然语言处理,计算社会科学,具体包括语言和社会动态、以人为中心的机器学习、多社区参与,一个人与多个社区的互动方式以及社区之间的相互关系。

根据他的个人主页所示,他的主要研究兴趣包括:

另外,他还在在招聘一名

博士后

,有兴趣的朋友可以点击

原文链接

追踪。

个人主页:https://chenhaot.com/

另外我们关注一下,2020年度的Salesforce人工智能研究基金的获奖者。

本年度一共有六位AI领域的学者入选,其中就包括大家比较熟知的

陈丹琦

和

杨笛一

。

Salesforce研究院将为每一位获奖者提供5万美元的资助,以推动他们的研究工作来帮助塑造人工智能的未来。

据了解这是Salesforce第三年提供这项研究基金,本次申请人数破了纪录。一共有来自30多个国家的180多个高质量学进行申请。在这轮申请中,Salesforce研究院最终根据申请提案质量、idea的新颖性以及与Salesforce提出的研究课题的相关性,授予6位AI学者研究基金资助。

以下对

陈丹琦和杨笛一二人做简单介绍。

陈丹琦

陈丹琦

是普林斯顿大学计算机系助理教授,

她将深度学习用于一系列自然语言处理重要问题,帮助机器获取知识、更好地回答问题。

基于自然语言处理(NLP)的人机对话正在创造一个新的交互时代,但在这个时代真正爆发之前,还有巨大的挑战摆在我们面前:机器在阅读人类语言文字和模拟人类的语言能力上仍面临着非常多的难题和限制。

作为一名 NLP 学者,陈丹琦过去 6 年多的研究工作,正在一环扣一环地为机器解开“枷锁”。29 岁的她现为普林斯顿大学助理教授,还在通过自己的研究继续加速这个过程。

斯坦福大学语言学和计算机科学教授、自然语言处理泰斗 Dan Jurafsky 曾如此评价她:“陈丹琦在发现重要的研究问题上很有品位。她已经对该领域产生了非凡的影响,并且她的影响只会越来越大。”

当今的 NLP 研究领域新星中,陈丹琦绝对是最值得关注的学者之一。

例如陈丹琦在 2014 年发表的论文“A Fast and Accurate Dependency Parser using Neural Networks”,就是深度学习依存分析方法的开创性研究,该成果实现了一个准确快速的依存句法分析器(Dependency Parser),解决了语义分析此前曾普遍存在的部分难题。这项研究也成为了日后谷歌 NLP 团队等在后续分析器上进一步研究的基础。

而在改良问答系统的表现上,陈丹琦在 2017 年的论文“Reading Wikipedia to Answer Open-Domain Questions”为这个问题的解决打开了很多新的方向。

2018年年底,陈丹琦完成了她名为“Neural Reading Comprehension and Beyond”的 156 页博士毕业论文。

杨笛一

杨笛一现为佐治亚理工学院交互计算系助理教授,隶属于机器学习中心。

本科就读于上海交通大学ACM班,随后赴卡内基梅隆大学语言技术研究所攻读硕士、博士,并于2019年获得卡内基梅隆大学博士学位。

她的研究兴趣包括计算社会语言于自然语言处理。

她曾连续三年获得Facebook博士生奖研金(2017-2019),她的工作曾获得EMNLP 2015、AAAI 2016网页与社交媒体、2019年ACM CHI等顶会的最佳论文提名。

获奖proposal:

用于结构化预测的有限数据的语言信息学习

在深度学习时代,自然语言处理(NLP)在大多数数据密集型环境中都取得了非常好的表现。

但是,当只有一个或几个训练示例时,有监督的深度学习模型通常会失败。

AI对标记数据的这种强烈依赖性在很大程度上阻止了将神经网络模型应用于新的环境设置或现实世界当中。

为了减少有监督模型对标记数据的依赖性,人们设计了各种数据增强方法,尽管这些方法在诸如文本分类的许多NLP任务中得到了广泛使用,但是在涉及单个句子可能具有各种相互关联的结构和标签的结构化预测任务时,这些技术通常仍难以创建具有语言学意义的、多样化且高质量的增强样本。

为了在少样本学习中用有限的数据训练更好的结构预测模型,并减少它们对有标记的结构化数据的依赖性,我们提出了一种新颖的数据增强方法,可以基于局部可加性来创建无限的训练样本,且可以将经过增强的样本约束样本直接互相接近。为了进一步增强有限数据的学习,我们将通过设计未标记数据及其扩充之间的语言信息自监督损失,将这些局部可加性增量用于半监督的少样本学习。

我们在两个经典的结构化预测应用程序任务中(NER和语义解析)证明了这些模型的有效性。

本文的后续对“Salesforce人工智能研究基金”介绍来源于 “Deeptech深科技” 和 “AI 科技评论” 公众号