图片来源

:pixabay

原文来源

:

arxiv

作者:Gary Marcus

「雷克世界」编译:KABUDA

尽管深度学习拥有较为久远的历史,但就在五年前,“深度学习”一词及其方法还并不流行。2012年,Krizhevsky、Sutskever和Hinton等人在论文中提出了经典的深度网络模型Imagenet,这使得深度学习重新回归大众视野,并逐步变得炙手可热。

自那时(2012年)起,深度学习领域在随后的五年中又有哪些新的研究成果?在期刊杂志对语音识别、图像识别及游戏交互等领域的快速发展,进行争相报道的背景下,我提出了关于深度学习的10个问题,并给出了我的建议:如果想提高人工智能的发展水平,就必须将深度学习其他技术相结合。

深度学习的发展到达瓶颈了吗?

虽然深度学习有着几十年的发展历史,但直到五年前才真正引起人们的关注。几乎所有的转机都发生在2012年,这一年出现了大量极具影响力的论文,如Krizhevsky、Sutskever和Hinton等人当年发表的ImageNet Classification with Deep Convolutional Neural Networks一文,该论文使得ImageNet因其在目标识别方面取得的先进的成果而被世人所熟知。随后,其他实验室也开展了类似的研究。在2012年年末,深度学习登上了《纽约时报》的头版,并迅速成为人工智能领域最著名的技术。如果说,训练多层神经网络的构思早已是老生常谈的话题,那么随着计算能力的提升和数据量的增长,使得深度学习开始在一定程度上变得真正实用起来。

自那时起,深度学习在语音识别、图像识别和语言翻译等领域取得了诸多先进成果,并在当前广泛的AI应用领域中发挥了突出作用。许多公司投入了数十亿美元用来争夺深度学习领域的人才。著名的深度学习倡导者Andrew Ng给出了这样的建议:“如果一个人可以用不到一秒钟的时间完成一项智力任务,那么在现在或者将来,我们可以通过利用AI来实现自动化”。最近,纽约时报周末杂志刊登的一片关于深度学习的文章,揭示了深度学习“有望重塑计算本身”。然而,正如我之前在beginning of the resurgence、as leading figures like Hinton和Chollet等论文中预测的那样,深度学习的发展或许已经到达了瓶颈,并且近期已经有相关的现象出现。

深度学习究竟是什么?智能的本质又是什么?我们期待它能够做些什么?我们希望它能从哪些方面带来突破?我们距离“通用人工智能”还有多远?机器在哪一方面展示出了人类所不具备的解决问题的灵活性?本文的目的是为了打破某些不理性的幻想,并反思我们应该在哪些领域谋求发展。

本文是为了深度学习领域的研究人员、日益增多的AI消费者(这些人往往不具备丰富的技术知识)以及其他希望了解该领域的人而撰写的。因此,我们从一个简短而通俗的介绍开始,首先阐明深度学习系统在哪方面表现出色,以及为什么能有如此出色的表现。然后,对深度学习存在的不足进行点评,并揭示一些因误解深度学习的作用而产生的恐惧心理,最后以前瞻性的预测作为结束。深度学习不可能,也不应该消失。然而该领域近五年的快速发展,似乎是一个深刻反思的契机,我们应反思哪些是深度学习可以实现的,哪些又是其无法实现的。

什么是深度学习?它有何出色表现?

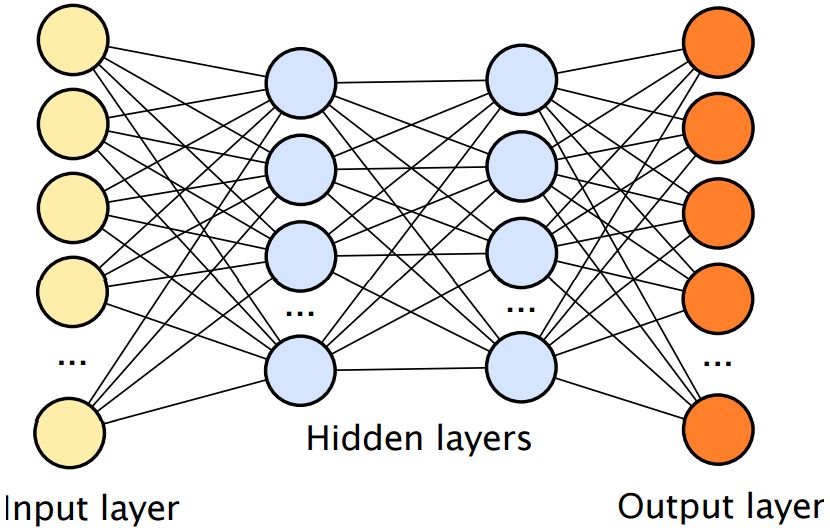

深度学习主要是一种使用多层神经网络,对样本数据进行分类的统计技术。深度学习中使用的神经网络主要由一组表示像素或单词的输入单元、多个隐藏层(隐藏层越多,网络越深),包括隐藏单元(也称节点或神经元)和一组输出单元(在这些相互连接的节点/神经元之间运行)组成。在一个典型的应用程序中,这样一个网络可以通过大量的手写数字(表示图像,作为输入)和标记(作为输出)进行训练,以识别这些输入所属的类别(如,这个图像是2,这个图像是3,等等)。

深度学习系统最常被用作分类系统,因为典型网络的任务是确定给定的一组输入属于哪一类别(由神经网络上的输出单元定义)。有了足够的想象力,分类的力量是巨大的;输出可以表示单词、围棋棋盘的上的位置以及其他任何内容。

在一个拥有大量数据和计算资源的世界里,可能对于技术的需求非常少。

深度学习的局限性

深度学习的局限性在于对立面(contrapositive):我们生活在一个充斥着无限数据的世界里,因此,深度学习系统经常需要将数据扩展到已知数据之外,可能是一个新单词的发音,或是一张从未见过的图片,在已知数据有限的情况下,深度学习的性能表现往往会受到限制。

正如我们将要探讨的那样,泛化具有两种形式,已知样本之间的差值和插值(interpolation)和外推(extrapolation),这需要超出已知训练样本的空间。

神经网络的泛化,一般需要拥有大量数据,而且测试数据必须与训练数据相似,从而可以在旧的数据之间插入新的答案。在Krizhevsky等人的论文中,一个具有6千万个参数和65万个节点的9层卷积神经网络,在大约100个不同的样本上进行了训练。

这种“粗暴”的方法在Image Net中得到了很好的应用,所有的刺激(stimuli)都可以被分到一个相对较小的类别中。它还适用于像语音识别这样相对稳定的领域,在该领域中,样本被不断地映射到一个有限的语音类别集合上,是由于诸多原因,深度学习不能成为人工智能的通用解决方案。

过度炒作的潜在风险

目前,过度炒作人工智能,会带来的最大风险是引发人工智能的“冬天”。 比如在上世纪70年代,Lighththill的报告打破了AI领域的研究。该报告称AI太过脆弱、太过狭隘、太过肤浅,无法在实践中使用。尽管如今,AI在现实生活中的应用,已经比20世纪70年代更加广泛,但炒作仍然是一个不可忽视的问题。当Andrew Ng这样的知名人士,在《哈佛商业评论》中写道,他承诺即将实现的自动化程度与现实不符时,人们的期望就有了新的风险。事实上,机器并不能像人类那样做很多事情,如感知世界和理解语义。任何人都不会把乌龟误认为冰箱, 也不会把停车标志误认为冰箱。

大量投资AI的高管们可能会感到失望,尤其是考虑到AI对自然语言的理解水平尚且较低。目前,已经有一些重大项目被放弃了,比如Facebook的M项目,这个项目于2015年8月推出,曾作为一个普通的私人助理而大肆宣传,后来被降级为一个小得多的角色,只是帮助用户完成范围很小的明确任务,如日历条目等。

就事实而言,聊天机器人总体上并没有达到几年前所宣传的效果。再比如,相较于早期的宣传而言,无人驾驶汽车同样令人失望,它被证实在大规模推广时是不安全的,同时,在做出大量承诺后,无人驾驶汽车没有实现充分的自主权。类似的事情可能导致AI领域的受欢迎程度和资金投入量大幅缩水。

哪些方面会更好?

虽然我指出了很多问题,但我并不认为我们应该放弃深度学习。

相反,我们应该对其进行重新定义:它不是一种万能工具,而是众多工具中的一个。在这个世界上,我们不仅需要凿子、钻头、电压表、逻辑探头和示波器,我们还需要锤子、扳手和钳子。

在拥有大量数据的感知分类(perceptual classification)领域,深度学习是一种富有价值的工具,而在其他更加丰富的认知领域,它往往不尽如人意。

作为一种衡量进步的标准,值得思考的是我5年前在《纽约客》上发表的一篇有些悲观的文章,在那篇文章中,我推测“深度学习只是构建智能机器的诸多挑战之一”,因为“这种技术缺乏表达因果关系(如疾病与症状之间的因果关系)的方式,而且在获得诸如‘兄弟姐妹’或‘完全相同’之类的抽象概念方面也会面临挑战。 它们没有明显的逻辑推理方法,对于抽象知识的整合也还有很长的路要走,比如关于什么是对象、对象用来做什么、以及如何使用对象等等”。

正如我们所看到的,尽管在语音识别、机器翻译和棋盘游戏等某些领域取得了重大进展;尽管在基础设施建设、数据量和计算量方面也取得了令人印象深刻的进步,但其中仍有许多问题没有得到有效解决。

有趣的是,在去年,越来越多的曾拥有不同观点的学者开始强调相似的限制。部分名单包括Brenden Lake和Marco Baroni、Franouis Chollet、Robin Jia和Percy Liang、Dileep George等人、Pieter Abbeel及其在Berkeley的同事。

或许最值得注意的是,Geoff Hinton勇敢地反思了自己的信仰。他在8月接受新闻网站Axios的采访时透露,他对反向传播“非常怀疑”,因为他担心对标记数据集产生依赖,然而,这曾是帮助他开展深度学习研究的一项关键动力因素。

相反,他指出(Axios的改述)“可能不得不发明全新的方法”。

原文链接:

https://arxiv.org/ftp/arxiv/papers/1801/1801.00631.pdf

欢迎个人分享,媒体转载请后台回复「转载」获得授权,微信搜索「ROBO_AI」关注公众号