近期,DeepSeek的火爆出圈,直接撬动了资本市场对AI+产业链的投资热情。不仅在2月5日开工第一天,DeepSeek概念指数大涨14.73%,AI应用端和科技全线拉升,2月6日早盘仍显示,A股TMT科技板块延续强势,DeepSeek、AI算力概念继续活跃。

而就在新年开工、DeepSeek概念指数大涨的同一天,中国大模型市场又传出重磅新闻:百度智能云成功点亮昆仑芯三代万卡集群,成为国内首个正式点亮的自研万卡集群。模型上线首日,已有超1.5万家客户通过千帆平台进行模型调用。

这不仅标志着百度在自研芯片与大规模AI算力布局上的又一次重大突破,也预示着AI模型的训练成本将迎来新一轮下调,整个行业的发展再次被注入新动能。

那么,在各大科技巨头都加速推进AI算力基建的当下,万卡集群究竟是什么?为何大家都在积极推进自研、自建万卡集群?国产万卡集群的不断演进,又将给智算产业带来怎样的改变?

国产万卡集群,中国AI新突破

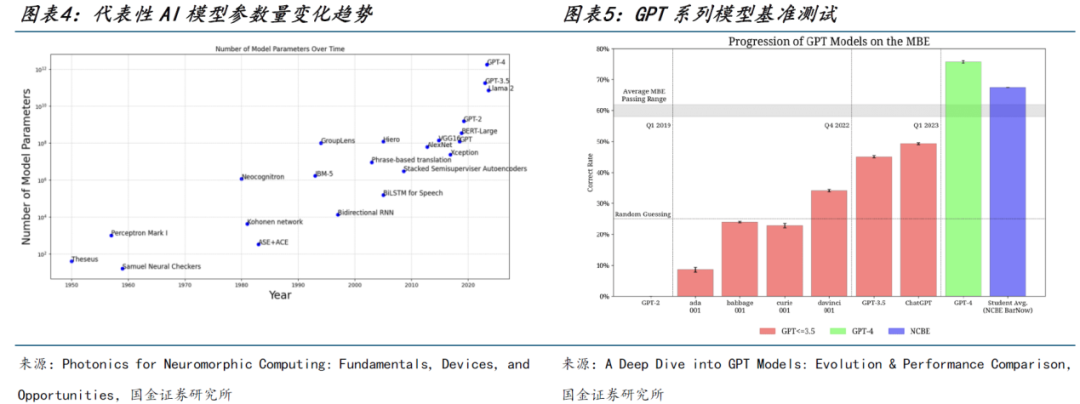

近年来,随着AI大模型的不断涌现,模型规模和数据参数都呈现出指数级增长。

例如在前期训练,据了解,2018年OpenAI发布的GPT-1模型参数量为1.17亿;到2020年,GPT-3的参数量已达到1750亿;2023年,GPT-4的参数量进一步增长到约1.8万亿。

参数量的快速增长推动了AI模型性能的大幅提升,使其在自然语言处理、图像识别等领域的表现越来越好。但同时,模型参数量的增长也让AI 模型训练的算力需求每3.5个月翻一番,每年所需算力增幅高达10倍,增速远远超出了芯片产业长期存在的摩尔定律(性能每18个月翻一番)。

图源:

国金证券研究所

图源:

国金证券研究所

以拥有16个专家模型、约1.8万亿参数的GPT-4为例,其训练约使用了 25000个英伟达(NVIDIA )的A100 GPU ,持续时间长达90至100天,对算力的消耗非常大。

并且,除了训练时的算力需求,随着大模型及应用越来越多地部署到企业实际业务场景中,后期推理的算力需求也水涨船高。因此,大规模 GPU 算力集群成为必然选择。这也是为什么近年来国内外科技厂商纷纷布局 AI 算力基础设施,死磕万卡甚至10万卡集群。

而“万卡集群”,顾名思义,是指由超过一万张加速卡(如GPU、TPU或其他专用AI加速芯片)组成的高性能计算系统,用以加速人工智能模型的训练和推理过程。

图源:

百度

图源:

百度

相比于训练周期长、成本高的传统千亿参数模型,万卡集群首先在计算能力、数据处理速度和存储容量等方面都有着质的飞跃。它能够通过并行计算和分布式处理,将庞大的数据和模型有效地组织起来,显著缩短模型的训练周期,提高研发效率。

其次,作为一种灵活的计算基础设施,万卡集群能够根据不同的应用需求进行定制化的配置和优化,同时支持更大规模模型和更复杂的多模态任务,比如智能医疗诊断、自动驾驶技术、自然语言处理等领域。这既为AI技术的创新和发展提供了更广阔的空间和可能,也为企业在AI领域的竞争中赢得先机。

此外,万卡集群通过提升算力利用率、简化用户部署流程,也降低了AI技术的使用门槛,进而推动其在各个领域的广泛应用。

但在《节点财经》看来,万卡集群虽好,但想要成功搭建也不是易事。

据了解,要想建设万卡集群规模的算力中心,通常要面临几大挑战:

●

算力使用效率:

集群规模提升不等于算力线性提升,关键在于互联网络和软硬件适配调优。需运用系统工程方法,精细化设计网络和软硬件整合优化,以提升集群算力使用效率。

●

海量数据处理:

未来万亿模型的训练对checkpoint的读写吞吐性能更是要求高达10TB/s,需通过协议融合、自动分级等技术手段提升数据共享和处理能力。

●

多芯混训难题:

受限于芯片厂商的产能,AI企业经常采用不同型号、不同厂商的芯片来组建算力集群。这些芯片在性能、架构、指令集等方面都存在差异,如何让它们在同一个集群中协同工作,并且保证混部训练的效率,是一个亟待解决的问题。

●

智算中心设计:

高能耗、高密度的智算中心对于空间和能源的需求,远远超过了传统机房部署方式的承载能力。这就要求在建设之初,提前对智算中心的供电制冷、承重等进行配套设计,以便更好支撑超万卡集群的快速建设、便捷部署。

●

稳定性与运维:

万卡集群中的计算卡数量庞大,网络连接复杂,且当单卡可靠性为99.99%时,万卡集群整体可靠性仅36.7%。一旦出现故障或延迟,将直接影响整个集群的计算效率和稳定性。

图源:

百度

图源:

百度

正如此前中国工程院院士、清华大学计算机系教授郑纬民所言,当下构建国产自主万卡系统充满挑战,但“至关重要

”

。

百舸平台赋能,让中国AI产业率先“跑”起来

目前,国内智算中心的搭建有国内外芯片“混搭”和全部国产化两种集群模式,而后者关乎一国在迈向通用智能征程中的核心竞争力。

正是意识到这样的重要性,百度一直探索用自研芯片搭建自主可控的算力生态系统,始终将助力实现 AI 基础设施国产化作为核心目标。

据了解,此次万卡集群的成功点亮,得益于百度在硬件和软件方面的技术创新。

在硬件层面,自研芯片保障了在生成式AI时代的技术主权。此次支撑万卡集群高效运行的昆仑芯三代,延续并优化了前代产品的设计,在算力、能效、稳定性等方面全面升级。

同时,百度也突破了卡间互联拓扑限制,避免通信带宽成为瓶颈,并采用创新性散热方案,有效解决了能效与散热问题,以确保集群高效、稳定地运行。

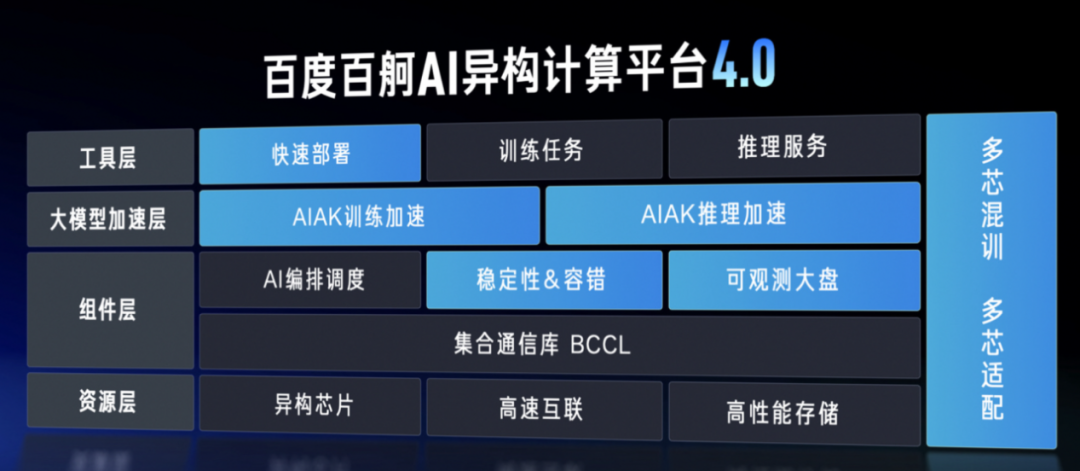

而在软件层面,百舸AI异构计算平台4.0则在构建高性能网络、优化分布式训练、多芯混训、故障诊断手段等方面发挥了至关重要的作用:

●

在分布式训练优化上,百舸4.0采用高效并行化任务切分策略,将训练主流开源模型的集群MFU提升至58%,大幅提升模型训练速度和资源利用率;

●

针对机间通信带宽需求,百舸4.0构建超大规模 HPN 高性能网络并优化拓扑结构,显著降低了通信瓶颈,使带宽有效性达到90%以上;

●

在多芯混训方面,百舸4.0可自动进行芯片选型,依据集群剩余资源选择性价比最高的芯片运行任务,实现高达 95% 的万卡多芯混合训练效能。

●

在集群稳定性上,百舸4.0提供全面故障诊断手段,能快速自动侦测节点故障,并将故障恢复时间从小时级缩短到分钟级,避免由于单卡故障率随规模指数上升而造成的万卡集群有效性大幅下降,保障有效训练率达到98%。

图源:

百度

图源:

百度

由此,《节点财经》认为,构建万卡集群不仅是芯片的堆砌整合,更要依托强大的AI计算平台来支撑整个集群的调配设计。而百度智能云依托百舸AI异构计算平台4.0,实现了从集群创建到开发实验,再到模型训练、推理的全链路优化。不仅提升了自身的智算实力,也为智算行业提供新的发展思路。

值得一提的是,凭借着自研昆仑芯的技术优势以及百舸平台的有力加持,百度智能云已为众多企业提供了“多、快、稳、省”的AI基础设施。

例如,生数科技依托百度百舸高效、稳定、混合多芯的能力,得以在短时间内完成了Vidu大模型的上线和开放API,其素材渲染加速效率提升3倍,数据拉取效率提升51倍;长安汽车通过与百度智能云的深度合作,让自动驾驶模型训练的算力总体平均使用率提升到90%以上,综合资源利用率提升了50%;教育场景先行者好未来教育集团则借助百舸平台自研出“九章大模型(MathGPT)”,目前已经广泛应用于好未来的智能硬件、学而思旗舰学习机及多个业务场景中......

图源:

百度智能云

图源:

百度智能云

可以预见,未来一年,将是各种AI原生应用爆发的黄金时期。而百度智能云自研万卡集群的建成,不仅带来了强大的算力支持,让中国产业率先“跑”起来,也推动了模型降本的趋势,为各行各业的AI应用和创新提供了实实在在的价值。

花小钱办大事,中国AI再引全球瞩目

百度智能云自研万卡集群的成功点亮,不仅在国内引发广泛关注,也在国际市场掀起热议。

日前,花旗银行在研报中指出,百度、DeepSeek等中国模型展现出高效和低成本优势,将有助于加速全球AI应用开发,并在全球引发更多技术创新,推动2025年人工智能应用的拐点。