我的新课

《C2C 电商系统微服务架构120天实战训练营》

在公众号

儒猿技术窝

上线了,感兴趣的同学,可以长按扫描下方二维码了解课程详情:

课程大纲请参见文末

目录:

-

用一个创业公司的发展作为背景引入

-

用多台服务器来分库支撑高并发读写

-

大量分表来保证海量数据下查询性能

-

读写分离来支撑按需扩容及性能提升

-

高并发下的数据库架构设计总结

“

这篇文章,我们来聊一下对于一个支撑日活百万用户的高并系统,他的数据库架构应该如何设计?

看到这个题目,很多人第一反应就是:

分库分表啊!

但是实际上,数据库层面的分库分表到底是用来干什么的,他的不同的作用如何应对不同的场景,我觉得很多同学可能都没搞清楚。

假如我们现在是一个小创业公司,注册用户就20万,每天活跃用户就1万,每天单表数据量就1000,然后高峰期每秒钟并发请求最多就10。

天哪!就这种系统,随便找一个有几年工作经验的高级工程师,然后带几个年轻工程师,随便干干都可以做出来。

因为这样的系统,实际上主要就是在前期快速的进行业务功能的开发,搞一个单块系统部署在一台服务器上,然后连接一个数据库就可以了。

接着大家就是不停的在一个工程里填充进去各种业务代码,尽快把公司的业务支撑起来,如下图所示。

结果呢,没想到我们运气这么好,碰上个优秀的CEO带着我们走上了康庄大道!

公司业务发展迅猛,过了几个月,注册用户数达到了2000万!每天活跃用户数100万!每天单表新增数据量达到50万条!高峰期每秒请求量达到1万!

同时公司还顺带着融资了两轮,估值达到了惊人的几亿美金!一只朝气蓬勃的幼年独角兽的节奏!

好吧,现在大家感觉压力已经有点大了,为啥呢?

因为每天单表新增50万条数据,一个月就多1500万条数据,一年下来单表会达到上亿条数据。

经过一段时间的运行,现在咱们单表已经两三千万条数据了,勉强还能支撑着。

但是,眼见着系统访问数据库的性能怎么越来越差呢,单表数据量越来越大,拖垮了一些复杂查询SQL的性能啊!

然后高峰期请求现在是每秒1万,咱们的系统在线上部署了20台机器,平均每台机器每秒支撑500请求,这个还能抗住,没啥大问题。

但是数据库层面呢?

如果说此时你还是一台数据库服务器在支撑每秒上万的请求,负责任的告诉你,每次高峰期会出现下述问题:

首先我们先考虑第一个问题,

数据库每秒上万的并发请求应该如何来支撑呢?

要搞清楚这个问题,先得明白一般数据库部署在什么配置的服务器上。

通常来说,假如你用普通配置的服务器来部署数据库,那也起码是16核32G的机器配置。

这种非常普通的机器配置部署的数据库,一般线上的经验是:不要让其每秒请求支撑超过2000,一般控制在2000左右。

控制在这个程度,一般数据库负载相对合理,不会带来太大的压力,没有太大的宕机风险。

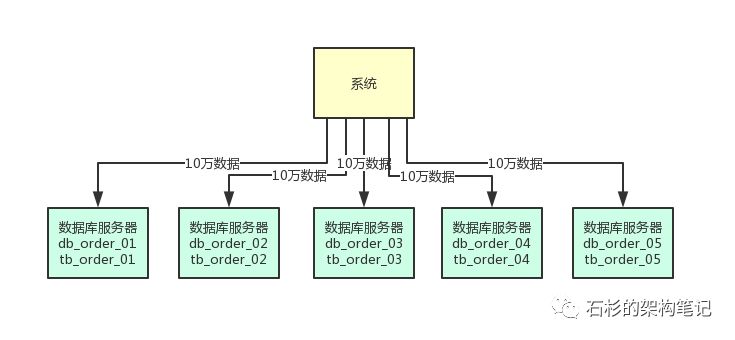

所以首先第一步,就是在上万并发请求的场景下,部署个5台服务器,每台服务器上都部署一个数据库实例。

然后每个数据库实例里,都创建一个一样的库,比如说订单库。

此时在5台服务器上都有一个订单库,名字可以类似为:

db_order_01,db_order_02,等等。

然后每个订单库里,都有一个相同的表,比如说订单库里有订单信息表,那么此时5个订单库里都有一个订单信息表。

比如db_order_01库里就有一个tb_order_01表,db_order_02库里就有一个tb_order_02表。

这就实现了一个基本的分库分表的思路,原来的一台数据库服务器变成了5台数据库服务器,原来的一个库变成了5个库,原来的一张表变成了5个表。

然后你在写入数据的时候,需要借助数据库中间件,比如sharding-jdbc,或者是mycat,都可以。

你可以根据比如订单id来hash后按5取模,比如每天订单表新增50万数据,此时其中10万条数据会落入db_order_01库的tb_order_01表,另外10万条数据会落入db_order_02库的tb_order_02表,以此类推。

这样就可以把数据均匀分散在5台服务器上了,查询的时候,也可以通过订单id来hash取模,去对应的服务器上的数据库里,从对应的表里查询那条数据出来即可。

依据这个思路画出的图如下所示,大家可以看看。

做这一步有什么好处呢?

第一个好处,原来比如订单表就一张表,这个时候不就成了5张表了么,那么每个表的数据就变成1/5了。

假设订单表一年有1亿条数据,此时5张表里每张表一年就2000万数据了。

那么假设当前订单表里已经有2000万数据了,此时做了上述拆分,每个表里就只有400万数据了。

而且每天新增50万数据的话,那么每个表才新增10万数据,这样是不是初步缓解了单表数据量过大影响系统性能的问题?

另外就是每秒1万请求到5台数据库上,每台数据库就承载每秒2000的请求,是不是一下子把

每台数据库服务器的并发请求降低到了安全范围内

?

这样,降低了数据库的高峰期负载,同时还保证了高峰期的性能。

但是上述的数据库架构还有一个问题,那就是单表数据量还是过大,现在订单表才分为了5张表,那么如果订单一年有1亿条,每个表就有2000万条,这也还是太大了。

所以还应该继续分表,大量分表。

比如可以把订单表一共拆分为1024张表,这样1亿数据量的话,分散到每个表里也就才10万量级的数据量,然后这上千张表分散在5台数据库里就可以了。

在写入数据的时候,需要做

两次路由

,先对订单id hash后对数据库的数量取模,可以路由到一台数据库上,然后再对那台数据库上的表数量取模,就可以路由到数据库上的一个表里了。

通过这个步骤,就可以让每个表里的数据量非常小,每年1亿数据增长,但是到每个表里才10万条数据增长,这个系统运行10年,每个表里可能才百万级的数据量。

这样可以一次性为系统未来的运行做好充足的准备,看下面的图,一起来感受一下:

这个时候整体效果已经挺不错了,大量分表的策略保证可能未来10年,每个表的数据量都不会太大,这可以保证单表内的SQL执行效率和性能。

然后多台数据库的拆分方式,可以保证每台数据库服务器承载一部分的读写请求,降低每台服务器的负载。

但是此时还有一个问题,假如说每台数据库服务器承载每秒2000的请求,然后其中400请求是写入,1600请求是查询。

也就是说,增删改的SQL才占到了20%的比例,80%的请求是查询。