最近,我留意到关于「本科生发数篇 SCI」、「90后直博保送」的新闻频频出现在各大媒体的头条上。

想想自己,每天除了上课、写论文、查文献,还要为作图分析数据抓破头皮……结果写出来的论文连导师那关都过不了。

前几天,有同学在后台向我抱怨:“第一次知道写论文能把人写秃”。

连续一个星期,他都在熬夜赶论文,翻墙、付费,前前后后下载了几百份资料包,一个一个打开筛选信息时却发现:将近50%的资料都是一样的!

整理完这些资料已经凌晨3点了,困得眼睛都睁不开,一想到明天就截稿了,他只好随便拼凑一篇应付。

结果可想而知,导师还没看完第一页就把论文给退回来了,说论文

通篇缺乏具体数据分析,研究计划就很粗糙,实施起来会出现各种bug。

好在,有个发了好几次

「SCI」

的师姐告诉他,手动找资料太局限了,现在她都是用Python来完成文献搜索、和数据处理。

师姐几十行代码写一个简单的爬虫工具,

几分钟不到,“嗖嗖嗖…

”

自动抓取到指定网站上的成千上万篇论文,没有找不到,只有想不到的。

师姐用Python做了一个自动翻译的小工具,爬取到的外文文献自动

翻译成中文

,

省下大把的时间做(谈)学(恋)术(爱)。

▲自动翻译外文文献

从爬取文献到清洗筛除数据,从数据统计到绘制韦恩图,从论文的写作到完成 PPT,整个过程一气呵成。

这位同学要花大半天才能检索到的学术文献,师姐

不到1分钟就搞定了。

师姐告诉她:很多学霸、行业专家都在使用python获取最新学术文献,处理特殊图像和撰写仿真脚本。

看见师姐文章里明了高端的 PPI 图、热图、富集图、韦恩图、和弦图、火山图和主成分分析图,自己和他们的差距一目了然,发表SCI感觉遥不可期

。

在学习和科研工作中,我们常常面临各种与信息搜集有关的事情。

但在互联网信息爆炸的时代,信息来源网站多,信息量大,如果采用常规的人工搜索文献和手动整理数据,往往费时费力还完不成。

而这些,都能通过Python来实现。

当下,python 在信息搜集和数据分析方面的应用已经非常普遍,

已经成了一项必备技能

,

而不再只是程序员的专属。

前段时间,秋招信息中,很多公司纷纷

在招聘JD里写上了

“熟悉Python优先”

这

样的招聘条件。

▲人工智能python语言进入小学课本,并纳入高考!

前段时间,

潘石屹也公布自己要学Python的消息,一再刷屏朋友圈和各大媒体

。

在这里,已经有

66万+名从来没有接触过编程的学员,

经过一个月左右的时间,现学现用,来帮助自己更快更好地完成工作和学习。

一听编程,就觉得很难学,是不是一定要数学或有计算机的基础啊?

看过线上视频也买过书,但是最后都半途而废了,线上课程我能学完吗?

平常太忙了,没有固定的时间学习,能不能自己控制学习进度和时间呢?

它的课程模式不同于传统的学习方式,甚至有些

颠覆。

每按一次“enter"键都是一次对话,

“他”会说rap、讲段子,或者提一些有趣的问题,我们运用学到的知识参与这个话题,收获他的鼓励。

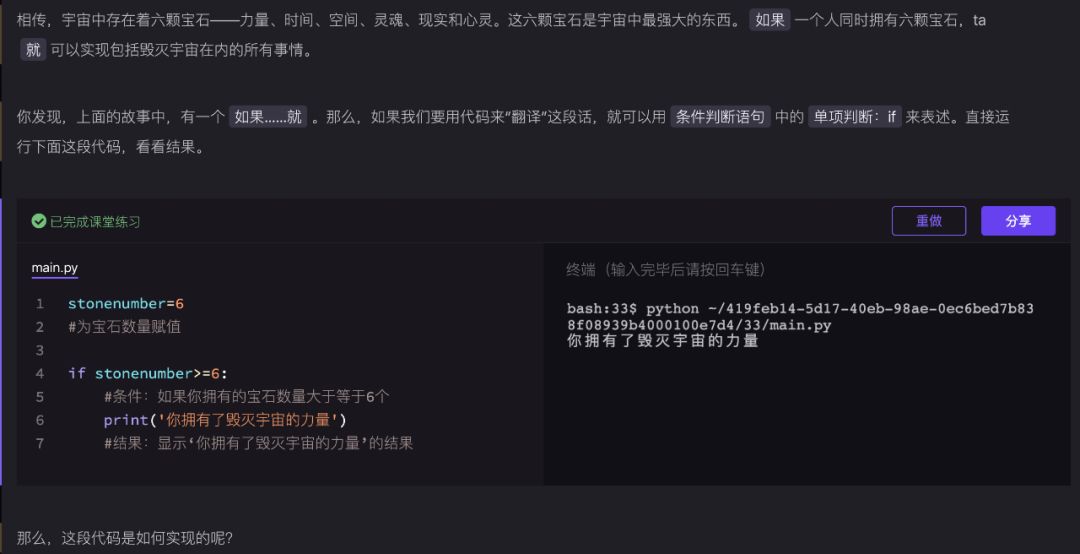

比如,单纯的用abcd去定义变量和写代码,学习的时候会枯燥。

但是知识点代入皮卡丘、灭霸的故事中,就会很有意思。

用if语句帮助复仇者偷回灭霸的宝石

这种

交互式学习方式

,让完全0基础、从来没有接触过编程的同学,学起来一点也不感觉到吃力,甚至还有弃剧也想把课上完的冲动。

班级群

里有来自各行业各业的小伙伴,大家互相监督学习。

助教老师不是程序的自动回复,而是

真人在线实时指导。

而且助教都每天会发一篇认知文章,讲述编程在各个行业领域应用的情况与案例,方便非互联网行业的朋友知道自己学了之后应该怎么用,用在哪里。

贴身助教随时解疑答惑

中断学习后,

平台会自动保存学习进度,而且课程内容是终身有效,还可以反复学习。

每节课上课时间大概15-20分钟,对于上班没时间的小伙伴们,抽个刷短视频的时间学习简直不要太方便。

“

我们希望做一个“社会认知机器,

希望借助技术手段,做一套顶厉害的产品体系。能够以低成本,规模化的方式,把不同人,从不同的起点,送往不同的终点。

如此,我们能够实现——教育资源的极大丰富。我们希望教育就像水和电一样,我们按一个开关,它就可以为我们所用。它才能真正地普惠到每一个人。“

如果你是在学习和工作中时常面临收集海量信息、分析各种数据,并且想要改变现状、给自己一个开挂机会的人:

不要再花俩月工资买

10G的视频课程和砖块厚的python学习书

,买了不看等于浪费。

福利时间!

专享价

8.9

元

不到一杯奶茶的价格

给自己一次接近SCI的机会

仅限

前100名

扫码,即刻开始学习

变厉害的机会,都是自己给的

时间不能让你弯道超车,新技能可以!