爬虫解析数据有很多种,爬取不同的数据,返回的数据类型不一样

常见格式包含:

掌握这 4 种解析数据的方式,无论什么样的数据格式都可以轻松应对处理

这四种方式分别是:

1.x

path

、

2.bs4

、

3.json

、

4.正则

下面以实战方式讲解这四种技术如何使用

1.请求数据

以请求链接如下的案例进行讲解

http://www.xbiquge.la/xuanhuanxiaoshuo/

导入相应的库

import requests

from lxml import etree

开始请求数据

headers = {

'user-agent':'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/69.0.3947.100 Safari/537.36',

}

url="http://www.xbiquge.la/xuanhuanxiaoshuo/"

res = requests.get(url,headers=headers)

res.encoding = 'utf-8'

text = res.text

2.解析数据

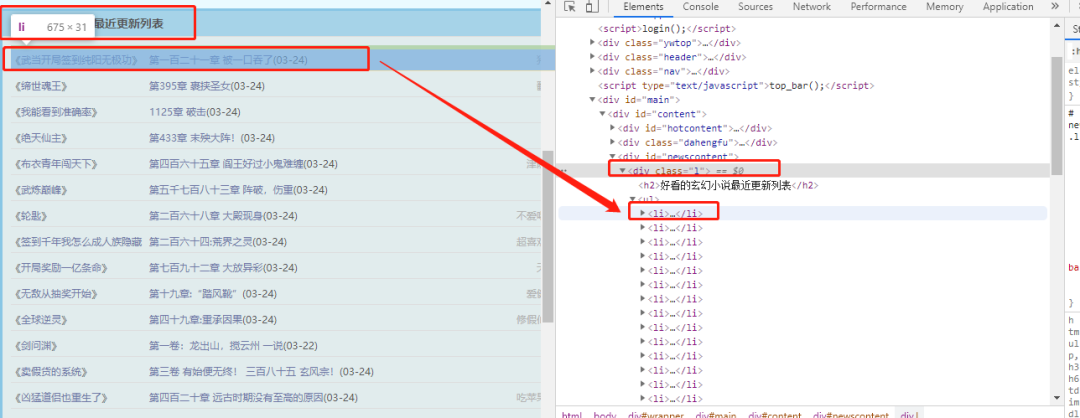

比如我们要获取下面这些数据(小说名称)

分析网页标签

数据在class="l"-> ul ->li标签中

selector = etree.HTML(text)

list = selector.xpath('//*[@class="l"]/ul/li')

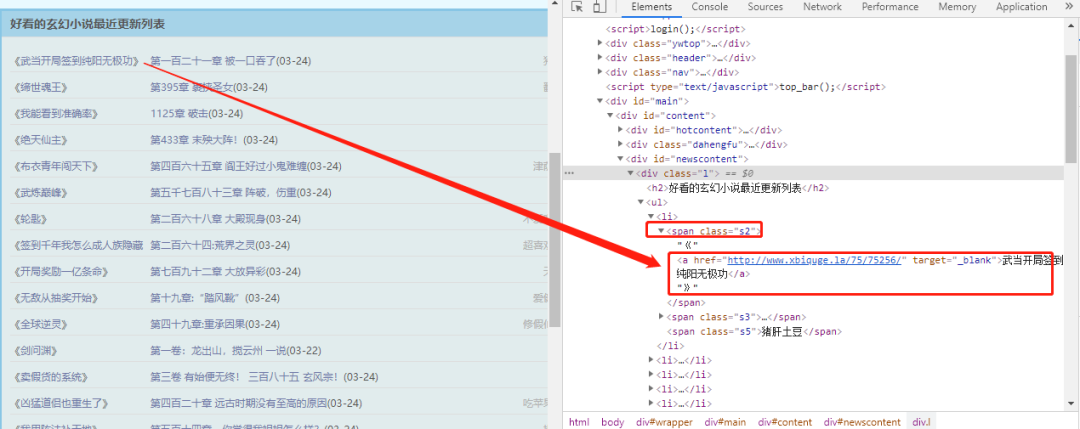

解析li中数据

可以看到,数据在li->span->a 标签中

for i in list:

title = i.xpath('.//span/a/text()')

href = i.xpath('.//span/a/@href')

print(title)

print(href)

print("--------")

1.请求数据

同样以请求链接如下的案例进行讲解

http://www.xbiquge.la/xuanhuanxiaoshuo/

导入相应的库

import requests

from bs4 import BeautifulSoup

开始请求数据

headers = {

'user-agent':'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/69.0.3947.100 Safari/537.36',

}

url="http://www.xbiquge.la/xuanhuanxiaoshuo/"

res = requests.get(url,headers=headers)

res.encoding = 'utf-8'

text = res.text

2.解析数据

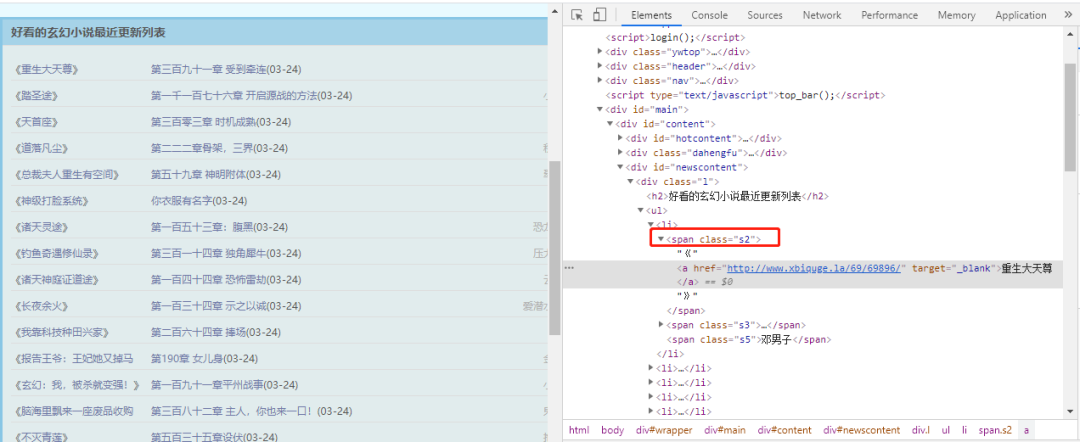

比如我们要获取下面这些数据(小说名称)

分析网页标签

可以看到,数据在span中(class="s2") 标签中

法一

###法一

list = soup.find_all(attrs={'class':'s2'})

for i in list:

print(i.a.get_text())

print(i.a.get("href"))

print("--------")

print(len(list))

法二

####法二

# 获取所有的链接

all_link = [(link.a['href'], link.a.get_text()) for link in soup.find_all('li')]

for i in all_link:

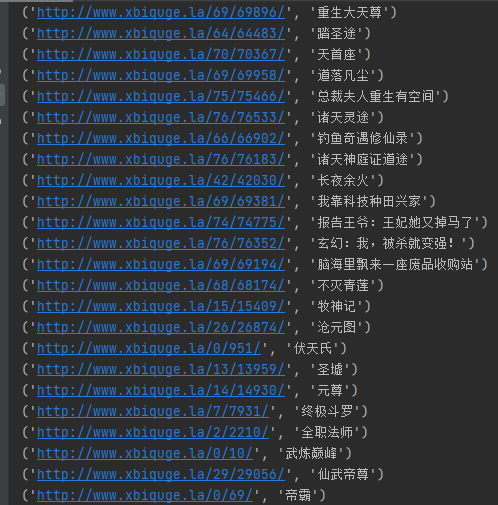

print(i)

1.请求数据

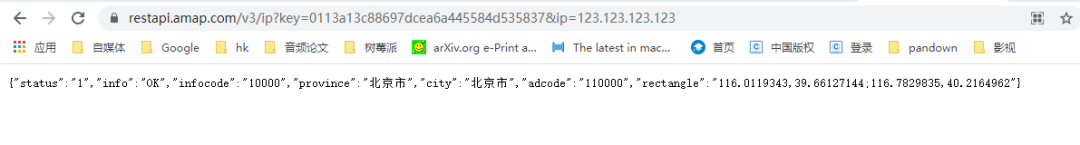

请求链接如下,获取 ip 定位为案例进行讲解

https://restapi.amap.com/v3/ip?key=0113a13c88697dcea6a445584d535837&ip=123.123.123.123

导入相应的库

import requests

import json

开始请求数据

ip = "123.123.123.123"

url="https://restapi.amap.com/v3/ip?key=0113a13c88697dcea6a445584d535837&ip="+str(ip)

res = requests.get(url,headers=headers)

res.encoding = 'utf-8'

text = res.text

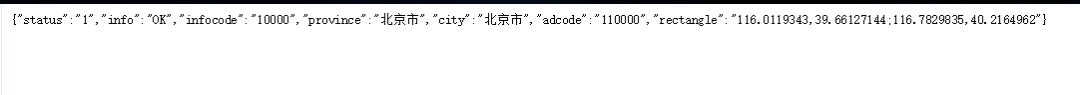

2.解析数据

比如我们要获取下面这些数据(

省份和城市

)