摘要:

回顾2018,展望2019,计算机科学技术继续前进!

1、简介:

过去几年一直是人工智能爱好者和机器学习专业人士最幸福的时光。因为这些技术已经发展成为主流,并且正在影响着数百万人的生活。各国现在都有专门的人工智能规划和预算,以确保在这场比赛中保持优势。

数据科学从业人员也是如此,

这个领域正在发生很多事情,你必须要跑的足够的快才能跟上时代步伐。回顾历史,展望未来一直是我们寻找方向的最佳方法。

这也是我为什么想从数据科学从业者的角度退一步看一下人工智能的一些关键领域的发展,它们突破了什么?2018年发生了什么?2019年会发生什么?

我将在本文中介绍自然语言处理(NLP)、计算机视觉、工具库、强化学习、走向合乎正道的人工智能

2、自然语言处理(NLP)

让机器分析单词和句子似乎是一个梦想,就算我们人类有时候也很难掌握语言的细微差别,但2018年确实是NLP的分水岭。

我们看到了一个又一个显著的突破:ULMFiT、ELMO、OpenAI的Transformer和Google的BERT等等。迁移学习(能够将预训练模型应用于数据的艺术)成功应用于NLP任务,为无限可能的应用打开了大门。让我们更详细地看一下这些关键技术的发展。

ULMFiT

ULMFiT由Sebastian Ruder和fast.ai的Jeremy Howard设计,它是第一个在今年启动的NLP迁移学习框架。对于没有经验的人来说,它代表通用语言的微调模型。Jeremy和Sebastian让ULMFiT真正配得上Universal这个词,该框架几乎可以应用于任何NLP任务!

想知道对于ULMFiT的最佳部分以及即将看到的后续框架吗?事实上你不需要从头开始训练模型!研究人员在这方面做了很多努力,以至于你可以学习并将其应用到自己的项目中。ULMFiT可以应用六个文本分类任务中,而且结果要比现在最先进的方法要好。

你可以阅读Prateek Joshi关于如何开始使用ULMFiT以解决任何文本分类问题的优秀教程。

ELMO

猜一下ELMo代表着什么吗?它是语言模型嵌入的简称,是不是很有创意? ELMo一发布就引起了ML社区的关注。

ELMo使用语言模型来获取每个单词的嵌入,同时还考虑其中单词是否适合句子或段落的上下文。上下文是NLP的一个重要领域,大多数人以前对上下文都没有很好的处理方法。ELMo使用双向LSTM来创建嵌入,如果你听不懂-请参考这篇文章,它可以让你很要的了解LSTM是什么以及它们是如何工作的。

与ULMFiT一样,ELMo显着提高了各种NLP任务的性能,如情绪分析和问答,在这里了解更多相关信息。

BERT

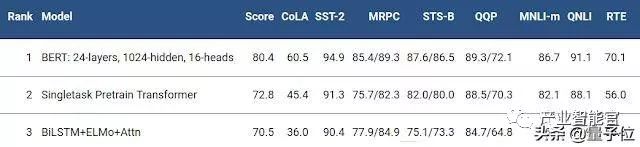

不少专家声称BERT的发布标志着NLP的新时代。继ULMFiT和ELMo之后,BERT凭借其性能真正击败了竞争对手。正如原论文所述,“BERT在概念上更简单且更强大”。BERT在11个NLP任务中获得了最先进的结果,在SQuAD基准测试中查看他们的结果:

有兴趣入门吗?你可以使用PyTorch实现或Google的TensorFlow代码尝试在自己的计算机上得出结果。

我很确定你想知道BERT代表什么,它实际上是Transformers的双向编码器表示,如果你能够领悟到这些,那很不错了。

PyText

Facebook开源了深度学习NLP框架PyText,它在不久之前发布,但我仍然要测试它,但就早期的评论来说非常有希望。根据FB发表的研究,PyText使会话模型的准确性提高了10%,并且缩短了训练时间。

PyText实际上落后于Facebook其他一些产品,如FB Messenger。如果你对此有兴趣。你可以通过GitHub下载代码来自行尝试。

2019年NLP趋势:

塞巴斯蒂安·罗德讲述了NLP在2019年的发展方向,以下是他的想法:

-

预训练的语言模型嵌入将无处不在,不使用它们的模型将是罕见的。

-

我们将看到可以编码专门信息的预训练模型,这些信息是对语言模型嵌入的补充。

-

我们将看到有关多语言应用程序和跨语言模型的成果。特别是,在跨语言嵌入的基础上,我们将看到深度预训练的跨语言表示的出现。

3、计算机视觉

这是现在深度学习中最受欢迎的领域,我觉得我们已经完全获取了计算机视觉中容易实现的目标。无论是图像还是视频,我们都看到了大量的框架和库,这使得计算机视觉任务变得轻而易举。

我们今年在Analytics Vidhya花了很多时间研究这些概念的普通化。你可以在这里查看我们的计算机视觉特定文章,涵盖从视频和图像中的对象检测到预训练模型列表的相关文章,以开始你的深度学习之旅。

以下是我今年在CV中看到的最佳开发项目:

如果你对这个美妙的领域感到好奇,那么请继续使用我们的“使用深度学习的计算机视觉”课程开始你的旅程。

BigGAN的发布

在2014年,Ian Goodfellow设计了GAN,这个概念产生了多种多样的应用程序。年复一年,我们看到原始概念为了适应实际用例正在慢慢调整,直到今年,仍然存在一个共识:机器生成的图像相当容易被发现。

但最近几个月,这个现象已经开始改变。或许随着BigGAN的创建,该现象或许可以彻底消失,以下是用此方法生成的图像:

除非你拿显微镜看,否则你将看不出来上面的图片有任何问题。毫无疑问GAN正在改变我们对数字图像(和视频)的感知方式。

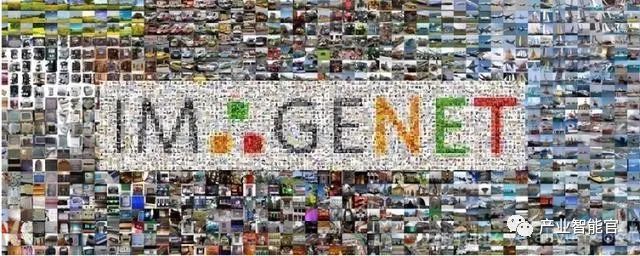

Fast.ai的模型18分钟内在ImageNet上被训练

这是一个非常酷的方向:大家普遍认为需要大量数据以及大量计算资源来执行适当的深度学习任务,包括在ImageNet数据集上从头开始训练模型。我理解这种看法,大多数人都认为在之前也是如此,但我想我们之前都可能理解错了。

Fast.ai的模型在18分钟内达到了93%的准确率,他们使用的硬件48个NVIDIA V100 GPU,他们使用fastai和PyTorch库构建了算法。

所有的这些放在一起的总成本仅为40美元! 杰里米在这里更详细地描述了他们的方法,包括技术。这是属于每个人的胜利!

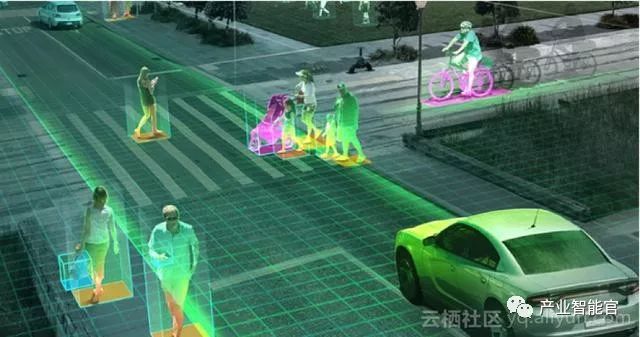

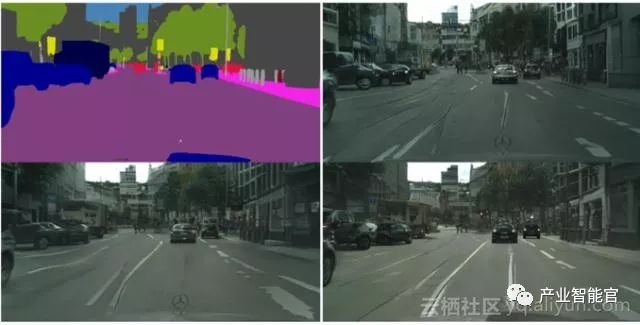

NVIDIA的vid2vid技术

在过去的4-5年里,图像处理已经实现了跨越式发展,但视频呢?事实证明,将方法从静态框架转换为动态框架比大多数人想象的要困难一些。你能拍摄视频序列并预测下一帧会发生什么吗?答案是不能!

NVIDIA决定在今年之前开源他们的方法,他们的vid2vid方法的目标是从给定的输入视频学习映射函数,以产生输出视频,该视频以令人难以置信的精度预测输入视频的内容。

你可以在这里的GitHub上试用他们的PyTorch实现。

2019年计算机视觉的趋势:

就像我之前提到的那样,在2019年可能看到是改进而不是发明。例如自动驾驶汽车、面部识别算法、虚拟现实算法优化等。就个人而言,我希望看到很多研究在实际场景中实施,像CVPR和ICML这样的会议描绘的这个领域的最新成果,但这些项目在现实中的使用有多接近?

视觉问答和视觉对话系统最终可能很快就会如他们期盼的那样首次亮相。虽然这些系统缺乏概括的能力,但希望我们很快就会看到一种综合的多模式方法。

自监督学习是今年最重要的创新,我可以打赌明年它将会用于更多的研究。这是一个非常酷的学习线:标签可以直接根据我们输入的数据确定,而不是浪费时间手动标记图像。

4、工具和库

工具和库是数据科学家的基础。我参与了大量关于哪种工具最好的辩论,哪个框架会取代另一个,哪个库是经济计算的缩影等等。

但有一点共识--我们需要掌握该领域的最新工具,否则就有被淘汰的风险。 Python取代其他所有事物并将自己打造成行业领导者的步伐就是这样的例子。 当然,其中很多都归结为主观选择,但如果你不考虑最先进的技术,我建议你现在开始,否则后果可能将不可预测。那么成为今年头条新闻的是什么?我们来看看吧!

PyTorch 1.0

什么是PyTorch?我已经多次在本文中提到它了,你可以在Faizan Shaikh的文章中熟悉这个框架。

这是我最喜欢的关于深度学习文章之一!当时TensorFlow很缓慢,这为PyTorch打开了大门快速获得深度学习市场。我在GitHub上看到的大部分代码都是PyTorch实现的。这并非因为PyTorch非常灵活,而是最新版本(v1.0)已经大规模应用到许多Facebook产品和服务,包括每天执行60亿次文本翻译。PyTorch的使用率在2019年上升,所以现在是加入的好时机。

AutoML—自动机器学习

AutoML在过去几年中逐渐取得进展。RapidMiner、KNIME、DataRobot和H2O.ai等公司都发布了非常不错的产品,展示了这项服务的巨大潜力。你能想象在ML项目上工作,只需要使用拖放界面而无需编码吗?这种现象在未来并不太遥远。但除了这些公司之外,ML / DL领域还有一个重要的发布-

Auto Keras!

它是一个用于执行AutoML任务的开源库。其背后的目的是让没有ML背景的领域专家进行深度学习。请务必在此处查看,它准备在未来几年内大规模运行。

TensorFlow.js-浏览器中的深度学习

我们一直都喜欢在最喜欢的IDE和编辑器中构建和设计机器学习和深度学习模型。如何迈出一步,尝试不同的东西?我将要介绍如何在你的网络浏览器中进行深度学习!由于TensorFlow.js的发布,已成为现实。

TensorFlow.js主要有三个优点/功能:

1.使用JavaScript开发和创建机器学习模型;

2.在浏览器中运行预先存在的TensorFlow模型;

3.重新创建已有的模型;

2019年的AutoML趋势

我个人特别关注AutoML,为什么?因为我认为未来几年它将成为数据科学领域真正的游戏规则改变者。跟我有同样想法的人是H2O.ai的Marios Michailidis、Kaggle Grandmaster,他们都对AutoML有很高期望:

机器学习继续成为未来最重要的趋势之一,鉴于其增长速度,自动化是最大化其价值的关键,是充分利用数据科学资源的关键。它可以应用到的领域是无限的:信用、保险、欺诈、计算机视觉、声学、传感器、推荐、预测、NLP等等,能够在这个领域工作是一种荣幸。AutoML趋势:

-

提供智能可视化和解释,以帮助描述和理解数据;

-

查找/构建/提取给定数据集的更好特征;

-

快速建立更强大/更智能的预测模型;

-

通过机器学习可解释性弥补这些模型的黑匣子建模和生产之间的差距;

-

促进这些模型落地生产;

5、强化学习

如果我不得不选择一个我看到的渗透更多领域的技术,那就是强化学习。除了不定期看到的头条新闻之外,我还在社区中了解到,它太注重数学,并且没有真正的行业应用程序可供专一展示。

虽然这在某种程度上是正确的,但我希望看到的是明年更多来自RL的实际用例。我在每月GitHub和Reddit排序系列中,我倾向于至少保留一个关于RL的存储库或讨论,至少围绕该主题的讨论。

OpenAI已经发布了一个非常有用的工具包,可以让初学者从这个领域开始。

OpenAI在深度强化学习中的应用

如果RL的研究进展缓慢,那么围绕它的教育材料将会很少。但事实上,OpenAI已经开放了一些关于这个主题的精彩材料。他们称这个项目为“Spinning Up in Deep RL”,你可以在这里阅读所有相关内容。它实际上是非常全面RL的资源列表,这里有很多材料包括RL术语、如何成为RL研究者、重要论文列表、一个记录完备的代码存储库、甚至还有一些练习来帮助你入门。

如果你打算开始使用RL,那么现在开始!

Google Dopamine

为了加速研究并让社区更多的参与强化学习,Google AI团队开源了Dopamine,这是一个TensorFlow框架,旨在通过它来使更灵活和可重复性来构建RL模型。

你可以在此GitHub存储库中找到整个训练数据以及TensorFlow代码(仅15个Python notebooks!)。这是在受控且灵活的环境中进行简单实验的完美平台,听起来像数据科学家的梦想。

2019年强化学习趋势

Xander Steenbrugge是DataHack Summit的代表,也是ArxivInsights频道的创始人,他非常擅长强化学习。以下是他对RL当前状态的看法以及2019年的预期:

-

样本复杂性(代理需要查看/收集以获得的经验数量);

-

泛化和转移学习(训练任务A,测试相关任务B);

-

分层RL(自动子目标分解);

人工智能:符合伦理才更重要

想象一下由算法统治的世界,算法决定了人类采取的每一个行动。这不是一个美好的场景,对吗?AI中的伦理规范是Analytics Vidhya一直热衷于讨论的话题。

今年有相当多的组织因为Facebook的剑桥分析公司丑闻和谷歌内部普遍关于设计武器新闻丑闻而遭受危机。没有一个开箱即用的解决方案或一个适合所有解决方案来处理AI的伦理方面。它需要一种细致入微的方法,并结合领导层提出的结构化路径。让我们看看今年出现的重大政策:GDPR。

GDPR如何改变游戏规则

GDPR或通用数据保护法规肯定会对用于构建AI应用程序的数据收集方式产生影响。GDPR的作用是以确保用户可以更好地控制他们的数据。那么这对AI有何影响?我们可以想象一下,如果数据科学家没有数据(或足够数据),那么构建任何模型都会还没开始就失败。

2019年的AI伦理趋势预期

这是一个灰色的领域。就像我提到的那样,没有一个解决方案可以解决这个问题。我们必须聚集在一起,将伦理问题整合到AI项目中。那么我们怎样才能实现这一目标呢?正如Analytics Vidhya的创始人兼首席执行官Kunal Jain在2018年DataHack峰会上的演讲中所强调的那样:我们需要确定一个其他人可以遵循的框架。

结束语

有影响力!这是2018年来描述AI最佳的词汇。今年我成为ULMFiT的狂热用户,我也很期待BERT。

文章原标题《

A Technical Overview of AI & ML (NLP, Computer Vision, Reinforcement Learning) in 2018 & Trends for 2019

》

来源:阿里云

原文链接:https://www.analyticsvidhya.com/blog/2018/12/key-breakthroughs-ai-ml-2018-trends-2019/

一文看尽谷歌AI全年重大研究突破,Jeff Dean执笔,全程干货

量子位

晓查 郭一璞 栗子 乾明 发自 凹非寺

量子位 报道 | 公众号 QbitAI

刚刚,Jeff Dean代表Google AI,完整总结了2018。

这也是姐夫作为全球AI第一大厂总负责人的第一次年度汇报。

他说,2018真是令AI工作者兴奋的一年。

学术和应用两开花,开源和新技术同步推进。

从重要AI技术应用突破讲起,到展望2019结束。Jeff Dean总结了14个大方面的AI成果,并透露全年AI论文发表数

达608篇

。

涵盖量子计算、感知技术、计算摄影、算法框架、AutoML、机器人、医疗AI,计算力和TPU……

桩桩件件,不仅在当前推动了AI作用社会方方面面,而且也是对未来趋势的小小展示。

毫不夸张地说,欲知2018 AI技术进展,看Jeff这篇总结再合适不过;欲知2019 AI会走向何方,看Jeff这篇也能获益良多。

为了方便阅读,我们先整理了一个小目录给你:

-

智能助手

:打电话回邮件,都靠AI

-

量子计算

:72量子比特设备、开源框架、可行的量子神经网络……

-

自然语言理解

:从Transformer到BERT,碾压各项NLP任务

-

感知

:图像识别和场景理解,语音增强与合成

-

拍照

:照片动起来,夜景亮起来

-

算法和理论

:谷歌帝国基石,从优化、算法选择到应用

-

软件系统

:Mesh TensorFlow、TF-Ranking、JAX、隐私与安全

-

AutoML

:自动找出最高效的网络结构

-

TPU

:给全世界提供大量算力

-

开源软件和数据集

:远不止多巴胺,大量资源预警

-

机器人学

:从多个角度入手,让机器人更独立,更强大

-

人工智能在其他领域的应用

:物理学、生命科学、天文学

-

医疗

:从视网膜诊断病症到癌症预测,从辅助诊断到拓展到临床预测

-

合作研究

:投入大量资源资助教师、学生和各方面研究人员进行研究

-

新地方、新面孔

:持续在世界各地扩张,并广纳人才

-

展望2019

:对谷歌以及更广泛的研究和工程领域产生更大影响

-

AI原则

:Google AI历史性指导准则,争议性军事项目之后制定了7大原则

-

AI社会公益

:展示Google利用AI技术推动社会公益的案例

完整报告如下:

智能工具们

Google AI也在不断打造新技术应用帮助用户提升效率,创造更大的社会价值。

简而言之:努力打造Google AI小助手工具产品。

2018最典型的莫过于Google Duplex,这是一个汇集语音识别、语义理解和对话的AI系统,可以作为你的虚拟电话助手,订餐厅、预约会议时间都不在话下。

还有Smart Compose——智能回复。能够基于语义分析和文本预测,帮助用户提升邮件回复的效率。

同样的还有Sound Search和Smart Linkify,都是AI提升用户效率的尝试。

Google目前也在围绕上述AI产品,展开多语言支持的努力,希望类似的产品通过小数据训练学习,就能对全球更多地区和用户产生更好的影响。

相关报道:

Google AI打电话以假乱真

量子计算

量子计算是一种新兴的计算范式,有望解决经典计算机无法解决的问题。

在过去的几年里,我们一直积极进行相关的研究,我们相信该领域正处在实现量子霸权能力的转折阶段,这将是量子计算领域的一个分水岭。

2018年,我们取得了许多令人兴奋的成果,开发了一种新的72量子比特的量子计算设备

Bristlecone

。在迈向量子霸权的过程中,这台设备扩展了量子计算机可以解决问题的规模。

△

科学家Marissa Giustina在圣巴巴拉的量子AI实验室安装了Bristlecone芯片

相关报道:

首个72量子比特的量子计算机问世,谷歌出品

我们还发布了量子计算机的开源编程框架Cirq,并探讨了量子计算机如何用于神经网络。

此外,我们还分享了理解量子处理器性能波动的经验与技术,以及量子计算机如何作为神经网络计算底层的一些想法。

相关报道:

谷歌证明量子神经网络可训练图像分类

2019年,我们期待在量子计算领域取得激动人心的成果!

自然语言理解

谷歌的自然语言研究在2018年取得了令人兴奋的成果,既有基础研究,也有以产品为中心的研究。

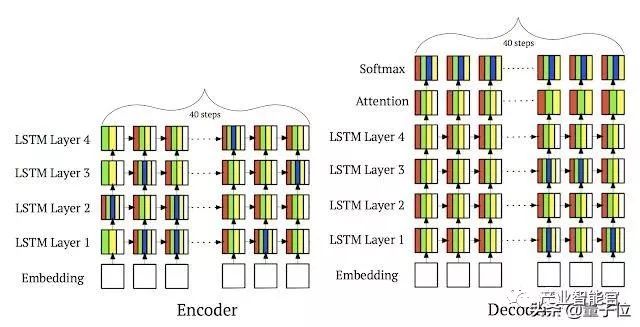

从2017年起,我们开始对Transformer进行改进,去年开发了一个名为“通用Transformer”模型的新的并行时间版本,该版本显示了包括翻译和语言推理在内的许多自然语言任务上的巨大进步。

相关论文:

Universal Transformers

https://arxiv.org/pdf/1807.03819.pdf

我们还开发了BERT,这是第一个深度双向、无监督的语言表示,仅使用纯文本语料库进行预训练,然后可以使用迁移学习对各种自然语言任务进行微调。

相关报道:

全面超越人类!Google称霸SQuAD,BERT横扫11大NLP测试

在11项自然语言任务上,BERT比以往最先进成果有显著的改进。

△

BERT在极具挑战性的GLUE基准测试中提高了7.6%的成绩

除了与各种研究团队合作以实现AI帮助写邮件(Smart Compose)和虚拟电话助手(Duplex)外,我们还努力使谷歌智能助手能够更好地处理多语言使用案例,目标是使助手能与所有用户进行自然的对话。

相关报道:

谷歌助手超进化:可以同时识别两种语言了

感知

我们的感知研究解决了让计算机理解图像、声音、音乐和视频的难题,并为图像捕捉、压缩、处理、创造性表达和增强现实提供了更强大的工具。

2018年,我们的技术提高了Google Photos组织照片的能力,这项功能也是用户最关心的内容,比如给人和宠物照片分组。

△

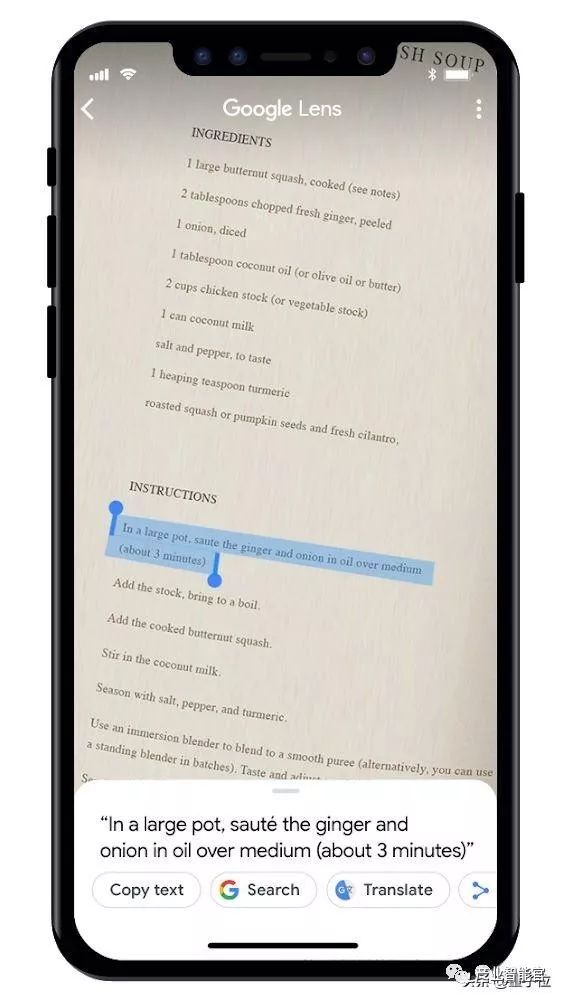

Google Lens能识别狗的种类

Google Lens和Google Assistant使用户能够了解周围世界,实时获取问题的答案,还能在让你在谷歌图像搜索中做更多的事情。

△

Google Lens让你从照片中直接拷贝文字

谷歌AI使命的一个关键方面是让其他人从我们的技术中受益,我们在改进Google API一部分的功能和构建模块方面取得了很大进展。

例如Cloud ML API中视觉和视频方面的改进和新功能,以及通过ML工具包在面部识别相关的设备上构建模块。

相关工具:

https://cloud.google.com/blog/products/ai-machine-learning/closer-look-our-newest-google-cloud-ai-capabilities-developers

2018年,我们对学术研究的贡献包括在3D场景理解的深度学习方面的进步,例如立体放大(Stereo Magnification),这使我们得能够用多张图像合成场景的逼真视图。

相关论文:

Stereo Magnification: Learning View Synthesis using Multiplane Images

https://arxiv.org/abs/1805.09817

我们正在进行关于更好地理解图像和视频的研究,使用户能够在谷歌产品中找到、组织、增强和改善图像和视频,比如Google Photos、YouTube、搜索等等。

2018年,我们取得了多项显著的进步,包括:

快速自下而上的联合姿态估计和人物实例的分割模型

PersonLab: Person Pose Estimation and Instance Segmentation with a Bottom-Up, Part-Based, Geometric Embedding Model

https://arxiv.org/abs/1803.08225

将复杂运动可视化的系统

MoSculp: Interactive Visualization of Shape and Time

http://mosculp.csail.mit.edu

对人和物体之间时空关系建模的系统

Actor-Centric Relation Network

https://arxiv.org/abs/1807.10982

基于distillation和3D卷积的视频动作识别的改进

D3D: Distilled 3D Networks for Video Action Recognition

https://arxiv.org/abs/1812.08249

Rethinking Spatiotemporal Feature Learning: Speed-Accuracy Trade-offs in Video Classification

https://arxiv.org/abs/1712.04851

在音频领域,我们提出了一种无监督学习语义音频表示的方法,并且显著改进了语音合成,让它更生动、更像人类。

相关论文:

Unsupervised Learning of Semantic Audio Representations

https://ieeexplore.ieee.org/abstract/document/8461684

Towards End-to-End Prosody Transfer for Expressive Speech Synthesis with Tacotron

https://arxiv.org/abs/1803.09047

多模态感知是一个越来越重要的研究课题。Looking to Listen将输入视频中的视觉和听觉提示结合起来,分离并增强视频中说话者的声音。

相关论文:

Looking to Listen at the Cocktail Party: A Speaker-Independent Audio-Visual Model for Speech Separation

https://arxiv.org/abs/1804.03619

这项技术可以支持一系列应用:从视频中的语音增强和识别,到视频会议,再到改进的助听器,尤其是在有多人说话的情况下。

在资源受限的平台上实现感知变得越来越重要。MobileNetV2是谷歌的下一代移动计算机视觉模型,广泛应用于学术界和工业界。

相关论文:

MobileNetV2: Inverted Residuals and Linear Bottlenecks

http://openaccess.thecvf.com/content_cvpr_2018/papers/Sandler_MobileNetV2_Inverted_Residuals_CVPR_2018_paper.pdf

MorphNet提出了一种学习深层网络结构的有效方法,这种方法可以在计算资源受到限制时,全面提高图像和音频模型的性能,最近在自动生成移动网络架构方面的工作表明,实现更高的性能也是可能的。

相关论文:

MorphNet: Fast & Simple Resource-Constrained Structure Learning of Deep Networks

http://openaccess.thecvf.com/content_cvpr_2018/html/Gordon_MorphNet_Fast__CVPR_2018_paper.html

拍照算法

过去几年中,手机相机的拍照质量和功能提升十分显著,虽然手机实际物理传感器的进步是一方面,不过更大的进步则是拍照算法方面的。

我们的研究团队发布了新技术,与Google的安卓和消费者硬件团队密切合作,让这项新技术在最新的Pixel等安卓手机和其他设备上落地。

2014年,我们发布了

HDR+

,一种依靠计算机软件将单帧对齐融合的技术。HDR+最初应用的主要目的是为了让图片比单次曝光有更大的动态范围,但随后,拍摄动态帧并计算分析成为了2018年相机进步的一种通用方式。例如Pixel 2中的动态照片(Motion Photos)功能和动态剧照(Motion Stills)里的AR模式。

△

Pixel 2中的动态照片功能

相关博客:

动态照片

https://ai.googleblog.com/2018/03/behind-motion-photos-technology-in.html

动态剧照AR模式

https://ai.googleblog.com/2018/02/the-instant-motion-tracking-behind.html

2018年,我们在拍照算法方面的主要工作之一就是创造了夜视(Night Sight)功能,让Pixel手机的相机能看到黑暗中的物体,这项功能赢得了媒体和用户的赞誉。

相关报道:

宛如白昼,谷歌发布最强夜景拍照AI算法,单摄秒杀一众苹果华为三星

当然,夜视只是我们团队开发的多种帮助用户摄影的软件功能之一,另外还有用机器学习提供更好的人像模式、用Super Res Zoom看得更清晰更远、用Top Shot和Google Clips捕捉更好的瞬间。

△

左为iPhone XS的效果,右为Pixel夜视

相关博客:

机器学习人像模式

https://ai.googleblog.com/2018/11/learning-to-predict-depth-on-pixel-3.html

Super Res Zoom

https://ai.googleblog.com/2018/10/see-better-and-further-with-super-res.html

Top Shot

https://ai.googleblog.com/2018/12/top-shot-on-pixel-3.html

Google Clips

https://ai.googleblog.com/2018/05/automatic-photography-with-google-clips.html

算法和理论

算法是Google系统的基干,关系到我们所有产品,从Google Trips旅行App背后的路径选择算法,到谷歌云的哈希一致性校验都是如此。

相关论文:

Consistent Hashing with Bounded Loads

https://arxiv.org/abs/1608.01350

过去一年,我们继续研究算法和理论,覆盖了从理论基础到应用算法,从图数据挖掘到隐私保护计算。

我们在优化方面的工作涉及到机器学习的持续优化、分布式组合优化等领域。

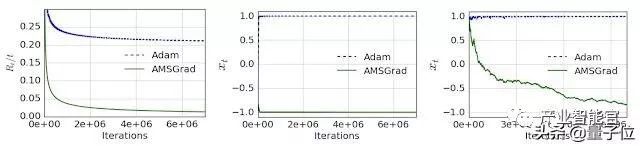

在持续优化上,我们研究随机优化算法训练神经网络的收敛性的工作,展示了ADAM变体等一些流行的基于梯度优化方法存在的问题,但也为新的基于梯度的优化算法提供了监视的基础,获得了ICLR 2018最佳论文。

相关论文:

On the Convergence of Adam and Beyond

https://openreview.net/forum?id=ryQu7f-RZ

上图就是ADAM和AMSGRAD在一个简单一维凸问题模拟例子上的性能对比,左中两幅是在线设置,最右一幅是随机设置。

在分布式优化上,我们努力提高一些经过充分研究的组合优化问题的循环和通信复杂性,比如通过round compression、core-sets、以及子模块最大化、k核分解等进行图匹配。

相关论文:

Round Compression for Parallel Matching Algorithms

https://dl.acm.org/citation.cfm?id=3188764

Optimal Distributed Submodular Optimization via Sketching

https://dl.acm.org/citation.cfm?id=3220081

Parallel and Streaming Algorithms for K-Core Decomposition

http://proceedings.mlr.press/v80/esfandiari18a/esfandiari18a.pdf

在更多应用层面,我们开发的算法技术,能通过sketching实现大规模集合覆盖,能为数万亿边的图解决平衡分区和分层聚类问题。

我们关于online delivery services的工作,还获得了WWW’18会议的最佳论文呢提名。

相关论文:

Minimizing Latency in Online Ride and Delivery Services

https://dl.acm.org/citation.cfm?doid=3178876.3186104

最后,我们的开源优化平台OR-tools在Minizinc约束规划竞赛中获得了4枚金牌。

平台主页:

https://developers.google.com/optimization/

在算法选择理论中,我们提出了新的模型,研究了重建(reconstruction)问题、学习多项logit混合问题。我们还研究了可通过神经网络学习的函数类,以及如何使用机器学习来改进经典在线算法。

相关论文:

A Discrete Choice Model for Subset Selection

https://dl.acm.org/citation.cfm?doid=3159652.3159702

Discrete Choice, Permutations, and Reconstruction

https://epubs.siam.org/doi/10.1137/1.9781611975031.38

Learning a Mixture of Two Multinomial Logits

http://proceedings.mlr.press/v80/chierichetti18a.html

Convergence Results for Neural Networks via Electrodynamics

http://drops.dagstuhl.de/opus/volltexte/2018/8352/

Improving Online Algorithms via ML Predictions

http://papers.nips.cc/paper/8174-improving-online-algorithms-via-ml-predictions

对Google来说还有一件事非常重要,那就是理解具有强隐私保障的学习技术。

在这一领域,我们开发了两种新方法,分析如何通过迭代和混排来强化差分隐私。

我们还运用差分隐私技术,设计了对博弈具有鲁棒性的激励感知学习方法。这样的学习技术可以用于高效在线市场设计。

相关论文:

Privacy Amplification by Iteration

https://ieeexplore.ieee.org/abstract/document/8555134

Amplification by Shuffling: From Local to Central Differential Privacy via Anonymity

https://epubs.siam.org/doi/abs/10.1137/1.9781611975482.151

Incentive-Aware Learning for Large Markets

https://dl.acm.org/citation.cfm?id=3186042

我们在市场算法领域的新研究,还包括帮助广告主测试广告竞价激励兼容性的技术,优化App内广告刷新的技术等。

相关论文:

Testing Incentive Compatibility in Display Ad Auctions

https://pdfs.semanticscholar.org/30a7/773faea229efa6a47178c396ef7b9617fcef.pdf

Optimizing Ad Refresh In Mobile App Advertising

https://dl.acm.org/citation.cfm?id=3186045

我们也推动了重复拍卖动态机制的发展,展示了对缺乏未来预测、对嘈杂预测、对异质买方行为具有鲁棒性的动态拍卖机制,还把研究结果扩展到动态双重拍卖上。

最后,关于在线优化、在线学习的鲁棒性,我们开发了新的在线分配算法,用于流量峰值的随即输入,以及对损坏的数据具有鲁棒性的新型bandit算法。

软件系统

我们在软件系统方面的一大部分研究依然是在建设机器学习模型和TensorFlow上。

例如,我们发布了TensorFlow 1.0动态流程控制的动态设计与实践,我们的一些新研究引入了一个我们称之为Mesh TensorFlow的系统,这使得用模型并行指定大规模分布式计算变得容易,有时会有数十亿个参数。

相关论文:

The Case for Learned Index Structures

https://arxiv.org/abs/1712.01208

Dynamic Control Flow in Large-Scale Machine Learning

http://delivery.acm.org/10.1145/3200000/3190551/a18-yu.pdf

Mesh-TensorFlow: Deep Learning for Supercomputers

https://papers.nips.cc/paper/8242-mesh-tensorflow-deep-learning-for-supercomputers

另一个例子是,我们发布了一个使用TensorFlow的可扩展深度神经排序库。

△

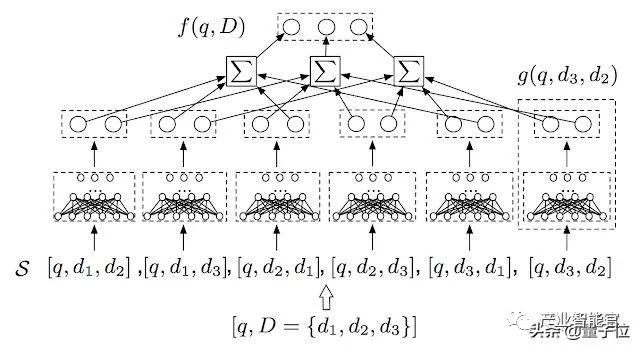

TF-Ranking支持多项目评分体系结构,这是传统单项评分的扩展。

相关论文:

TF-Ranking: Scalable TensorFlow Library for Learning-to-Rank

https://arxiv.org/abs/1812.00073

我们还发布了JAX,这是一个加速器支持的NumPy变体,支持自动将Python函数区分为任意顺序。虽然JAX不是TensorFlow的一部分,但它利用了一些相同的底层软件基础架构(例如XLA),并且它的一些想法和算法对我们的TensorFlow项目有所帮助。

相关开源项目:

JAX

https://github.com/google/jax

最后,我们继续研究机器学习的安全性和隐私性,以及在人工智能系统中老发安全和隐私的开源框架,如CleverHans和TensorFlow Privacy。

相关开源项目:

CleverHans

https://github.com/tensorflow/cleverhans

TensorFlow Privacy

https://github.com/tensorflow/privacy

我们的另一个重要的研究方向是将机器学习在软件系统中在堆栈的许多层面上应用。

例如,我们继续努力使用分层模型将计算部署到设备上,并且我们有助于学习内存访问模式。我们还继续探索如何使用学习指数来取代数据库系统和存储系统中的传统索引结构。正如我去年写下的,我们在计算机系统中使用机器学习仅仅停留在表面。

相关论文:

A HIERARCHICAL MODEL FOR DEVICE PLACEMENT

https://openreview.net/pdf?id=Hkc-TeZ0W

Learning Memory Access Patterns

http://proceedings.mlr.press/v80/hashemi18a/hashemi18a.pdf

2018年,得益于Google的Project Zero团队与其他人的合作,我们发现了Spectre和Meltdown,现代计算机处理器中新的严重安全漏洞,这两者以及其他相关的漏洞让计算机架构研究者们相当忙碌。

在我们继续努力模拟CPU行为时,我们的编译器研究团队将他们用于测量机器指令延迟和端口压力的工具集成到LLVM中,从而可以做出更好的编译决策。

相关文档:

llvm-exegesis - LLVM Machine Instruction Benchmark

https://llvm.org/docs/CommandGuide/llvm-exegesis.html

Google产品,我们的云产品和机器学习模型推理决定了计算、存储和网络提供大规模、可靠、高效的技术基础架构的能力。

过去一年的一些研究亮点包括Google软件定义网络WAN的发展,一个独立的联合查询处理平台,可以在许多存储系统中对基于不同文件格式存储的数据执行SQL查询(BigTable、Spanner、Google Spreadsheets等)以及我们广泛使用的代码审查报告,调查Google代码审查背后的动机,当前的实践以及开发人员的满意度和挑战。

相关论文:

Modern Code Review: A Case Study at Google

https://storage.googleapis.com/pub-tools-public-publication-data/pdf/80735342aebcbfc8af4878373f842c25323cb985.pdf

F1 Query: Declarative Querying at Scalehttps://storage.googleapis.com/pub-tools-public-publication-data/pdf/fa380016eccb33ac5e92c84f7b5eec136e73d3f1.pdf

运行内容托管等大型Web服务需要在动态环境中实现稳定的负载平衡。我们开发了一致的哈希方案,对每台服务器的最大负载提供了严格的可证明保证,并将其部署到Google Cloud Pub/Sub中的云客户。

在提供了我们论文的早期版本后,Vimeo的工程师找到了论文,在haproxy中实现并开源,并将其用于Vimeo的负载平衡项目。结局是戏剧性的:应用这些算法思想帮助他们将缓存带宽减少了近8倍,消除了缩放瓶颈。

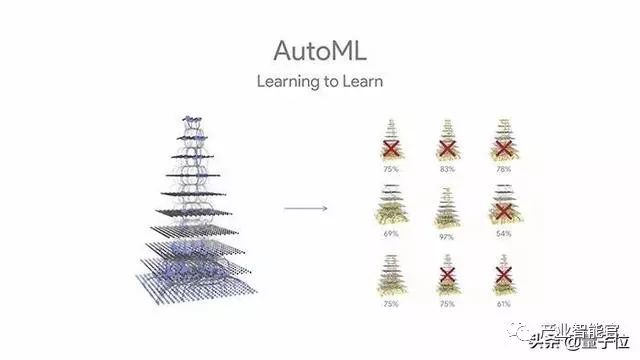

AutoML

AutoML,是用机器学习来加速机器学习的一种方法。

在这个领域,我们已经做了很多年的研究,长期目标是开发出那种

拿到一个新问题,也能自动解决

的学习系统:

从之前解决的问题里面获得的启发、习得的能力,就是处理新问题的依据。

这一领域的早期研究,大多是用

强化学习

做的,不过我们也对

进化算法

感兴趣。

去年我们就展示过,怎样用进化算法自动找到各种不同的视觉任务里,最先进 (State-of-the-Art) 的神经网络结构是什么。

我们还探索过,怎样把

强化学习

用到神经网络结构搜索以外的其他地方。发现有这些用途:

1) 自动生成图像变换序列 (Image Transformation Sequence) ,来提高各种图像模型的准确性。

2)找到新的符号优化表达方式 (Symbolic Optimization Expressions),比常用的优化更新规则更有效。

我们在AdaNet上的成果,展示了如何造出一个快速灵活的AutoML算法:

另外一个关注点,是自动发现

计算效率高

的神经网络结构,让网络在手机、自动驾驶汽车这样的环境下也能跑起来:不论是计算资源有限,还是时间有限。

在这个问题上,我们证明了:把模型准确度和推理计算时间结合到一起,来设置强化学习的奖励函数,就可以找到高准确度的那些模型,应对不同的环境限制。

除此之外,我们也探索了用机器学习

自动压缩机器学习模型

,减少参数,就会减少计算资源的占用。

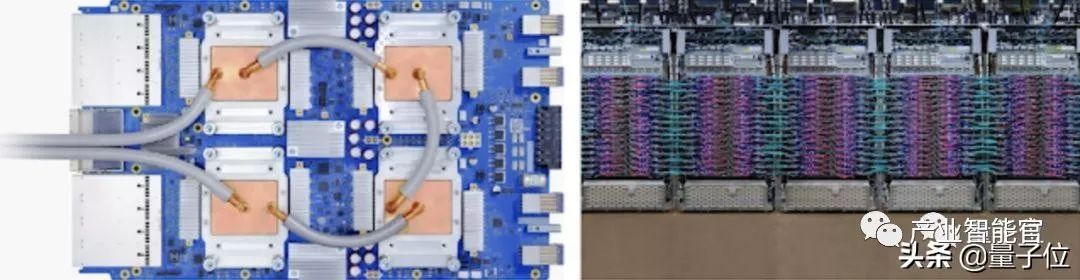

TPU

TPU是谷歌内部用的机器学习硬件加速器,从一开始就是设计用来支持

大规模训练

和

大规模推理

的。

谷歌的许多重大突破都是在TPU的加速下实现的,比如刚才讨论过的BERT自然语言处理模型。TPU也能让世界各地的研究人员在谷歌开源研究的基础之上,寻求自己的研究突破。

还是以BERT为例,任何人都可以在TPU上,用Colab来给BERT做微调。TensorFlow Research Cloud已经为数千研究人员,提供了大量的云TPU算力。

我们还把多代TPU硬件,用云TPU的形式做了商用:比如名叫Cloud TPU Pods的机器学习超级计算机,支持大规模训练。

而在谷歌内部,除了让机器学习研究进步更快之外,TPU也驱动了谷歌核心产品的重大改进:搜索、YouTube、Gmail、谷歌助手、谷歌翻译,等等。

希望不论是谷歌还是谷歌以外的机器学习团队,都能在TPU提供的、前所未有的计算规模之下,达成更多的成就。

开源软件和数据集

发布开源软件、创建新的公共数据集,是我们为学界和业界做出贡献的两种主要方式。

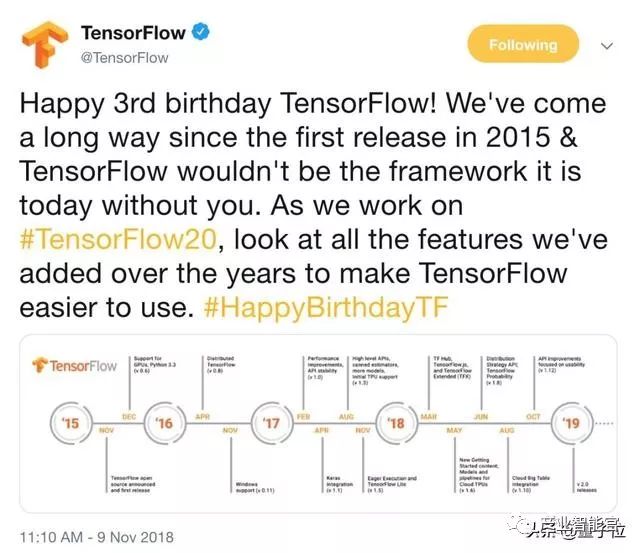

TensorFlow

在这一方面,我们做过最大的努力之一就是TensorFlow。2015年11月发布的机器学习系统,不久前才庆祝了三岁生日。

三年间,TensorFlow已被下载了超过3000万次,贡献者超过1700个,添加过45000多次代码 (Commits) 。

2018年,TensorFlow经历了8次主要版本更新,增加了重要功能:比如Eager Execution,以及分布策略 (Distribution Strategies) 。

我们还在开发过程中启用了

大众评审

,让广大贡献者都参与进来。

随着TensorFlow Lite、TensorFlow.js和TensorFlow Probability这些相关产品的推出,TensorFlow生态系统在2018年茁壮成长。

我们很高兴地发现,TensorFlow的GitHub的用户留存率 (User Retention) ,在主流机器学习/深度学习框架里面是最高的。

除此之外,TensorFlow团队也在加快处理GitHub上面讨论的问题 (Issue) ,给外部贡献者提供一个更好的体验。

研究方面,TensorFlow还在继续为这个世界大量的机器学习和深度学习研究提供支持,从Google Scholar论文发表的数据上就能看出。

另外,

TensorFlow Lite

仅仅上线一年,就有15亿台设备搭载了这套系统。

还有,

TensorFlow.js

是JavaScript机器学习框架里面的第一名:推出9个月,CDN (内容分发网络) 点击量已经超过200万,下载25万次,GitHub标星10000多。

其他框架

除了继续发展开源生态系统,2018年还发布了一个新框架“多巴胺 (Dopamine) ”,用来做灵活、可重复的强化学习。量子位报道在此:

令人激动!谷歌推强化学习新框架「多巴胺」,基于TensorFlow,已开源丨附github

发布了What-If可视化工具,可以快速了解数据集的特征(无需编写任何代码):

pair-code.github.io/what-if-tool/

发布了

TF-Ranking

高级库,用来表达涉及排名的机器学习问题 (报道如下) :

谷歌开源TF-Ranking可扩展库,支持多种排序学习

发布了

AdaNet

,一个快速灵活的AutoML框架 (报道如下) :

谷歌开源集成学习工具AdaNet:2017年提出的算法终于实现了

还发布了能在浏览器里

实时做tSNE可视化

的框架,基于TensorFlow.js:

https://github.com/tensorflow/tfjs-tsne

数据集

公开数据集是很好的灵感来源,可以让整个学界看到有趣的数据和有趣的问题,在许多不同的任务上获得更好的结果。

这一年,我们很高兴地发布了

谷歌数据集搜索引擎

,可以在全网搜索数据集:

Google数据集搜索神器上线,和搜索论文一样简单 | 还不去训练网络?

发布了

Open Images V4

,一个包含190万张图1540万个边界框、600个类别的图像数据集:

https://storage.googleapis.com/openimages/web/index.html

发布了动作识别

AVA

数据集,提供视听双重标注:

https://research.google.com/ava/download.html

还发布了新版本的

Youtube-8M

数据集,包含610万个调视频,3862个类别,26亿次视听特征标注:

https://research.google.com/youtube8m/download.html

HDR+连拍数据集 (HDR+ Burst Photography Dataset),是计算摄影领域的数据集:

https://hdrplusdata.org/

Google-Landmarks,地标识别数据集:

https://www.kaggle.com/google/google-landmarks-dataset

其中,许多数据集都是伴随着挑战赛一同发布的,HDR+连拍数据集也是,地标数据集也是,Youtube-8M也是。还有一场Kaggle比赛,内容是识别“Quick, Draw!” (猜画小歌) 数据集里的涂鸦:

https://quickdraw.withgoogle.com/data

机器人

2018年,我们朝着理解机器学习如何教机器人在世界上行动的目标,取得了重大进展,教机器人抓取新物体的能力也达到了一个新的里程碑,并通过这种方式帮助机器人在没有人类监督的情况下了解物体。

将机器学习、基于抽样的方法和机器人几何学结合,我们在机器人运动学习方面也取得了进展。机器人在通过自主观察来更好地理解世界结构的能力上,取得了巨大的进步。