本文内容非商业用途可无需授权转载,请务必注明作者及本微信公众号、微博 @唐僧_huangliang,以便更好地与读者互动。

接前文《

从

PowerEdge MX

看刀片服务器的进化

》

《

PowerEdgeMX SAS

存储交换应用:类

ODA

数据库一体机,还有啥?

》

最近比较忙,不过之前说过要写的东西还是尽量去兑现。另外就是之前写出一点错误和不足之处也想在本文中补充交代下。

首先是上一篇中提到的

PowerEdge MX7000

模块化服务器

SAS

交换的“驱动器分配模式”,应该是只能用

PERC H745P MX RAID

卡,而不能用

HBA330 MMZ

。

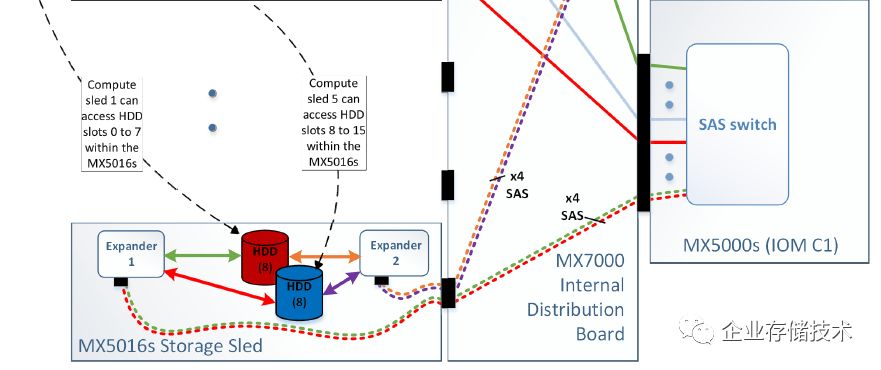

根据我对这一块设计的理解,当一个

MX5016s

“存储刀片”中的

HDD/SSD

允许分配到不同服务器节点时,默认要使用

RAID

卡来保证可靠性。而

SAS HBA

卡主要针对软件定义存储(

SDS

)使用场景,比如

vSAN

分布式存储

/

超融合,计算刀片分别连接不同存储模块中的盘,在此基础上跨

Storage Sled

利用多副本保护数据。

无中板设计:区别于传统刀片服务器

之前我留意到

PowerEdge MX

前后风扇不同风道的散热设计,但忘了跟大家讲一点前提。就是传统刀片服务器在前端计算刀片和后端网络交换模块之间,通常是有中板转接的,这也可能制约到

机箱后续的网络带宽升级

。

比如之前的

PowerEdge M1000e

的网络应该就没有升级到

100GbE

,相比较下

MX7000

的

7U

机箱规模要小一些,采用了简洁的无中板设计(如上图)。这样同时也

优化了散热气流

,因为中间少了阻隔。

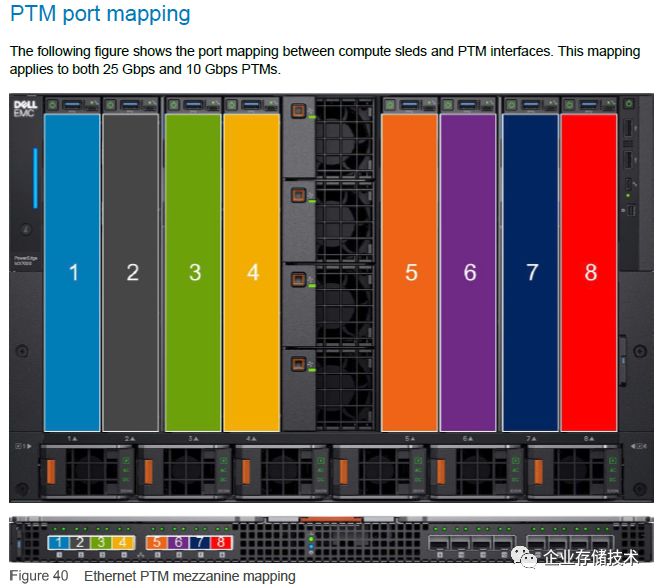

对于

PowerEdge MX7000

而言,最基础的网络模块是直通(

pass-through modules

)。上图可以看到计算刀片与

PTM

上面的端口对应关系,这里支持

25Gbps

和

10Gbps

网卡接口。

32G FC to FCoE

网关为何有

25Gbps

、

28Gbps

两种速率

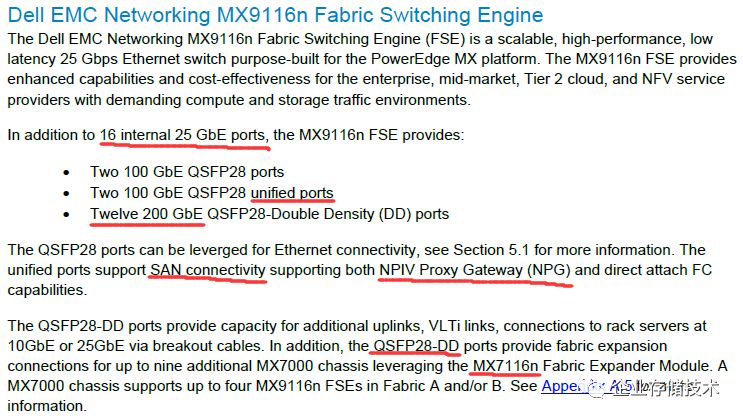

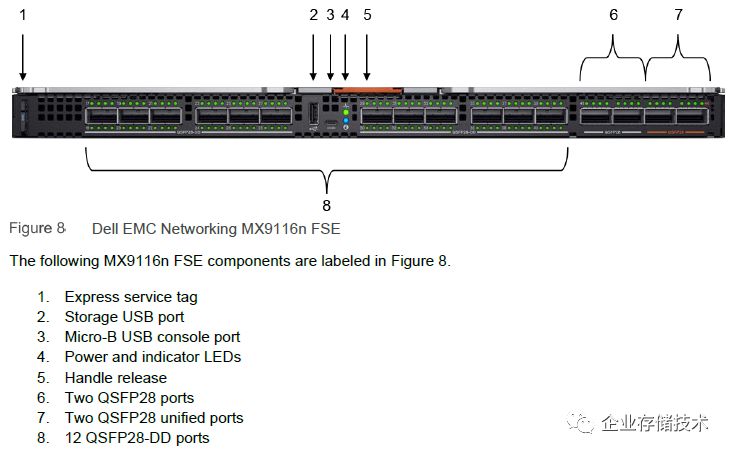

对于

MX7000

模块化服务器中最高端的

Dell EMC Networking

MX9116n FSE

(

Fabric Switch Engine

)网络模块,除了

16

个

25GbE

内部接口,还有

2

个

100GbE QSFP28

接口、

2

个

100GbE QSFP28 unified ports

,以及

12

个

200GbE QSFP28-DD

(双倍密度)接口,后者可以用来连接不同

MX7000

上的

MX7116n Fabric

扩展模块

,下文中我再详细解释。

首先我们来看看

unified ports

(统一接口)的工作原理,它能够提供

FC SAN

存储下行连接能力,支持

NPIV

代理网关(

NPG

)

和直连

FC

功能。也就是让服务器可以用

FCoE

来连接光纤通道阵列,提供除了

MXG610 FC

交换机模块之外的另一种选择。

由于

32Gb FC

的

64b/66b

编码,实际有效数据

传输速率为

28Gbps

。

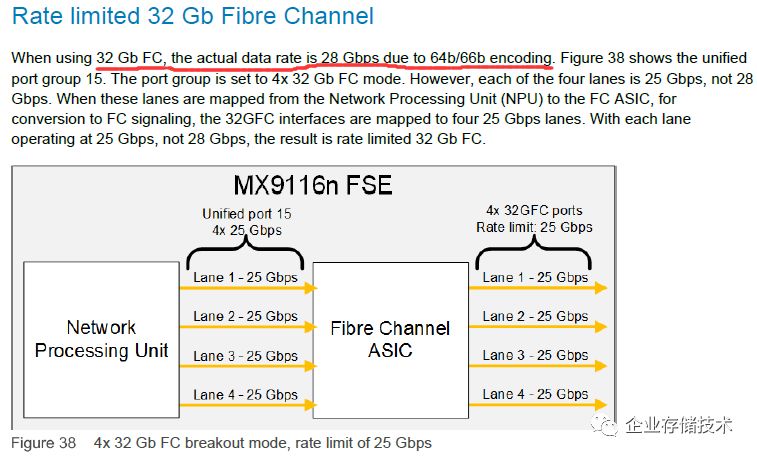

上图是

unified ports

底层的芯片设计。一种选择是

MX9116n

的

NPU

(网络处理单元),可以用

Unified port 15

的

4

个

25Gbps Lane

连接到

Fibre Channel ASIC

桥接芯片,然后提供

4

个速率限制为

25Gbps

的

32G FC

接口。

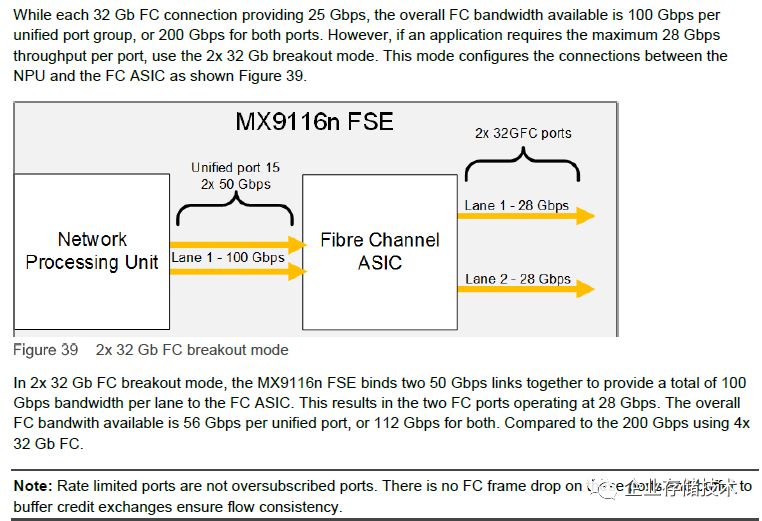

如果用户想要无折扣全速的

32G FC

,还有下面这种选择。

这个模式是把

NPU

到

FC ASIC

之间的

100Gbps Lane

配置为

2

个

50Gbps

,如此就能提供

2

个

28Gbps

全速的

32G FC

接口。

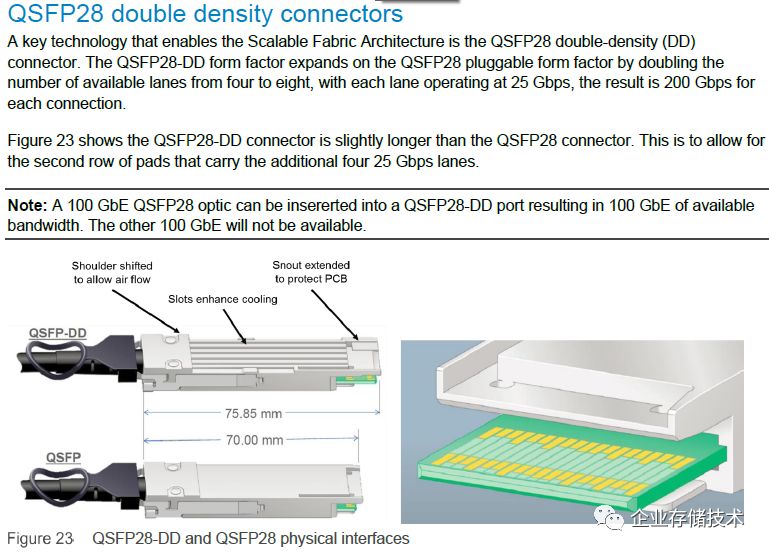

QSFP28

双密度连接器:从

MX9116n FSE

扩展到

MX7116n FEM

能在一个

QSFP28-DD

接口上跑

200Gb

双向带宽的秘密,就是那

2

排金手指触点

,这样就将

25Gbps lane

从

4

个翻倍达到

8

个。该模式应该是只用于

MX9116n

到

MX7116n

之间的连接,如果在同一接口中插入普通的

100GbE QSFP28

光纤,则只能用到一半也就是

100GbE

的带宽。

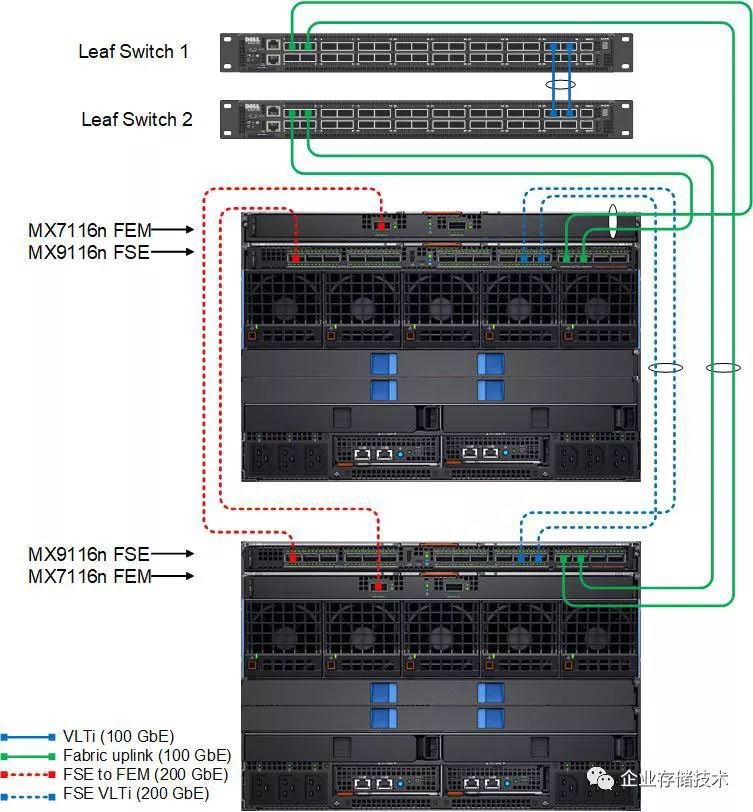

如上图,在

2

个

MX7000

机箱(刀箱)中各配有

1

个

MX9116n Fabric

交换机和

1

个

MX7116

扩展模块,每个

MX7116n

分别通过

200GbE

(红色虚线,

QSFP28-DD

)连接到另一个

MX7000

上的

MX9116n

上面。根据我有限的网络知识,此二者之间的关系是不是有点像

Cisco Nexus 2000

和

7000

系列那样?

MX7116n

并不是完整功能的独立交换机

,就是专用于多套

MX7000

机箱扩展的

SmartFabric

组网

。

蓝色虚线的

FSE VLTi

(

200GbE

)是

MX9116n FSE

交换机之间互连的

200GbE

(

2

条

100Gb

);绿色实现就是普通的

Fabric uplink

100GbE

上行连接了,比如南北向接口上方的

Leaf Switch

可以用

Dell Z9100-ON

。

Dell EMC Networking MX9116n

、

MX7116n

,以及

MX5108n

这几款交换机,应该都是由当初收购

Force10

技术发展而来的。比如

SmartFabric

模式,支持的也是

OS10EE

系统命令行。

可视化管理界面、模块化服务器的客户心声

刀片类服务器的一大优势,或者说重要价值点就在于集中管理系统。用过

Dell

服务器的朋友,估计不少都知道

Open Manager

(

OME

)管理软件。本次针对

PowerEdge MX7000

新型号,特别推出了

OpenManage Enterprise– Modular Edition

(

OME-M

)模块化版本。

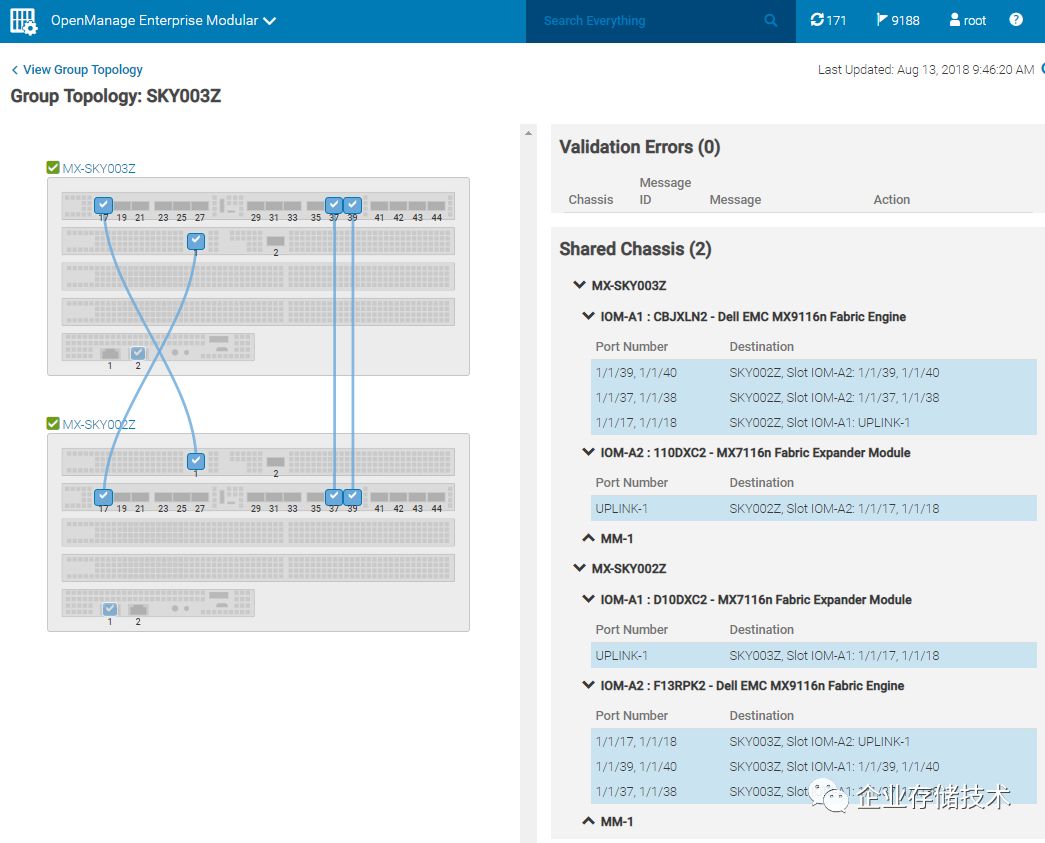

如上图,

MX9116n

和

MX7116n

之间网络连接的可视化效果,还是很容易理解吧?

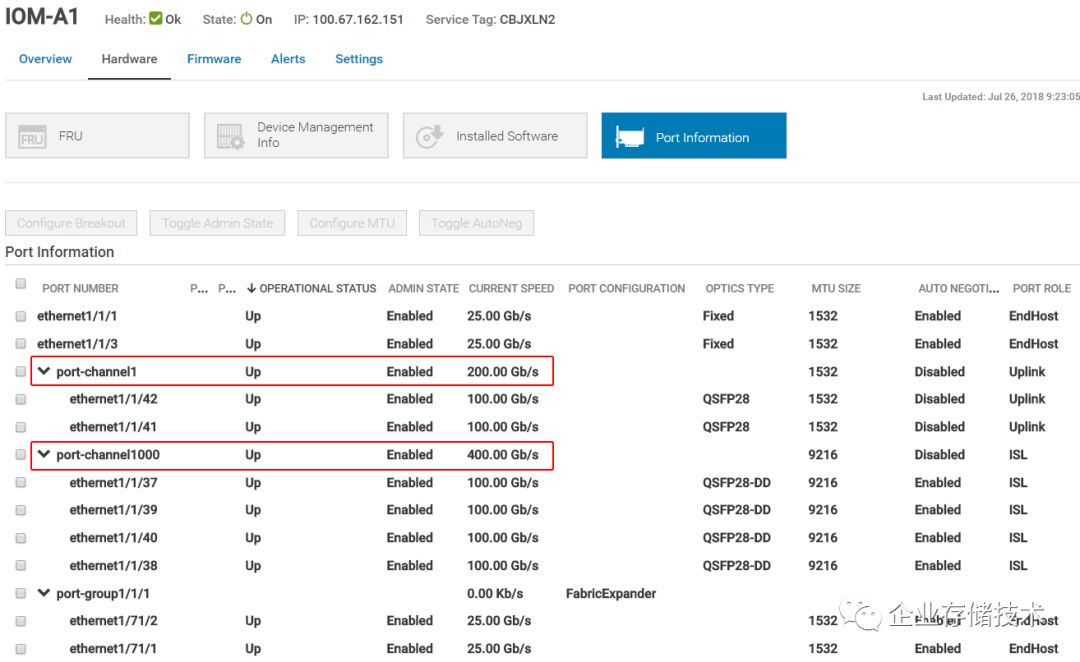

再来看下上面这个示例:

IOM-A1

槽位中的

MX9116n

有

2

个

QSFP28

网口组成

200 Gb/s

的

Uplink port-channel

;另有

4

个

QSFP28-DD

(此时未工作在双倍密度模式)网口配置为另一个

400 Gb/s ISL port-channel

。

上图节选自

Dell EMC

中文网站

PowerEdge MX7000

网页的客户证言。

华大基因生物计算

HPC

平台高级工程师李焱

对之前一代模块化服务器

FX2

的管理程序、包括

CMC

和

iDRAC

给出了满意的评价。

如今除了更新的管理软件,

CMC

(机箱管理控制器)在

MX7000

上也已经升级到下一代模块,希望青出于蓝能够胜于蓝吧。

至此,本文系列

3

篇就先告一段落了,有没有朋友想亲眼看下

PowerEdge MX7000

的实物呢?据说今天在北京国家会议中心举行的

2018

戴尔科技峰会

上要展出一台样机。如有想在现场聊下的朋友,也可以给我发消息哦:)

注

:本文只代表作者个人观点,与任何组织机构无关,如有错误和不足之处欢迎在留言中批评指正。

进一步交流

技术

,

可以

加我的

QQ/

微信:

490834312

。如果您想在这个公众号上分享自己的技术干货,也欢迎联系我:)

尊重知识,转载时请保留全文,并包括本行及如下二维码。感谢您的阅读和支持!《企业存储技术》微信公众号:

HL_Storage

长按二维码可直接识别关注

历史文章汇总

:

http://chuansong.me/account/huangliang_storage