来源 |

Object Instance Mining for WeaklySupervised Object Detection

出品 | AI科技大本营(ID:rgznai100)

商汤科技视频大数据团队发表论文《Object Instance Mining forWeakly Supervised Object Detection》,该论文被AAAI 2020录用。

该团队提出了一种端到端的物体实例挖掘弱监督目标检测框架

,引入了基于空间图及外观图的信息传播机制,在网络迭代学习过程中,尝试挖掘每张图像中全部的物体实例。

除此之外,还引入了物体实例权重调整损失函数(reweighted loss),

使网络可以同时学习到更完整的物体实例,从而让弱监督目标检测方法得到更加准确的检测框。

详细解读

目标检测,

是计算机视觉领域长期关注的问题,

在自动驾驶、图像理解、视频监控等领域都有着广泛的应用

。

然而基于深度学习技术的目标检测器在网络训练中需要大量精确标注的物体边界框,这些耗时耗力的标注工作阻碍了该技术在实际产品中的快速和广泛应用,同时大量的人工标注也大大提高了产品成本。

为了解决这个局限性,

仅使用图片级别标注(既标注仅包含图片中物体的类别)的弱监督目标检测技术在近几年受到了广泛的关注和研究,

具有重要的意义。

现有的弱监督目标检测方法大多数是基于多实例学习框架的,对于每个物体类别,基于多实例学习框架的方法倾向于学习图像中该类中特征最明显的物体,并对于每张图片选取得分最大的一个物体框进行训练,其他被忽略的物体实例容易使学习网络陷入局部最优,进而影响弱监督目标检测的性能。

本论文提出了一种端到端的物体实例挖掘(Object Instance Mining,OIM)弱监督目标检测框架。

该框架引入了基于空间图(Spatial Graph)及外观图(Appearance Graph)的信息传播机制,在网络迭代学习过程中,尝试挖掘每张图像中全部的物体实例。

这样使得在基于多实例学习方法的网络学习过程中,

特征不够显著的物体实例可以被检测到并加入训练,进而提升特征的表达能力和鲁棒性

。

除此之外,商汤科技视频大数据团队还引入了物体实例权重调整损失函数(reweighted loss),使网络可以同时学习到更完整的物体实例,从而让弱监督目标检测方法得到更加准确的检测框。

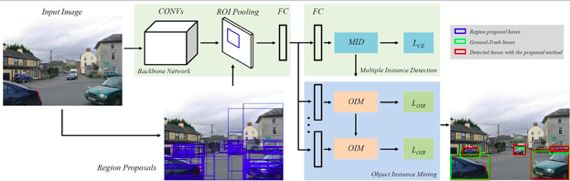

基于物体实例挖掘(OIM)弱监督目标检测框架结构如下图所示:

物体实例挖掘(OIM)弱监督目标检测框架

该框架主要由多实例检测(Multiple Instance Detection)及目标实例挖掘(Object Instance Mining)两个部分构成。在网络训练迭代过程中,论文先使用多实例检测预测每个候选区域的类别,之后基于检测的输出及候选区域的特征,通过建立空间图及外观图尽可能挖掘图像中的全部物体实例,并将它们加入训练。其中物体实例挖掘过程如下图所示:

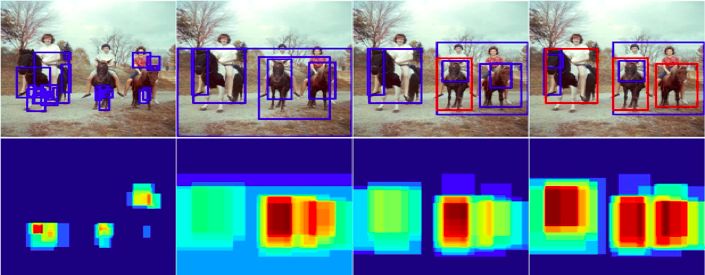

物体实例挖掘过程示例。

在网络训练迭代过程中,在一幅图中,首先学习/检测到最具辨识力的物体实例,基于此实例通过位置关系,既其他候选框与此实例的重叠关系,建立空间图(Spatial Graph),

如图(a)

。

之后基于此实例,通过计算它与其他候选框之间的外观相似度,挖掘图片中可能属于同一类别的物体实例,建立外观图(Appearance Graph),针对每一个新挖掘到实例同样建立空间图,

如图(b),(c)

。以此步骤进行迭代训练,直到挖掘出图像中全部可能的物体实例加入训练

如图(d)

。

除此之外,由于在网络迭代学习过程中,尤其是对于非刚性物体实例,基于CNN的分类器学习到的最具辨识力的是物体实例的某个局部而不是整个物体的整体,

因此本论文设计了物体实例权重调整损失函数(reweighted loss), 以学习到更准确的物体检测框。

团队提出对于不同的候选框应分配不同的权重,对于分类器置信度得分高的候选框分配较低的权重,反之对最高分候选框周围的候选框分配较高的权重,从而学习更完整的物体实例检测框。

团队在PASCAL VOC 2007训练集上进行了弱监督物体实例挖掘的过程的可视化,如下图所示(从左到右),随着网络的迭代学习,更多更准确的物体实例可以被检测出来并加入训练中。

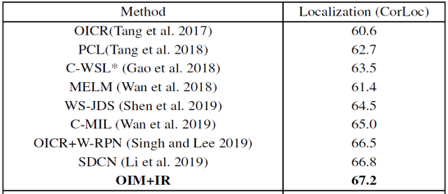

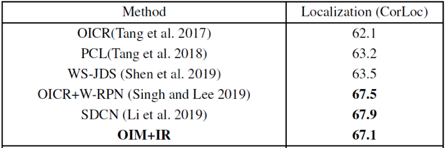

团队使用 PASCAL VOC 2007及VOC 2012数据进行了测试,比较了物体实例挖掘(OIM)方法与其他相关弱监督检测方法效果。结果表明,弱监督物体实例挖掘方法在定位精确率以及检测准确率均达到或超过目前最先进的方法。

OIM与其他目前最先进的方法在PASCALVOC 2007 测试集上检测精确度的比较(AP) (%)

OIM与其他目前最先进的方法在PASCALVOC 2007训练验证集上定位精确度的比较(CorLoc) (%)

OIM与其他目前最先进的方法在PASCALVOC 2012 验证集/测试集上检测精确度的比较(AP)(%)

OIM与其他目前最先进的方法在PASCALVOC 2012训练验证集上定位精确度的比较(CorLoc) (%)

论文:Object Instance Mining for WeaklySupervised Object Detection

论文作者:Chenhao Lin, Siwen Wang, Dongqi Xu, YuLu, Wayne Zhang

论文地址:

https://arxiv.org/pdf/2002.01087.pdf

(*本文为投稿文章,投稿请微信联系1092722531)

为了助力对抗疫情,减少线下人员流动和聚集,CSDN与 PyCon 官方授权的 PyCon中国社区合作,举行「

Python开发者日

」在线系列峰会。通过精彩的技术干货内容、有趣多元化的在线互动活动等,让您足不出户便可与大咖学习交流,共同渡过抗疫攻坚期。

扫码入群咨询详情!