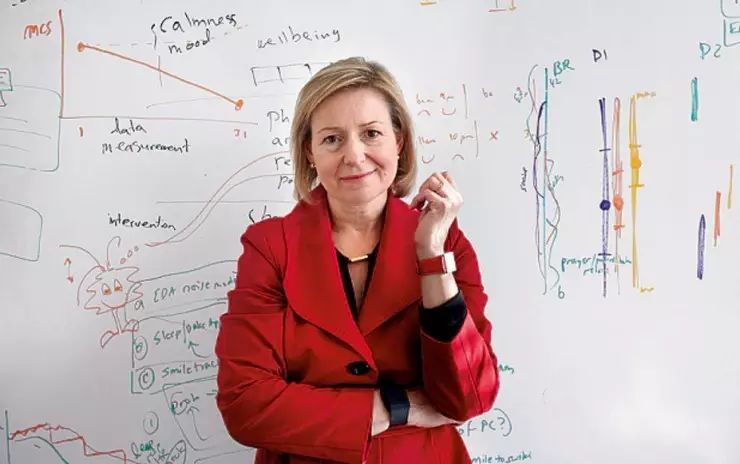

编者按:本文中,雷锋网将为大家介绍一名在世界 AI 江湖享有特殊声望的

人工智能

大牛—— Rosalind Picard。

她是麻省理工学院(MIT)教授,在 MIT 的跨领域尖端科学实验室 Media Lab 从事机器学习与神经科学的交叉研究,一手创立了 Media Lab 情感计算研究部

。她同时是两家初创公司 Affectiva 和 Empatica 的联合创始人,前者研

发情绪识别、监测技术,后者生产整合这些技术的医疗传感器,例如医

用

可穿戴设备

。但最重要的是,

她的著作《Affective Computing》开创了计算机科学和人工

智能

学科中的

新分支——“情感计算”。

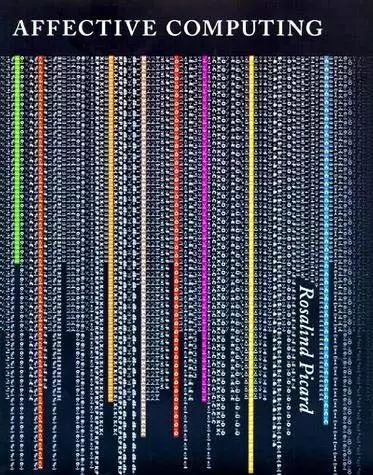

《Affective Computing》

她的研究横跨多个领域,涉及脑神经科学、计算机视觉、人机交互等等,但专注于情绪识别,以及人机交互中的情感沟通。她的研究之路并不平坦。在机器学习技术停留在算法时代时,研究 “情感” 并不受到学界的欢迎。一开始,各大 AI 学术会议拒绝接受她的成果与论文。但随着 AI 技术的发展,

如何赋予 AI“认知” 与 “情感”

这一课题变得越来越突出。李飞飞就在近日表示:

“我认为下一步人工智能的发展,需要加强对情感,情绪的了解,要走进认知学,心理学。我说的不仅是脑科学,而是认知学。因为我们目前对人的情感理解非常少,而这对于人工智能来说是很重要的。”

而身为 “情绪计算” 之母的 Rosalind Picard,便是该领域首屈一指的专家。在机器学习算法工具日渐普及的今天,人们猛然醒觉 “认知”“情感” 正是创造出真正的 AI 的瓶颈。于是,全世界的目光都投向了 Rosalind Picard 的研究。

此次,AAAI 2017 邀请她前来做专题演讲,介绍

“情绪计算” 学科的由来、情绪识别机器学习算法、以及能监测人体焦虑、紧张情绪的传感器的最新研究进展

。雷锋网记者对现场演讲进行了编译、梳理,非常适合关注情绪识别 CV 技术,和 “情绪计算” 商业化落地应用的读者们。注:本文由三川、亚萌联合编辑。

Rosalind Picard

Rosalind Picard:

这次演讲中,我想要与大家分享很多故事。尤其自我早年受到 AI 启发后,研究中遇到的惊奇发现。

我年轻的时候,想要创造一个无比智能的 AI 。它的智慧程度就像马文明斯基的描述那样:“它是那么得智慧,如果它把我们当做宠物一样养着,只会是我们的幸运”。一开始我觉得这特别酷。但细想之下就意识到,我并不想成为家庭宠物。但我仍然想要开发高度智能的 AI,来理解我们的大脑如何工作——对此,创建一个会思考的智能个体,是最好的方式。

为什么研究 “情感”?

学习生涯中,我被训练为一个电气工程师——偏向于架构方向,尤其是芯片和硬件设计。我对一件事非常感兴趣:这些零件怎么组合成一个系统,使得我们能 “看”。我从事了计算机视觉,并在人类 “感知”(perception)领域做了广泛阅读,包括感知如何在我们的大脑中运作。

该过程中,我遇到了一个十分惊奇的发现:

大脑深处涉及情感、记忆、意图的部分,对大脑皮层(cortical)的影响,要比大脑皮层对它们的影响要大。

而大脑皮层被看做是人类智慧活动发生的场所。当时我想,记忆和意图十分重要,但我不想涉及情感。这背后有一些小心思:作为一个工程学和计算机科学专业的女人,我不想把 “情感” 话题带进研究,会让别人笑话(雷锋网注:男性占据大多数的领域对女性的性别偏见)。

但了解地越深,我越是沮丧地发现,

情感在一系列智能活动中都起到核心作用:

包括感知、决策、逻辑推理、社交、行动选择、言语措辞。

与此同时,

我们从事的 AI 研究,在各个方面似乎都因为忽视了情感、无法充分理解情感的各项机制,而难以取得进展。

因而我十分不情愿地,打算在这方面做些研究。不出意外,一开始所有成果都被学术会议拒之门外。因此,在即将成为终身教授之前,我写了一本叫 “情感计算” 的书《Affective Computing》。幸运的是,这本书获得了许多人的认可。所以我今天(才能站在这里)十分欣喜地与大家分享,我和我的学生研究生涯中的一些故事,以及学到的一些东西。

情绪识别

研究早期,有一个方面我没能考虑到:HCI (human-machine interface,即人机交互界面)。后来我得到指点——HCI 是智能交互必不可少的前提。我认识一帮芬兰赫尔辛基大学的 HCI 研究人员,他们想,也许计算机科学可算是 HCI 下属的一个子学科,因为最终是人类在对机器进行评估、交互,并且决定了机器的形态、功能。

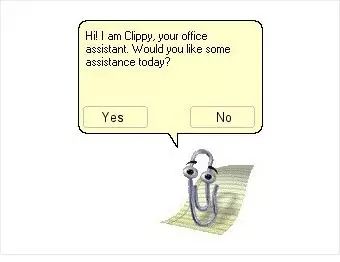

我入行时有一个逐渐形成的大趋势:如果你想要做智能交互,你的工作就是开发那些可爱的智能体(agent)。就比如——有多少人记得微软 Office 的智能助手 Clippy?你或许不知道的是,当比尔 · 盖茨宣布 Clippy 将被取消,大家都给他起立鼓掌。很多人推文:“Clippy 应该被吊死!”。但是为什么他们这么恨 Clippy?Clippy 其实是个很聪明的机器学习 AI,它能准确判断你在 Word 里写的是信件还是普通文章。我认为,大家不喜欢 Clippy 的原因是:它看起来太开心了。而当 Clippy 在 Office 中出现的时候,你的心情如何?恐怕是苦逼(因为在工作)。

微软 Office 智能助手 Clippy

当你心情不好的时候,别人看到你,如果他 / 它有智能,他会改变表情、不再看起来开心,以免刺激到你。但做到这一点,它们需要能感知、识别你的状态;它们需要理解该状态,知道什么才是恰当的反应;它们还需要能够模拟、表现出那个恰当的回应。顺便说一句,这当然不是什么新研究发现,人类知道这一点至少有几千年了——古时的谚语、歇后语、名言警句还有基督教典籍,很多都讲到 “向心情沉重的人唱欢快的歌,就像驱赶冬日的寒冷一样徒劳”。

因此,我们必须在情感上表现得聪明有智慧,识别情感、对它进行回应。即便一台计算机并没有模拟情感的内部机制,既然它们(计算机)会和我们交互,就必须在情感方面变得更智能。

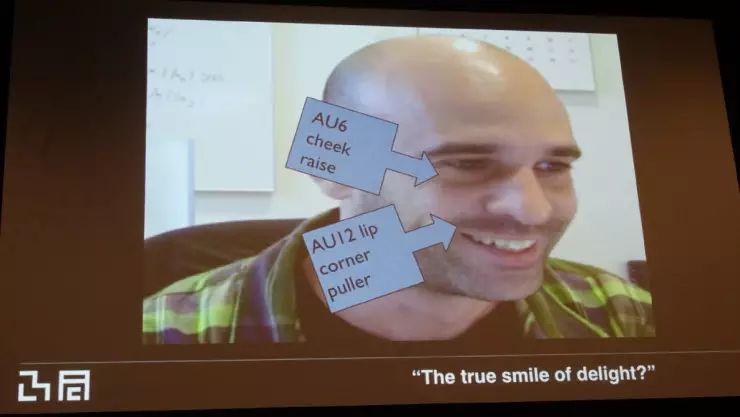

所以我展开研究,利用计算机视觉和其他技术,训练计算机识别人类的情感表达。早年我读到一个情感学家写的东西:在面部运动编码系统(FACS,详见维基百科)中,当一个人同时做出第动作单元 “脸蛋抬升”(Action unit 6:cheek rise)和第 12 动作单元 “嘴角向外拉伸”,这是一个发自内心的笑容,这个人是真的开心。但当朋友给你拍照时,他说 “茄子”,你做出笑容,那却是假的。

第六和第 12 动作单元

研究中,我们录制了一些测试者沮丧时的视频,测试者并不知道我们想要抓取的是沮丧情绪,所以他们的反应真实可靠(雷锋网注:这里 Rosalind Picard 现场播放了一段用作演示)。这段视频中,测试者面部出现两次第六动作单元和第 12 动作单元,但这显然并不是因为开心。这两个动作单元,并不总意味着那个人是发自内心的喜悦。事实上,我们的研究发现,90% 的人在沮丧时做出了这两个面部动作。同样的情况,通过教育软件在幼龄儿童身上被发现。

识别发自内心的笑和苦笑

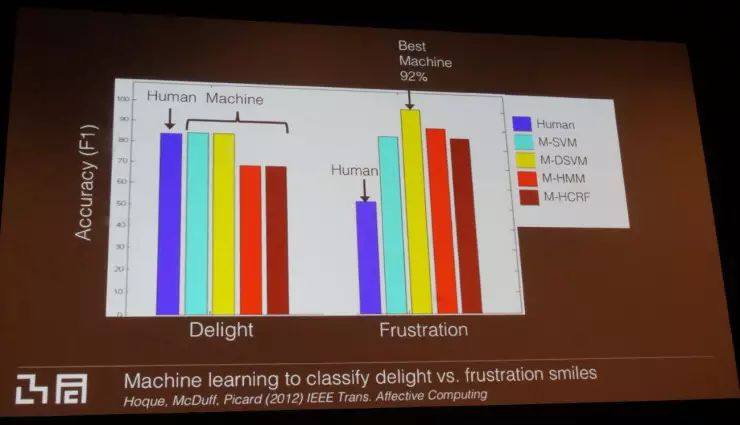

该研究中,我们把四个机器学习算法,应用于区分开心的笑和苦笑(沮丧时的笑容)这一任务。在判断真实笑容上,机器与人类的判断水平相似。在判断苦笑上,机器学习的成功率是 92%,大幅优于人类。当然,这不意味着机器学习在识别所有面部活动上都超越了人类,而仅在人类有感知偏差、会把某个表情误认为是另一个的领域。详情请见我的论文。这其中的一个有效特征很可能是 Dynamics(动态),换句话说,发自内心的笑容有缓慢的展开速度,这是相对于沮丧笑容的突然、迅速——虽然不开心,但要让自己感觉好些。

人类和机器学习算法,识别真笑、苦笑的正确率比较

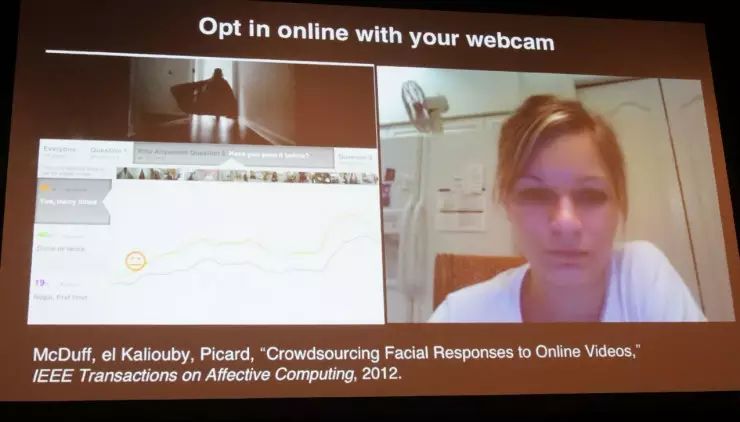

但该研究需要更多的数据,所以我们把许多短视频(包括超级碗 Super Bowl 的视频,都是一些很幽默、喜感的内容,不会让参与者不满)放到网上,邀请人们打开网络摄像头登入观看,分享他们观看时的表情。但这实验中只启用了喜悦笑容的探测。下图左下角的绿线、橙线代表了已经观看过这次些视频的观众,相比首次观看的人(蓝线),他们其实笑地更多。另一个发现是观众发笑的时间——非首次观看的观众,在看到笑点之前就已经有笑的表情。这其实很有趣,这告诉我们,

“笑” 这一行为或许能够揭示人们的过去、以及与特定内容打交道的经历。

人类何时发笑的因素,不止是 “开心”

开发和应用

机器学习开发者们,一直在琢磨如何提升机器学习的成效。我们的实验给开发者社区带来的核心信息是:

相比转换机器学习模型,增加数据量的效果要好得多。

研究中,对于特定(第四)动作单元,真正的提升是在大约 10 万个训练样本之后才发生。第四动作单元是 “皱眉头”(这里指的是眉毛之间起皱纹)——当你聚精会神或对某事感到迷惑、厌恶时的面部活动,很多人眉毛之间都有永久性的“川” 字皱纹。我们开发了一个能根据该动作单元判断情绪表达的检测模型。有用户在很不理想的光线环境下登入测试系统,我们从中获得了很多数据。

如果你想要尝试我们的测试系统,可以在 iOS 应用商店或安卓 Google Play 商店 免费下载,app 名为 “AffdexMe”。

目前,在 24 个面部表情的识别上,AffdexMe 达到了 90% 的精确度,

在印度、巴西和中国、南非、美国、欧洲等地都能下载。我的公司 Empatica 向开发者提供了实时情绪 SDK。如果你需要研究与情绪关联的技术,现在完全免费的(对于研究人员如此。对于商业化应用,在将来未必免费)。

AffdexMe

在面部表情的研究中,我接触到许多患有孤独症的人士。我和我的学生 Steve Mann 开发了类似于谷歌眼镜的设备,并集成了面部表情识别装置。当我戴着该智能眼镜和你说话时,如果你对话题感兴趣并且对我微笑,眼镜屏幕会显示绿色;如果你流露出困惑的神情,我会看到镜片显示的黄色光;如果你流露出负面情绪,我会看到红色光,这向我们提示需要更好地处理谈话。

监测紧张与焦虑

当我与一个患孤独症的年轻女士做实验时,她太紧张与我说话,于是打字对我说:“Ros,你做得不对。你读别人的情绪,对我来说并不是问题,但你读不到我的。” 当时我感到有些受伤,因为这是我赖以谋生的工作。

但她继续说:“并不只是你,所有人都体会不到我的情绪。”

我就说:“大家为什么会体察不出对方的情绪?我们没能从你身上读出的情感是什么?或者,我们读错了什么?” 她说:” 你们感觉不到我的紧张、焦虑。” 我意识到,很多人在高度紧张、心头沉重时,或许其焦虑情绪马上就要爆发,但他自己却没意识到,而是把自己内心关闭,与周遭分隔开。比方说,中学里某老师对一个的男孩子说:“起来!做点正事去”,只是很普通的话。但小男孩却一下子情绪崩溃了,因为他刚被学校开除。如果老师能正确解读这个小男孩的情绪,就能避免类似情况发生。

多年前我们开始做大量情绪检测实验的时候,把这看作是一般性的情绪激动信号,但后来证明它比我们想象的远远更丰富有趣。

对于检测出汗的手掌的技术,过去我们称之为 “galvanic skin response”,如今一般更科学、严谨地称为 “electrodermal activity”(EDA,皮肤电活动),测量皮肤的电导系数(conductance)和微摩尔(micromole)。

在麻省理工的 Media Lab,我们着手开发装备该技术的设备,让测试者七天 24 小时佩戴,监测其数据,希望为情绪崩溃等情绪变化提供线索。Empatica 有两个已经商业化的产品:E4

智能手表

推出已经有一年,专为研究人员收集测试者收据。它已被认证为医疗设备,能收集符合临床要求的数据;另外还有 Embrace

智能手环

,我会随后介绍。

E4 智能手表

我们的兴趣在于,获取能让我们读取自主神经系统(autonomic nerve system)两大分支(“sym

path

etic division” 和 “parasympathetic division”)的数据,它们能呈现出紧张、“fight or flight”(打还是跑)和 “rest and digest”(休息、消化)反应。收集的两大信号会实时传输到移动设备,你能看到皮肤电活动、微摩尔、脉搏(需要按住智能手表),脉搏又可用来计算心率。

除这两大分支(sympathetic,parasympathetic)以外,自主神经系统还有第三个分支:enteric。它很有意思,但现在我们还没有测量的好办法。人脑有数亿个神经元,在人睡眠时会进行无数有趣的活动、还有各种很酷的学习迹象,所以人脑智能研究的成果非常值得期待。但现在的研究重心是逃跑反应(flight response)和 parasympathetic 分支的 “休息、消化”。前者通过皮肤来监测,后者则通常是观察心率图谱中的高频波段。

使用普通

智能手机

监测心率、呼吸频率

由于很多研究有孤独者患者参与,我们经常受到要求,开发他们这一群体易于使用的产品。举个例子,我们研究团队是世界首个利用普通摄像头、计算机视觉技术、时间序列分析(time series analysis)、分解法(decomposition),无需人体接触而根据测试者脸色(雷锋网注:心跳快慢影响面部血液流动,产生面部颜色变化)来读取心率和呼吸频率的算法。

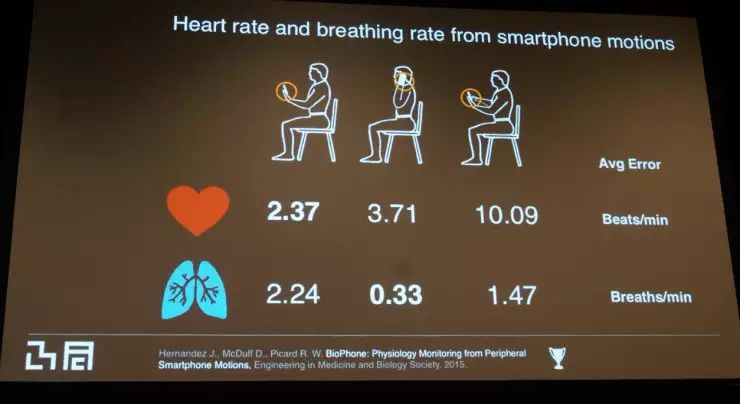

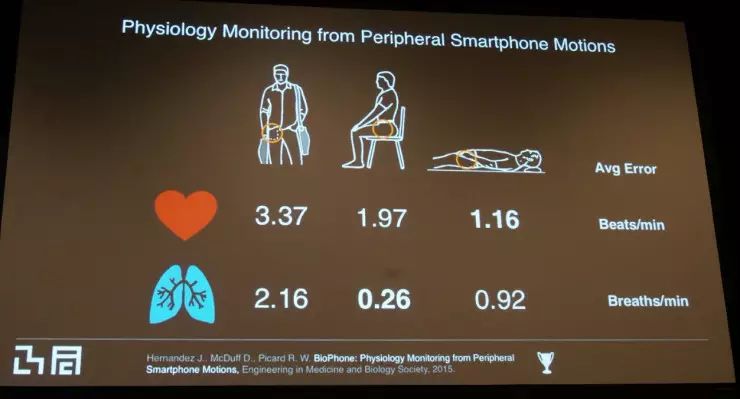

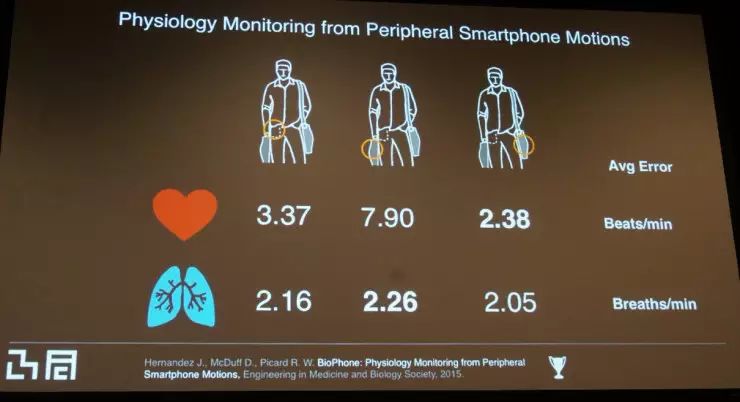

最近,我们在尝试根据你随身携带的物品(例如口袋里的智能手机),读取心率和呼吸频率,而无需佩戴任何设备。我们把该技术的精确率与业界的 “黄金标准”——专业医疗呼吸传感器和 ECG 心率检测设备对比,以下是受试者在不同姿势下的平均误差:

医疗级的手指脉搏传感器(戴在受试者手指)误差在 4 心率 / 分钟左右,而我们的技术平均误差几乎全部在 4 以下,因而可说是十分准确。对于习惯把手机放在手提包里的人们,如果手提包与人体接触有限,仅仅用手提着,误差会稍稍大一些;但如果手提包紧贴于身侧,还是非常精确的。另外,如果你手持智能手机,无论是注视屏幕或是举着它接听电话,监测结果都非常精确。但如果你用手指不停点击屏幕、执行触摸操作,误差会变大,这倒在意料之中。大家请等我们的好消息——

未来会推出能监测心率和呼吸频率的手机 app,而不需要专门的传感器。

用 EDA 监测大脑活动

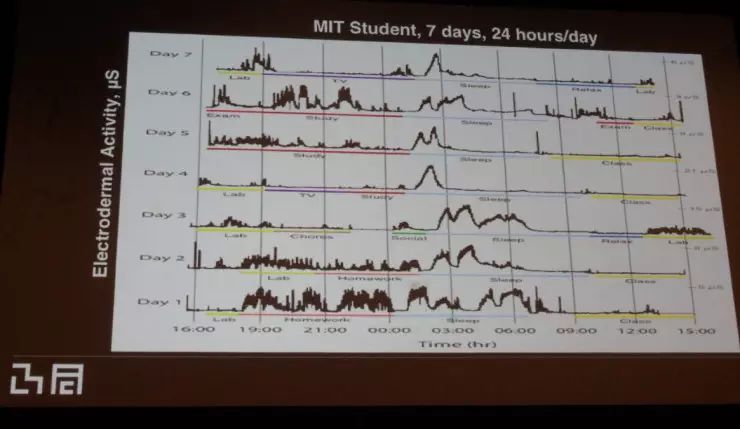

关于 parasympathetic 和心率监测到此为止了,这次讲座剩下的部分将聚焦于 EDA 和电导系数。首先,当下的研究阶段对我来说十分关键——这是我第一次看到测试者七天 24 小时不间断的皮肤电导系数数据,目前测试者全是 MIT 的学生。图中每一行代表着一天。EDA 在实验室工作时段(图中用黄色表示)升高在我们预料之中,这是由于学术交流、认知负荷、情绪负荷、高难度的 MIT 学习和研究(非常难、需要全神贯注的作业)。看电视时 EDA 很低。令人惊讶的是(学生的)社交活动很少,这就是 MIT 的生活(笑)。社交时 EDA 小幅上升,但不及实验室时段。当你只是听别人讲话时,EDA 较低,但当你讲话时,它会上升。

最大的惊讶来自于睡觉时段:这期间的皮肤电活动比一天中其他时段都要高。

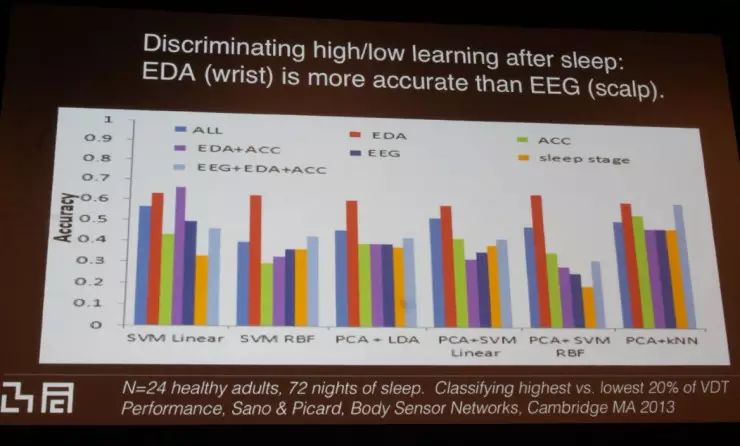

不仅 MIT 学生如此,普通人也是这般。我们对此提出了许多研究问题,也发表了许多论文,在这里,我只想指出一点:我们想知道 EDA、EEG (脑电波监测装置,戴在受试者头部) 和 ACC 各自、以及它们之间组合而成的特征,是否都能反映出睡眠时段的大脑活动高峰期。大家都知道,睡眠让人脑子更好使——当一个人学了些新东西然后去睡觉,睡醒后进行测试往往成绩更好。

于是我们进行了标准的记忆巩固、学习、睡眠实验,把睡眠后比睡眠前提升最大的受试者,和提升幅度最小、甚至没有提升抑或降低的受试者进行对比测试。我们创建了一个二元分类器,来看看是否能够使用这些特征,把两组受试者区分出来。迄今为止所发现的最佳特征是六个智能体(agents)的特征,利用六个很简单的机器学习模型进行特征测试。如图所示,我们看到在一组实验中紫色所代表的测试(EDA+ACC);其它所有实验中红色所代表的测试(EDA),最能辨别出睡眠时的大脑高峰活动。

细想之下,这其实很让人惊讶:为什么手腕上的汗水分泌,会和大脑中的学习活动相关?为什么 EEG 的效果不如它?

监测癫痫猝死症(SUDEP)

当我们成功开发出汗液分析腕带(配有皮肤电导系数传感器,能够七天 24 小时运行)之后,很多人上门借取,用于各种研究。有一天,实验室里的一名本科生对我说:“教授 Picard,我的弟弟不能说话,他有孤独症,我很想知道到底是什么事让他这么紧张?我能借一个智能腕带在圣诞假期时给我弟弟用吗?拜托了!” 我回答道:“当然可以,别只拿一个,带走两个吧。”

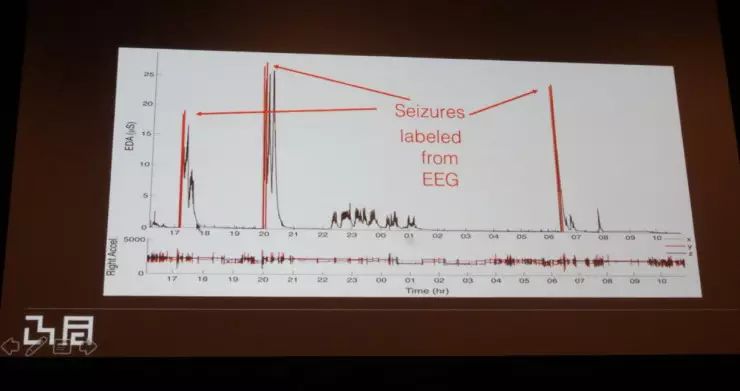

之后,我开始在办公室电脑上查看这个小男孩的数据。第一天很正常,虽然男孩因为不喜欢双手的腕带而尖叫,觉得累赘。第二天也很正常,是个放松的假日。但在第三天,异变发生了:一只腕带的指数突然飙得极高,而另一只腕带却没有反应。我以为传感器一定是坏了,怎么可能身体一侧感到紧张、焦虑,另一侧却没有?我仔细查看数据,两个传感装置在这前后一切正常,任何异样。我试图找到问题所在,但沮丧地一无所获,不得不破例给我假期中的学生打电话。学生说,那刚好是他弟弟癫痫大发作前 20 分钟。

雷锋网按:这件事令 Rosalind Picard 异常震惊,一度以为是传感器故障,这是因为:

-

脑电波在癫痫发作前产生预兆性的异常活动闻所未闻,若证实,将是医学上的突破性发现;

-

癫痫只在身体一侧产生异常反应,亦匪夷所思。

为解开这两个谜题, Rosalind Picard 求证于某儿童医院的癫痫脑外科医生,该医生在从医生涯中的确遇到过癫痫发作前在身体一侧产生生理反应的病例,但医学上尚未有合理解释。于是两人展开研究,在癫痫患者身上进行 EEG、EDA 监测。实验结果证实,所有患者均在癫痫发作时才产生异常脑电波、皮肤电活动(雷锋网 (公众号:雷锋网) 注:小男孩的皮肤电异常,应为无痉挛症状的癫痫发作)。另外,研究发现,由于大脑中许多组织成对出现,当只有其中一个受到异常脑电波刺激,身体另一侧的皮肤会产生异常皮肤电活动(举个例子,若右侧脑组织接受异常刺激,人体左侧皮肤会有异常电活动,反之亦然)。

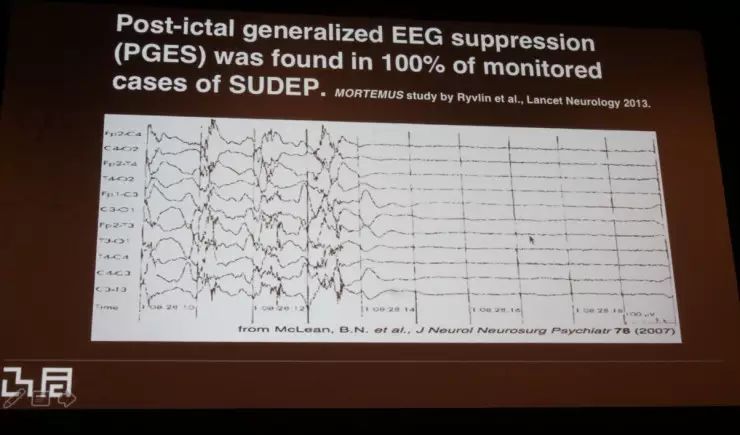

癫痫发作时的脑电波异常

在此这些都不是主要成果,Rosalind Picard 等另外揭开了一个重大研究发现:

当 EEG 传感器检测到测试者脑电波活动停止时

(癫痫猝死症(SUDEP)症状,大脑活动完全停止,导致患者呼吸停止),

停止的时间越长,死亡的风险就越大,但同时,EDA 检测到的皮肤电指数就越高。

癫痫猝死症时,大脑活动停止

简而言之,

皮肤电活动指数能准确监测癫痫猝死症。

该发现意义深远——这代表着,若癫痫患者随身佩戴 EDA 传感设备,一旦癫痫猝死症发作,系统就能立刻通知其他人,予以救援。顺便说一句,癫痫猝死症的死亡率在神经系统疾病中仅次于中风,排在第二名,超过阿兹海默症(注:民间常做老年痴呆症);但当它发作,癫痫者昏迷时,外界及时干预具有非常高的成功救活几率。许多不

必要

的死亡,其实是癫痫猝死症未能及时发现。

因此,Rosalind Picard 和她的同事推出了智能腕带 Embrace,内置 EDA 模块,能准确监测癫痫患者的状态。Embrace 已获得欧盟的医疗设备认证,并正在申请美国的许可。

Embrace

Embrace 发布之后,Rosalind Picard 收到一个患者家庭的感谢信。事情是这样的:该家庭的妈妈给患有癫痫的女儿买了 Embrace,24 小时佩戴。出事时,妈妈正在家里洗澡,但她的智能手机突然发出 Embrace 发来的警报。她拿起手机看了一下,不确实是否该相信,但犹豫一下后就冲出浴室,发现女儿脸朝下趴在地面上,呼吸停止,脸色变成了蓝紫色。她把女儿翻过来,实施简单的刺激,女儿重新开始呼吸,脸色慢慢变红。她十分感谢 Embrace 救了女儿一命。

被妈妈和 Embrace 拯救的小女孩

预防抑郁症

我们正在做一些更具深远意义的事情。

在美国 15-44 岁的人群中,重度抑郁症是造成残疾的主因。下面是 CDC 搜集的横跨 15 年的数据,反映出一个非常严肃的社会趋势:

抑郁症不仅在美国,在全世界范围内都将成为人类的重大生存威胁:发展中国家的自杀率更高且仍在增长。

WHO (世卫组织)的预测是:

当然这个数据只是预测,我们不希望这成为现实。所以在麻省理工的 MediaLab,我们在思考:“为什么不开发一些预防措施呢?” 今天,我们已经能很容易地从手机、可穿戴等设备里获得情绪焦虑数据、睡眠数据、社交数据和其它情绪数据。我们每年从参与研究的用户身上,搜集超过 10 亿样本数据,包括睡眠波、运动、光照(lightning exposure)、自主神经系统焦虑、发信息行为、打电话行为、地理位置、社交网络互动 、移动出行等等数据。

结合机器学习技术进行因果推理,我们或许能预测情绪变化。如果我们能预测出部分心情变化,那么就能避免一些对自己不利的事,提高生活品质。举个例子,当你工作到凌晨,不确定是要去睡觉,还是多花点时间把工作完成。机器学习算法可根据过去的数据,推算出如果你熬夜工作,第二天身体状态会很不好、心情很差的概率,再根据推算结果给出建议。

但现在的数据规模还远远不够,需收集更多。若有了足够的数据,如果我们能为每个城市做天气预报,为什么不能给每个人做心情预报?如此一来,我们或许能帮助很多人避免一些焦虑、抑郁情绪,甚至是抑郁症。目前抑郁症治疗的主要障碍是诊断:不少患者从来没有去医院看过医生,绝大多数人只在情况变得严重时才看医生。很多人直到被家人、朋友拽去医院神经科才意识到自己出现了问题。

如果我们能通过机器学习技术分析数据,提供早期预警呢?如果我们能通过及早发现、采取措施,预防 80% 的抑郁症呢?

得到预警之后,人们可以及时处理导致其抑郁状态的导火索,避免病情恶化;然后通过一系列社交、运动、睡眠、饮食、焦虑来改善生理、精神状态。这是我的研究小组正着手挑战的难题之一,这会是一个长期的研究课题。