云豆

贴心提醒,本文阅读时间4分钟

之前的几篇爬虫基础知识系列内容,已经记录了一些简单的爬虫知识。这些只是处理一些简单问题自然不在话下,但是涉及到一些复杂的问题就比较麻烦。

要想批量下载大量的内容,比如知乎的所有的问答,总会力不从心。

这时候,就需要爬虫框架Scrapy出场了!

Scrapy = Scrach+Python,Scrach这个单词是抓取的意思,暂且可以叫它:小抓抓吧。

你可以前往小抓抓的官网了解它的全部信息:doc.scrapy.org/en/latest/。

那么下面我们来简单的演示一下小抓抓Scrapy的安装流程,官网有更详细的步骤,建议有一定英语水平的读者可以阅读一下详细文档。

友情提醒:一定要按照Python的版本下载,要不然安装的时候会提醒找不到Python。

1.安装Python

安装完了记得配置环境,将python目录和python目录下的Scripts目录添加到系统环境变量的Path里。

在cmd中输入python如果出现版本信息说明配置完毕。

2.安装lxml

lxml是一种使用 Python 编写的库,可以迅速、灵活地处理 XML。

切记要选择相对应的版本。

3.安装setuptools

主要是用来安装egg文件。

4.安装zope.interface

可以使用第三步下载的setuptools来安装egg文件,现在也有exe版本,可自行习啊在。

5.安装Twisted

Twisted是用Python实现的基于事件驱动的网络引擎框架。

6.安装pyOpenSSL

pyOpenSSL是Python的OpenSSL接口。

7.安装win32py

用以提供win32api。

8.安装Scrapy

终于到了激动人心的时候了!安装了那么多小部件之后终于轮到主角登场。

直接在cmd中输入easy_install scrapy回车即可。

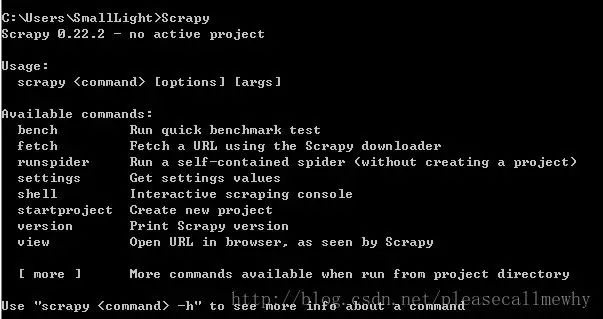

9.检查安装

打开一个cmd窗口,在任意位置执行scrapy命令,得到下列页面,表示环境配置成功。

10.预告

下一篇会更新我们本系列的最后一篇文章,届时我们会教大家如何使用爬虫框架Scrapy进行实战。

今日值班老师

马哥教育二号女神老师,爱水果,爱生活。

擅长帮助Linux小白,据说喜欢在小白学习遇到问题的时候突然出现。

如果你觉得Linux很难学,为什么不找她咨询一下秘诀?

Linux面授班,报名优惠400元,只有10个名额