人工智能(Artificial Intelligence),英文简称AI。维基百科是这样定义的:“智能主体的研究和设计,智能主体是指一个可以观察周遭环境并做出行动以达到目标的系统。”但目前来说并没有一个统一的定义能准确描述什么是人工智能。而科学家对此也存在分歧,不同的定义指向不同的研究方向。

有人工智能领域的科学家向鲸媒体讲述了人工智能技术的发展简史:在人工智能发展史上,有传统人工智能方法、经典机器学习与深度网络学习这几种技术路线。

追溯到1999年,那时一部分科学家认为可以用简单的人工神经网络来模拟人脑,只要模拟的数量足够多,达到人脑神经元数量,就可以实现泛化的人工智能,这部分科学家属于传统人工神经网络学派。另外有一部分科学家认为,就算机器达到了人脑的神经数量也实现不了像人一样智能,他们推崇的是经典机器学习路线。在2000年的时候,人们认识到机器可以模拟人脑细胞,却无法训练出合理搭配的神经元,更谈不上训练完之后能拥有智能。通过神经网络实现泛化人工智能被认为是无法实现的,浅层机器学习派便在这两个对抗的学派中占了上风。

2009年至2012年间,“人工智能三驾马车”(杰弗里·辛顿(Geoffrey Hinton)、延恩·勒昆(Yann LeCun)和约书亚·本吉奥(Joshua Bengio))分别在世界顶级期刊《nature》上发表了几篇文章,其中有一篇关于深度信任网络的训练方法,提出可以采用某种方式对复杂的深度网络进行训练。传统人工智能的核心是机器按照人定的规则运转,而这篇论文提出,网络在运转过程中,可以自己进行发现,不需要被人规定规则。在科学家看来,这类的突破才是新的生产力,否则只是生产力的代替。由此出现了深度网络学习学派。

那么,目前我们所说的AI是什么?AlphaGo不就是AI吗?这么说没有错,只是并不具体。AlphaGo是人工智能系统,但准确来说是深度学习系统,而深度学习只是人工智能的一个分支。

如果用图形来表示的话,人工智能在这三者中范围最大,它可以被看做最外侧的大圆,最核心的是深度学习,中层的是机器学习。深度学习是机器学习的子集,机器学习又被包含于最广泛意义的人工智能中。

范围最大的人工智能,其实还可以划分为强人工智能与普通人工智能两部分。我们运用人类对事物认识的深度来说明他们的区别:现在人类掌握的特征有三类:第一类是所谓的表象特征,即人类看到或者听到的事物,图像、形状、声纹等;第二类是联系特征,与语义特征有关。比如汉字“我”和“们”,可以组成有意义的词语“我们”,这两个字的连接性很大。而“我”与另外一个汉字比如“一”,这两个字的连接性就很小;第三类是科学特征,比如宇宙万物运行的规律可以总结成公式。人类掌握的前两类特征,表象特征及联系特征都属于普通人工智能,而科学特征属于强人工智能。如果机器能够掌握科学特征进行深度学习,那意味着机器可以代替数学家工作,可以创造科学奴役人类。当机器可以自动感知科学,甚至创造科学的时候,它已经迈过红线进入了强人工智能领域。

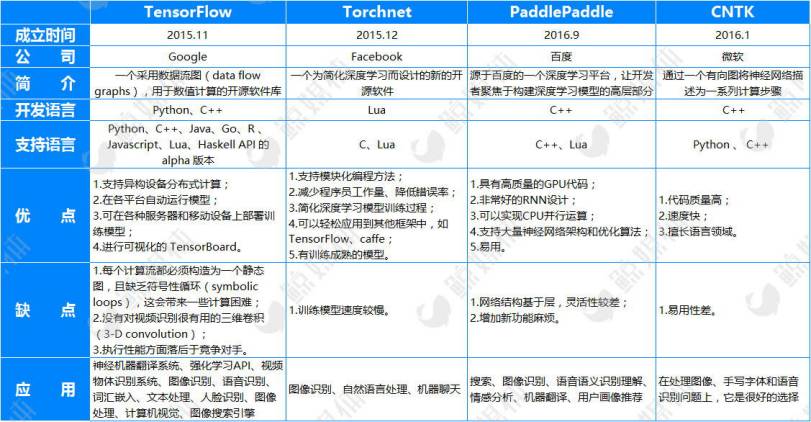

目前来说,我们听到最多的人工智能其实是深度学习,深度学习因其框架的开源、计算能力的大幅提高,而得到突破性发展。公司可以在各种开源框架的基础上搭建特定环境的解决方案。接下来,我们先来了解下目前比较流行的几款开源框架。

一个合适的框架可以减少程序员的工作量、降低错误率、提高工作效率,且可以快速培养数据模型等。根据统计数据,Google开发的TensorFlow是目前使用量最大的开源框架,在此基础上,Google已研发出Google翻译、无人驾驶汽车、AlphaGo等产品。而如今,市面上流行的开源框架基本由Google、Facebook、微软、百度等巨头开发而成,可以看出,各巨头已将下个目标瞄准了人工智能,争夺各专家人才,开展研发工作。

那么,他们都在人工智能有哪些布局?我们可以通过三个层面“基础层、技术层和应用层”来了解下。

表格内容参考腾讯研究院发布的报告《中美两国人工智能产业发展全面解读》

基础层的硬件设施给深度学习提供了强大的计算能力(TPU是Google专门为机器学习研发的特制芯片),技术层的框架和算法帮助深度学习得到更好的数据模型,使得最终结果越来越精准。可以看出,中美产业布局还是有一定差异,美国公司全面发展,积极布局整个产业链,同时,国外更注重基础层和技术层的核心领域发展,相对而言,国内更偏重应用层发展。这可能与人工智能在中美两国发展的时间早晚,以及行业人才有关。