来源:arXiv

作者:闻菲

【新智元导读】

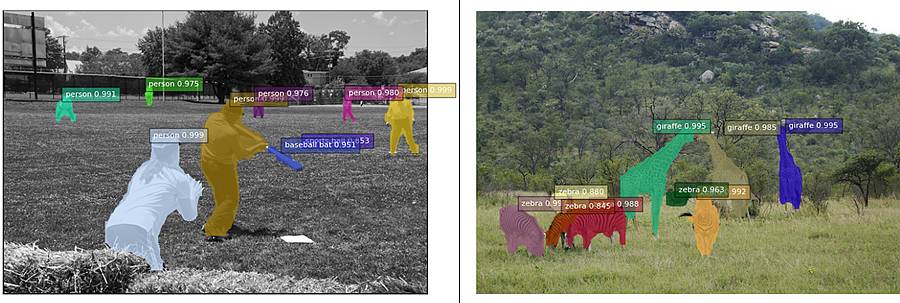

清华大学与微软研究院合作,提出了一种新的架构 FCIS,是首个用于图像实例分割任务的全卷积、端到端的解决方案,该架构在 COCO 2016 图像分割竞赛中获得了第一名。论文现被 CVPR 2017 作为 spotlight paper 接收,代码也已开源:

https://github.com/msracver/FCIS

继图像分类、物体检测之后,精确到像素级别的物体实例分割就成为更具挑战性和实用性的视觉识别任务。前两个任务在近年来取得了迅速的进展,已经有了不少优雅有效的方法。然而,实例分割任务却还缺少一个标杆性的工作。

为此,来自清华大学和微软研究院的李益、齐浩之、代季峰、季向阳、危夷晨合作,利用全卷积神经网络(FCN)在图像语义分割和实例分割预测方面的优势,提出了一种新的架构 FCIS。

FCIS 是首个全卷积、端到端的实例分割解决方案,为实例分割提供了一个简单、快速、准确的框架

,由于考虑到实例分割预测和分类这两个步骤之间的关联,FCIS 能够同时对多个物体实例进行检测和分割。

FCIS 在 COCO 2016 分割竞赛中以显著优势获得了第一名。日前,他们的研究论文《全卷积实例语义分割》(Fully Convolutional Instance-aware Semantic Segmentation)被 CVPR 2017 作为亮点论文接收,作者将论文上传到 arXiv,也将代码在 Github 开源。

现有的主流实例分割方法,几乎都是在常用的物体检测方法的基础上进行简单直接的扩展,对于问题的理解还不够深入,计算效率和精确度都还有很大的提升空间。

例如,对于兴趣区域(Region of Interests, RoI)的分类和分割作为单独的两个步骤进行,没有充分利用这两个任务的关联性;对于分割子网络的训练没有考虑物体类别的差异;对于每个 RoI 运行一个分割子网络导致计算效率低下;RoI Pooling 应该用更精确的对齐方式……

“我们之前在 NIPS 2016 发表的做物体检测的工作 R-FCN,其两个主要思想,一是基于高效的全卷积网络,二是利用位置敏感的 RoI Pooling 打破平移不变性,也都适合用来做实例分割,于是就沿着这个思路做下来了,希望能解决上述问题。”微软研究人员介绍说。

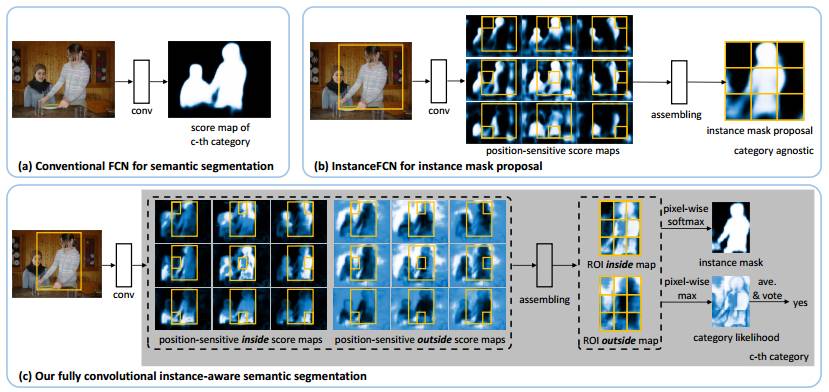

提出 FCIS 的思路示意图

。(a) 用于语义分割的全卷积网络(FCN)。每一类都有单独的一张 score map,这张图不会区分单个的物体实例。

(b) 用于实例分割预测的 InstanceFCN,一个大小为 3×3 位置敏感的 score map 会将相关的位置信息编码。InstanceFCN 产生一系列的分割候选,后续有一个网络会对这些分割候选做分类判别。

(c) 新提出的全卷积实例语义分割方法(FCIS),其中位置敏感的内/外 score maps 会在同一时间对多张连在一起的图像进行分割和检测。来源:Yi Li

et al.

Fully Convolutional Instance-aware Semantic Segmentation

提出 FCIS 的思路示意图

。(a) 用于语义分割的全卷积网络(FCN)。每一类都有单独的一张 score map,这张图不会区分单个的物体实例。

(b) 用于实例分割预测的 InstanceFCN,一个大小为 3×3 位置敏感的 score map 会将相关的位置信息编码。InstanceFCN 产生一系列的分割候选,后续有一个网络会对这些分割候选做分类判别。

(c) 新提出的全卷积实例语义分割方法(FCIS),其中位置敏感的内/外 score maps 会在同一时间对多张连在一起的图像进行分割和检测。来源:Yi Li

et al.

Fully Convolutional Instance-aware Semantic Segmentation

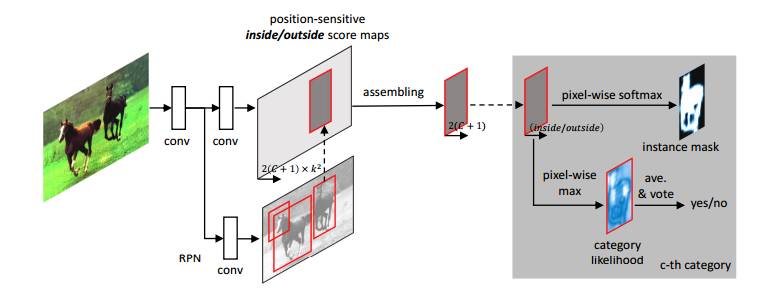

FCIS 整体架构

。一个区域预测网络(RPN)与 FCIS 共享卷积层。RPN 产生的兴趣区域(RoI)会作用在 score maps 上,同时产生分类和分割预测。权重可学的层都是卷积层,并且在整张图像上进行计算。每个 RoI 所产生的额外计算成本可以忽略不计。来源:Yi Li

et al.

Fully Convolutional Instance-aware Semantic Segmentation

据微软研究人员介绍,刚开始尝试时,他们先是简单将 R-FCN 用于做物体分类的 score maps 扩充为共享基础卷积网络的两路 score maps,各自解决 RoI 分类和分割的问题,网络结构类似于一个简单的多任务网络,相对于 R-FCN,增加的参数和计算量都很少。

不过,当他们将新架构和 MS COCO 物体分割比赛 2015 年冠军方法 MNC(也是他们的工作)比较时,发现在 VOC 数据集上 FCIS 相较于 MNC 的精度优势不够大,虽然速度和内存的优势明显。

但是,在 COCO 数据集上测试后,精度的差距又明显拉开了。作者分析认为,他们的方法对于更加困难的小物体,多类别的 COCO 数据集作用更明显。并且,COCO 的性能评价指标对于物体定位和分割的精度要求更高,更能反应出新方法高精度的优势。

经过进一步思考,研究人员认为应该充分利用分类和分割两个任务的相关性。他们发现通过一个简单的重新参数化,可以将原本不相关的两路 score maps 变得密切相关,使它们可以被同时用来解决两个任务。

这样做的好处是它们各自的训练会同时受到两路监督信号的影响,相当于更充分利用了训练数据,而没有增加任何模型的复杂度和计算代价,实验结果也更上了一层楼的。

“这也是我们最后论文里的基于全卷积网络的方法,简单高效,解决了前面提到的所有问题,最终获得了 MS COCO 比赛 2016 年的冠军。”论文第一作者李益告诉新智元。