在刚刚过去的 NIPS 2016 会议上,剑桥大学信息工程学教授 Zoubin Ghahramani 为我们讲述了贝叶斯神经网络的发展历程。本文从研究背景和问题应用切入,介绍了贝叶斯神经网络的起源、黄金时期以及后来的复兴,并介绍了每个发展阶段的几篇关键研究,是一份简明扼要的学习资料,能够帮你快速深入理解贝叶斯神经网络。

P4:上世纪八十年代的研究背景

P5-P7:神经网络与深度学习简介

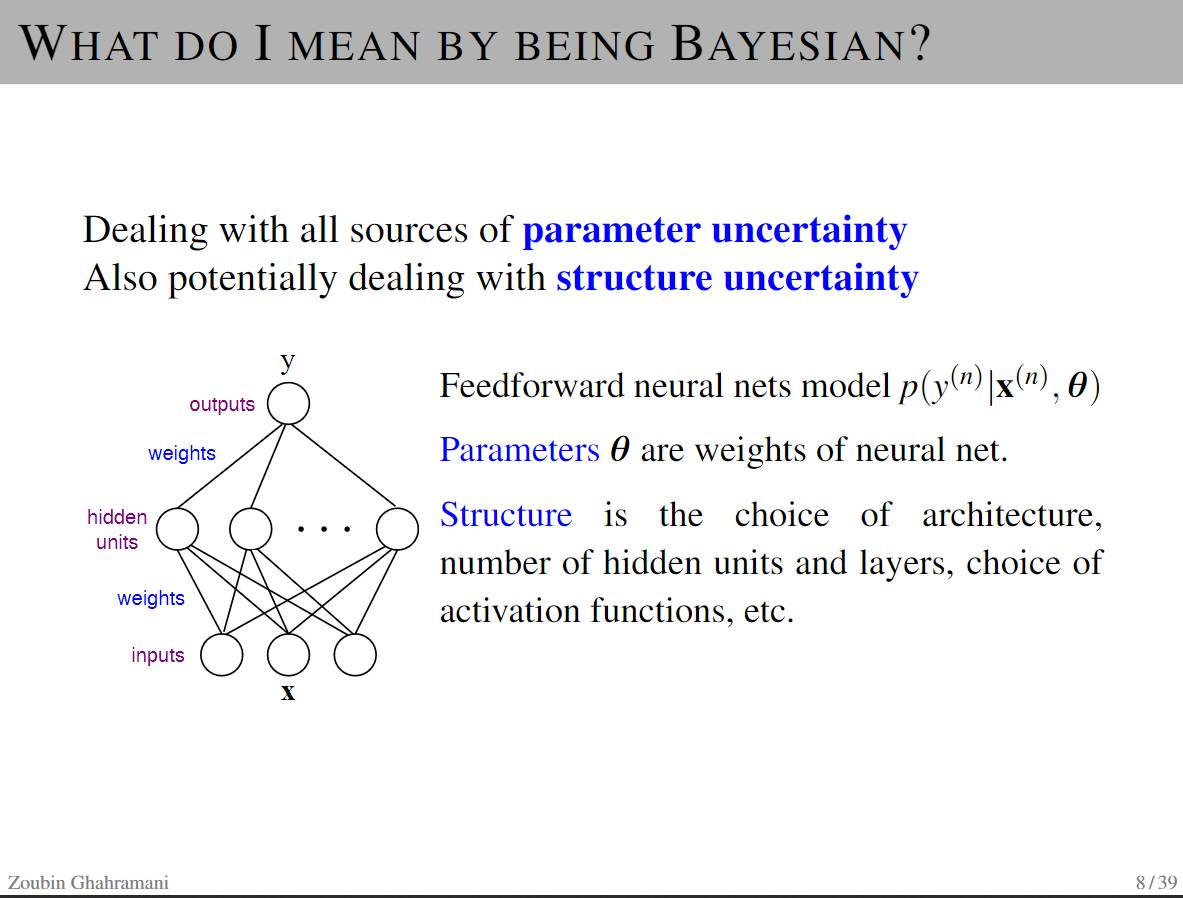

P8 -12:贝叶斯在这里有什么帮助

-

处理参数不确定性的所有来源

-

具备处理结构不确定性的能力

-

贝叶斯定理告诉我们要从数据(可衡量的量)当中做一些关于假设(不确定的量)的推理。

-

学习和预测都可以看作是推理的形式。

-

校正模型与预测不确定性:让系统知道它们何时不知道。

-

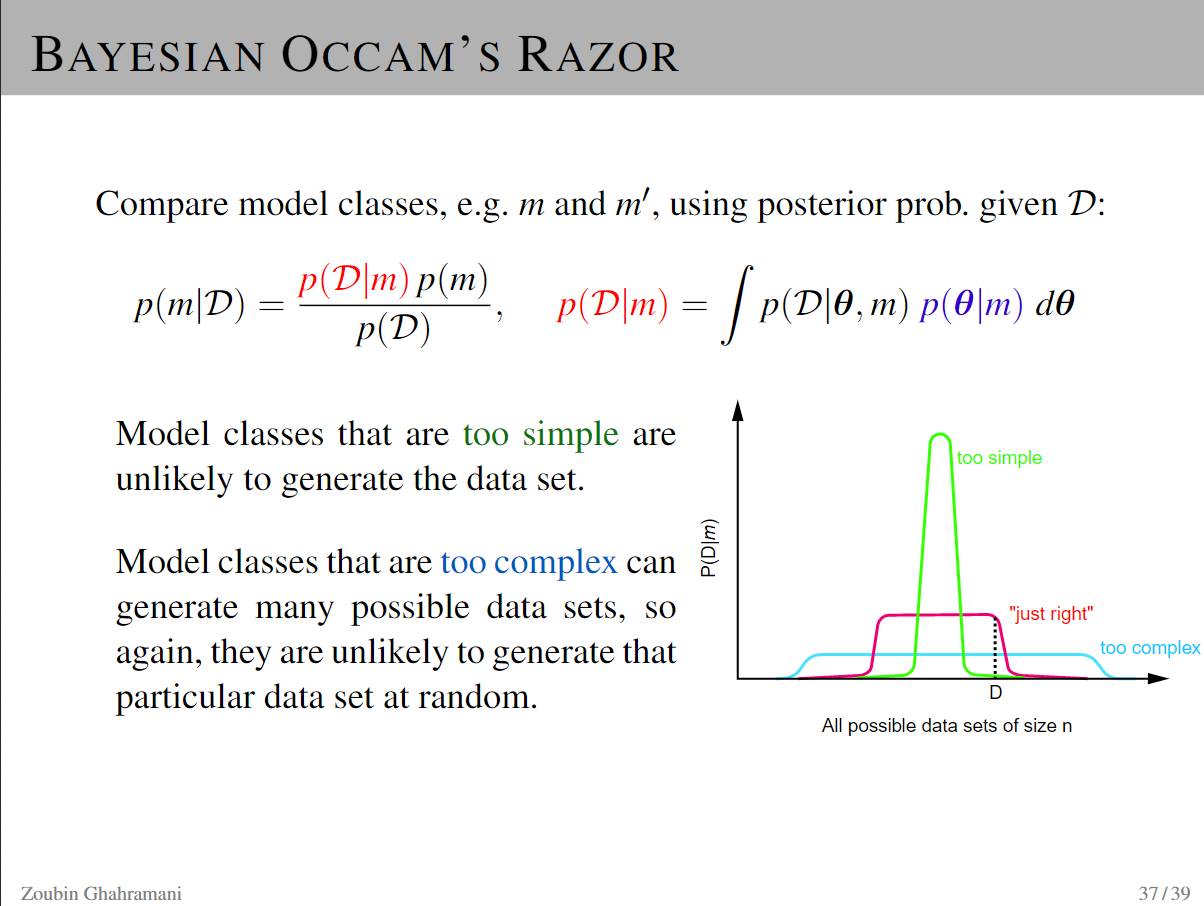

自动模型复杂性控制与结构学习((Bayesian Occam's Razor))

-

要清楚的一点是「贝叶斯」属于算法范畴,不是模型类。任何定义好的模型都可以用贝叶斯方法.

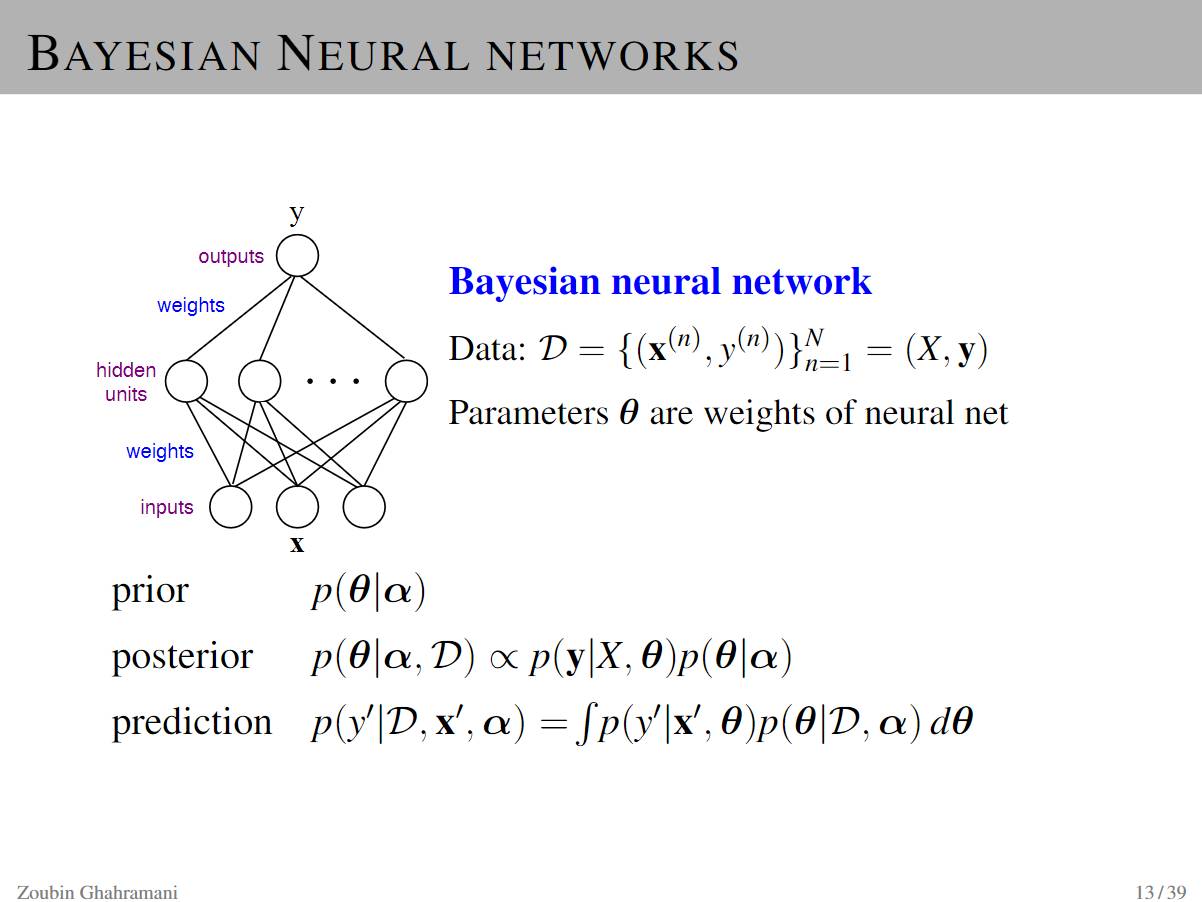

P13:贝叶斯神经网络

P14-16:贝叶斯神经网络的早期历史

贝叶斯神经网络的早期历史可以从以下几篇论文中了解:

-

John Denker, Daniel Schwartz, Ben Wittner, Sara Solla, RichardHoward, Lawrence Jackel, and John Hopfield. Large automaticlearning, rule extraction, and generalization. Complex Systems,1(5):877-922, 1987.

-

Nafitali Tishby,Esther Levin,and Sara A Solla. Consistent inference of probabilities in layered networks: Prediction and generalization. In IJCNN,1989.

-

......

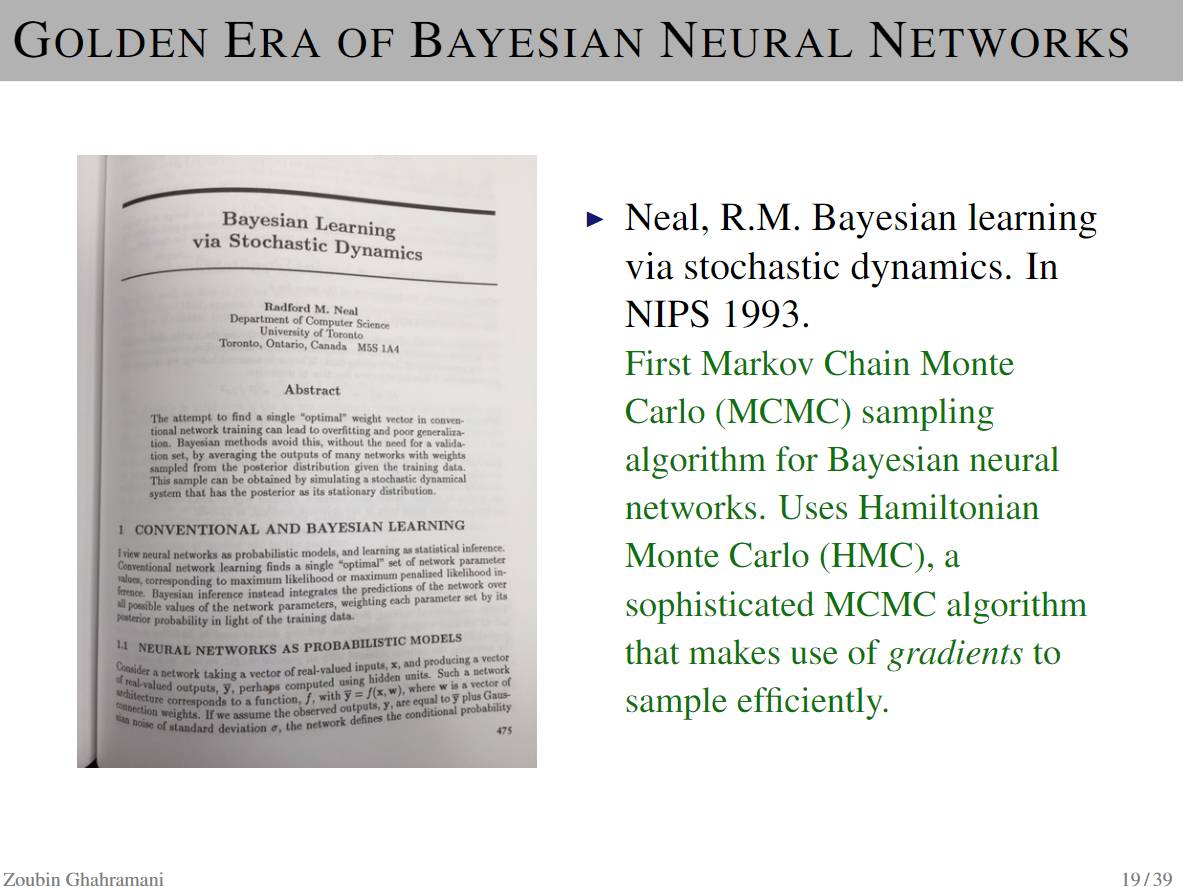

P17- 20 贝叶斯神经网络的黄金时期

-

David JC Mackay 发表在神经计算(Neural Computation)上的一篇文章:A Pratical Bayesian Framework For Backpropagation Networks 揭开了这一时期的序幕。

-

Neal, R.M. 1995 年在多伦多大学的博士论文:Bayesian learning for neural networks. 这篇论文也奠定了贝叶斯神经网络 (BNN) 和高斯过程(Gaussian processes)以及自动相关决策机制(automatic relevance determination ,ARD)之间的关系。

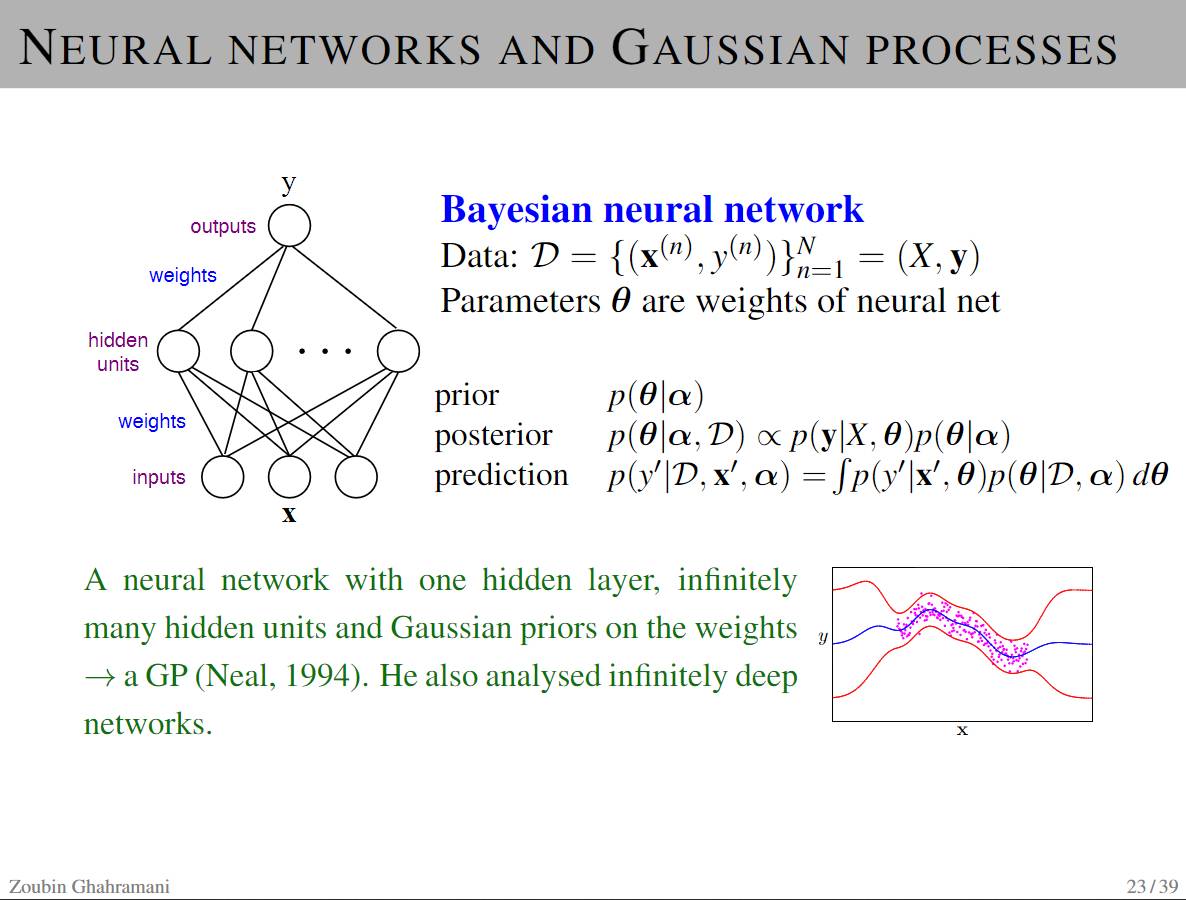

P21-24 高斯过程与贝叶斯神经网络

-

高斯过程可被用于回归、分类、排名等。

-

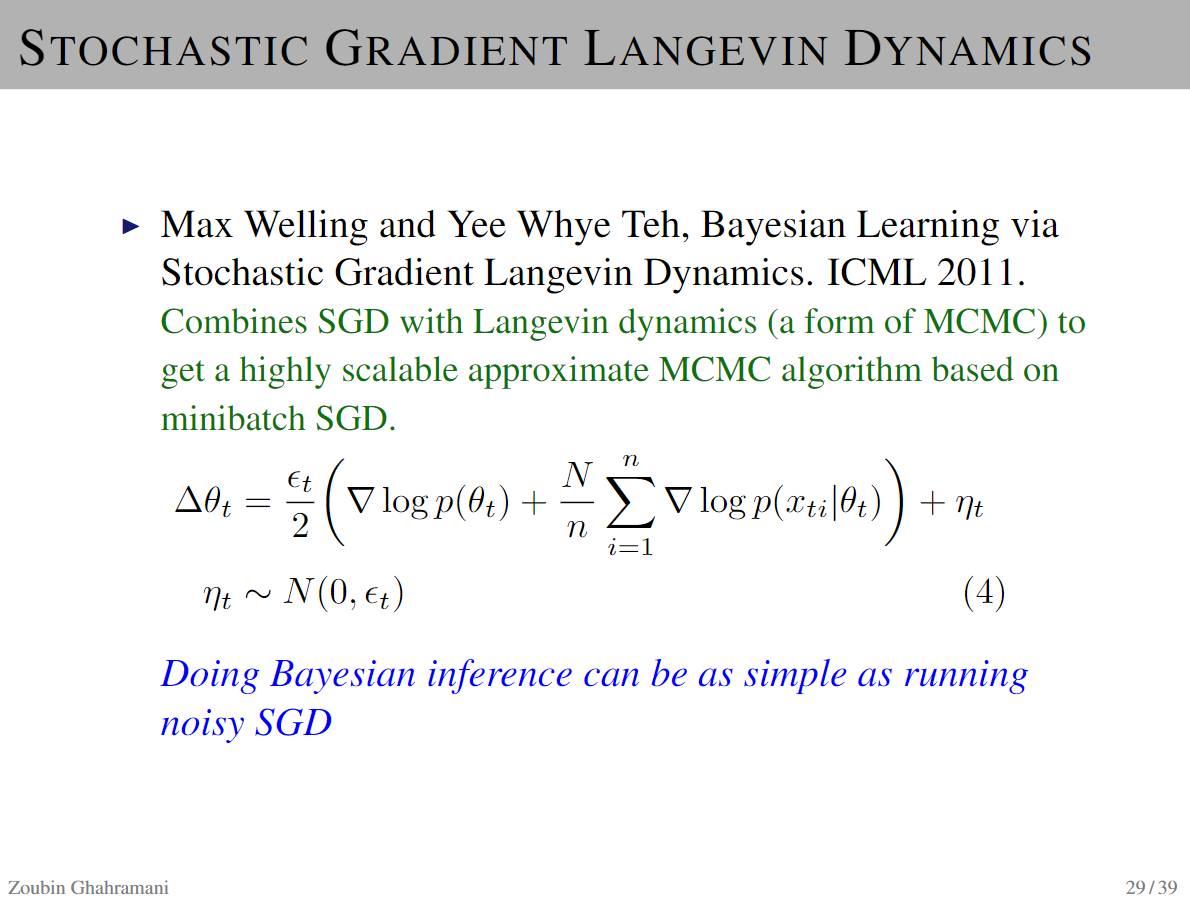

将郎格文动力学(Langevin dynamics,一种 MCMC 的形式)与随机梯度下降(SGD)结合起来得到一个基于 minibatch SGD 的高度可扩展的近似 MCMC 算法。

-

这样一来,贝叶斯推断就能像运行嘈杂的 SGD 那样简单。

-

一个带有一层隐藏层和无数隐藏单元的神经网络和权重高斯先验

-

MacKay 和 Neal 的贡献将特征与架构选择与高斯过程联系起来

P25- 28 贝叶斯神经网络中的变分学习(variational learning)

P29 随机梯度朗格文动力学(Langevin Dynamics)

P30:贝叶斯神经网络的复兴

P31-32 概率方法什么时候变得非常重要?

P33 结论

概率模型为建立能从数据中学习的系统提供了通用框架

贝叶斯神经网络有很长的历史并且正在经历着复兴的浪潮

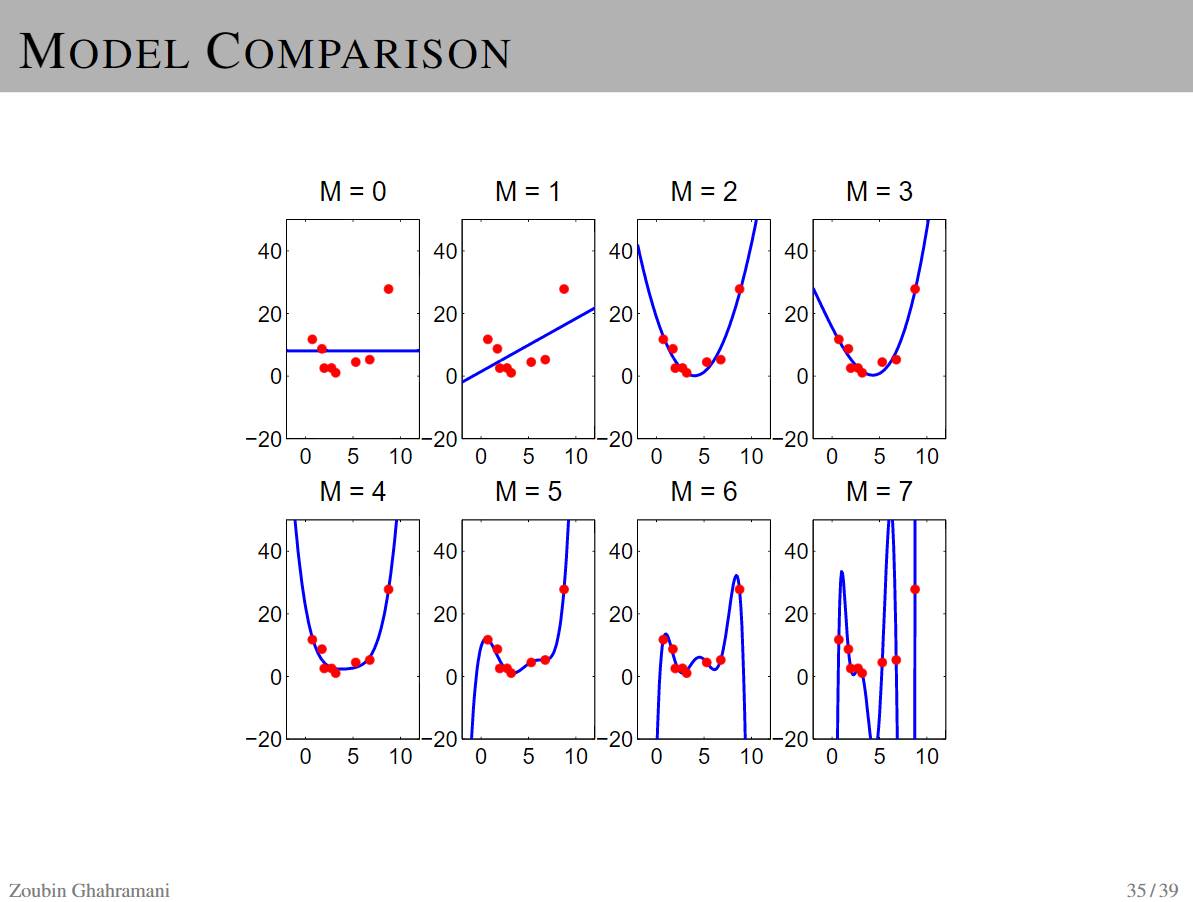

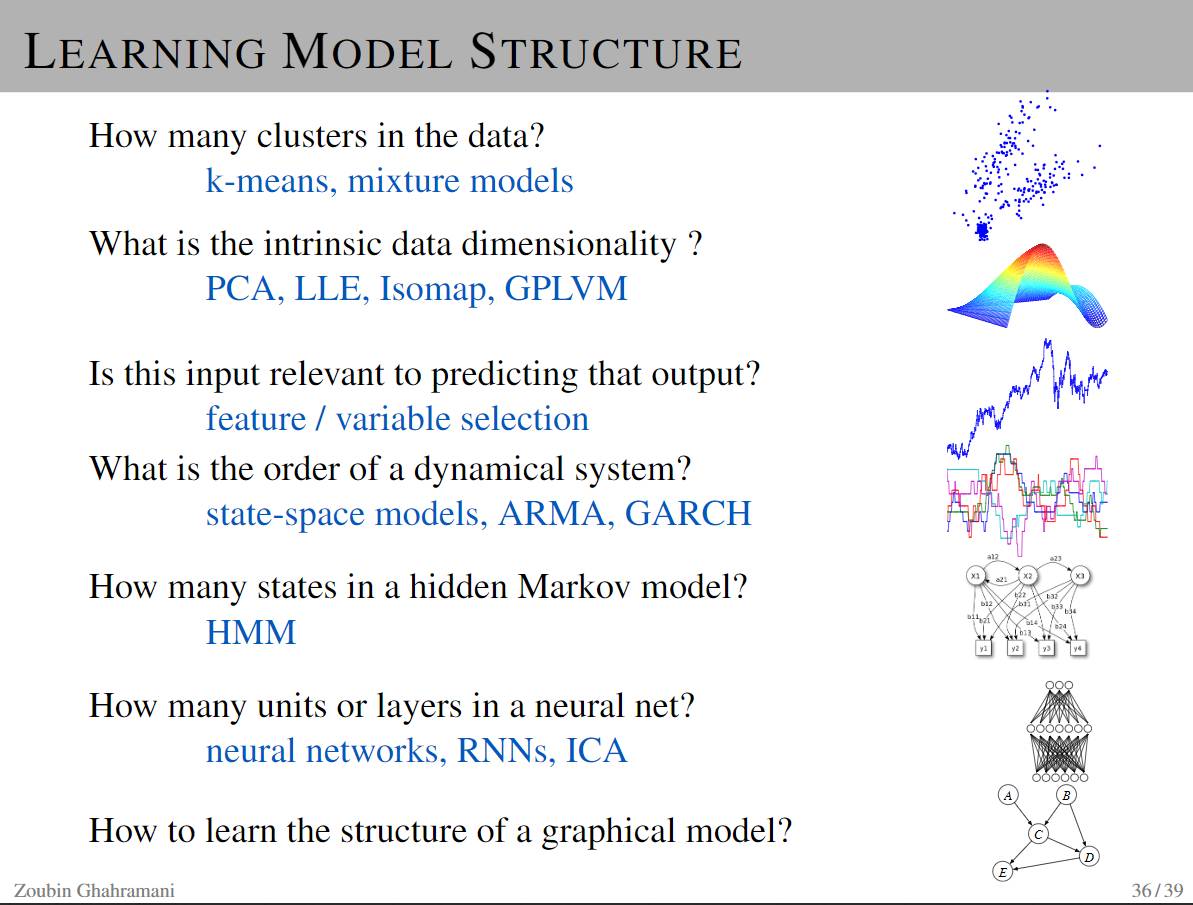

P35-36 模型比较及学习模型结构

P37-39 贝叶斯奥卡姆剃刀(Bayesian Occam's Razor)