我 相 信 这 么 优秀 的 你

我 相 信 这 么 优秀 的 你

已 经

置 顶

了 我

翻译|崔嵐

选文|小象

转载请联系后台

◇

◆

◇

◆

◇

人工智能是怎样变成种族主义者的?

简单:它在模仿我们。

打开你手机上的照片app并搜索“狗”,你手机上所有狗的照片都会出现。这很厉害。你的手机知道狗长什么样子。

这就是机器学习的结果。这些是梳理数百万条数据并且对世界进行相关性和预测的程序。这些程序的吸引力是巨大的:这些机器可以使用冷硬数据来做出有时比人类更准确的决策。

但要知道:机器学习有阴暗的一面。“很多人认为机器学习没有偏见,”普林斯顿的计算机科学家Aylin Caliskan说。“但是机器接受人类数据的训练。而人类是有偏见的”

机器以与孩子相似的方式,学习种族主义,性别歧视和偏见,Caliskan解释:从它们的

造物主

这里。

◇

◆

◇

◆

◇

我们认为人工智能是公正的

其实不然

几乎所有新的消费技术都以某种方式使用机器学习。比如谷歌翻译:没有人指示软件学习如何将希腊语翻译成法语,然后翻译成英语。它梳理无数的文字,自己学习。其它情况下,机器学习软件预测哪个简历更容易帮求职者取得成功,或者病人对特定药物会有什么临床反应。

机器学习是一个筛选数十亿个数据点来解决问题程序(比如“你可以识别照片中的动物么”),但是它并非总是清楚它解

决了的问题。而且很显然这些程序将会自主演变出

偏见和成见

。

去年去年五月,ProPublica发表

了一份关于法院用来预测那些有案底的人中谁有可能再次犯罪的一个机器学习程序的调查。记者发现该软件认为黑种人比白种人的风险更高。

“这种称为风险评估的打分—在全国各地的法院越来越常见,” ProPublica解释道

。“它们被用来在刑事司法制度的每一个阶段通知谁可以被释放的决定,从保释金金额到被告人的自由权。”

软件从现实世界的监禁数据了解谁有可能在监狱度过余生,从历史上看,现实世界的刑事司法制度对美国黑人是不公平的。

ProPublica wrote.这个故事揭示了机器学习的一个深刻讽刺。这些系统的吸引力是它们可以不受人类偏见的影响从而做出公正的决定。“如果机器可以准确预测哪些被告可能再次犯罪,司法系统的监禁决定和监禁期限将可以更加公正和有选择性, ”ProPublica写到.

但事实是机器学习很多大程度上延续了我们的偏见。因此不是法官而是一个机器人在歧视非裔美国人。

像ProPublica调查这样的机器学习的故事,吸引Caliskan来研究这个问题。曾经是大学班级里面唯的一名女生,作为一名女性机器科学家她对这个问题很敏感。

Caliskan发现偏见润物细无声地潜入机器学习中-比如谷歌翻译。

她的母语之一土耳其语中没有性别代词。但是当她使用谷歌翻译翻译土耳其语短语时,它“总是以性别语言翻译成‘他是一名博士’。”土耳其语句子中没有说这名博士是男性还是女性。计算机就是假定你谈论一名博士时该博士是个男的。

◇

◆

◇

◆

◇

机器人如何学习隐形偏见

最近Caliskan 和她的同事在Science发表了

一篇论文,揭示机器在自己学习英语时变得对黑人和女人有偏见。

总的说来他们让一个常见的机器学习程序到互联网上爬取数据,查看8400亿个单词,并且自己学习这些单词的定义。程序通过查看在一个句子中某些单词出现的频率达到目的。比如“瓶子”。计算机通过注意到它经常和单词“容器”一起出现,也经常和“水”和“牛奶”等含有液体意思的单词一起出现,开始明白这个单词的含义。

这种教机器人学习英语的想法实际上来自认知科学,以及对儿童学习语言的理解。两个单词一起出现的频率是我们破译得以它们含义的第一个线索。

计算机累积了词汇量后,Caliskan对它进行了一次内隐联结测验。

人类社会中,内隐联结测验用来通过人类需要多久时间联想单词揭示大脑中细微偏见。一个人可能很快的将单词“男性”和“工程师”联系在一起。但是如果一个人滞后将单词“女性”和“工程师”联系在一起,这表明在思想中这两个术语不是紧紧联系在一起,暗示着偏见。(存在着一些关于人类内隐联结测验的可靠性的问题

。)

在这里,不是滞后时间,Caliskan观察的是,计算机认为两个术语的联系有多紧密。项目中她发现,比起白人的名字,非裔美国人的名字和单词“愉快”的关联更少。并且女性名字比男性名字与家庭相关的单词更加关联。(的确,内隐联结测验可能更加适合于计算机程序而不是人类,因为人类的答案前后不一致但是计算机每次都回答相同的答案。)

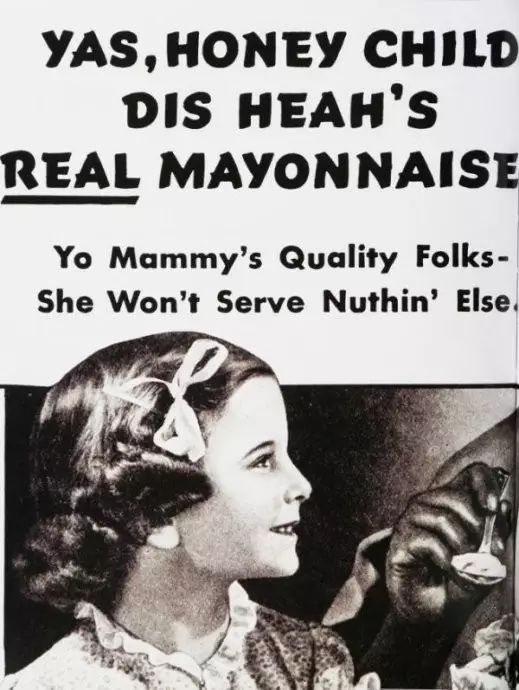

和孩子一样,计算机通过观察术语同时出现的频率来构建自己的词汇库。互联网上,非裔美国人的名字经常被和不快乐相关的词汇包围。不是因为非裔美国人不快乐。是因为人们在互联网上说可怕的事情。这给我们年轻的人工智能留下了这种印象。

如你所想,这是一个问题。

◇

◆

◇

◆

◇

人工智能“学会”了种族主义性别歧视的后果

越来越普遍,Caliskan说,招聘人员依赖机器学习程序对求职简历进行第一轮筛选。如果不加控制,程序在决策中采取性别定型观念。

“比如说,一个男人在申请一个护士职位他可能被认为不适合那个职位,如果机器自己决定的话,”她说。“当一个女性申请软件开发人员或者编程职位时这种情况也可能发生。”几乎所有这些软件都不是开源的,因此我们不能看到正在发生的事情。因此我们有责任来发现他们是否不公平或者有偏见。

这将是未来的挑战。人工智能已经进入到医疗保健系统,帮助医生为病人找到正确的治疗方法。 (这是早期关于它是否可以帮助预测精神健康危机

的研究。)

但是健康数据也充满了历史偏见。众所周知女性比男性更少获得手术治疗

。(一个主要原因是,作为主要护理人员的妇女在手术后有较少的人照顾她们。)

人工智能会很少建议女性患者手术么?这是值得注意的事情。

◇

◆

◇

◆

◇

那么这些程序就没有用了么?

不可避免的,机器学习程序会遇到反应种族歧视和性别偏见的历史模式。而且很难在什么是偏见和什么是事实之间画一条线。

机器学习软件将会熟悉大多数护士历来是女性。它们会意识到大多数计算机程序员是男性。“我们不建议你们删除这些信息,” Caliskan说。这可能会完全破坏软件。

Caliskan认为需要有更多的保障措施。使用这些软件的人需要不断地问,“我为什么得到了这些结果?”并且查看这些结果是否有偏差。他们需要认真思考他们正在梳理的数据是否反映了历史偏见。Caliskan承认人工智能如何对抗偏见的最佳实践仍在制定中。“这需要计算机科学家,伦理学家,社会学家和心理学家的长期的研究议程,”她说。

但至少,那些使用这些软件的人们需要意识到这些问题,并不要想当然的认为计算机可以比人类产生更少偏差的结果。

总的来说,重要的是要记住:人工智能学习过去的世界,它熟悉现状趋势,它不知道世界应该如何。这需要人类来决定。

王海伦

IT从业者,对大数据云计算人工智能等前沿技术非常感兴趣。