11月5日,腾讯混元大模型家族正式发布了两款新模型,分别是混合专家(MoE)模型 Hunyuan-Large(Hunyuan-MoE-A52B),及 3D 生成模型 Hunyuan3D-1.0,支持企业及开发者精调、部署等不同场景的使用需求,两款模型现均已在 Gitee 正式开源。

💡Hunyuan-Large Gitee 仓库地址:https://gitee.com/Tencent/Tencent-Hunyuan-Large

💡Hunyuan3D-1.0 Gitee 仓库地址:https://gitee.com/Tencent/Hunyuan3D-1

Hunyuan-Large

Hunyuan-Large(Hunyuan-MoE-A52B)模型拥有 3890 亿总参数和 520 亿激活参数,上下文长度达256k,是当前业界参数规模最大、效果最好的 Transformer 架构的开源 MoE 模型,更适配开源框架精调和部署。该模型在多轮对话、高质量文本生成、数学逻辑、代码创作等多个场景中表现优异。

MoE 模型(Mixture of Experts Models,混合专家模型)是一种通过多个专家网络来协同处理不同任务的深度学习模型结构。在 MoE 架构中,通常只有一部分专家会在每次计算中被激活,以处理输入数据的特定部分,而其他专家则保持非激活状态,从而实现参数高效利用和计算成本优化。

技术细节

在模型结构和训练策略方面,Hunyuan-Large 探索了 MoE ScalingLaw,进行了MoE共享专家路由、回收路由等策略上的创新,并引入了专家特化的学习率适配训练策略,有效提升不同专家利用率和稳定性,带来模型效果的提升。

随机补偿路由策略

随机补偿路由策略此外,Hunyuan-Large 采用了Grouped-Query Attention(GQA)和Cross-Layer Attention (CLA)两种策略,对KV Cache进行了压缩。Hunyuan-Large模型的head数通过GQA从80压缩到8,并通过CLA每两层共用KV激活值,最终将模型的KV Cache压缩为MHA的5%,大幅提升推理性能。

KV Cache压缩

KV Cache压缩效果评测

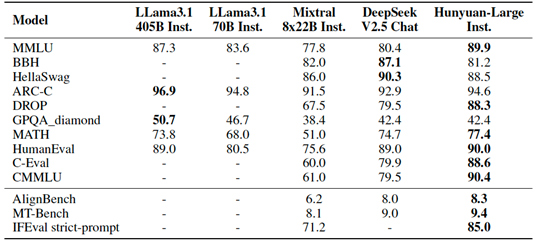

Hunyuan-Large在与业界开源的DeepSeek-V2、Llama3.1-70B、Llama3.1-405B以及Mixtral-8x22B的对比中,在 CMMLU、MMLU、CEval 等多学科综合评测集、中英文 NLP 任务、代码和数学等九大维度处于行业领先水平。

了解更多

点击链接:https://gitee.com/Tencent/Tencent-Hunyuan-Large前往 Hunyuan-Large 仓库,了解更多训练及部署详情。

Hunyuan3D-1.0

为解决现有的3D生成模型在生成速度和泛化能力上存在不足的问题,本次腾讯混元开源的3D生成大模型Hunyuan3D-1.0,可以帮助 3D 创作者和艺术家自动化生产 3D 资产,是业界首个同时支持文字、图像生成3D的开源大模型。

Hunyuan3D-1.0首批开源模型包含轻量版和标准版,轻量版仅需10秒即可生成高质量3D资产,目前已在 Gitee 正式上线,包含模型权重、推理代码、模型算法等完整模型,可供开发者、研究者等各类用户免费使用。

同时,混元大模型团队还上线了两个公开的3D数据集GSO与OmniObject3D,点击链接:https://gitee.com/Tencent/Hunyuan3D-1前往 Hunyuan3D-1.0 仓库,了解更多详情。

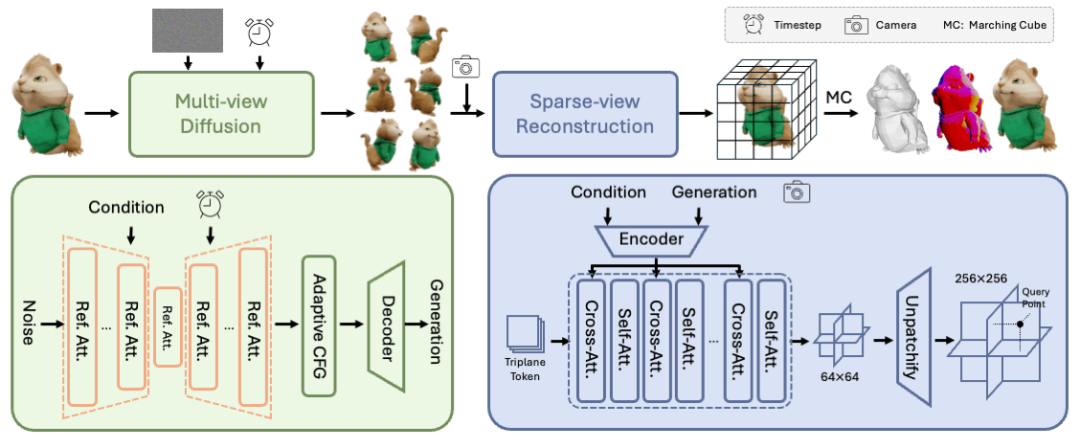

模型能力框架

在生成的第一阶段,Hunyuan3D-1.0采用了一种多视角扩散模型,轻量版模型能够在大约4秒内高效生成多视角图像。这些多视角图像从不同的视角捕捉了3D资产的丰富的纹理和几何先验,将任务从单视角重建松弛到多视角重建。

第二阶段,Hunyuan3D-1.0引入了一种前馈重建模型,利用上一阶段生成的多视角图像。该模型能够在大约3秒内快速而准确地重建3D资产。

重建模型学习处理多视角扩散引入的噪声和不一致性,并利用条件图像中的可用信息高效恢复3D结构。最终,Hunyuan3D-1.0模型实现了输入任意单视角的三维生成。

生成效果展示

文生模型

图生模型

在实际场景的应用中,腾讯地图已经基于腾讯混元3D大模型,发布了自定义3D导航车标功能,支持用户创作个性化的 3D 导航车标,相比传统的3D车标重建方案,速度提升了91%。此前,腾讯元宝 APP 也上线了「3D 角色梦工厂」玩法,支持个性化的 UGC 3D 人物生成。

未来,腾讯混元也将继续和 Gitee 共同带来更多模态、更多尺寸的开源模型,将更多经过实际业务场景打磨和检验的模型在 Gitee 开源,促进大模型技术进步和行业生态繁荣。