选自Medium

作者:Andrej Karpathy

机器之心编译

参与:李亚洲

开玩笑地说,现在提交论文的主题是不是应该围绕把全卷积编码器解码器BatchNorm ResNet GAN应用于风格迁移,用 Adam 进行优化?

你是否使用过 Google Trends?相当的酷,你在里面输入关键词,看一下谷歌搜索中这一词条如何随时间变化的。我想,过去 5 年中 arxiv-sanity 数据库中刚好有 28303 篇机器学习论文,为什么不做一些类似的工作,看一下过去 5 年机器学习研究有何进化?结果相当的有趣,所以我把它贴了出来。

arXiv 奇点

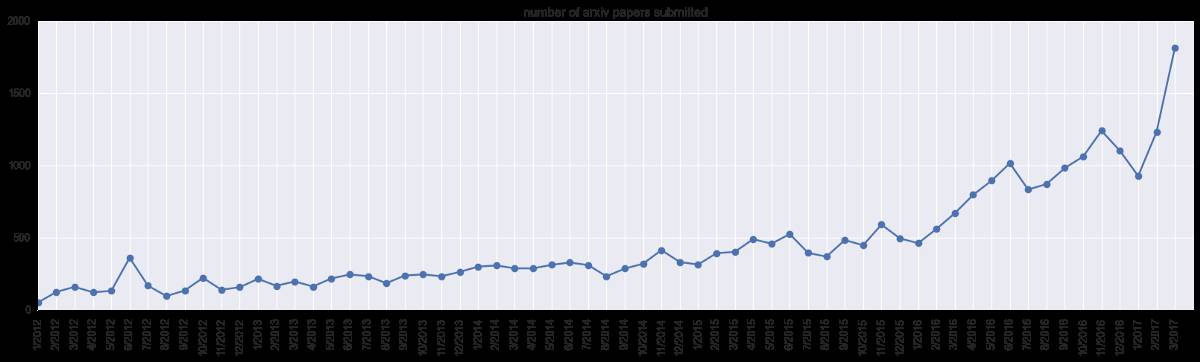

首先,让我们看一下在 arxiv-sanity 类别下(cs.AI、cs.LG、cs.CV、cs.CL、cs.NE、stat.ML)所递交论文的总数。随时间变化,得出以下结果:

是的,2017 年 3 月,该领域有几乎 2000 篇论文被提交。这一峰值可能是由于大会截止日期(例如 NIPS/ICML)。注意,这不是关于该领域自身体量的一个直接说明,因为不是每个人都会把论文提交到 arXiv 上,而且研究人员做研究的分类也会随时间变化。但有一点可以说明,人工智能领域正有大量论文被发现、浏览、阅读。

把论文的总量做为分母,我们现在看一下有多少比例的论文包含确切的关键词。

深度学习框架

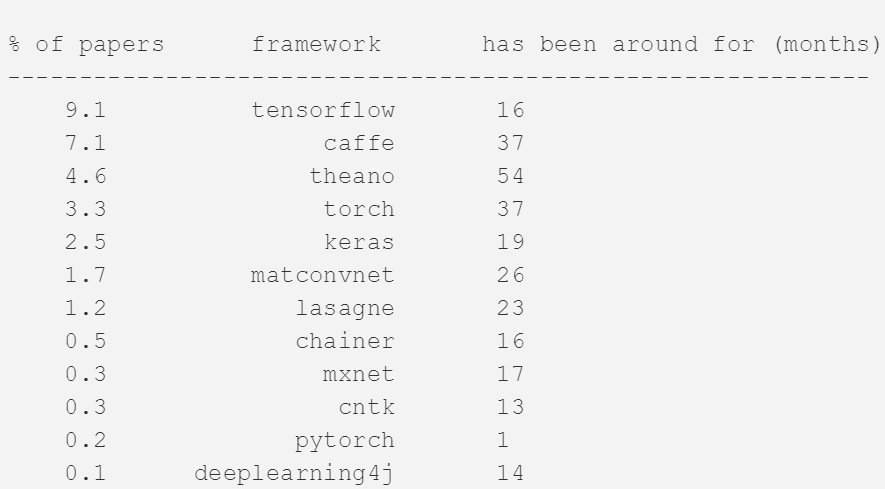

作为热身,我们先看一下深度学习框架。为了计算这个关键词,我们记录了在全部文本中的某处提到框架名的论文以及其比例(任何地方,包括 bibiliography 等)。在 2017 年三月份提交的论文中,我们得出了下面的结果:

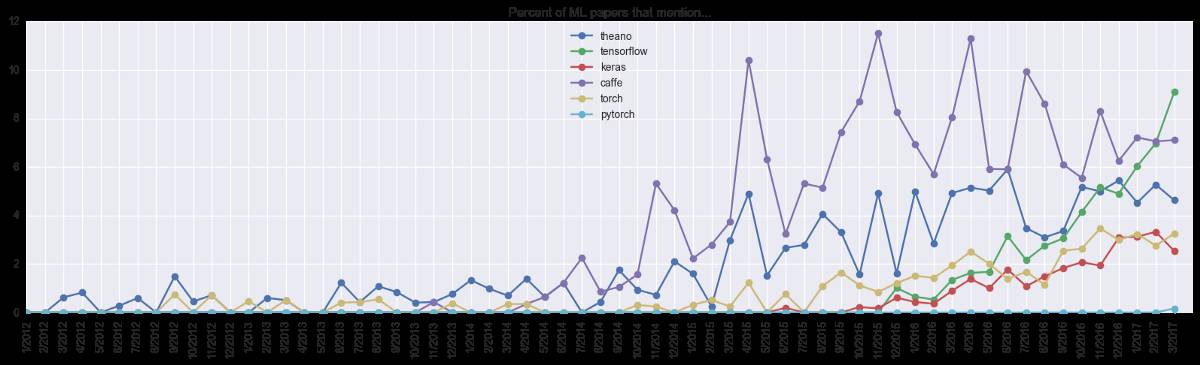

也就是说,2017 年 3 月提交的论文中 10% 提到了 TensorFlow。当然,不是每篇论文都宣布使用了该框架,如果我们假设那些提到框架的论文都有一定概率使用该框架,那看起来社区中有 40% 的人在使用 TensorFlow(或者更多,如果你把带有 TF 后端的 Keras 也算在内)。下面是更多框架随时间变化的图绘:

我们能看到 Theano 已经出现很长时间了,但其增长趋于停滞。Caffe 在 2014 年有急剧的增长,但在过去几个月被 TensorFlow 超越。Torch(以及最近的 PyTorch)也在攀爬阶段,缓慢却稳定。接下来几个月的发展值得注意,我个人的猜测是 Caffe/Theano 将继续缓慢的衰退,TensorFlow 也会因为 PyTorch 出现,增长速度变的更慢。

ConvNet 模型

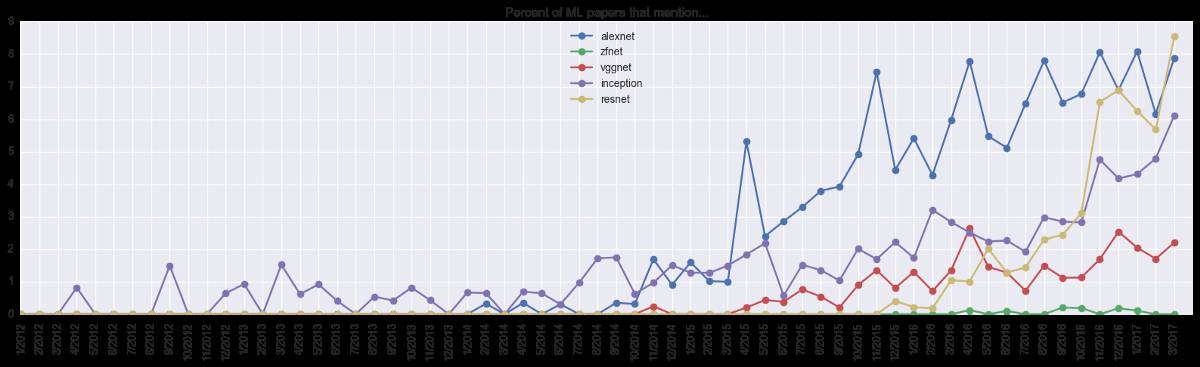

接下来看一下常见的 ConvNet 模型。下图中,我们能清楚的看到 ResNet 的涨幅,直到三月份所有论文的 9% 提到了它。

还有,在 InceptionNet 之前谁在讨论「inception」?对此也很好奇。

优化算法