本文约

6900字,

建议阅读

10分钟。

本文讲述奠定AI基石的神经网络研究的学者们早期科研探索的故事。

[导读]

几位最偏执的人坚持到了春天来临

。经过过去五年的发展,AI

已经从一种玄学概念发展成了科技产业最大的希望之一。计算机已经能够识别人脸和事物、理解人类说出的话,以及翻译多种语言。谷歌母公司

Alphabet,亚马逊,苹果,Facebook 和微软这些全球最大的科技巨头们,都已经很大程度上将自己的未来押在了 AI

上面,他们开启了一轮「谁先打造出更智能的机器」的 AI 竞赛。

巨头们的 AI 竞赛点燃了 AI

技术,几乎是一夜之间特斯拉的自动驾驶汽车已经奔驰在路上,而亚马逊语音助手 Alexa 也正和你的孩子聊天。但 AI

并不是一晚上建成的,也非单个硅谷公司的独立作品。

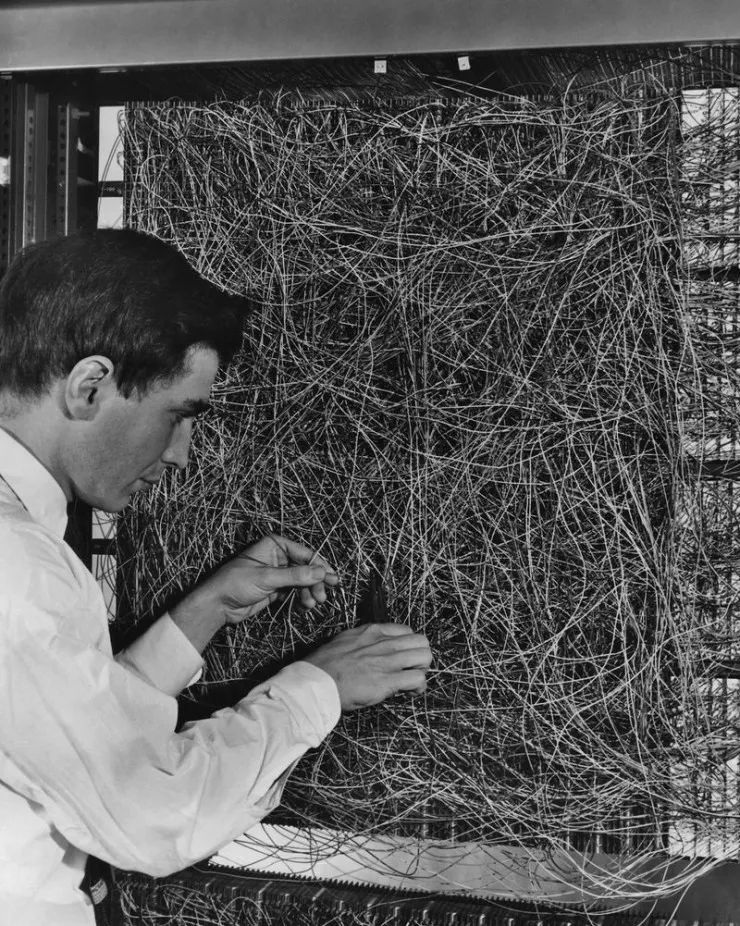

1960 年的水牛城,工作人员正在「精细调节」一台感知机

现代 AI,也就是神经网络和机器学习,背后的历史可以追溯到二战的最后的阶段。那时候,学者们刚刚开始试着打造能像人脑那样存储和处理信息的计算机系统。自此开始的几十年间,这项技术起起伏伏的发展着,但是它直到接近 2012 年才开始广泛的受到计算机科学家的青睐,这多亏了一小撮不惧被当成傻子的固执 AI 研究者的坚持。他们始终坚信神经网络将点亮世界,并改变人类的命运。

这些先驱者们散落在世界各地,不过投身神经网络研究的学者们在加拿大这个地方尤其集中。其实他们能来加拿大很大程度上只是因为运气好:神经网络的研究在当时无论如何都算不上时尚,那时候由政府支持的加拿大高级研究所(CIFAR),通过资助神经网络研究的方式吸引了一小撮专业学者来到加拿大。这其中就包括如多伦多大学的 Geoffrey Hinton 和 Yann LeCun,蒙特利尔大学的 Yoshua Bengio,阿尔伯塔大学的 Richard Sutton 这样一些计算机科学家们,给了他们机会分享自己的研究理念、坚守自己的研究事业。这些固执的计算机科学家们提出了很多加速 AI 发展的概念,到现在,所有这些早期概念都被认为是现代 AI 的基石,这几个人也被认为是 AI 的「教父」。

本文接下来要讲述这样一个有点奇特的故事,该故事取材自 Bloomberg 记者 Ashlee Vance 对他们各自采访的内容,这些内容包括:

-

神经网络为什么花了这么久才发挥作用?

-

热爱神经网络的计算机科学家是如何抱团在一起的?

-

为什么全世界这么多地方里就选择了加拿大?

这一切最终都成为了智能机器崛起的舞台。

AI 的画作,BLOOMBERG BUSINESSWEEK 2018 年 3 月刊

加拿大总理 Justin Trudeau :

广泛意义上来讲,AI 指的是一台计算机能够模拟人类想法或行为的电脑。在这种定义下,就诞生了机器学习的概念,其中你会让计算机反复做一个实验。这种情况可能是模拟一辆自动驾驶汽车在道路上行驶,或者机器尝试认出照片里的一只猫。

在这一理念下,就涉及到了机器学习的一个叫做深度学习的子集方法。深度学习的总体思想是打造一个神经网络,神经网络中的权重和偏倚可以进行调节,直到网络给出理想的输出。深度学习可以让计算机的问题解决能力迭代进化,这也就是 Geoff Hinton 和其他科学家们在过去几十年里真正研究的东西,深度学习也是当前 AI 技术最让人激动的基础所在。深度学习在模仿人脑思考方面的表现也更加出色。

Cade Metz

,纽约时报记者,《A Forthcoming History of AI》一书的作者:神经网络的灵感要追溯到 1940 年代,当时有人提出构建一种能模拟人脑内神经元网络的计算机系统。但是就在不久后的在 1950 年代,一个叫做 Frank Rosenblatt 的人真正地推动了这样研究的发展。Frank Rosenblatt 教授当时也与美国海军以及其他政府部门进行合作研究,基于神经网络的概念他开发出了这种名为「感知机」的东西。当他曝光自己的成果时,纽约时报和纽约客这样的杂志将其放在了最显眼的位置进行了报道。

Rosenblatt 声称这个感知机将不止能做如识别图像这样的小任务,理论上还能教机器行走,说话和做出表情。但是感知机仅仅有一层神经元,这也就意味着它能做的事情极其有限。更不用说,实际上他承诺的该设备的功能一项也没有实现。

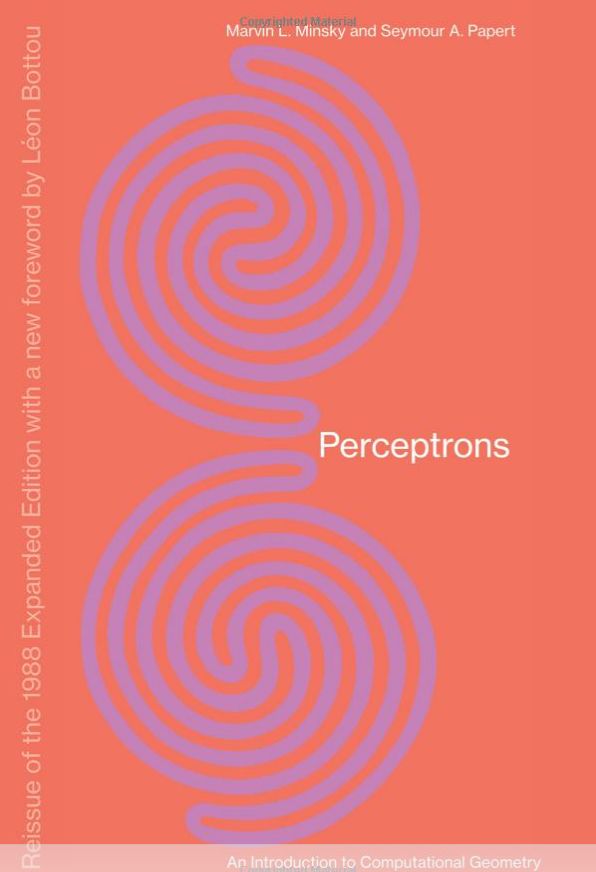

当时,Rosenblatt 的一个同事名叫 Marvin Minsky,Minsky 也碰巧是在 Rosenblatt 在 Bronxt 读高中时的同学,Minsky 在 1960 年代写了一本书,他在书中详细地介绍了 Rosenblatt 开发的感知机和神经网络的局限性。几乎就是因为这本书,神经网络这一领域的研究至少被冰冻了十年之久。

Geoff Hinton:

Rosenblatt 的感知机本来能够实现一些有趣的事情的,但是他超前了大约 50 年。尽管同学 Minsky 也曾经可以算作神经网络的信徒,但他在书中显示出了他们解决不了的东西。这本由 Minsky 和 Seymour Papert 写的书《Perceptrons: An Introduction to Computational Geometry》基本上将这一领域的研究判了死刑。

Metz:

Geoff Hinton,一开始在 CMU,后来在多伦多大学,一直都在坚持着神经网络的想法。他和他的合作者们最终开发出了一种多层的神经网络,也就是深度神经网络,这种网络终于开始在各种不同的任务中大显神威。

法国出生的计算机科学家 Yann LeCun 也在多伦多的 Hinton 实验室里做了一年的博士后。后来 LeCun 去了美国新泽西州的贝尔实验室。

Yann LeCun:

我很小的时候就对智能这一整个概念非常着迷。我长大的时候正是 1960 年代,那时候有太空探索、有最早的计算机和 AI 的出现。所以我开始学习工程学,我对人工智能非常感兴趣,即便这个领域那时候才刚刚萌芽。

1979 年,Yann LeCun(右侧)在 Esiee Paris 大学

我听说了感知机的事情,觉得很好奇,因为我觉得「学习」就是智能的一部分。我就各种途径找到了所有关于感知机的东西来读。作为一个工程师,有一条明摆着的途径就是尝试自己制造一台有智慧的机器,它会促使你关注那些产生智慧需要的组件。这有点像是航空学的先驱们从鸟类身上得到启发,但也同时也不是全盘照抄。我们其实不需要模仿生物智能或者是大脑,因为它的功能的很多方面就只是受制于生物化学或者生物学的基本规律,而不是真的和智慧本身有多大关系。就像羽毛对飞行来说不是必须的,真正重要的是其中隐藏的空气动力学原理。

Metz:

有些人曾认为LeCun是个彻头彻尾的疯子,他所做的研究都是徒劳。当时,如果你参加大型人工智能会议,说自己研究的是神经网络,学术界主流肯定会把你排斥在外。当时神经网络都是些边缘研究。

Yoshua Bengio:

在1985年,神经网络是边缘研究,我在麦吉尔大学学不到这门课程。我学的是经典的符号人工智能。所以我必须说服我的教授指导我研究神经网络。我获得了政府奖学金,所以我可以自行选择研究主题,这对教授来说没有任何损失。我和他达成了一项协议,我可以做机器学习,但我必须把这一研究应用到他所关心的领域——语音识别。

LeCun:

大约在1986年,当时出现了一股神经网络浪潮。物理学家对这些模型产生了兴趣,提出新的数学方法,这使得该领域再次被主流接受,这引领了上世纪 80 年代末和 90 年代初的神经网络浪潮。有些人制造了基于神经网络的系统来做一些实际的事情,比如信用卡诈骗检测。我研究出一个基于符号识别来读取支票的自动化系统。

1995 年,Pomerleau 正在演示他的自动驾驶汽车

Metz:

卡耐基梅隆大学的 Dean Pomerleau 在上世纪 80 年代末基于神经网络制造了一辆自动驾驶汽车,这辆车可以在公共道路上行驶。LeCun 在上世纪 90 年代使用这一技术,建立了一个可以识别手写数字的系统,最终这一系统被银行所使用。

从80年代末到90年代,神经网络再次复兴,出现了一些实际应用,LeCun 的工作就是最好的例子。但之后又到了上限,主要原因是计算能力有限、缺乏可用数据。人工智能的冬天再次袭来。

Jurgen Schmidhuber:

我们肯定没有使用那些加拿大人(注:此处指 Bengio)的算法;他们在使用我们的算法。LeCun 本来是法国人,我们在用他的算法。这很好。他有很多的贡献,这非常重要、非常有用。

我已经与这些研究人员认识很长时间了。我第一次见到 Yoshua 时,他与我的学生发表了同样的研究,或多或少一样,那项研究我的学生在四年前就发表了。几年后,在一次会议上,我们摊牌了,所有的一切都真相大白。研讨会上大家进行了一场公开辩论,很明显是谁先做的研究。这不会令人不悦,只是澄清事实而已。进行科学研究就是澄清事实。(而 Bengio 否认了 Schmidhuber 的说法。)

LeCun:

当时的问题是这些方法需要复杂的软件、大量的数据以及高性能的计算机。没有多少人有机会利用这些资源,也鲜少有人乐意投资。

在上世纪 90 年代中期至 2005 年左右,人们选择了更简单的方法——没有人真正对神经网络感兴趣。对Geoff, Yoshua和我来说,这真是一段黑暗时期,我们并不感到痛苦,但会有点悲伤。我们认为存在明显潜力的研究,大家竟然选择视而不见。

Hinton:

当然,我们一直相信神经网络,并致力于这一研究。但是工程师们发现,在小数据集上,其他的方法与神经网络相比也同样有效或者更加有用,所以他们选择了其他方法,认为神经网络只是我们的一厢情愿。致力于让神经网络更加有效的人在当时相当少。

CIFAR 让世界各地与我们抱有相同想法的人有了更多交流。这时候到了转折点。

LeCun:

正是由于这一小群人坚持认为神经网络是正确的选择,最终,神经网络重回大众视野。2003年,Geoff 当时在多伦多,CIFAR 找他做关于神经计算的程序。我们聚在一起,决定努力重燃对工作的兴趣。但是,发布我们的想法之前,我们需要一个安全的地方,来举办一些小型研讨会和会议,真正地发展我们的想法。该项目于 2004 年正式启动,到 2006 年出现了一些非常有趣的论文。Geoff 也在《Science》上发表了一篇相关论文。

2006 年 Hinton 《Science》论文中的人脸识别图像

Trudeau:

在上一个人工智能寒冬,当大多数人放弃神经网络研究,有些人继续前进,加拿大悄然建立现代 AI 研究的基础,那我可以肯定地讲,加拿大在这方面,在支持纯粹科学研究上,一直做得很好。

我们给真正聪明的人提供了做前沿研究的机会,即便他们的研究可能不会落地到商业或某些具体的地方。

Hinton:

2006 年在多伦多,我们开发出了这种训练含有多个层的网络的技术,它比以前的技术更高效。同一年我们在《Science》发表了一篇论文,它产生了很大影响,也为我们的主张起到了很大支持作用,很多人重新燃起了对神经网络的兴趣。2009 年的时候我的实验室里有两个学生开发了一种用深度神经网络做语音识别的方法,它的效果要比当时所有别的方法都好。

其实它的提升也就只有一点点,但是相比之下当时别的技术的发展已经陷入了停滞,30年了都没有实质性的进步。深度神经网络只需要几个月的时间就可以比那些方法做得好,很明显可以看出来只需要短短几年时间,神经网络就还可以有大的发展。

Metz:

大概 2009 年的时候,Hinton 很巧地遇到了微软的语音识别研究员邓力。就像其他人一样,邓力相信 AI 的呈现形式不应当只有符号化 AI 一种。对于符号化 AI ,语音识别系统需要由一行又一行的代码组成,需要人工设定系统的每一个行为的具体细节,系统研发也进行得非常缓慢。

Hinton 表示他尝试用神经网络做语音识别,而且已经有了实质性进展。神经网络能够学会分析语音数据中的模式,而且运行速度也要比一行行代码组成的符号化 AI 系统要快。邓力这时候并没有完全相信 Hinton 的话,但他邀请 Hinton 来微软继续推进这项研究,最终还有两位 Hinton 的合作者也一起来了。微软的语音识别技术由此跨越了一大步,2010 年时谷歌也跨了一大步。

后来,到了2012年底,Hinton 和两个学生一起在图像识别方面也做出了突破性进展,把之前的所有方法都远远甩在了身后。也就是直到这个时候,微软和谷歌之外的业界公司们才开始意识到这个想法有多么厉害。

值得注意的是,这些都是很老的想法了。但现在神经网络背后的计算能力和数据量就和以前大不一样。对于微软和谷歌这种规模的科技企业,他们需要数以千计的计算机共同运行,处理文本、视频等等各种东西。让神经网络获得成功的正是这些:训练网络需要许多的数据,同时你还需要足够的计算能力支撑网络的训练。

办公室里的 Hinton

办公室里的 Hinton

LeCun:

如果你要问为什么过了这么久才成功,那我的回答是,科学研究就是这样的,人类的心理也就是这样的。当一种新技术出现的时候,要先有足够的证据能说服人们它能行,然后人们才会开始大规模使用它。但神经网络的这些方法一直有「挑剔」的坏名声,想要发挥出效果也需要一些「黑魔法」。

Richard Sutton:

计算能力能这样快速而持久地提升,这是十分惊人的。现在,想要开发更复杂的算法的人和想要开发更快的计算机的人之间仿佛在比赛一样。对于设计的算法的人来说,已经可以考虑设计运行在未来 5 到 10 年内新出现的计算机上的算法了。

计算机需要什么是好的、什么是不好的。所以人类会给它一个特别的信号,叫做「反馈」(reward)。如果反馈值高,那就说明是好的;如果反馈值低,那就说明是不好的。这就是这种设计的目的。

神经网络可以存储学习过程,而强化学习就是让你决定你想要改变什么。

Bengio: