文/ InfoQ薛梁

FPGA(Field Programmable Gate Array)现场可编程门阵列,作为ASIC领域中的一种半定制电路而出现已有30年的历史了,它既解决了定制电路的无法改变功能的不足,又克服了原有可编程器件门电路数有限的缺点,可应用的场景也很广泛。

1月20日,腾讯云推出国内首款高性能异构计算基础设施——FPGA云服务,利用云服务的方式将只有大型公司才能长期支付使用的FPGA服务推广到了更多企业。企业可以通过FPGA云服务器进行FPGA硬件编程,可将性能提升至通用CPU服务器的30倍以上。同时,与已经深入人心的高性能计算的代表GPU相比,FPGA具有硬件可编程、低功耗、低延时的特性,代表了高性能计算的未来发展趋势。

而在人工智能(AI)里面火热的深度学习领域,企业同样可以将FPGA用于深度学习的检测阶段,与主要用于训练阶段的GPU互为补充,FPGA还可应用于金融分析、图像视频处理、基因组学等需要高性能计算的领域,是这类对效率要求高的行业应用的最佳选择。

基于此,我们特邀InfoQ采访了由腾讯云基础产品中心、腾讯架构平台部组成的腾讯云FPGA联合团队,向读者介绍FPGA的基本原理和设计初衷、应用场景以及它给行业带来的价值。

随着芯片制程逼近理论极限,可以预见通用处理器(CPU)性能提升空间越来越有限。而腾讯自己的业务随着移动互联网的快速增长,数据体量的急剧膨胀,伴随着对这些数据的计算需求也在迅猛上涨。腾讯在2013年开始考虑如何解决计算需求的增长,而FPGA作为一种可编程的加速硬件彼时进入了大家的视野。有了解决计算需求的想法后,需要通过实践验证FPGA实际的能力。

腾讯的QQ、微信业务,用户每天产生的图片数量都是数亿级别,常用的图片格式有JPEG格式、WebP格式等,WebP图片格式比JPEG图片格式存储空间小30%。为节省存储空间,降低传输流量,提升用户的图片下载体验,通常采用WebP格式进行存储及传输分发,而图片转码所带来的计算消耗需要上万台CPU机器支撑。自然FPGA开发落地的第一个切入点就是图片转码:将JPEG图片格式转成WebP图片格式。

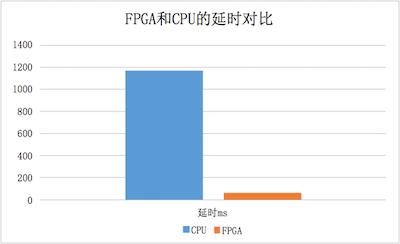

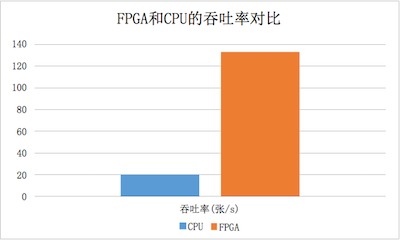

在图片转码的实践中,FPGA联合团队取得了FPGA处理延时相比CPU降低20倍,FPGA处理性能是CPU机器的6倍,验证了FPGA能进行计算加速的能力,同时也增强了FPGA联合团队的自信心。

▲图片转码中FPGA和CPU延时对比

▲图片转码中FPGA和CPU吞吐率对比

图片转码项目完成后,深度学习映入了FPGA联合团队的眼帘,一方面深度学习需要密集的计算,另一方面深度学习在未来应用上有着巨大的商业价值。深度学习基于深度神经网络理论,用在图片分类的神经网络是其中的一个分支:卷积神经网络(CNN)。团队使用FPGA对CNN计算进行加速,增强违规图片检测能力,最终在深度学习的实践中取得了FPGA处理性能是CPU机器4倍的战绩。

腾讯云FPGA项目实践的结果,见证了FPGA在数据中心里可以提供强大的计算能力和足够的灵活性,来应对数据中心对硬件加速的挑战。经过之前的FPGA实践,FPGA联合团队获得了在数据中心使用FPGA的经验,未来也将在数据中心的计算、网络、存储三个方向进一步探索,重构数据中心基础架构。

云端的数据中心业务日新月异,更需要一种高性能、高灵活的底层硬件结构,所以FPGA联合团队通过云端开放FPGA计算服务,从硬件层面加速云计算在各个场景中的应用,降低企业的使用门槛和成本。

2016年3月,英特尔宣布正式停用“Tick-Tock”处理器研发模式,未来研发周期将从两年向三年转变。至此,摩尔定律对英特尔几近失效。一方面处理器性能再无法按照摩尔定律进行增长,另一方面数据增长对计算性能要求超过了按“摩尔定律”增长的速度。

CPU本身无法满足高性能计算应用软件的性能需求,导致需求和性能之间出现了缺口。

在新的芯片材料等基础技术没有取得突破前,一种有效的解决方法就是采用专用协处理器的异构计算方式来提升处理性能。

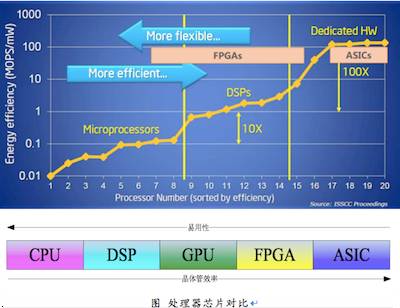

现有的协处理器主要有FPGA,GPU和ASIC,FPGA由于其独特的架构拥有其他处理器无法比拟的优势。

FPGA(Field Programmable Gate Array)现场可编程门阵列,可以通过软件重新配置芯片内部的资源形成不同功能硬件,就像用乐高积木可以搭出航空母舰或变形金刚一样。因此,

FPGA不仅有了软件的可编程性和灵活性,同时又有ASIC高吞吐和低延时的特性。

而且,由于有丰富的IO,FPGA还非常适合用作协议和接口转换的芯片。

FPGA在数据中心最大的特点就在高吞吐的同时能做到低延时。

FPGA内部的资源都是可以重配置的,因此它可以很容易进行数据并行和流水并行,且易于在数据并行和流水并行之间平衡。

而GPU几乎只能做数据并行。

与ASIC相比,FPGA的可编程性体现出很大的优势。现在数据中心的各种算法每时每刻都在更新变化,没有足够稳定的时间让ASIC完成长周期的开发。比如在一种神经网络模型出来之后开始把它做成ASIC,也许还未投片生产,这个神经网络模型已经被另一种神经网络模型所替代。不同的是,

FPGA可以在不同的业务需求之间做平衡。比如说白天用于为搜索业务排序的机器;在晚上请求很少的情况下,可以将这些FPGA重新配置成离线数据分析的功能,提供对离线数据进行分析的服务。

另外由于FPGA有高速SERDES等丰富的接口,而且能灵活控制实现的粒度和操作数据,因此非常适合进行协议处理和数据格式的转换。比如说

FPGA可以很方便的接入以太网数据,并对以太网包进行包过滤等处理。

▲处理器芯片对比

CPU/GPU 属于冯·诺依曼结构,任务执行需要经历取指、译码、执行、访存以及写回等过程。CPU为达到足够高的通用性,其指令流的控制逻辑相当复杂。GPU使用SIMD单指令多数据流并行等方式进行计算加速。

FPGA/ASIC在使用时硬件功能模块已固定,无需分支判断等复杂控制逻辑,同时大大降低了访存次数。因此在能效上可以比 CPU 高出1到2个数量级。

ASIC是一种专用的芯片,是为了某种特定的需求而专门定制的芯片。ASIC与通用芯片相比,体积小、功耗低、计算效率高、芯片出货量越大成本越低。但是缺点也很明显:开发周期很长,算法是固定的,一旦算法变化就可能无法重用。

而FPGA则是“软硬件一体”的架构,软件就是硬件。

FPGA基本原理是在芯片内集成大量的数字门电路以及存储器,用户可以通过烧入 FPGA 配置文件来来定义这些门电路以及存储器之间的连线,

进而得到不同的硬件功能。

就开发难度而言,ASIC > FPGA > GPU > CPU。

目前主流的FPGA开发语言是硬件描述HDL,需要开发者具备一定的相关技能。随着业界OPENCL、HLS等类C高级语言的推进,FPGA的开发难度和周期也会有所改善。

腾讯云的FPGA主要部署在数据中心的服务器中。腾讯云将FPGA芯片加上DDR内存、外围电路和散热片,设计成PCIE板卡。这种FPGA板卡被安装在服务器的主板上,用户通过网络远程访问服务器,开发调试FPGA,并用其加速特定业务。

FPGA与CPU之间是通过PCIE链路通信的。CPU内部集成了DDR内存控制器和PCIE控制器。在FPGA芯片内部也用可编程逻辑资源实现了PCIE控制器、DDR控制器和DMA控制器。一般通讯分三种情况:

(1)指令通道

CPU向FPGA芯片写入指令,读取状态。CPU直接通过PCIE访问到FPGA芯片内挂载的存储器或内部总线。

(2)数据通道

CPU读写FPGA板卡上DDR的数据时,CPU通过PCIE配置FPGA芯片内的DMA控制器,输入数据的源物理地址和目的物理地址。DMA控制器控制FPGA卡上的DDR控制器和PCIE控制器,在FPGA卡上的DDR内存和CPU连接的DDR内存之间传输数据。

(3)通知通道

FPGA通过PCIE向CPU发送中断请求,CPU收到中断请求后保存当前工作现场,然后转入中断处理程序执行,必要时会关闭中断执行中断处理程序。CPU执行完中断处理程序后,会重新打开中断,然后重载到之前的工作现场继续执行。

在行业内,微软在数据中心使用FPGA架构,Amazon也推出了FPGA的计算实例,那么是不是说明整个行业对FPGA的使用比较广泛呢?实际上,FPGA是个硬件芯片,它本身不能直接使用,也缺乏类似操作系统这样的系统软件支持。长期以来,FPGA行业在数据计算加速方向可以分为以下几个参与方:

1.芯片原厂