本文内容非商业用途可无需授权转载,请务必注明作者及本微信公众号、微博 @唐僧_huangliang,以便更好地与读者互动。

25G

、

40G

、

56G… FC

说我能比你们都快,而且还只是单个

lane

。

昨天看到华云数据收购

Maxta

的新闻,不过我还是想写点具体技术相关的东西。

也是这两天注意到

64GFC

和第七代光纤通道的消息,仔细一看原来是去年底发布的,为什么没啥关注度呢?

想想现在主流数据中心网络接入层的速率,以太网还在从

10Gb/s

向

25Gb/s

过渡中,

FC

多是

16Gb

和

32Gb

,

InfiniBand

则以

56Gb

(

FDR

)和

100Gb

(

EDR

)为主。需要注意的是,

56Gb

和

100Gb IB

都是

4

个

lane

(

4

对信号线),

40Gb

和

100Gb

以太网(多用于汇聚

/

核心层)也是如此。

那么对于

单个

lane 25Gb

的以太网和

32Gb

的

FC

来说,速率翻倍也算是个挑战了。

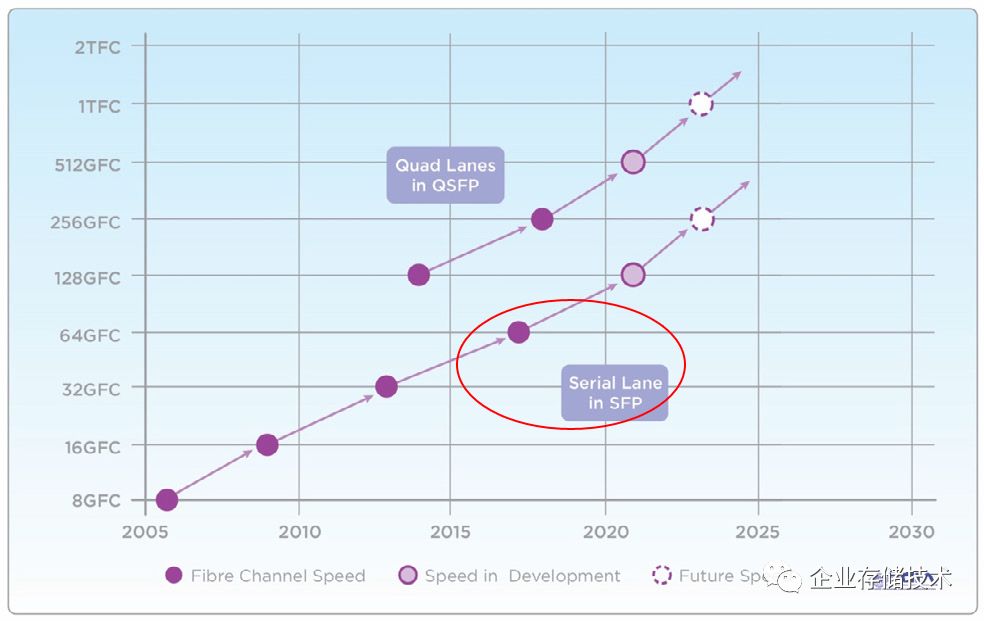

请注意位于上方那条折线是

Quad Lane

(

4

信道)

in QSFP

,也就相当与

4

个单

lane

聚合。

上图引用自

FCIA

最新的

Roadmap

,按道理到

2019

年

Serial Lane in SFP

达到

64G

的光纤通道产品应该出现了。不过现实往往没有计划乐观,我们也简单看看问题出在哪里。

这就是被

Broadcom

收购的

Emulex

,最新一代的

Gen 7 Fibre Channel HBA LPe35000

系列中的

4

端口

32Gb

卡,同一代自然也提供单

/

双端口的型号。不难看出这

LPe35004

卡的金手指是

PCIe x16

,而单

/

双端口则是

PCIe x8

,它们使用的控制芯片应该都是同一颗

XE601

。

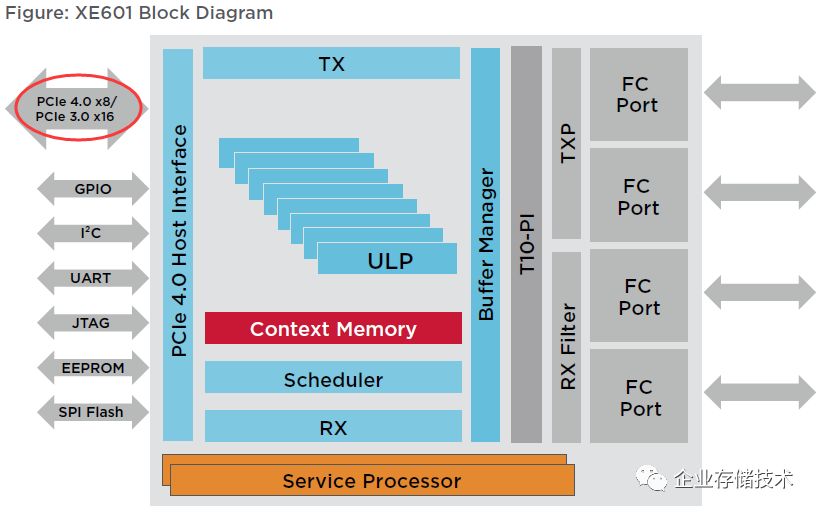

这个是

Broadcom

(

Emulex

)

XE-601

的架构图,该芯片主机界面可支持

PCIe 4.0 x8

或者

PCIe 3.0 x16

。我们知道目前除了

Power9

之外,

Intel

和

AMD

的

x86

平台还不支持

PCIe 4.0

,所以绝大多数人应该是这样计算带宽的:

4

个

32GFC

口

总带宽

3200x4=12800MB/s

(双向还可以

x2

),单个

lane

接近

1GB/s

的

PCIe 3.0

只有

x16

才能发挥到线速

。

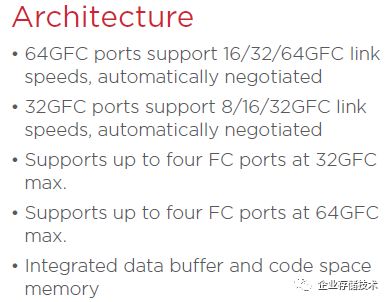

要说

64GFC

有点不足的话,那就是不再支持自适应到

8G

链路速度了(向前兼容

2

代)

目前

Emulex

发布的

Gen 7 FC HBA

还不支持

64G

,但芯片有这个潜在能力,最多

4

个端口能一起跑到

64G

,这种配置下无论

PCIe 3.0 x16

还是

PCIe 4.0 x8

都显不足了(还会有

Gen 8 FC

嘛)。好在服务器端的主流需求是双端口为主,

将来

64G

的

LPe35002

跑在

PCIe 4.0 x8

的主板上比较合适

。当然,对

PCIe Gen4

最迫切的应该还是

200Gb/s IB

和

OPA

。

同时我们不能忽略

光模块

,还有交换机。我在《

PowerEdgeMX

网络篇:从

100GbE

到

32Gb FC

的

2

种姿势

》中说过

32GFC

的物理层速率是

28Gbps

(

64b/66b

编码,准确点说

28.05 Gb/s

),那么在一对差分信号上实现

64GFC

也需要与之对应物理层收发器——

Broadcom

资料里写的是

57.8 Gb/s

。正好前几天我还转载了一篇《

数据网络,“凭什么”可以达到

56 Gbps

?

》,可供大家了解这一领域的进展。

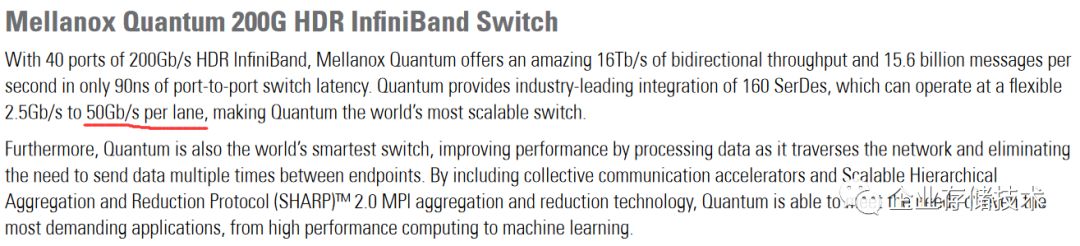

旁引个资料:

Mellanox

还是早了一步,在

200G HDR InfiniBand

上用到了

50Gb/s per lane

。虽然这家公司身陷收购传闻,但我不得不佩服他们的技术理想与实践,

Mellanox

是网络领域一个独特的存在:)

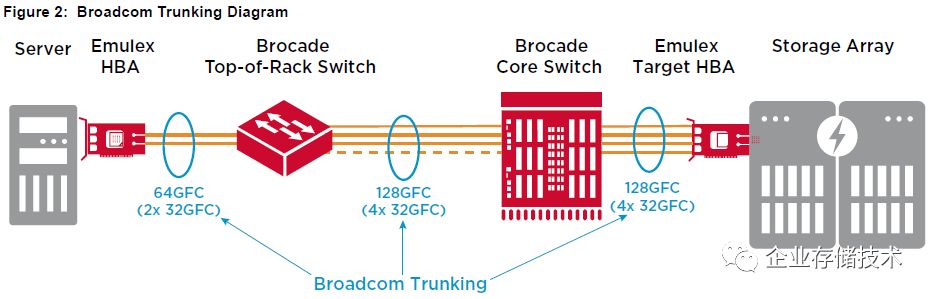

上图引用自《

Fibre Channel Trunking -Emulex® Gen 7 HBAs and Brocade® Gen 6 Switches

》,如今博科也同在

Broadcom

屋檐下,但

7

代的

HBA

暂时还只能配

6

代交换机用,所以即使

HBA

卡支持

64G

也只能跑

32G

。看来整个生态系统不是太着急,为什么呢?

我们再从去年底

FCIA

的新闻稿中看看,还有哪些要点:

-

为全闪存和端到端

NVMe

数据中心而构建,提供

10

µ

s

以内的往返延时,大于

500

万

IOPS

。

-

Gen 7 Fibre Channel

将受益于

成熟的第二代

T11 FC-NVMe

标准

,带来增强的“

Sequence-Level

”错误恢复。关于

NVMe over Fibre Channel

(

NVMe/FC

)协议的支持,我在《

端到端

NVMe

阵列:想说爱你却没那么快?

》简单讨论过一点,记得交换机部分曾有写错之处,感谢朋友的纠正。

-

性能升级只需要简单热插拔

64GFC

光套件

(主要是光模块)

当时的新闻里还提到

Dell EMC

是交付

Gen7 FC

的首家服务器厂商,也就是

PowerEdge

系列,当然目前暂时还是跑

32G

。

讨论

Emulex

之余,我总是会一同看看

QLogic

。刚被

Cavium

收购不久,又加入了

Marvell

,估计整合要折腾一阵吧。按以往的经验,等将来

64GFC

真正上线应用的时候,我倒是不太担心两家的产品都能准备好。

小结

其实

在当前

32G FC

很少有不够用

的情况,作为存储网络,光纤通道基本上只负责南北向、服务器到存储阵列之间的

I/O

。那些

Scale-out

架构的

SAN

存储,比较高端的在

控制器间用

IB

或者

PCIe

互连

(如

EMC VMAX/PowerMAX

),另外一些用以太网;像

IBM SVC/V7000

那样将

FC

作为控制器间通信的毕竟属于另类。

在这种专注的用途下,不需要

RDMA

,而光纤通道也支持

NVMe over Fabric

了。相比之下,

IB

用于计算

-

存储节点间互连主要应用在

HPC

领域(扩展阅读:《

HPC

存储

IO500

测试分析:这结果合理吗?

》)。

Server SAN

的前后端(或称内外部)网络通常都是以太网,

25Gb/40Gb

真正不够用的时候又有多少呢?

别忘了还有端口聚合

/

多路径。

就像一位专家朋友所说:“

全世界的

transaction

(交易数)增加了多少?

”

SAN

也好,

Server SAN

也罢,承载的主要还是传统结构化数据,还有虚拟机等。有几个人真正需要在单块

I/O

卡上跑

500

万

IOPS

?这大概就是

64GFC

目前的孤独吧:)

参考内容

https://fibrechannel.org/industrys-fastest-storage-networking-speed-announced-by-fibre-channel-industry-association-%E2%94%80-64gfc-and-gen-7-fibre-channel/

https://fibrechannel.org/broadcom-first-to-ship-7th-generation-fibre-channel/

注

:本文只代表作者个人观点,与任何组织机构无关,如有错误和不足之处欢迎在留言中批评指正。

进一步交流

技术

,

可以

加我的

QQ/

微信:

490834312

。如果您想在这个公众号上分享自己的技术干货,也欢迎联系我:)

尊重知识,转载时请保留全文,并包括本行及如下二维码。感谢您的阅读和支持!《企业存储技术》微信公众号:

HL_Storage

长按二维码可直接识别关注

历史文章汇总

:

http://chuansong.me/account/huangliang_storage