本文约

2500

字,

建议阅读

6

分钟。

本文将为你介绍如何用贝叶斯方法结合深度学习的方法运用在机器学习中。

[ 导读 ]

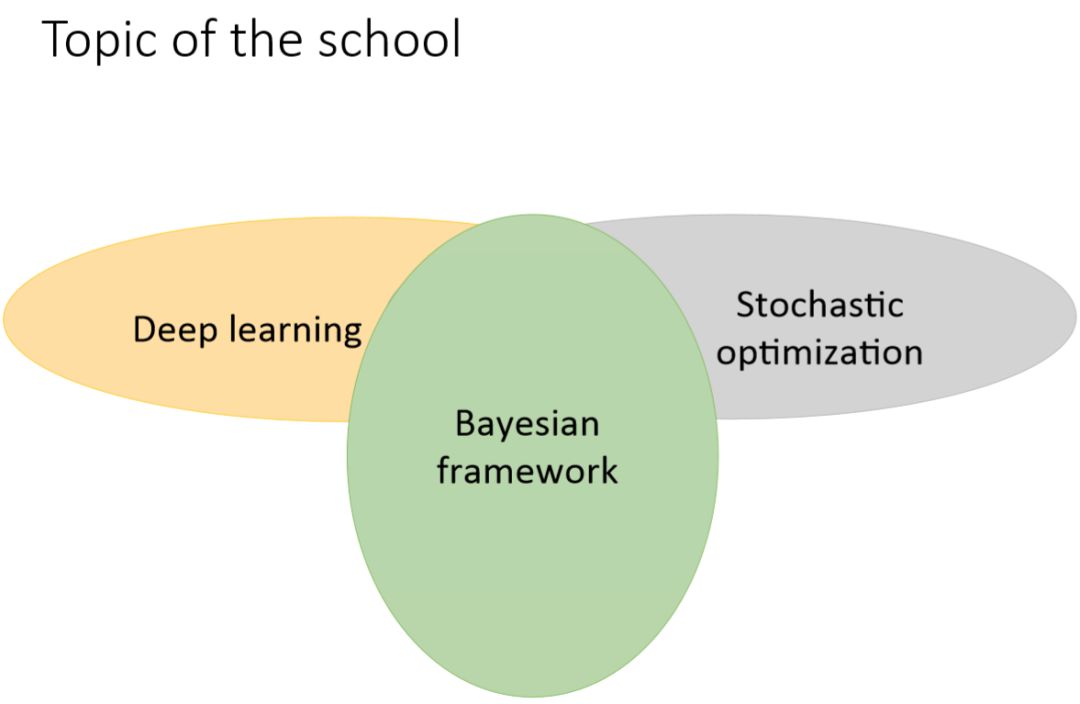

在 Deep|Bayes 夏季课程中,授课人将讨论贝叶斯方法如何结合深度学习,并在机器学习应用中实现更好的结果。近期研究表明贝叶斯方法的利用可以带来许多好处。学生将学到对理解当前机器学习研究非常重要的方法和技术。他们还将体会贝叶斯方法和强化学习之间的联系,学习神经网络的现代随机优化方法和正则化技术。在课程之后,授课人还设置了实践环节。

项目地址:https://github.com/bayesgroup/deepbayes-2018

视频地址:https://www.youtube.com/playlist?list=PLe5rNUydzV9Q01vWCP9BV7NhJG3j7mz62

PPT 地址:https://drive.google.com/drive/folders/1rJ-HTN3sNTvhJXPoXEEhfGlZWtjNY26C

教师

多数讲师和助教都是贝叶斯方法研究团队的成员以及来自世界顶级研究中心的研究者。很多讲师曾经在顶级国际机器学习会议例如 NIPS、ICML、ICCV、CVPR、ICLR、AISTATS 等发表过论文。贝叶斯方法研究团队已经开发了一系列的大学课程,包括贝叶斯方法、深度学习、优化以及概率图模型,拥有大量的教学经验。

学生

该夏季课程面向:

学习本课程的必备基础

我在 Deep|Bayes 能学到什么?

-

贝叶斯方法为什么(在机器学习和日常生活中)这么有用?随机性到底是什么?

-

隐变量模型。如何训练模型识别在训练前未知的模式?

-

可扩展的概率模型。为什么将概率推断问题转换为优化问题是有用的?

-

强化学习和贝叶斯方法之间的联系。如何训练随机计算图?

-

自动 Dropout 率的微调。神经网络会过拟合吗?(会的)

-

随机优化。如何以比计算一个点的函数值更快的速度来优化函数?

该课程的目标是展示在深度学习中使用贝叶斯方法可以扩展其应用范围,并提升性能。尽管机器学习中有很多不同的问题设定,但贝叶斯网络的概率推断可以用相似的方式来解决它们。你,心动了吗?

课程主要内容

整个课程涉及贝叶斯学习的方方面面,从最基础的贝叶斯原理到比较难的变分推断和马尔可夫链蒙特卡洛方法。以下展示了整个课程的主题列表,机器之心将简要介绍部分课程内容。

第一天:

-

贝叶斯方法简介

-

贝叶斯推理

-

隐变量模型和 EM 算法

-

EM 算法

第二天:

-

随机优化简介

-

可扩展贝叶斯方法

-

变分自编码器

-

狄利克雷隐变量

第三天:

-

变分推断高级方法

-

变分推断视角下的强化学习

-

强化学习

-

分布式强化学习

第四天:

第五天:

-

高斯过程

-

贝叶斯优化

-

深度高斯过程

-

马尔可夫链蒙特卡洛方法

-

随机马尔可夫链蒙特卡洛方法

第六天:

-

贝叶斯神经网络和变分 Dropout

-

稀疏变分 Dropout 和方差网络

-

信息瓶颈

整个课程需要六天才能完成,且每一天的的课程量都非常大,因此机器之心只简要介绍最基本的贝叶斯方法和隐变量模型,其中贝叶斯方法是整个课程的核心思想,而隐变量模型又是生成模型等很多高级方法的基础。

贝叶斯方法简介

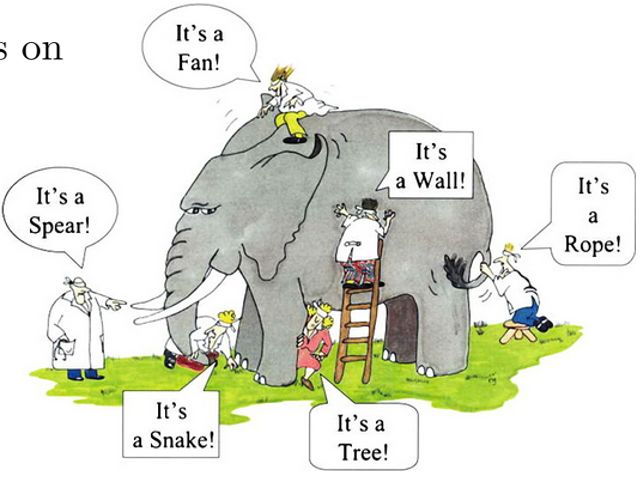

我们首先围绕“盲人摸象”的例子来介绍贝叶斯定理,然后简单描述频率学派和贝叶斯学派的区别。

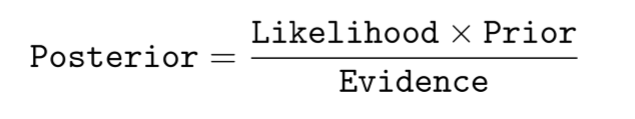

1. 贝叶斯定理:

首先贝叶斯定理的基本形式为

即后验=似然度 x 先验/证据

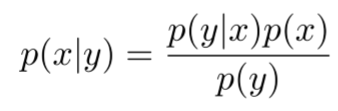

形式化的样子是

现在我们开始讨论“盲人摸象”问题。

一群“盲人”在摸一头大象,试图猜测摸的是什么东西,然而没有一个人猜的是正确的。在不确定的世界里,这就是我们在用概率论理解世界时的样子。

为简单起见,我们把问题设置得简单一些:一群“盲人”在摸一头大象,并且知道这是一头大象,他们希望根据摸到的东西猜测大象的重量。

贝叶斯方法是怎么解决这个问题的呢?

我们假设这些盲人之间会互相交流观察结果,并且都拥有一定的共同常识,也就是对大象重量的最初猜测:

然后他们可以这样:

第一个人的观察结果是摸到了尾巴,以及尾巴的长度 y1,然后重新猜测大象的重量;

第二个人将第一个人的猜测作为先验,并且观察结果是摸到了肚子,以及肚子的面积 y2,然后再次猜测大象的重量;

第三个人同理,根据第二个人的猜测,继续观察、猜测……

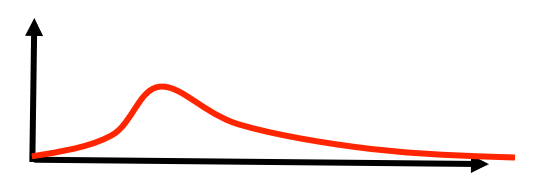

在此过程中,他们一开始的共有常识、大象的猜测重量即先验 P(x),第一个人的观察结果即似然度 P(y1|x),观察结果本身出现的可能性就是证据 P(y1),最后就得到的是 P(x|y1),也就是根据观察结果 y 得到的大象重量为 x 的可能性(概率分布):

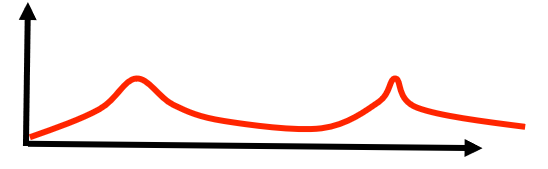

而第二个人在此基础上,将能得到 P(x|y1,y2):

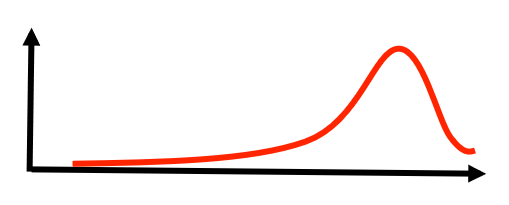

第三个人将能得到 P(x|y1,y2,y3)……

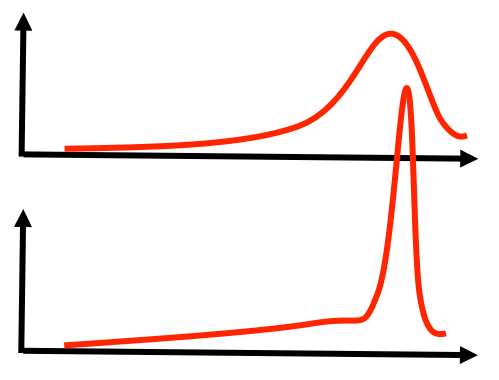

好了,随着观察报告的增加,这头大象的重量也越来越藏不住了(峰值变得尖锐):

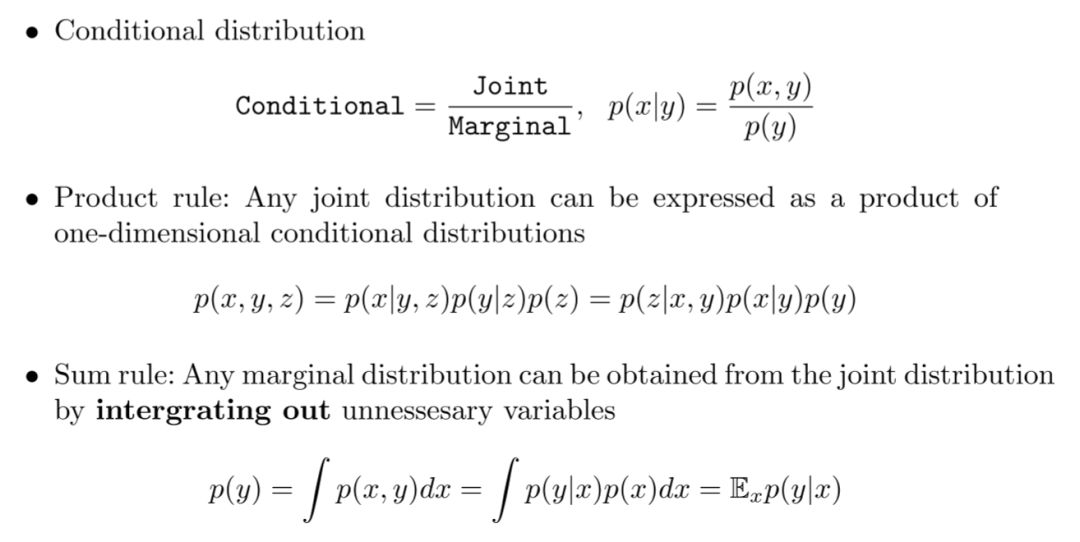

当然,授课人在课程中会很详细地把概念一步一步讲清楚,包括条件分布、联合分布、边缘分布之间的关系,以及乘积规则、和规则的介绍,可以把上面这个例子涉及的各个概念串联起来,帮助学生理解得更加透彻。

2. 频率学派和贝叶斯学派的联系和区别:

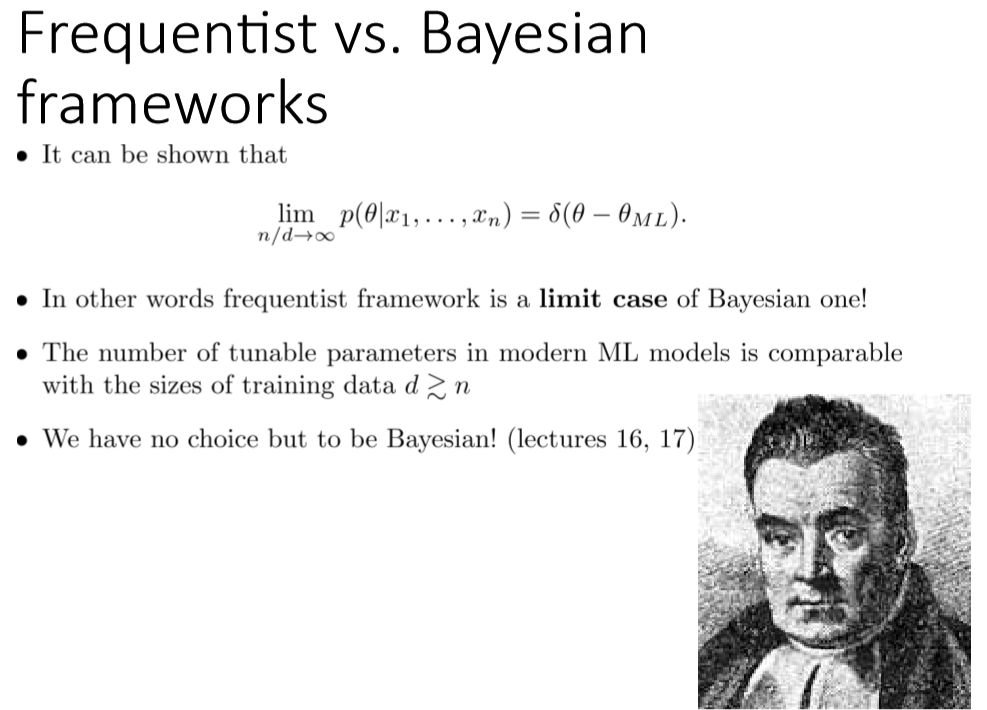

频率学派不假设任何的先验知识,不参照过去的经验,只按照当前已有的数据进行概率推断。而贝叶斯学派会假设先验知识的存在(猜测大象的重量),然后再用采样逐渐修改先验知识并逼近真实知识。但实际上,在数据量趋近无穷时,频率学派和贝叶斯学派得到的结果是一样的,也就是说频率方法是贝叶斯方法的极限。

以上就是贝叶斯方法的基础理论部分的大致内容,之后还有生成、判别模型的区别,贝叶斯训练过程以及贝叶斯方法优势的讨论。

3. 隐变量模型