4月11日晚,地平线第三期微讲座正式开讲,主讲人是地平线机器人智能驾驶研发总监余轶南。本次讲座主题为“通往智能驾驶的深度学习之路”,主要包括环境结构化感知和语义理解两个方面。

自从2012年深度学习爆发

以来,

深度学习在图像、自然语言理解、语音技术等方面都有了非常多的突破和发展,这些技术的提高也使得自动驾驶方面的感知技术有了非常大的进步。

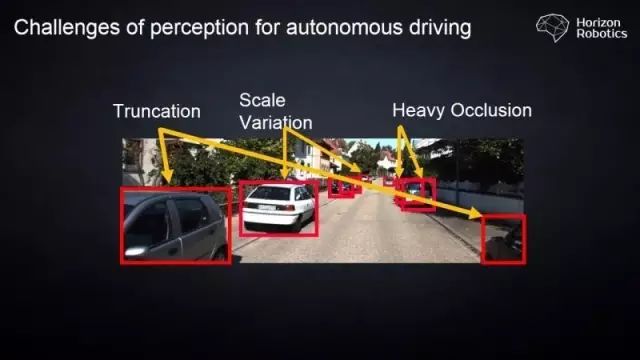

以计算机视觉为例,在传统的辅助驾驶技术中,通过摄像头来对路面中的物体进行识别和检测,主要会遇到这样的一些问题:

比如说物体的遮挡,物体尺度的变化,还有一些因为视野不够所造成的一些障碍,只能对物体进行部分的感知。

这些问题在传统的计算机视觉中都是一些非常困难的问题,也使得传统的计算机视觉需要人工去设计非常多的结构来去处理这样的一些问题。

在有了深度

学习以

后,这些问题变得更加容易一些。

模型所需要知道的就是人工的标注,哪些是属于车辆,而哪些不属于车辆

,然后通过非常大量的数据进行训练,从而得到最后的结果。

这种模式我们一般

也称作

为end to end,也就是“端到端”的训练。

这种方法在一些简单的自动驾驶任

务中已经取得了非常不错的结果。

如图中所示,我

们

在

车辆的检测,车道线、可行驶区域

这些问题上面都取得了非常大的进步,使得这些技术可以被真正应用在辅助驾驶的系统中。

因为深

度学习具有非常强大的数据拟合能力,使得我们在问题的建模时变得非常简单,我们的研究人员

在这种情况下只需要关注问题的输入和问题的输出就可以了。

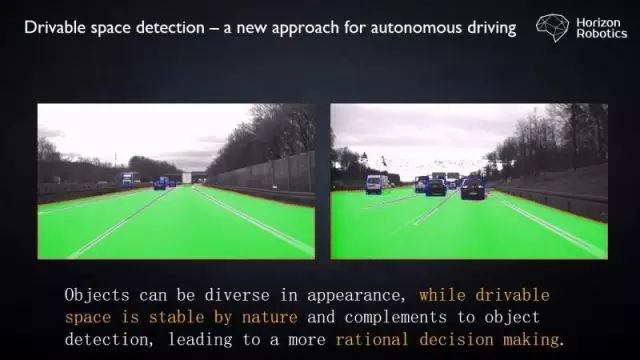

例如像可行驶区域这样的技术难题,在过去的方法中是非常难以被解决的。

那么对于深度学习来说,我们只需要标注海量的可行驶区域的图片,然后将这些图片送到神经网络中,使得神经网络去拟合这样的输出,便可以达到我们的目的,这样的结果在我们目前所看到的各种系统中已经非常常见了。

例如mobileye的IQ3的系统已经可以做到非常好的物体检测,包括车辆的检测,

行人的检测,交通标志牌和地面的交通标志物,还有可行驶区域的检测。

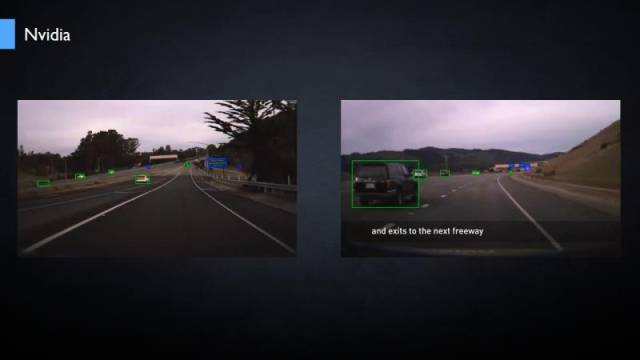

又例如N

vidia今年早些时候所展示的新的系统,已经可以处理非常多类别的检测和识别问题。

上面的

这些结果

对于做计算机视觉方向的人来讲,都不是什么特别难的问题。但是我们在这里想讨论一个问题,就是

这些结果是真正自动驾驶想要的结果吗?

对于辅助驾驶系

统来说

,车道线、前方车辆的距离、行人这几种类型是非常关键的要素。

我们的系统需要

在车

辆非法变线、车辆和行车的距离保持过近等情况下,对我们的驾驶员进行报警就可以了。

而车辆本身事实上并不

关心周

边的环境的变化,周边环境的结构。但是对于自动驾驶来说,这样的简单的感知和识别是不足够的。

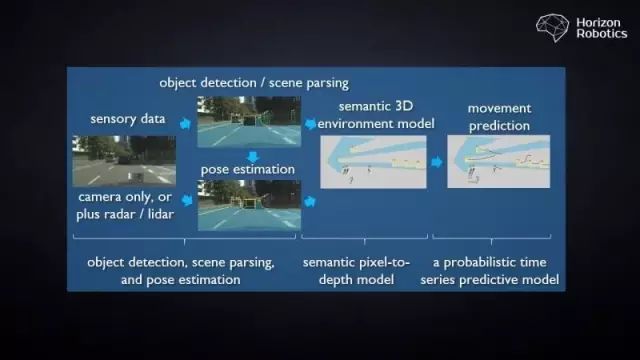

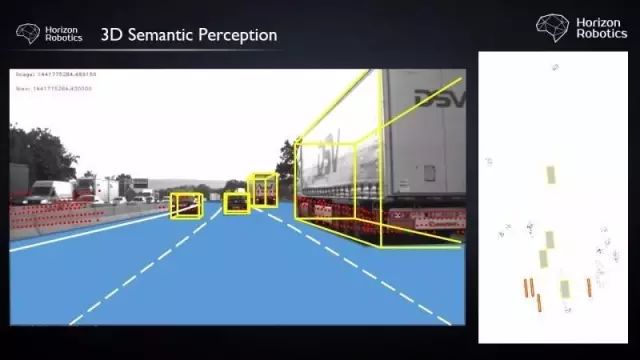

这张图里展示我们目前系统整体的结构框图。对于自动驾驶系统来说,整个环境的3D建模

和物体的运动估计是尤为重要的技术。

当我们的车辆在直行、换线、通过十字路口的时候,它需要对车辆的360度范围之内的运动物体进行感知和运动的跟踪。

那么物体在图像上的(Bounding box)本身并没有任何的含义,而只有物体本身的结构,物体的运动方向,物体和车辆的相对的关系,才是我们真正关心的东西。

因此

我们将环境感知更加聚焦在以规划和决策为目的的环境建模上面

。从而来倒推我们的感知系统需

要做出哪些相应的技术,来完成这样的建模。

决策系统希

望从感知系统获得前方车辆的距离、速度、姿态、运动的角度等信息。那么

这些信息如何从视觉或者其他的传感器获得,变成了技术的关键

。

原文链接:

https://mp.weixin.qq.com/s/-jQD791fF4STq8ok2ht-0A