早上刷微博看到@酱紫表分享他第一次在本地跑大模型,看得我手痒,于是在我这台 Mac Studio 上也安装跑了下。

安装过程很简单,一个软件,一行命令,就可以在 Mac 上使用大语言模型对话,就像用 ChatGPT 一样,而且 Mac 断网也可以用。

下面分享一下过程。

安装 Ollama

Ollama 是一款可以让电脑本地运行大语言模型(LLM)的工具,所以第一步是安装 Ollama。

打开官网

ollama.com

,点 Download↓下载,然后选择 macOS 版下载即可。

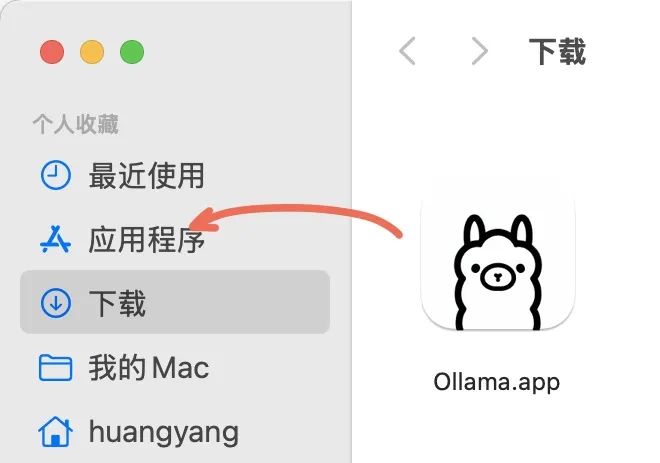

把下载的 .app 文件放到「应用程序」文件夹即是安装(小羊驼🦙图标好可爱)。

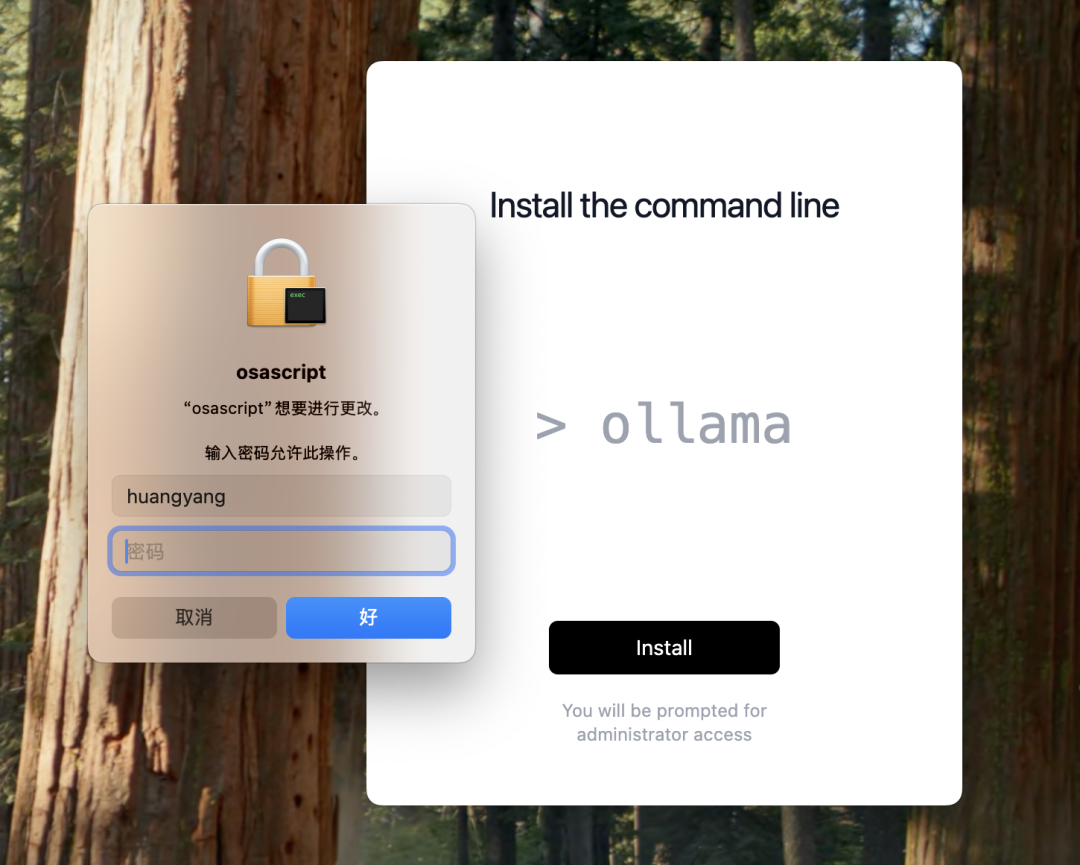

第一次打开 Ollama 会提示安装命令行工具(Ollama 本身并没有 GUI(软件窗口)界面),输入 Mac 用户密码授予权限就行了。

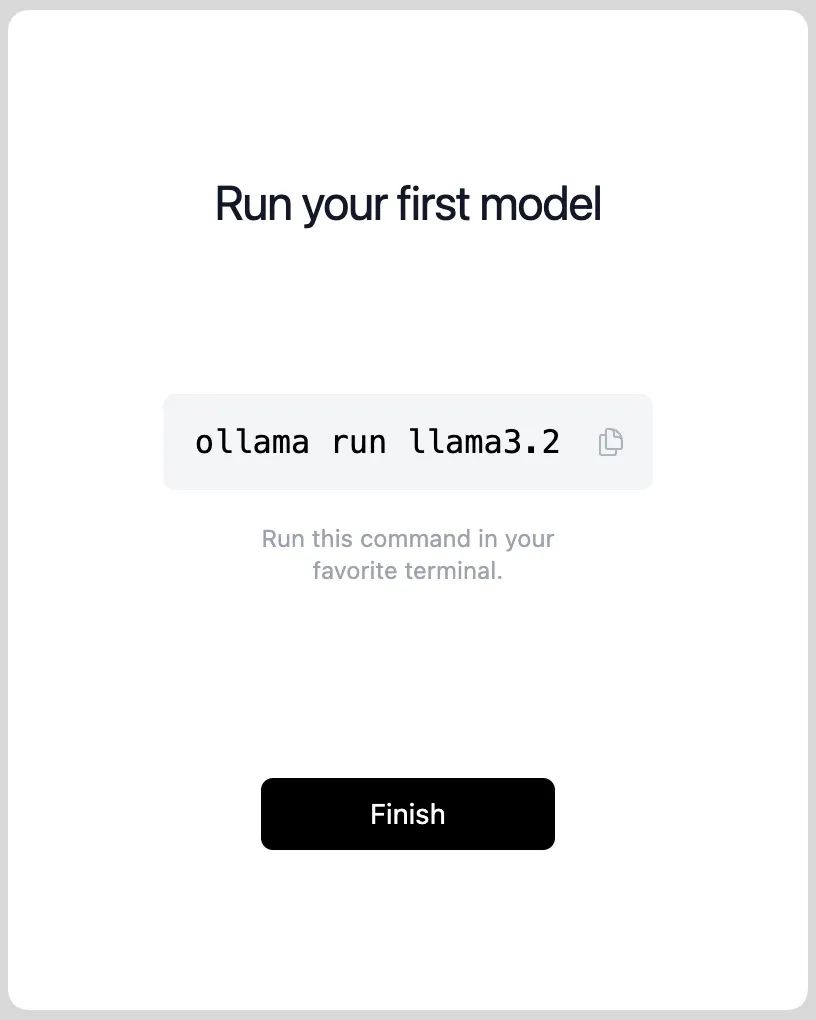

接下来会提示你安装第一个本地模型 llama3.2。

复制

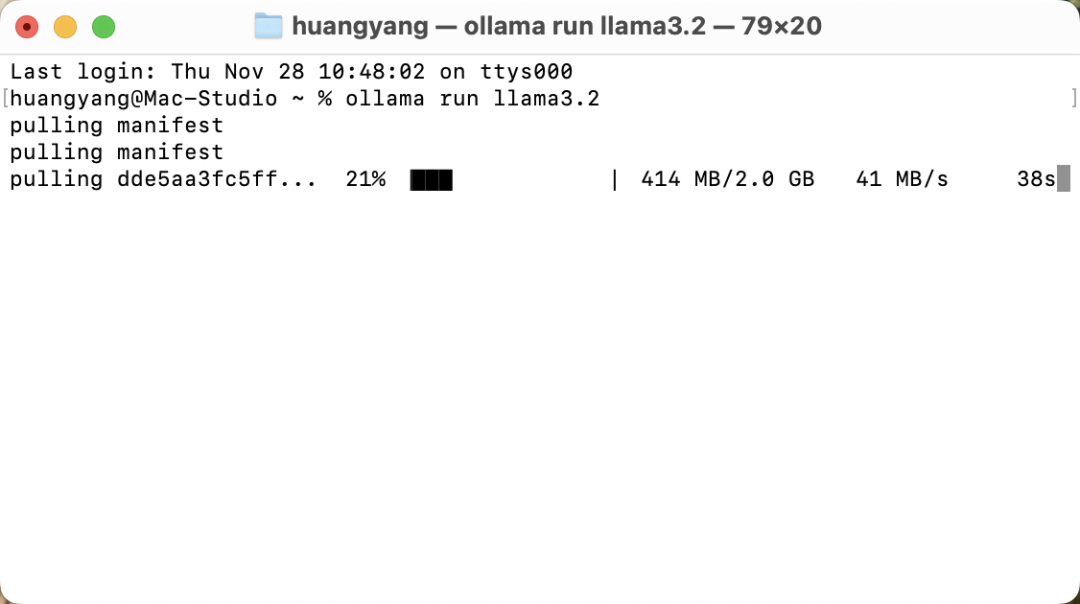

ollama run llama3.2

这行命令,打开 macOS 终端窗口,粘贴并回车,接着开始下载 llama3.2 这个本地模型,这个模型有 2GB。

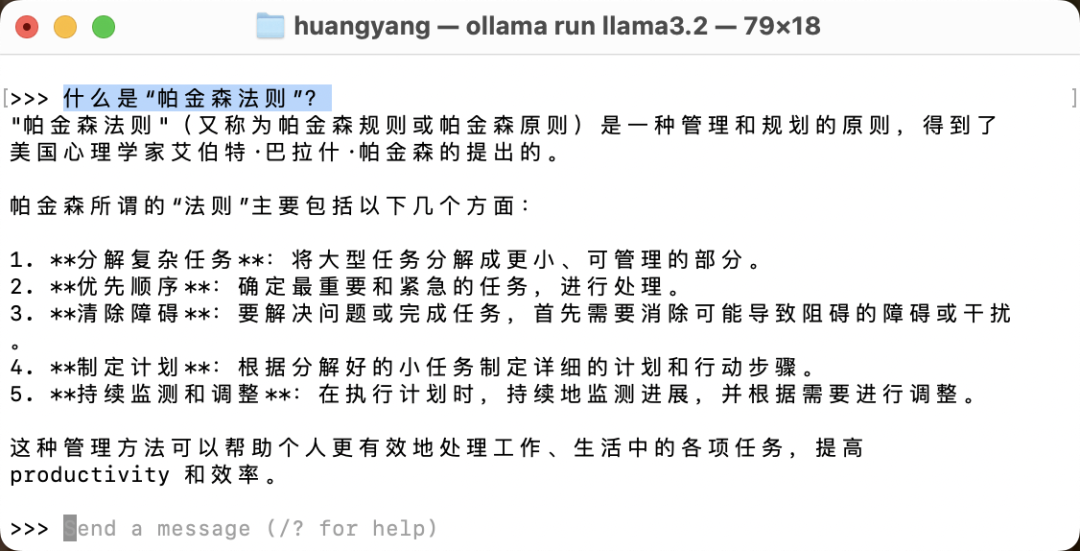

等显示 success 就代表安装好了!现在可以使用这个模型(跟它对话)了。

安装更多本地模型

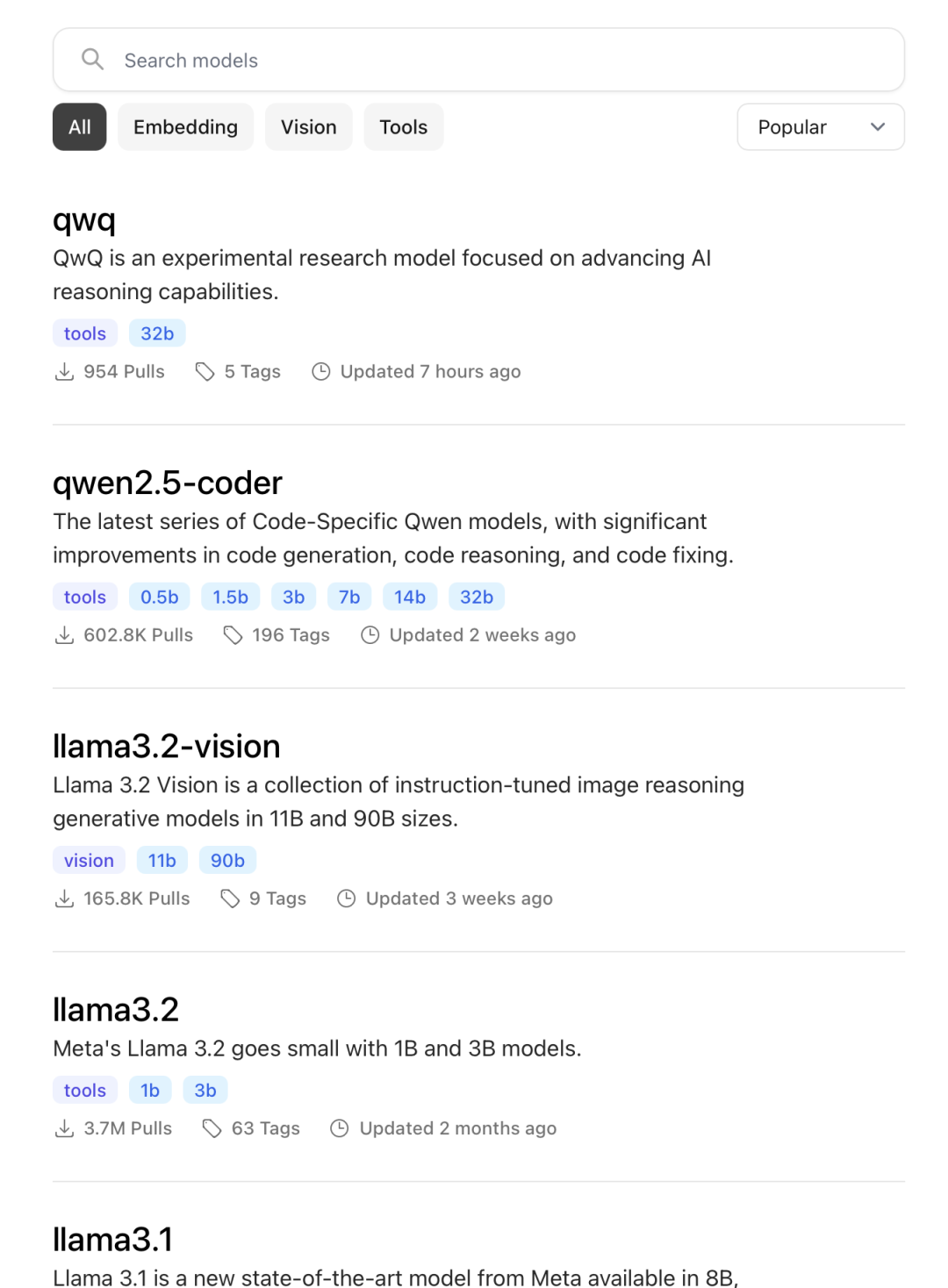

在 Ollama 官网点 Models 就可以查看或者搜索所有的本地模型。

比如我们想下载阿里的「通义千问」大语言模型「qwen2」,先选择一种模型规格,简单来说

规格数越大,模型体积越大,模型越“聪明”,但对电脑的性能要求越高。

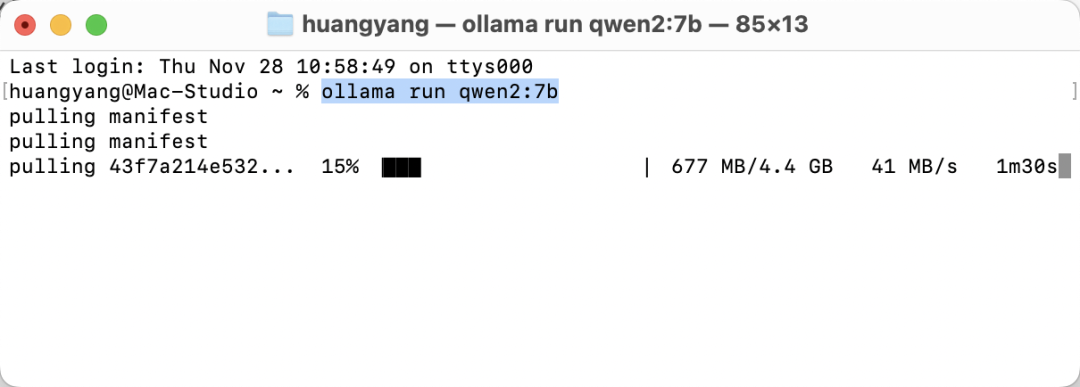

复制安装代码粘贴到终端并回车(也可以手动输入),开始安装 qwen2:7b 本地模型。

安装完一个本地模型,会自动进入这个模型的对话界面。输入

control - D

快捷键可以退出此次对话。

怎么查看和删除已安装的本地模型?

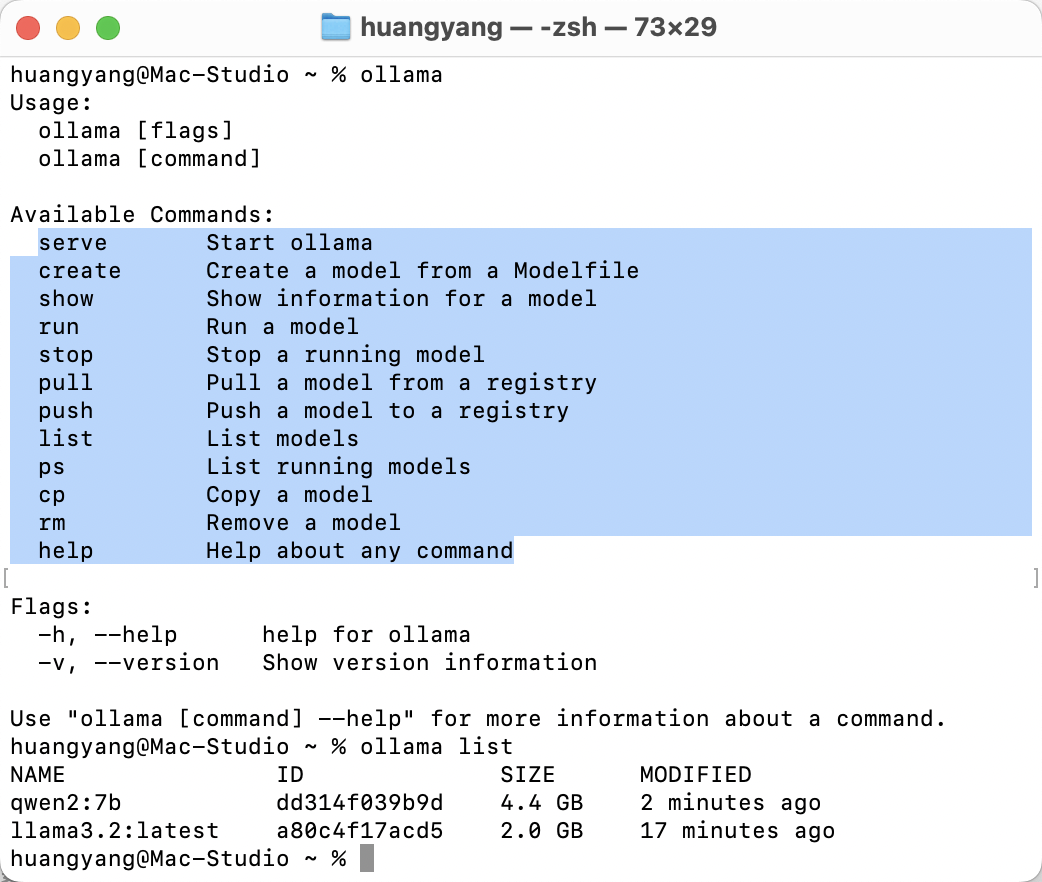

虽然 Ollama 没有 GUI(软件窗口)界面,但工具能做的操作并不多,也不复杂,只要在终端窗口输入

ollama

并回车,就能看到 ollama 的用法。

比如想

查看本地安装了哪些模型

,就输入命令:

ollama list

并回车。

要

开始使用某个本地模型

,就用

ollama run 模型名字

并回车。

想

删除某个本地模型

,就输入命令:

ollama rm 模型名字

并回车。

所有下载到本地的模型都被放在 macOS 用户目录下的

.ollama

这个隐藏文件夹下。如果你卸载了 Ollama,但忘记先删除本地下载的模型,也可以直接删除这个文件夹。

显示隐藏文件的快捷键

command - shift - .

本地模型位置👉

~/.ollama/models/

以及 Ollama 程序会保持在后台运行,可以直接在菜单栏点开程序图标来退出。

不喜欢命令行操作?

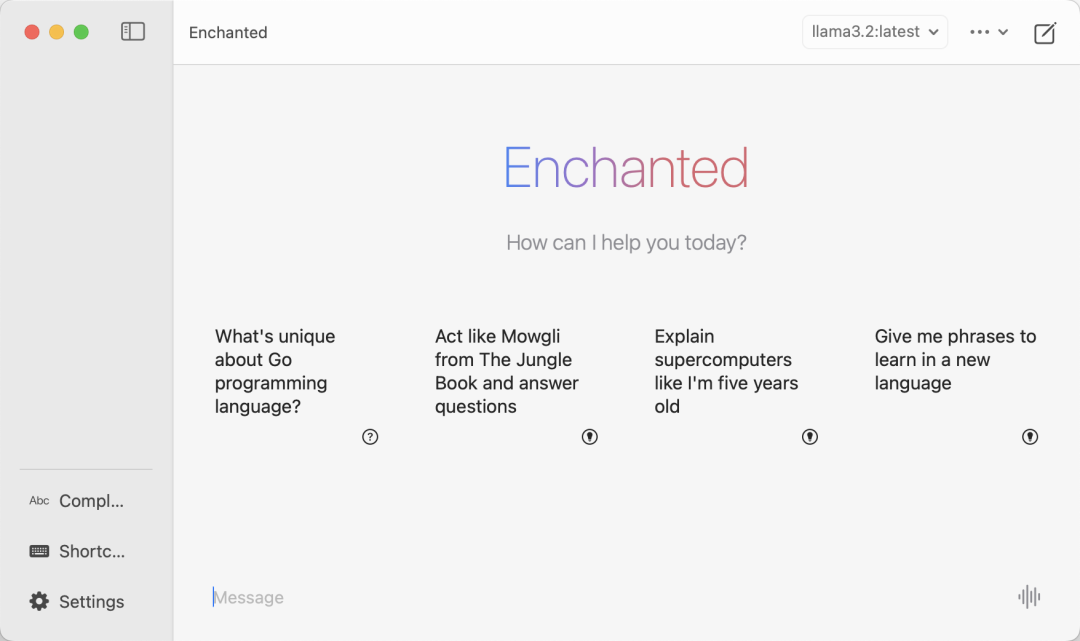

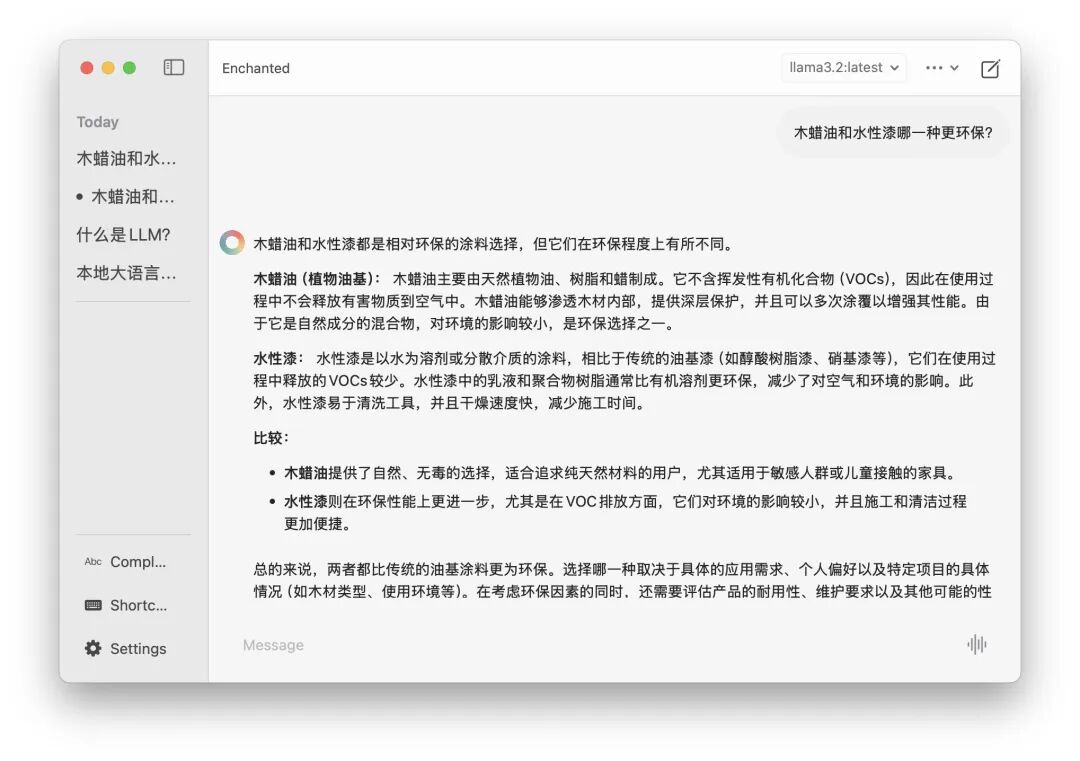

如果你不习惯用终端命令行操作,也可以在 App Store 安装

Enchanted LLM

这款免费软件,它甚至支持 iPhone、iPad 和 Apple Vision。

Enchanted LLM 其实相当于给 Ollama 套了个 GUI 的壳,所以需要先打开 Ollama 并且安装了本地模型,才能在 Enchanted LLM 上使用这些模型。

Enchanted LLM 的软件界面是不是跟 ChatGPT 界面很像,而且即是你现在给 Mac 断网,也依然可以使用本地大模型对话。

本地大语言模型的好处和不足?

因为是本地离线运行的,不受网络情况的影响,所以

对话响应速度更快

,并且

没有隐私安全问题

,而且使用几乎零成本,永久免费,无限次数对话,也方便开发人员本地进行相关开发调试。