正文

在人工智能界,Michael I. Jordan的大名应该是尽人皆知,这位执教于加州大学伯克利分校的教授因其在机器学习领域的突出贡献,被称为

“机器学习之父”

。在美国,相比与之同名的NBA传奇球星迈克尔·乔丹,他有着另一个有趣而贴切的称号:

“The Michael Jordan of Machine Learning”

(机器学习领域的迈克尔·乔丹)。

图丨《Science》报道的一份计算机科学影响力榜单将Michael Jordan排名第一,其配图意味深长

Jordan教授在 AI 领域并非浪得虚名,

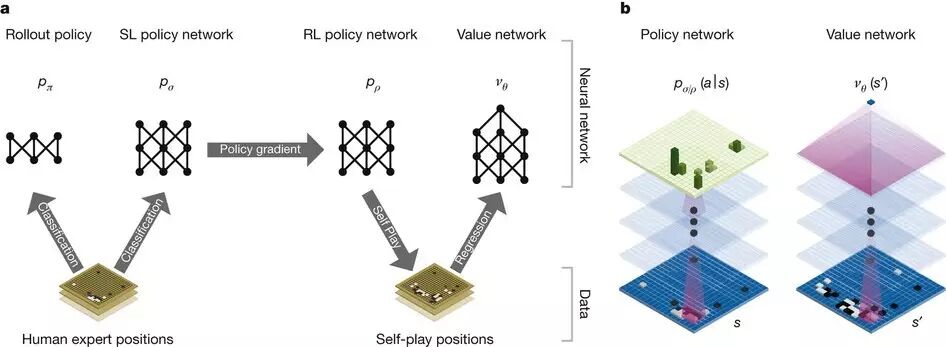

他在整个学术生涯中都对机器学习、概率统计和神经网络进行着深刻的探索,他的许多论文已成为当代AI应用的基础,包括虚拟现实(VR)、增强现实(AR),以及DeepMind的“围棋上帝”AlphaGo。

图丨加州大学伯克利分校中Jordan教授所属的电子工程和计算机科学系

曾在Jordan教授门下学习的不少学生后来也成了该领域中的大咖,比如

蒙特利尔大学教授Yoshua Bengio,百度前首席科学家、斯坦福大学教授吴恩达

等。

图丨Michael Jordan教授

近五年,AI的热度越来越高,媒体、资本、科技公司都一窝蜂地涌入这个前沿风口。

尤其在AlphaGo之后,“人类智力的又一壁垒终被突破”,“AI要战胜人类”这样的论调不绝于耳。

但与主流的狂热不同的是,Jordan教授对人工智能和深度学习抱有一种学者应有的冷静。早在2014年,Jordan教授就对这股热潮泼了一盆冷水:在与美国电气电子工程师学会杂志《科技纵览》(IEEE Spectrum)的采访中,他首先就表示:

“所有学术问题都有这样的误读。媒体总是尽力发掘那些抓人眼球的话题,有时候有些报道就言过其实了。”

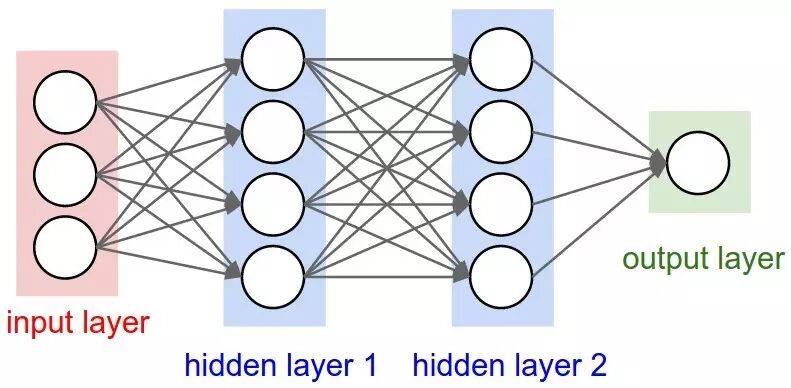

Jordan教授认为,不应该把深度学习和人脑的神经科学过度联系,因为我们对人类的认知研究还处于极为原始的阶段。

类比于物理学来说,神经科学还停滞在牛顿和爱因斯坦出现之前。“所以,我们还没有步入可以利用我们对脑的认识来指导搭建智能系统的时代。”

图丨神经网络

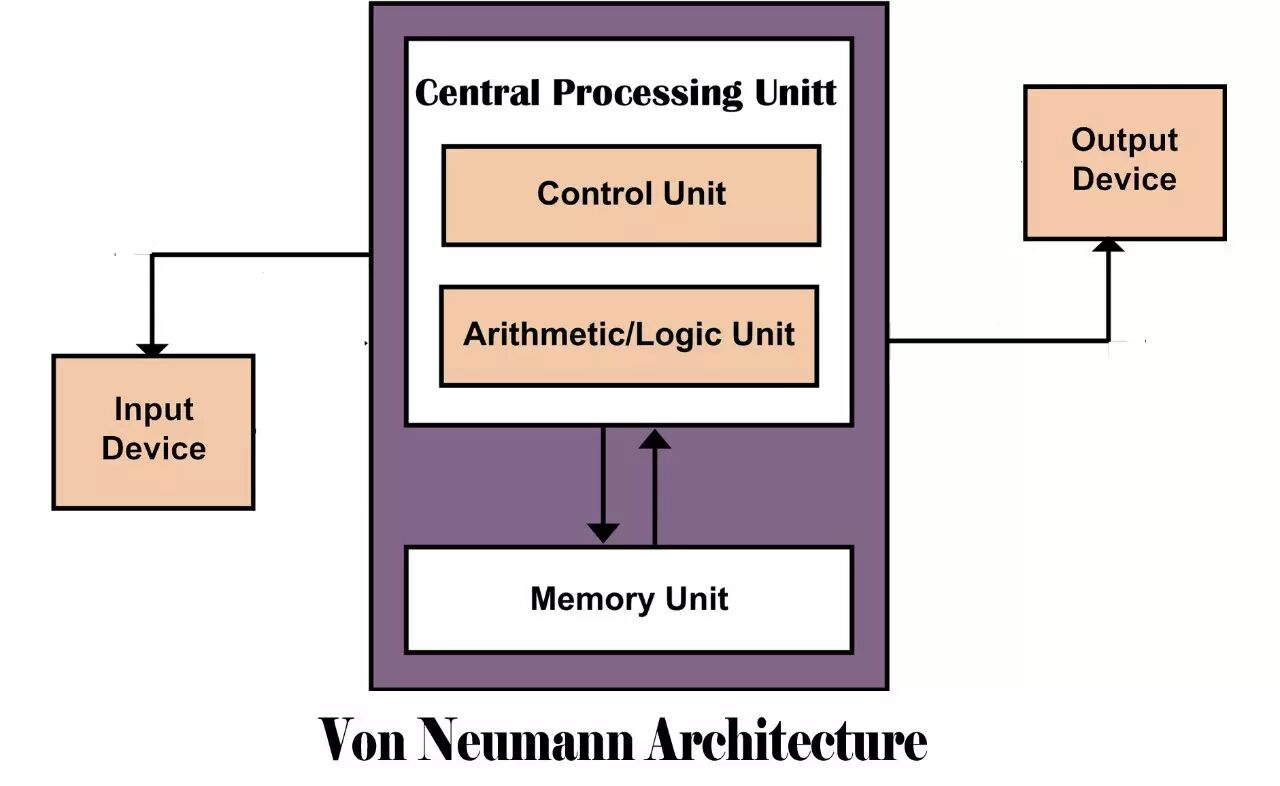

本质上来讲,传统计算机还处于冯·诺依曼的传统架构时代

,只是人们有了想要突破这种范式的需求,才会寻求高度并行大脑的一些比喻,所以有了目前脍炙人口的“神经网络”。

图丨传统的冯·诺依曼结构

就在今天,Michael Jordan教授莅临深圳,在腾讯主办的2017“云+未来”峰会上发表了题为“机器学习:创新视角,直面挑战”的主题演讲。DT君也有幸采访到了这位AI领域的顶尖学者。以下是Jordan教授的精彩回答。

图丨DT君与Michael Jordan教授

问:

目前深度学习是AI相关研究的最主流方法,但也开始有人质疑,

将所有的希望全部寄托在深度学习上是否会导致研究同质化?

尤其在美国,陆续出现了一些基于“小数据”和消费级电子设备的机器学习研究方法,比如概率编程等。您对这一现象怎么看?

答:

其实现代机器学习包含了很多方法,比如基于矩阵因子分解的推荐系统,和经典的树形结构算法,这些都能用于解决问题。

强化学习也经常会演变为一套巨大的树状搜索系统。

Nvidia也很有针对性的提供了不同的软硬件来满足不同的人工智能研究方法。

当然,

深度神经网络是一个比较常用的方法

,但如果研究的对象存在数据标签不足的问题,比如文字分析只需要去理解语料库,且这个语料库又只有少数标签,我可能会选择该领域常用的语义分割的方法,因为我只需要了解文字所表达的主题和文章结构。

所以说,

深度学习并不是唯一的方法

,我们所建造的GPU、TPU这类专用硬件能够支持一系列的分析方法应用。

下一代的研究方法势必会整合树操作、搜索操作、约束满足操作,甚至会包括一些语言学上的研究方法,而不是目前这样的一层层的矩阵堆叠。

图丨决策树

问:

《麻省理工科技评论》不久前刊登了一篇关于AI相关研究不可解释性的文章,比如机器到底是如何决策的。而

某些人类无法理解、无法掌控的机制往往会给技术本身带来隐忧。这个问题您怎么看?

答:

不可解释性其实是 AI 研究中遇到的很多问题之一。其他比如机器人安全、语义抽象性等,这些都是问题。但要说不可解释性如果是一个无法忽视的大问题的话,或许我们不应该使用深度神经网络,而应该转而使用决策树。

决策树很好理解:提出问题,选择一个最优解法,如果中途又出现新的问题,在重建一个树状选择,以此类推。

图丨AlphaGo中的决策网络系统

决策树方法可能没有深度神经网络那么高效

,但也还不错,尤其是在数据量充足的条件下,将多个决策树组成随机森林,也可以达到深度神经网络的水平,而且更具有可解释性。

其实人类智能就是一个复杂决策树的典型案例,它不仅能分析出最优解,还能预测其他选择可能带来的后果,以及是否必要。

所以我觉得,

深度神经网络的不可解释性确实是一个大问题,但或许我们不该责怪神经网络本身。

因为它就是这样一种隐含性的方式,是我们主动选择了这样一种难以解释的方式。比较好的解决方法是,我们围绕神经网络,在其周围建立更多可解释的架构。

而且我认为一个神经网络并不是所有问题的万能钥匙,与神经网络相辅相成的其他算法也是必要的。

图丨由腾讯主办的“云+未来“峰会

最后附上Michael Jordan教授在本次腾讯“云+未来”峰会上的主题演讲:“机器学习:创新视角,直面挑战”精彩内容摘要。

60年代刚刚出现“智能”这个词的时候,

大众对人工智能的认识还只局限于具备人类思维的机器人,

所有的科幻电影展示的都是利用云系统、视觉系统,还有自然语言系统,来使机器人越来越像一个人。

但是在80、90年代,出现了IA的概念,也就是智能增强技术,最典型的代表就是搜索引擎。此外,智能IaaS(智能基础设施服务)的概念也开始浮现,

现在我们的交通和金融等每一个行业都出现了智能化的趋势,我们也发现世界更了解我们了,能够根据我们的需求提供服务。

而实现这一目标的是一个系统工程,如今我们把它称之为“云”,这个云变得越来越智能,所以,

并不是机器人和我们沟通,而是这个云的架构和云的基础设施在和我们沟通。

而“云”的角度来讲,数据分享就变得至关重要了,它也是人工智能的基石,我们能够通过它帮助其它公司进行数据的传输,获得更多的竞争优势。但这也会引发诸如诈骗信息、不公正、多样性缺失和系统攻击等问题,这对于人工智能的发展来说都会是潜在的大问题。

除此以外,现在的人工智能已经可以更好的帮助我们进行语音识别、视觉识别等功能,

但机器人还没办法帮我们了解听觉、视觉之后的真正的意义。

也就是说,在短期之内还不会出现像人这样的灵活可变的人工智能。也许机器可以了解一些事实,但是它们没法真正得到人这样一种高级智能,甚至连小孩子也不如,它没有办法了解抽象思维,没有办法进行抽象的处理,

机器人并没有办法实现像人一样的能力,它没有办法引领一个公司的发展。到目前为止,在我们这代人身上还看不到那种高水平的强人工智能的出现。