刚刚过去的秋季苹果新品发布会正式发布了全新的 iPhone X,虽然与此前的各种预测分析并无二致,但当苹果真正向世人展示这部充满未来感的手机时,相信很多人依旧被震撼到了。苹果也丝毫不掩饰对自家新产品的自豪感,为 iPhone X 打出了“Say hello to the future”(你好,未来) 的广告词。

图丨全新 iPhone X

iPhone X 留给人们最深刻的印象无疑是其 Face ID 面部识别功能,不管是叫好还是恶搞,Face ID 在一夜之间已经火遍个大社交媒体。网友们为 Face ID 恶搞出的各种“应用场景”更是层出不穷。

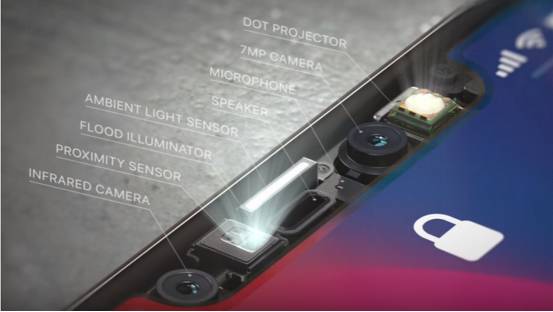

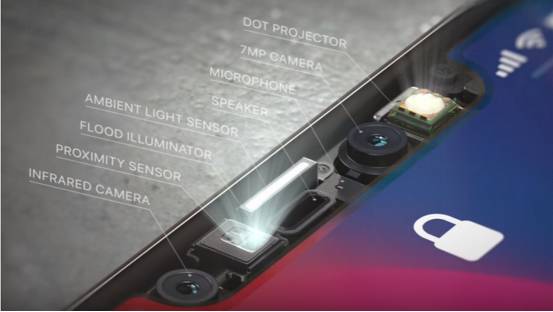

图丨iPhone X 正面上方的面部识别组件

此外,从设计上看,iPhone X 在全面屏上方多出了一块“刘海”区域,虽然这个设计一曝光即被网友和其他手机厂商作为“槽点”狠狠戏弄了一番。但不论从 OLED 全面屏中这块异形区域的加工难度,或者其内部暗藏的众多传感器来看,这种设计可能是苹果能找到的最佳解决方案。

图丨iPhone X“刘海”处其实整合了 Face ID 相关的大量核心技术

从上图可以看见,“刘海”区域内整合了的原深感摄像头(TrueDepth Camera)和点位投射器(Dot Projector)是 Face ID 面部识别功能的核心组件。这项苹果公司酝酿了至少 4 年的技术最终得以搭载在手机平台上。

为何这么说?其实苹果公司早在 2013 年 11 月,就以 3.45 亿美元的高价收购了以色列传感器公司 PrimeSense,该公司专注于开发通过摄像头来进行 3D 扫描成像的相关技术。微软的第一代 Kinect 体感互动平台、高通早期的 Vuforia AR 增强现实平台,以及 iRobot 的 Ava 机器人自主导航平台都是由这家公司参与开发。

图丨最初曾有人猜测,苹果收购 PrimeSense 是为了将其技术应用在 Apple TV 上来增加体感功能,然而其技术最终却搭载在了手机上

图丨最初曾有人猜测,苹果收购 PrimeSense 是为了将其技术应用在 Apple TV 上来增加体感功能,然而其技术最终却搭载在了手机上

PrimeSense 被苹果收购后,沉寂了相当长一段时间,目前看来,其多年的研发成果终于被整合到 iPhone X 上。此外,有消息称 PrimeSense 的技术也成为了苹果增强现实开发平台 ARKit 的基础。

所以说,你甚至可以这么简单粗暴的理解:苹果将一整组 Xbox Kinect 微型化,并统统塞进了 iPhone X 的“刘海”中……

Face ID 面部识别功能室 iPhone X 的一大特色,但苹果显然还要拿它做更多的事。发布会上演示的一些 AR 游戏显然是其应用场景。而且,对自动驾驶激光雷达稍有了解的人应该知道,既然是深度相机,又具有点位投射器辅助,测距与成像势必成为潜在应用场景。为了展示 iPhone X 在这方面的潜能,苹果开发了一款极具趣味性,又比较“接地气”的应用:Animoji 动态表情。

图丨苹果发布会上介绍 Animoji

Animoji 是 iOS 11 中加入的一项新功能,可以简单看作是 iPhone 表情包 emoji 的动画版本。Animoji 通过 iPhone X 搭载的原深感摄像头对用户表情进行实时捕捉,并同步到卡通形象上。

苹果对 Animoji 的定义是“使用用户本人声音和表情的定制动画消息”。同时,开发人员也提供了一系列的 3D emoji 模型供用户选择,比如狐狸、猴子、小狗,甚至便便……

图丨Animoji 实时面部表情捕捉

在 2015 年苹果收购苏黎世公司 Faceshift 起,苹果就在布局实时表情捕捉技术及应用,历时两年推出了这款 Animoji。虽然 Animoji 确实是一个很好玩的功能,但目前只有 iPhone X 可以使用该功能。高昂的门槛源自于其表情捕捉技术对原深感摄像头的依赖。其他的 iPhone 用户,以及 Android 的大量用户,只能望洋兴叹了。

事实上,有一家低调的中国公司已经走在了美国同行的前面,只需要普通的手机摄像头,就可以在多平台上完成高质量的实时面部表情捕捉,并用来驱动虚拟形象。该公司开发的面部动态捕捉 SDK 被应用于直播、社交、游戏等领域,并已拥有了超过 70 家 B 端客户,SDK 日均调用次数近 400 万次。这家公司便是位于杭州的相芯科技有限公司(faceunity.com)。

图丨相芯科技的实时表情捕捉 App

相芯科技的表情捕捉技术之所以不需要深度摄像机,是源于他们在人脸跟踪和三维重建领域的积累。人类对于人脸的识别有着非常强的先验知识,只是看到一个人的照片,也可以想象出这个人的长相及三维特征。相芯科技通过长期积累的三维人脸大数据,借助于深度学习算法,使得从二维图像恢复三维人脸模型成为了可能。

图丨相芯科技的实时面部表情捕捉与驱动

具体来说,该技术将庞大的三维人脸数据压缩成 3MB 的张量模型。并由机器学习的方法,从单张照片中提取人脸的特征信息,根据张量模型恢复出整个人脸三维模型。在此基础上,通过视频中不断输入的人脸信息,对人脸的面部特征和表情进行识别和分离,以达到无需校准步骤的精确表情识别与三维重建。

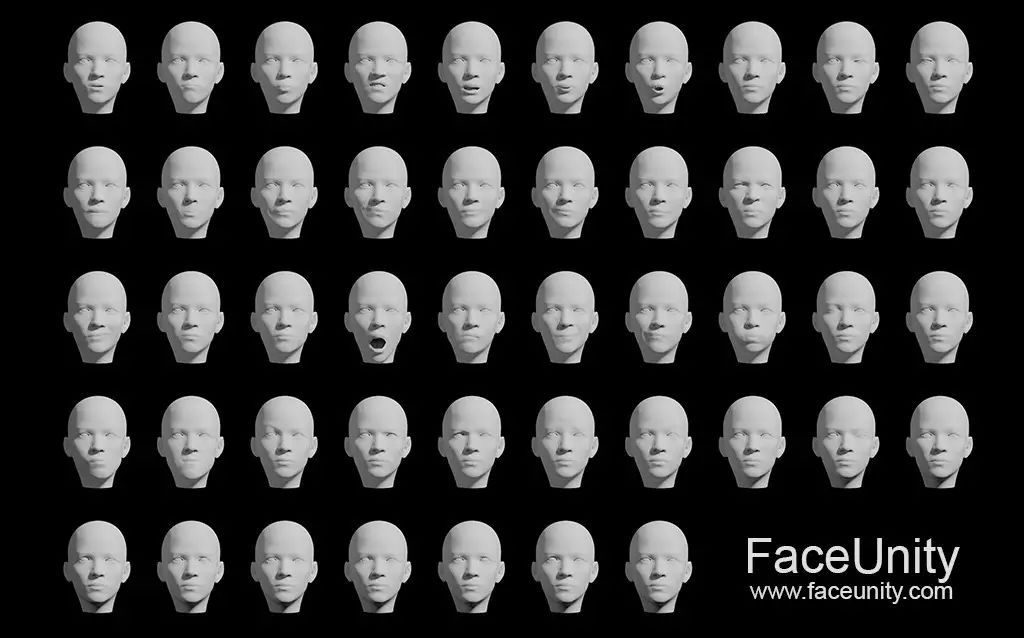

相芯科技识别的表情系数代表了 47 个面部肌肉运动组成,非常接近苹果方案中的水平。以此表情系数为媒介,可以实现精确的表情转移,和各种不同风格的虚拟形象进行表情的同步。

图丨相芯科技的技术驱动多种不同类型的虚拟形象

然而,从应用的层面来看,开发类似应用的一大门槛在于虚拟形象的制作,要实现完整并且精准的表情驱动,意味着需要针对一个形象制作 40-50 个不同的面部肌肉模型,对应用快速开发迭代形成巨大的障碍。

图丨一个可驱动虚拟形象的所有面部肌肉模型

针对虚拟形象制作成本高昂的问题,相芯科技还拥有一套全自动的虚拟形象生成技术。只需要一张照片,就可以生成个性化的虚拟形象,即所谓的 Photo-to-Avatar(P2A)技术。用户可以通过拍摄,或者在手机中选择一张清晰的人脸照片,P2A 技术即可根据人像自动生成与照片人物高度匹配的全动态 3D 虚拟形象,生成的 3D 虚拟形象能被相芯科技实时人脸表情跟踪与动画 SDK 所驱动。

图丨用户通过普通手机拍摄一张照片,然后生成与自己容貌相仿的虚拟形象

如何去解决这些问题?这就会涉及到包括计算机图形学、计算机视觉以及机器学习等众多交叉领域。比如虚拟形象生成,会用到端对端的 3D 深度神经网络。

简单来讲就是,输入一张照片,经过一个黑盒子处理,出来的就是一个 3D 模型。而这个黑盒子其实就是现在的人工智能。这套 AI 系统需要做的事情包括抓取特征点、识别性别、识别配饰等。除了做普通的人脸识别外,还要创造出一个 3D 形象,且这个形象要与输入的 2D 照片高度匹配。

此外,相芯科技并没有止步生成虚拟头像,而是进一步延伸到了全身,完整的虚拟形象包括用户的肢体动作、衣着打扮、周围环境等,都可以做相应调整,完全契合各种 3D 应用。

图丨除了面部表情捕捉与驱动,虚拟形象还可以调整动作、衣着、环境等因素

相芯科技之所以将 Animoji 这一类实时面部表情捕捉与驱动进行了扩展,其背后的原因是,作为一种网络空间的虚拟形象,其实完全可以做得比物理世界中的形象更有表现力。比如夸张的表情,甚至一些动漫化的特征。毕竟,不是每个人都经过了专业训练,一些更富有张力的表现形式可能在社交和泛娱乐领域会有很好的应用,甚至包括未来的在线教育。

相芯科技目前主要专注于移动平台,未来 AR 什么时候能真正落地现在还很难说。但一旦这些技术成熟,虚拟形象就会成为一种必需品。因为在虚拟现实环境下,用户不可能还是以 ID 或静态照片的形式存在,而必须有一个 3D 的、互动功能完备的具体形象。

我们也有理由相信,苹果 ARKit 平台在早前的布局,iPhone X 及其面部识别相关技术的随后推出,已经为 AR 的真正落地打开了一条路。全新的 A11 Bionic 芯片、原深感摄像头、红外摄像头、点位投射器,以及一系列软硬件技术,将远远不止为手机刷脸解锁,或者刷脸支付这么简单。可能真像 iPhone X 的广告语:“Say hello to the future”那样,当未来来临时,我们希望能看到更多来自中国的科技公司的身影。

-End-

校审:郝锕铀

《麻省理工科技评论》中英文版APP1.0版已正式上线,长按识别图中二维码,或点击“阅读原文”下载

欲知会员计划详情,请点击以上图片