目录

-

GPU连接方式:PCIe还是UBB?

-

4颗144 lane PCIe Switch的价值

-

电源3200+9600W、CPU/GPU散热区域隔离

-

I/O不妥协:24个满血PCIe 5.0 x16插槽

-

豪华散热器取巧达成“1U”双CPU 500W

-

原则上只能用被动散热,因为卡的安装方向…

-

PCIe Switch to CPU上行链路:为何有一点不对称?

-

GPU服务器对CPU的要求

刚过去的一个周末,IT新闻基本上又被DeepSeek刷屏了。从春节到现在,加班的同行朋友是不是比以前多了?

GPU连接方式:PCIe还是UBB?

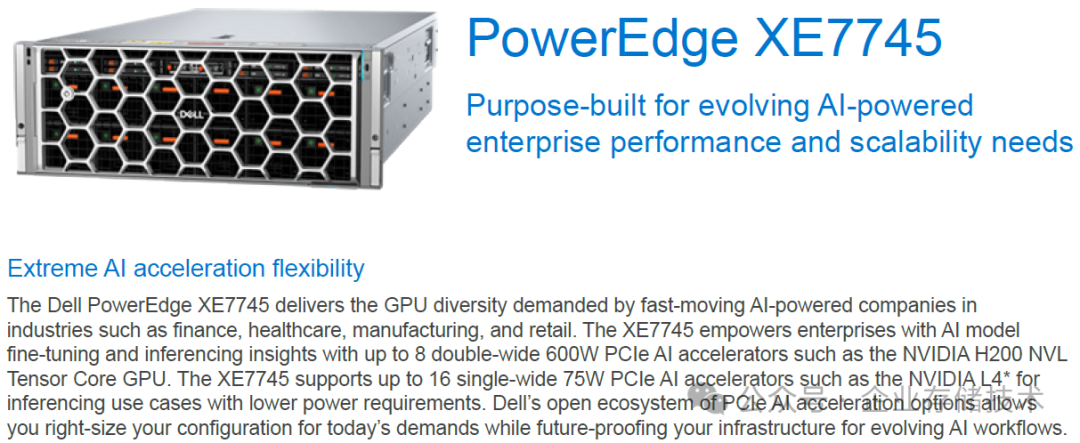

上图是一款4U 8卡(或单宽16卡)的AI服务器,支持可以4卡互连的NVIDIA H200 NVL GPU。其实XE7745这个机型我在《

风冷、液冷GPU服务器密度提升 - PowerEdge 17G整机架预览 (2)

》中已有过简单介绍;我还在《

3U 8卡:对AI推理服务器意味着什么?

》中实物讨论过另一款接近的服务器——Lenovo SR675 V3。

凭借在GPU卡顶部的

4-way NVLink

bridge,4块H200 NVL的显存能够“打通”,

141GB x 4=564GB

。此时8卡机可以当作2个节点,如果用

FP8精度跑LLAMA 3 405B这种规模的大模型推理

,应该是挺合适的。

但随着DeepSeek V3/R1 671B模型的开源,以及人们对全量参数的崇拜,上述配置想“满血”推理就不够完美了,除非量化到int4。似乎只有像H20、MI308等UBB模组,具备GPU高速全互连的AI服务器才是好马配好鞍?

扩展阅读:《

解锁DeepSeek-R1 671B FP8推理性能:5,921 token/s @ AMD MI300X

》

当然大家也知道H200等有些AI芯片是禁售的,我只是拿它从技术角度举个例子。而我认为这个思路,对NVIDIA以外的PCIe AI加速卡(包括国产)也能做个参考?

毕竟大模型参数的提高,

显存/内存容量

是一个很重要的门槛。另外像《

DeepSeek-R1 671B最小化部署实验:CPU+192GB内存

》这种拿CPU做低成本推理的尝试,容量够了

带宽

又会比较敏感。

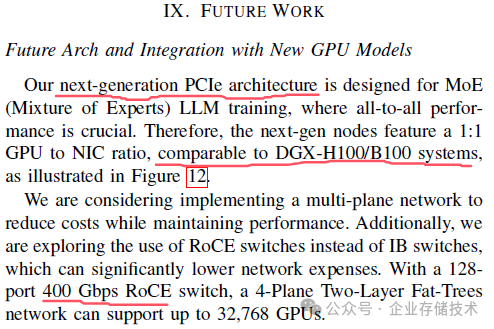

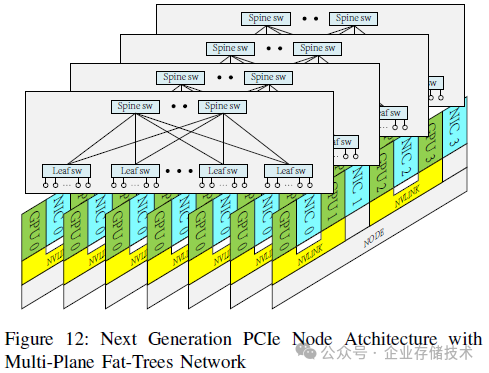

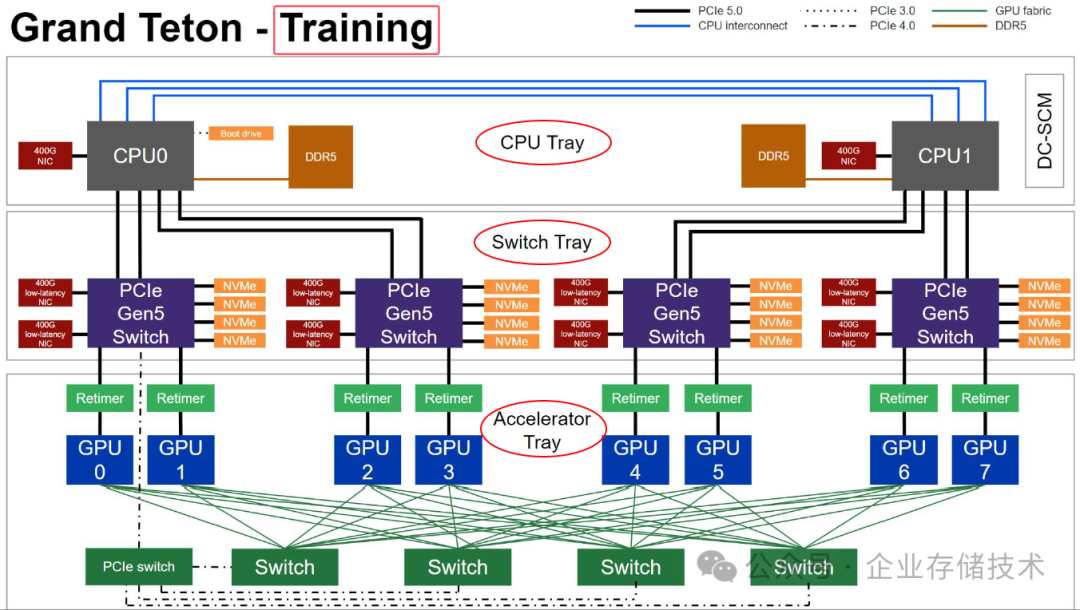

伴随着DeepSeek不断对外的开源&分享,更高效的推理方案可能并不一定要在单机显存中全部容纳671B参数,而是用多台主机组成的“超节点”分工协作。在这方面我还研究有限,下面先简单截取2张论文里训练架构的图片。然后还是重点讨论我的本行——服务器硬件。

注意:上面描述的是

MoE LLM训练(下一代PCIe架构)

,而当前DeepSeek官方说法是“

DeepSeek V3 和 R1 的所有服务均使用 H800 GPU

”。

上图显示的双卡NVLINK,有点像DeepSeek早先就拥有的硬件A100?无论未来是什么样的卡间互连技术,在大规模集群中还是要依靠

IB或者高速以太网

。另一方面,随着Qwen、DeepSeek蒸馏模型质量的提高,

更多的用户拿70B、32B乃至更小参数的模型也完全够用

,因此PCIe AI服务器仍然大有可为。

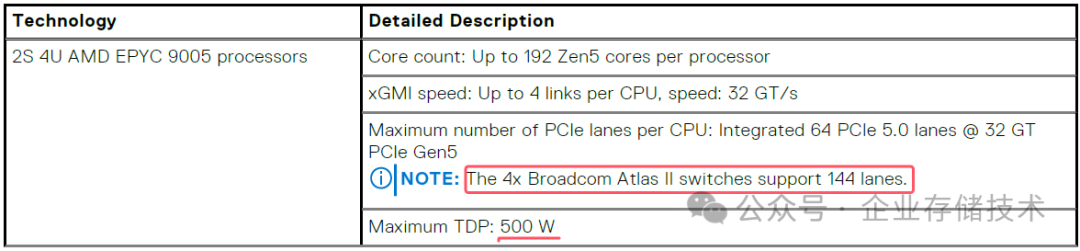

4颗144 lane PCIe Switch的价值

PowerEdge XE7745的重点就是支持

8块双宽600W

PCIe AI加速卡,或者16块单宽75W的——比如NVIDIA L4。

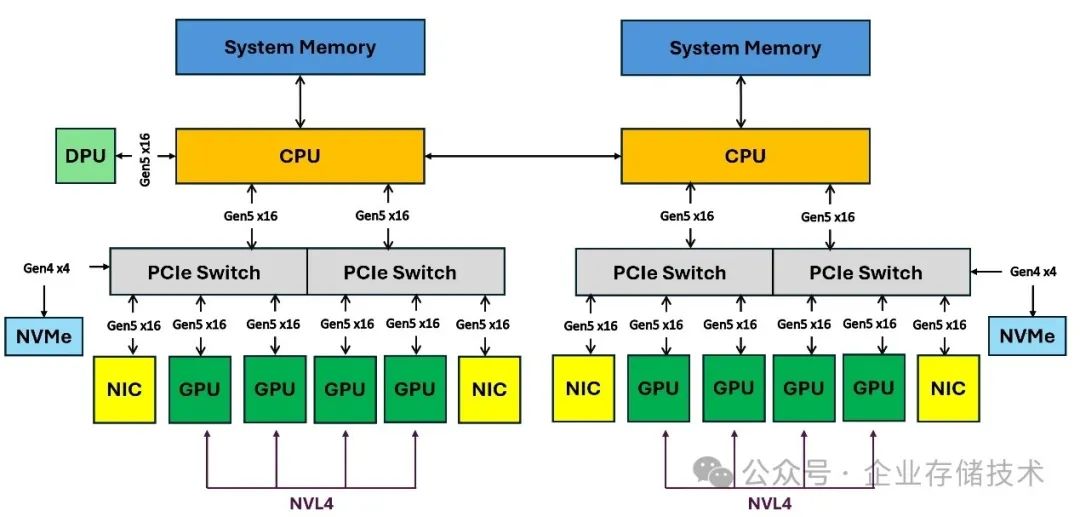

上面是Dell官方文档里的架构图,但我想说这个示意

并不完全准确或者说完整

,我会在下文中逐渐剖析这一点。另外我们也能从这里先了解到一些信息:

-

每颗CPU通过2颗PCIe Switch,各自连接2个GPU;

-

网卡和NVMe SSD都连接到PCIe Switch上,这样它们即可以被CPU使用,也能直连GPU,支持RDMA远程内存访问或者GPUDirect Storage这样的用途。

作为一款4U服务器,XE7745具备比3U更多的扩展空间,比如跟下图所示的SR675 V3简单比较:

SR675 V3也是基于AMD EPYC平台,该机型是用2颗PCIe Switch来连接8块GPU卡,做不到GPU与网卡之间的1:1配比。我认为对于AI推理用途,这款3U 8卡机型更适合跑单机而不是拼多节点集群,当然多台之间用Nginx跑负载均衡并发是ok的。

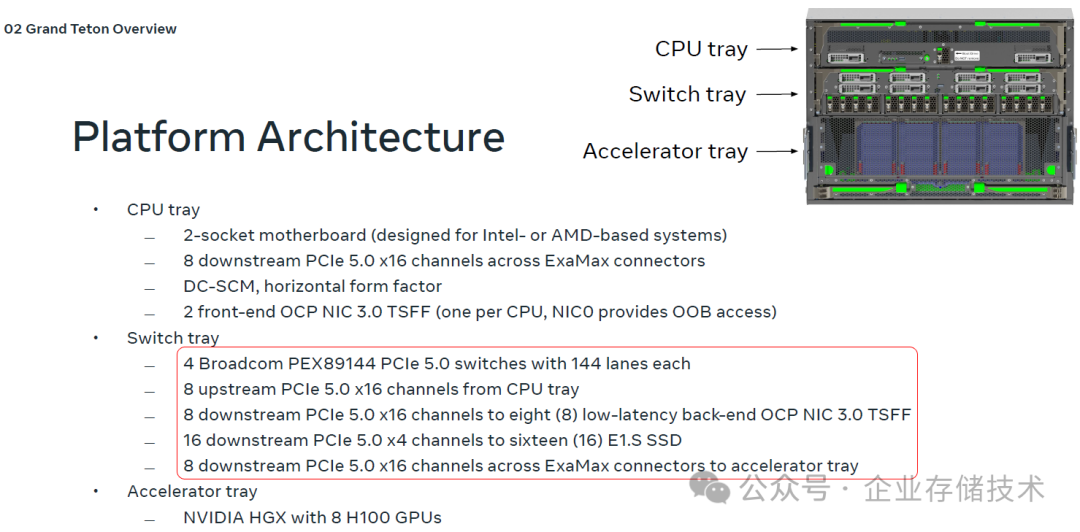

Dell XE7745使用了4颗Broadcom 144 lane PCIe Switch,显然成本更高。这也又一次让我想起了

OCP(Meta)的Grand Teton

机型。

Grand Teton有一个专门的Switch tray。XE7745实际上也是分成了2个Tray,集成度比Grand Teton要高一些。上面有些可以参考的我先列一下:

4x

PEX89144

PCIe 5.0 Switch,一共提供:

-

8x上行PCIe 5.0 x16到CPU;

-

8x下行PCIe 5.0 x16到8个OCP NIC 3.0网卡;(XE7745支持8块网卡是PCIe AIC形态的)

-

16x下行PCIe 5.0 x4到NVMe SSD;(XE7745支持8个SSD,这里不算BOSS盘)

-

8x 下行PCIe 5.0 x16到GPU/AI加速器。(XE7745最多支持16个GPU/AI卡)

Dell XE7745设计不完全一样很正常,下面是Grand Teton用于

训练

配置的架构图:

我在以前的文章中还列出过Grand Teton用于

推理

的配置——主要是去掉了连接在PCIe Switch上的网卡

。而这次我介绍的XE7745,可以说是兼具2种用途支持的。

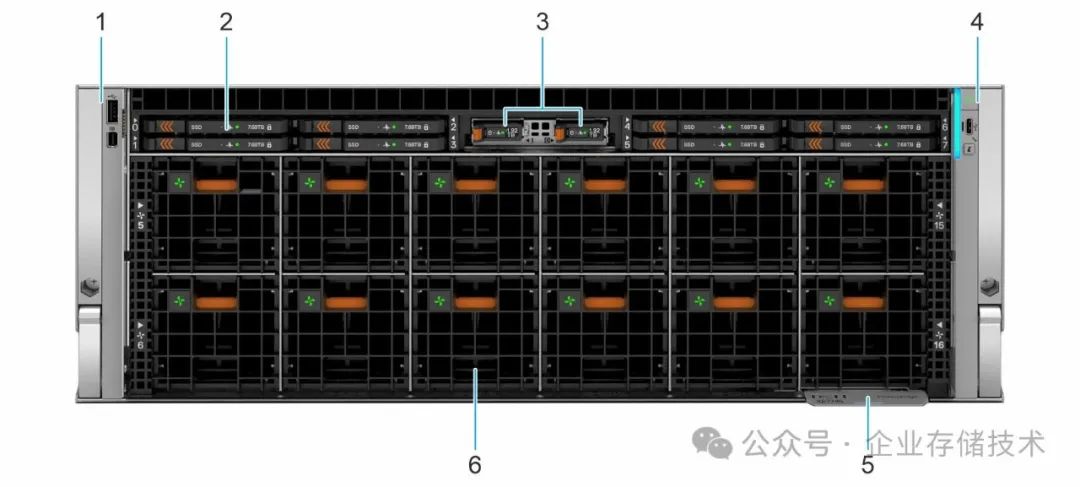

电源3200+9600W、CPU/GPU散热区域隔离

XE7745前面的12个风扇,都是主要针对GPU/AI加速卡的。上面有8个E3.S SSD,以及BOSS系统盘位。本地存储容量是个可选项吧,像人家DeepSeek/幻方不就开源了3FS存储集群的文件系统嘛。