本文内容非商业用途可无需授权转载,请务必注明作者及本微信公众号、微博ID:唐僧_huangliang,以便更好地与读者互动。

接前文:《

Dell PowerEdge R940

解析:四路顶配服务器维护平民化

》

《

Dell PowerEdge R740xd

解析:服务器只看参数那就错了

》

《

Xeon SP

服务器的

M.2 SSD RAID

:揭秘

PowerEdge 14G BOSS

》

《

Dell PowerEdge R640

:

NVMe

直连、

NDC

网卡、

PERC10

一览

》

尽管以前

Dell

等

OEM

大厂也提供

2U 4

节点服务器机型,但该领域受关注更多的似乎是

SuperMicro

、广达这样的

ODM

厂商。

在互联网公司这一轮兴起之前,计算密度高的

2U 4

节点最初用于

HPC

应用多一些,该部分市场有些不温不火——增长更多在于

GPU/

协处理器。

如今策略变化的原因是什么呢?

不知您的答案是否和我一样——

超融合

。

最近写的新一代

Xeon Scalable

服务器主要是围绕

Dell

的机型,有读者朋友给我留言,能否分析下不同厂商的产品?

一旦涉及到横向对比,我都会比较谨慎。首先要对各家的产品有一定的了解,更重要的是客观中立,如果做不到则不如不写。既然这么说,我也做好准备谈一些

Dell

服务器设计上的限制,并尝试分析其背后的原因。

大功率

电源模块:

110V

电压下输出下降一半?

2U 4

节点的

PowerEdge C6420

,是本次

Dell 14G

服务器发布型号当中,我要写的最后一款。上面这台

24

盘位样机一共安装了

8

个

SSD

,每节点连接

2

个。

Intel OEM

给

Dell

的

SATA

接口

SSD DC S3610 800GB

C6420

的后视图。我们看到

1+1

冗余

电源的位置现在位于中间

,上一代的

PowerEdge C6320

电源模块在机箱最左边。

抽出其中一个节点,除了固化的管理网口、

USB 3.0

和

DP

显示输出等之外,右上方安装了一块

PCIe

网卡。除此之外还能扩展几个

PCIe

设备呢?请大家往后面看。

之前介绍另外几款

Dell 14G

服务器时没太注意电源部分。这款

2000W 80plus Platinum

(白金)电源模块的转换效率可达

94%

。需要注意的是,其最大交流输入电流为

11.5A

,也就是说

只有在

200-240V

输入时才能达到最大

2000W

的输出功率

,而在

100-120V

输入时只能达到

1000W

输出。

我们知道,

Xeon SP

的最高功耗可达

205W

,一个节点光是

2

颗

CPU

就有可能达到

400W

。所以

PowerEdge C6420

支持的电源模块有

1600W

、

2000W

和

2400W

三种。根据我的理解,在

110V

供电时也可以

将负载分摊到

2

个模块上

,支撑总体功率的同时牺牲一部分冗余能力。至于最佳实践,请以官方说明为准。

同时我也核对了

C6420

的另外两种电源模块规格,

100-120V

交流输入下,

1600W

电源的输出为

800W

,

2400W

的输出为

1400W

。我想

其他服务器厂商应该也会有类似的情况

,这一点

对于国内用户基本没啥影响

。

我又翻阅了上周拍的照片,

R940

用的

1100W

电源在

100-120V

交流输入下可输出

1050W

,而

R640

使用的

750W

输出功率则不受输入电压影响,供参考。

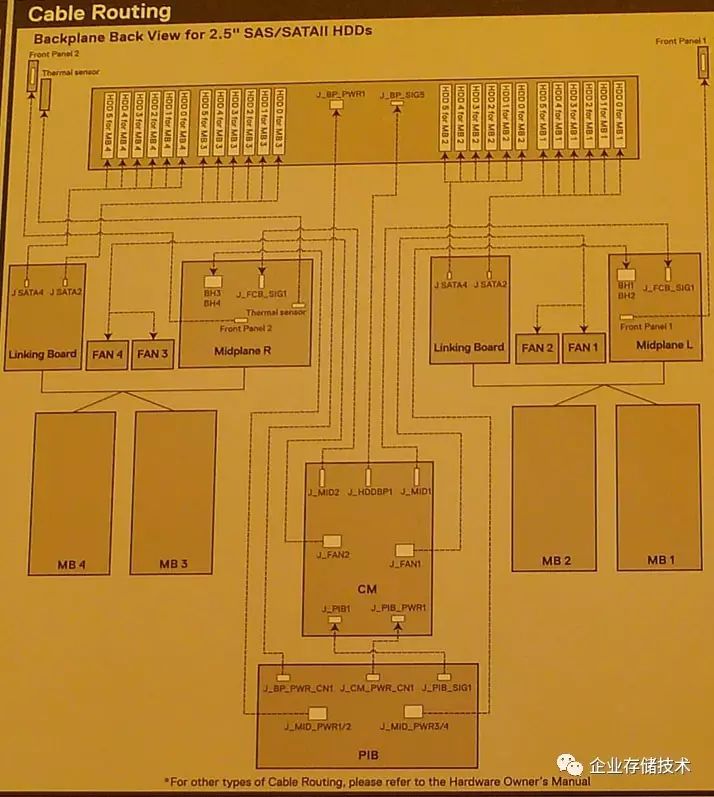

上图是

C6400

机箱内部的线缆连接示意,其中

MB 1-4

对应的是

4

个节点的主板,

Linking Board

负责连接驱动器,而

Midplane

、

CM

和

PIB

板则是用于供电转接、机箱管理(风扇控制)等。

Xeon 61xxF

、

81xxF

的

Omni-Path 100Gb/s

互连

这张照片就是其中一个节点,光线不够好请大家谅解:)除了位于下风方向的

CPU

散热器尺寸较大之外,左下方节点尾部可以看到有

PCIe

转接板的托架。

为什么两颗一样的

CPU

配不同散热器呢?我想不少朋友都知道,右边处理器更靠近系统风扇,散热气流会先经过它,带走热量并升温后再经过左边的

CPU

。或者说

位于风道后面的

CPU

进风温度更高

,而风压则较小一些,所以

散热压力相对较大

,就要靠散热器补回来。

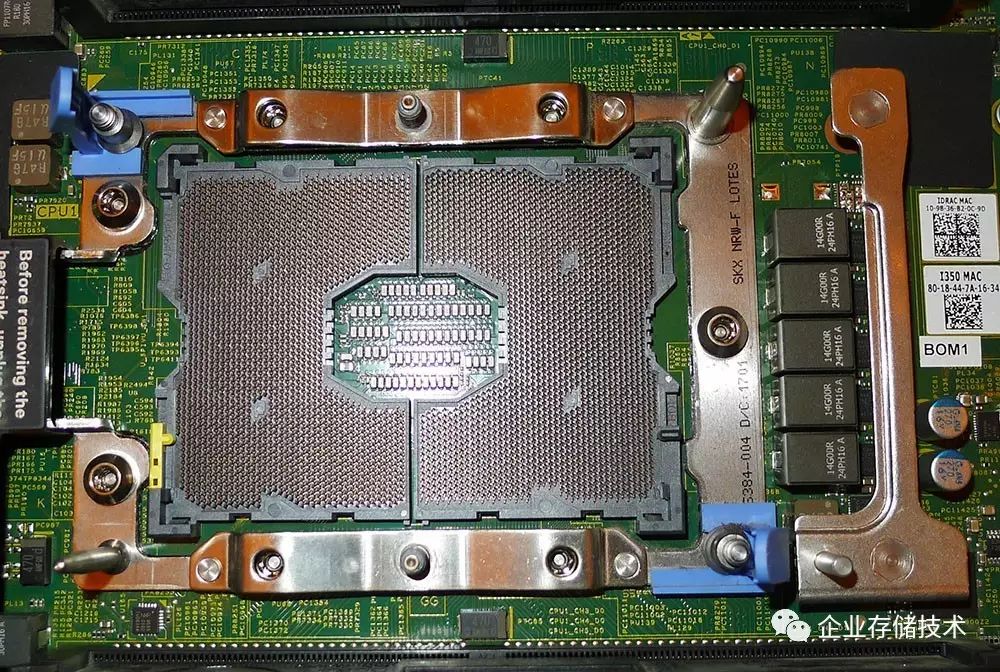

LGA-3647

这一代

CPU

的

Socket

成本看来较高,而易用性也相当到位。首先

CPU

不用锁扣而直接靠散热器压在插座上,其次有防呆设计不用担心散热器方向装反。

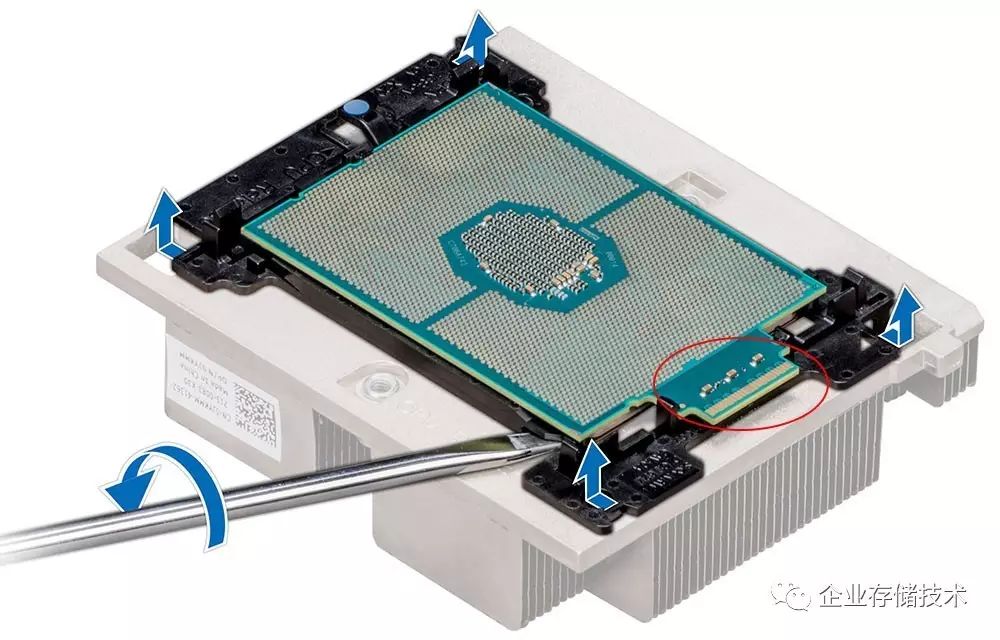

在

介绍

PowerEdge R940

的文章

中我曾提到拆散热器时

CPU

会被被硅脂粘下来,下面有一张分离操作的示意图。

大家可能也看到了,该示意图中用的

CPU

有点特别,也就是本次推出的

Xeon Scalable

家族中带有“

F

”结尾的型号。

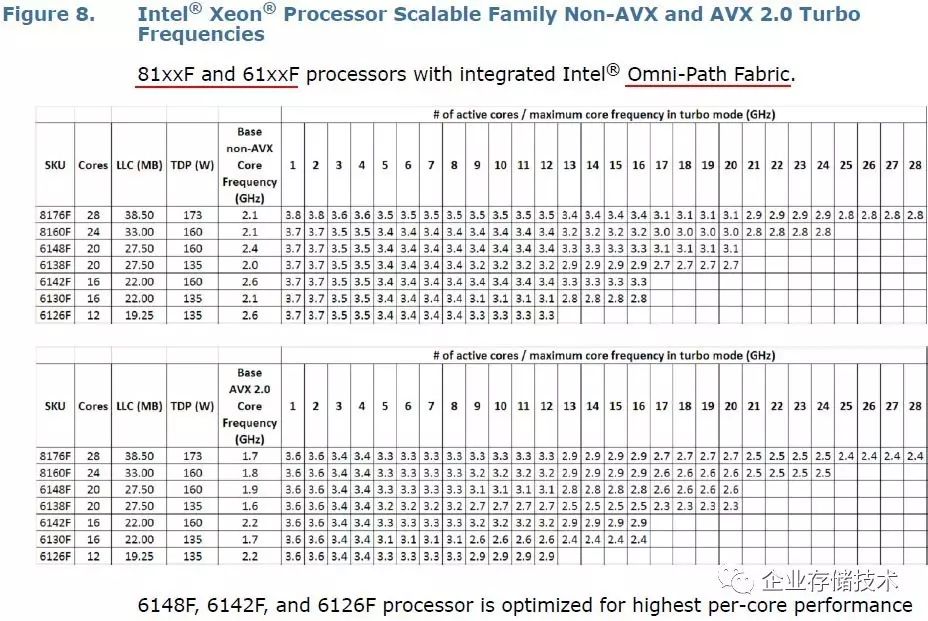

上图截自《

Intel Xeon Processor ScalableFamily - Specfication Update

》,当在

PowerEdge C6420

中配置这些

CPU

时,就多出了

100Gb/s

的

Omni-Path Fabric

(也称为

OPA

)

互连接口,目前主要用于

HPC

高性能计算,与

InfiniBandEDR

竞争。

关于

OPA

网络,我在一年前的《

Xeon Phi x200

要自我互连,

CPU

靠边站

》中就介绍过。当时赶上

Intel

发布了代号为

KnightsLanding

的

Xeon Phi Processor 7200

,不依赖传统

x86 CPU

就可以独立工作,其中就有集成

Omni-Path Fabric

互连的版本(上图右边)。

与此同时,

Dell

还推出了一款专门支持

Xeon Phi 7200

的

2U 4

节点服务器

PowedEdge C6320p

,和上图中的节点长得比较像。有了这个专门针对

HPC

的机型,可以说在

LGA-3647

和

OPA

方面提前积累了一些经验吧。

在上周

7

月

12

日的发布会现场,

Intel EPSD

展台上摆出了这样一块

OPA

接口子卡,相当于是

2

个

100Gb/s

的

QSFP28

接口物理层。

目前

Xeon 61xxF

、

81xxF

的用途明显还是高性能计算,对于

C6420

以外的

PowerEdge 14G

机型,可以通过独立的

OPA PCIe

扩展卡来获得类似功能。据了解

100Gb/s Omni-Path

卡的价格可能比

56Gb/s IB

还要便宜,另外交换机端口数上还有优势。虽说

Mellanox

的

IB

王国短时间内不会动摇,但他们或许需要更重视以太网市场了,比如未来空间巨大的

25GbE

。