![]()

在某些情况下,我们常常无法对自己的行为作出合理的解释。例如一场说走就走的旅行,一次奋不顾身的爱情,事后人们常常无法相信当时的自己究竟为什么会做出那样的选择。但这种情况毕竟是少数,大多数时候,我们都具有自我解释和自我认知的能力,而这一点也是人类与机器人(或者说人工智能)最大的区别之一。

一般我们所说的人工智能,其实说到底就是由一段程序代码组成的复杂运算系统,这个系统能够根据输入数据得出一个运算结果,而这个结果的外在体现就是人工智能。在通常情况下,我们只能看到输入的数据和最终的运算结果,至于中间的运算过程究竟怎样,则一概不知。

这会带来两方面的缺陷:一是当整个系统出现问题时,我们无法迅速准确地对问题进行定位并实施改进;二是当人工智能得到一个近乎完美的运算结果时,我们无法回溯整个过程,并从中汲取经验(雷锋网注:也就是我们常说的“AI决策黑箱”)。

现在有一个正在迅速成长的研究领域,正在试图改变这一现状。

拿图像识别的场景来说。通常的做法是:我们会将一系列的图像数据输入系统,然后系统会以既定的模式识别出图像中的物体,并予以标记。在现实场景中,每张图片包含的信息都非常复杂,这使得一旦出现标记错误,我们将很难回溯整个标记流程,从而也很难定位并解决问题。

日前来自加州伯克利大学和Max Planck信息研究所的科学家们发明了一种全新的图像识别算法,可以解决这一难题。该算法除了能够按照一般的流程对图像信息进行识别并加以标记之外,还能对产生这一标记的原始数据进行记录,并将这一原始数据“翻译”成人类可以理解的语言备份下来,方便研究者们回溯和检查。

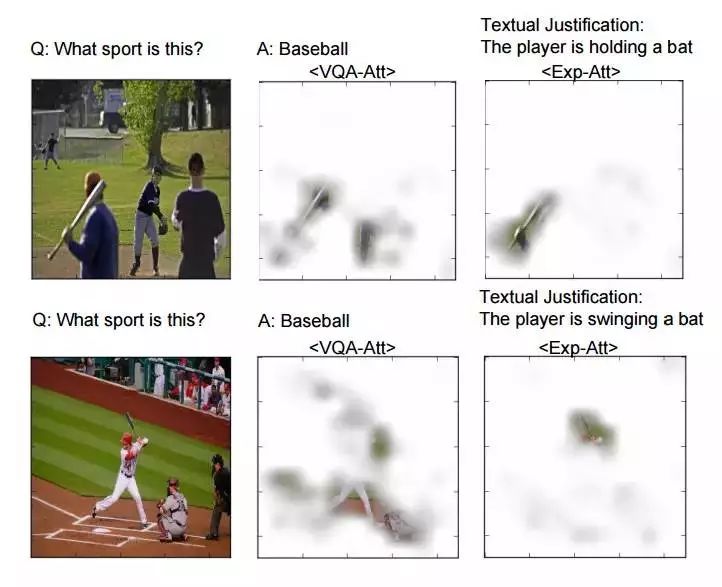

根据团队发表的论文,目前这一算法还仅限于识别图像里的人物动作信息(例如这个人是在打棒球还是骑自行车),而且需要基于两种不同的数据集合的支持。第一个集合是关于图像信息本身的,包括图像、图像的初步描述、以及图像的进一步说明。

例如一个打棒球的照片,描述信息可以是“图中有一个棒球棍,以及一个人握着它”,说明信息可以是“这个人正在握着棒子挥舞”。第二个集合是关于图像信息解释的,其中包括三个图像的相关问题,而且针对每个问题要给出10种可能的答案。例如问:“这个人是在打棒球么?”一种回答可以是:“不是,因为图中没有棒球棍。”

正是基于上述两种数据集合的支持,当某个利用了这种算法的神经网络系统被问到为什么将图片描述为“打棒球”时,它就可以追溯到最原始的定位信息,并将之描述出来:例如它检测到图中出现了一个棒球棍,以及一个人在握着这根棒球棍挥舞,因此得出结论这是一个打棒球的照片。研究者们称之为“标记并解释”系统,因为它不但能描述一张图片的内容,还能指出为什么得出了这样的结论。

微软首席研究员Kate Crawford在评论中指出:工程师们已经开发出了能够自动识别不同种类的猫、狗或者其他内容的深度学习系统。虽然这些系统的表现随着研究的深入正在变得越来越好,但人们始终无法搞清楚背后的逻辑,即为什么系统会得到这个结论。

Kate Crawford的观点触及了机器学习领域的一个核心问题:当一个算法进行自我学习时,它只能根据研究者输入的数据(可以是文本,也可以是图像或者视频等),提取出关键的信息,并将这些信息按照只有机器自己才能理解的方式加以归类和整理,这一过程完全不需要人类的直接参与,人类也无法加以观察和控制。

波士顿大学计算机学科的教授Kate Saenko表示:实际上并没有人能够设计一个深度神经网络。人们只是设计了这个系统的算法,并提供了相应的数据集合,剩下的都由系统自主完成。

所以,这就是来自加州伯克利大学和Max Planck信息研究所这一最新算法的重要意义:它能将机器内部的逻辑链条翻译出来展示给人类,而不是简单的仅仅给出一个结论。

欧洲计算机视觉联会的主席,Facebook访问学者Devi Parikh表示:这一算法的难点不在于解释一个结论本身,而是如何以人类能理解的方式表述出来。因为如果你看到过机器内部的运算流程,就会发现其中所有的参数和中间变量都是以数字的形式出现的,有些数字甚至长达数百上千位。因此,从内部的运算逻辑中找到一个结论的源头数据或许并不困难,真正困难的是如何将这一长串数字翻译成人类能够理解的语言。

虽然目前来看,来自加州伯克利大学和Max Planck信息研究所的这一最新研究成果还非常具有局限性(例如只能识别人类的动作)。但更重要的是,它为我们指明了一种未来可能出现的现实场景:不但能够从机器那里得到一件事情的具体决策,还能像跟朋友聊天一样询问它得到这一结论的原因。未来,随着我们赋予机器越来越关键信息的决策能力(例如自动驾驶),这种能够自我解释的机制也将变得越来越重要。

当然,如果像此前的报道那样,机器有一天也终于学会了骗人,那就是另一个故事了。

来源:Quartz

本文作者 | 恒亮

本文责编 | 岑峰