本论文首次探讨了医学影像生成中的公平性问题,并提出了一种基于公平贝叶斯扰动的FairDiffusion方法,同时构建了标注有多维敏感属性的FairGenMed数据集。通过对比实验,验证了该方法在整体图像质量和群体间公平性(基于ES-FID、ES-IS和ES-AUC指标)上的双重提升效果。未来,我们将进一步扩展数据集规模,丰富敏感属性维度,并探索更多应用场景下的公平生成策略,以推动医学生成模型在全球医疗影像领域实现更普惠且公正的应用。

论文标题:

FairDiffusion: Enhancing Equity in Latent Diffusion Models via Fair Bayesian Perturbation

论文链接:

https://arxiv.org/abs/2412.20374

数据集和代码链接:

https://github.com/Harvard-Ophthalmology-AI-Lab/FairDiffusion

一、背景与挑战

随着人工智能在医学影像领域的广泛应用,文本到图像扩散模型(如Stable Diffusion)正逐步渗透到医学数据合成、医学教育和数据共享中。然而,尽管生成质量整体较高,模型在不同人口统计属性(性别、种族、族裔)上却存在明显差异。例如,实验表明,Stable Diffusion在生成女性、白人及非西班牙裔样本时图像细节和临床特征更为突出,而在男性、亚洲人及西班牙裔样本上则表现欠佳。这种不均衡现象直接影响了后续临床特征检测、病情预测及诊断准确性,进而可能加剧医疗资源分配的不公平问题。

此外,还存在以下挑战:

-

噪声建模与分布不匹配问题

扩散模型的噪声去除假设数据服从统一分布,但真实医学数据在不同群体间存在分布偏移,导致单一全局损失难以平衡各群体的生成质量。

-

公平性指标缺乏

传统指标(如FID、IS)只关注总体质量,无法揭示不同群体间的性能差异。因此,我们提出了ES-FID、ES-IS和公平AUC(ES-AUC)等新指标,用于量化群体间的公平性。

-

公平调控机制设计难题

如何在保证整体生成质量的同时,自适应地调节各群体的损失权重,是当前技术的一大难点。为此,我们引入了公平贝叶斯扰动机制,通过针对不同群体施加自适应高斯扰动,缩小群体间的误差差距。

公平性研究需要高质量且具备多维敏感属性标注的数据。为此,我们构建了FairGenMed数据集,其主要特点如下:

-

数据来源与采集

FairGenMed基于真实临床SLO眼底图像,数据采自一家大型学术眼科医院,覆盖2015至2022年期间的患者数据,并附带详细的临床指标(如青光眼风险、杯盘比、视野缺损程度等)。

-

多维敏感属性标注

数据集中详细标注了性别、种族、族裔、首选语言、婚姻状况等敏感属性,允许针对不同群体单独分析,揭示模型在弱势群体上存在的性能不足问题。

-

公平性问题的实际背景

在医学影像领域,不同群体由于生理差异和疾病风险的不同,在病理表现上可能存在细微区别。如果生成模型不能平衡学习这些差异,可能导致弱势群体的影像质量不达标,增加误诊风险,进而引发伦理和社会公平问题。

-

数据集意义

FairGenMed不仅为生成模型提供了充足且多样化的训练样本,同时也为公平性指标(如ES-FID、ES-IS、ES-AUC)的设计提供了坚实的数据基础,有助于推动医学生成模型在公平性与实用性上的双重提升。

三、方法与技术细节

在上述背景与数据集支持下,我们提出了FairDiffusion方法,其核心技术细节包括:

基础扩散模型损失:

标准LDM的去噪损失定义为

公平贝叶斯扰动机制:

为自适应调节各群体损失贡献,我们在损失中引入扰动因子

公平贝叶斯扰动机制:

为自适应调节各群体损失贡献,我们在损失中引入扰动因子

群体间损失差异量化为衡量批次内各群体误差的不均衡,我们定义了平均损失差异

群体间损失差异量化为衡量批次内各群体误差的不均衡,我们定义了平均损失差异

这一指标用于指导贝叶斯优化过程中扰动参数的更新。

贝叶斯优化与参数更新:

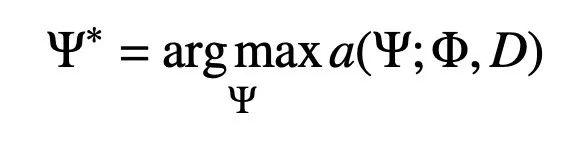

我们将扰动参数的最优求解转化为贝叶斯优化问题

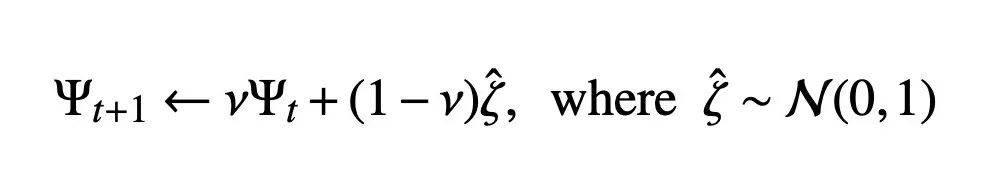

采用上置信界(UCB)作为采集函数,并用以下规则更新参数:

采用上置信界(UCB)作为采集函数,并用以下规则更新参数:

这一过程实现了探索与利用的平衡,逐步缩小群体间的性能差异。

公平评价指标:

除了传统的FID和IS指标,我们设计了公平扩展指标

以及公平AUC(ES-AUC)指标,用于评估生成图像与文本提示间的语义一致性。

-

图像视觉效果对比

在新增的定性可视化图(图2)中,我们展示了真实SLO眼底图像、Stable Diffusion生成的图像与FairDiffusion生成图像的对比。可以明显看出,FairDiffusion生成的图像不仅结构更为清晰,而且在纹理和细节上更接近真实图像,尤其是在原本容易出现模糊和细节缺失的弱势群体样本上,优势更为明显。

-

整体生成性能提升

如下面几张图所示,我们在SLO眼底图像上对比了FairDiffusion与Baseline模型(例如Stable Diffusion和Debiased Diffusion)的FID和IS指标。FairDiffusion取得了显著更低的FID值和更高的IS值,证明了其在整体图像生成质量上的优势。此外,通过ES-FID和ES-IS指标,可以看到各敏感群体(性别、种族、族裔)之间的性能差距明显缩小。例如,在白人、亚洲人和黑人群体中,FairDiffusion减少了最大误差差距(最大-最小FID值)的幅度,确保生成图像在各群体间更为一致。

-

在HAM10000皮肤病图像(图6,8)和CheXpert胸部X光影像(图6,8)上,我们同样验证了FairDiffusion的有效性。对于HAM10000数据集,下图展示了FairDiffusion在不同年龄和性别组上的ES-FID和ES-IS指标均有大幅提升;而在CheXpert数据集中,无论是针对性别还是种族的细分指标,FairDiffusion均实现了FID降低和IS提升的目标。这表明我们的公平贝叶斯扰动机制在跨模态任务中均能稳定发挥作用,提升各群体的生成质量和公平性。

-

语义一致性与临床相关性

我们还设计了分类任务,对生成图像与文本提示之间的语义相关性进行评估。通过公平AUC(ES-AUC)指标(图7),可以观察到FairDiffusion生成的图像与临床特征描述具有更高的一致性,特别是在青光眼和杯盘比的分类任务中,弱势群体的AUC值均有明显提升。这一结果进一步证明了方法在提升医学语义相关性方面的有效性。