接着第三块的内容,KVM磁盘性能方面的调优。磁盘IO方面我们可以从以下四个方面去着手优化:

磁盘类型选择

缓存模式选择

AIO 异步读写方式选择

磁盘IO调度器选择

磁盘方面,建议是用Virtio模式,在CentOS7.1 中,磁盘的类型有IDE 、SATA 以及virtio 三种。磁盘这块也有完全虚拟化和半虚拟化之分。virtio它就是半虚拟化的,最初是由澳大利亚的一个天才级程序员Rusty Russell编写,是一个在hypervisor之上的抽象API接口,它让客户机知道自己运行在虚拟化环境中,从而与hypervisor一起根据 virtio 标准协作,因此,virtio能让客户机中达到更好的性能(特别是I/O性能)。

关于使用virtio的测试数据,如下图所示,virtio模式的读写能力远高于IDE的:

图上淡紫色的数据条是virtio的数据,红色的是IDE的,性能几乎是相差很大。

所以大家在选择磁盘模式的时候,注意选择virtio模式,特别是在云环境里,你制作的虚拟机模版,最好选择virtio模式。

目前KVM这块支持5种磁盘缓存模式,writethrough、writeback、none、directsync或者unsafe。一般用到的就是前面3种,后面两种几乎不会使用。

writethrough:(直写模式)数据直接写入磁盘里,不使用缓存;在数据更新时,同时写入缓存Cache和后端存储。此模式的优点是操作简单;缺点是因为数据修改需要同时写入存储,数据写入速度较慢。

writeback:(回写模式)在数据更新时只写入缓存Cache。只在数据被替换出缓存时,被修改的缓存数据才会被写到后端存储。此模式的优点是数据写入速度快,因为不需要写存储;缺点是一旦更新后的数据未被写入存储时出现系统掉电的情况,数据将无法找回。

none:这种模式作用在Guest OS Pagecache和Physical Disk Cache中,相当于虚拟机能直接访问宿主机的磁盘,性能不错!

从图中可以看到,writeback采用了guest和host两层的page cache,也就是说同一个文件会存在两份cache,这是没有必要的,none和writethrough都会绕过host层的page cache。

低于QEMU-KVM1.2的版本kvm默认的cache方式是writethrouh,这种方式是最安全的,不会造成数据的不一致性,但是性能也是最差的。

总的来说,这三种模式,从安全和性能两角度分析,效果如下:

性能上: writeback > none > writethrough

安全上 :writeback

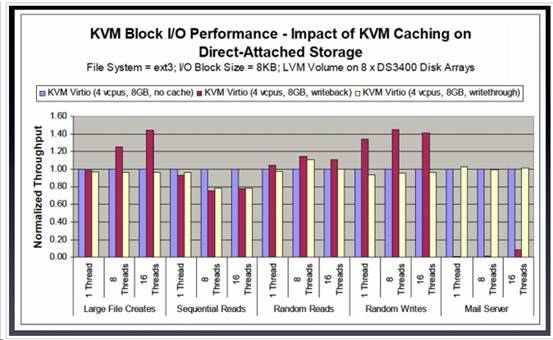

关于这三种模式的测试结果,如下图所示:

其中淡紫色的是 none模式,我们发现它的性能数据几乎很平均,所以选择它是最合适的方式,既安全稳定性能又不错。设置的方法也很简单,直接在XML里定义:cache='none'/> 加上cache='none'即可

综合数据的安全性和性能,建议选择none模式,注意CentOS下默认是none。

aio 这块分为两种,一种是native方式,还有一种是thread方式。

Linux系统上异步IO常见的有两种实现,一种是kernel native AIO,另外一种是threaded aio: user space AIO emulated by posix thread workers。

Kernel native AIO : Kernel的原生态异步IO实现。

Threaded aio : linux用户空间异步IO的实现,其实它不是真正的异步IO,是通过启动一定数量的 blocking IO线程来模拟异步IO。这种实现有不少缺点,毕竟有不少线程开销,还在改进中。

因此,我们KVM里选择AIO这块选择Kernel的原生态的native更好。

开启方式是:

目前Linux 磁盘IO调度主要有3种,NOOP ,Deadline ,CFQ 。

Deadline I/O scheduler :用过期时间来排序io操作顺序,保证先出现的io请求有最短的延迟时间,相对于写操作,给读操作更优先的级别,是比较好的一个调度模式。特别适合于读取较多的环境(比如数据库,Oracle 10G 之类)。

NOOP (elevator=noop): 这个调度模式会把所有的数据请求直接合并到一个简单的队列里。在有些SAN 环境下,这个选择可能是最好选择。适用于随机存取设备, 不适合有机械结构的存储器。因为没有优化顺序,会增加额外的寻道时间。属于最简单的一个调度模式,无视io操作优先级和复杂性,执行完一个再执行一个,如果读写操作繁多的话,就会造成效率降低。

CFQ I/O scheduler:完全公平队列,是anticipatory模式的替代品,没有过多的做预测性调度,而是根据给定的进程io优先级,直接来分配操作的顺序。这个模式在linux上表现良好,但也许并不是最适合android的io调度模式,太强调均衡,而降低了连续读写数据的性能。适用于有大量进程的多用户系统。

Linux默认是deadline,我们可以通过命令cat /sys/block/sd*/queue/scheduler查看:

如果要更改模式,我们就用:

格式:echo {SCHEDULER-NAME} > /sys/block/{DEVICE-NAME}/queue/scheduler

例:echo cfq > /sys/block/sda/queue/scheduler 改成cfq模式

这三种调度方式,得具体看你的虚拟机跑的应用去选择,一般的是选择CFQ模式。

参考链接:

https://segmentfault.com/a/1190000004549553

http://www.php-oa.com/2010/01/03/linux-io-elevator.html

宝哥,云技术社区专家,资深IT运维工程师,多年IT运维经验,擅长Linux,VMware&Openstack虚拟化,ELK大数据日志分析等运维技术,扎实的一线运维经验,目前在某大型云计算公司担任openstack高级运维工程师。

相关阅读:

2017版:KVM性能优化之CPU优化

2017版:KVM 性能优化之内存优化

高端私有云项目交流群,欢迎加入!

加入中国最活跃的OpenStack技术讨论QQ群,加群主QQ:502207183,并注明城市、行业、技术方向。