继Facebook、微软开发者大会之后,谷歌终于迎来了自己的主场——北京时间 5 月 8 日凌晨,一年一度的谷歌 I/O 大会在加州山景城如期开幕。

尽管过去一年谷歌过得相当不太平,被谷歌CEO桑达尔·皮查伊(Sundar Pichai)称之为“谷歌有史以来最为动荡不安的时刻”,这次大会依然吸引到来自全球的约3万名与会者,规模盛大。

Google I/O 2019 大会现场

Google I/O 2019 大会现场

微软 Build 大会推出多个重磅产品(详见今日推文第二条),谷歌 CEO 桑达尔·皮查伊显然并不希望被抢去风头。在阵阵掌声中,一个又一个新应用与新产品呈现在了人们的眼前。

腾讯刚刚升级的企业使命和愿景被定为“科技向善”,今天Google就用黑科技诠释了自己的愿景“

「Building a more helpful Google for everyone」

成为惠及每一个人的 Google

”,AI向善,情怀满满。

至于怎么服务和惠及每一个人,就需要落到具体的功能上——

2硬件,1系统,8AI新功能!

早在2016年的I/O大会上,谷歌就亮出了“从移动优先到AI优先(Mobile first to AI first)”的新战略。在长达两三个小时的开幕演讲里,AI几乎贯穿始终。

1. 谷歌搜索:融入3D摄像头和AR

谷歌宣布将增强现实(AR)融入到谷歌搜索中,只需在搜索框输入你想搜索的内容,即可将相关实物通过3D摄像头和AR技术,放到真实场景中。

比如只要用摄像头对准街道就能显示相应的信息,手机就会告诉你在哪能买吃的,从哪里进入会场。

他首先展示了Google News的搜索能力,搜索“黑洞”后,谷歌使用机器学习的方式推荐新闻,能看到一条展示黑洞是如何被发现的时间线。

你还能通过搜索找到你想要的播客(Podcast),就像搜索照片、文章一样,这些播客可以先存储下来以后再听。

另外,谷歌还将3D摄像头、AR和搜索结合在一起——

若是你搜索“骨架”,不仅可以看到一个三维且可旋转的骨架,你还可以在手机界面中将它放置在现实物体之上!

顺着这个思路,通过搜索可以查找New Balance的3D鞋子的款式,你可以直接把搜索到鞋子的3D模型并加入一个AR空间中,并和现实中的衣物进行搭配,你将迎来全新的搜索购物体验。

与昨天微软的 Hololens 演示不同,谷歌直接将 AR 鲨鱼放到了舞台上,非常惊艳!

2. Google Lens新增语音功能,35美元手机也能用

谷歌最近新推出的视觉搜索工具Google Lens也增加了新功能。

一个接地气的例子就是当你在餐馆里用餐时,可以用Google Lens可自动识别菜单,高亮显示最受欢迎的菜品,还可以在Google Map上的评价。

你也可以通过菜品的图片,可以直接搜索到菜品的做法,这给广大吃货们无疑是大福利。

更智能的是,Google Len在你就餐结束后帮你结账,计算小费以及每个人应付的价格。

这背后是Google强大的知识图谱和应用生态。据介绍,Google Len在Google Assistant、Google Photos和Google Camera中的使用已超过10亿次。

谷歌高管宣布功能在文本识别之外,又增加了语音朗读等更多智能化功能。

更令人惊喜的当属

Google Go的新功能——

它是一款入门级手机搜索应用程序,允许用户将摄像机指向一个标志,并翻译文本并以其母语朗读。

考虑到很多人看不懂英语,你只需用摄像头直接对准英文文字,就能听到它读给你,一边读一边将原文字显示高亮,还能将原文直接翻译成你读得懂、听得懂语言。

据介绍,谷歌计划让Google Lens支持英语、日语、中文等14种语言。同时,它的使用门槛非常低,容量压缩到100KB以下,可应用于入门级设备,连售价仅35美元的手机都可以使用这个功能。

3.网页上的Duplex

在上一届I/O大会上大秀实力的全双工Duplex又来了,Duplex可在手机上使用,现已在美国44个州推出,它只需一个语音命令,就可以代替人类与餐厅工作人员进行对话,为人类预订餐桌。

例如预订汽车租赁服务,它通过Gmail和历史记录了解您的旅行日期和您的汽车偏好,打开相应的网站,就可以代替你填写所有需要的信息,帮你选择你喜欢的汽车型号,你只需最后确认细节,就能快速完成订车过程。

谷歌高管表示,希望Duplex不仅能用于手机,还能用于网页(Duplex on the web)。现在谷歌正在为这一方向而努力,并将在今年晚些时候分享更多细节。

4.Google Assitant:惊人的响应速度

自2016年以来,Google Assistant都会作为I/O大会重磅内容推出,今年也不例外。

随着深度学习技术的进步,100GB的语音学习模型已经被缩减到0.5GB,已经可以搭载到设备中了,全程语音讲述,无需手动点击屏幕,可以看到系统的各项相应都极其迅速。

真人女助理在一旁做了现场演示,

速度堪称实时

,让现场尖叫连连!

而且,不必每次都说Hey Google

她可以进行“持续对话”

,你甚至可以通过语音交互,让 AI 帮助你分享一张照片。你甚至可以语音查询自己的航班行程。

语音触发邮件App,然后全程语音输入,识别准确率振奋人心。现场演示毫无卡顿。

可以看到演示的美女完全用语音就打开了手机相册,并通过语音能够精确定位到“有动物”的那些照片,选中图片后,又用语音发送并编辑了一条电邮,几乎演示者话音刚落,邮件就已经写完了,回复甚至可以加下划线。

全新Google Assistant通过深度学习将100GB模型压缩到1.5GB,可直接供移动设备使用,预计将在今年晚些时候推出的新Pixel手机上率先发布。

此外,谷歌推出Picks for you、个人参考(Personal References)功能,使得Google Assitant更好推断和理解用户的需求,提供更加精准的个性化推荐。

5.Google Assitant与Waze集成,唤醒驾驶模式

另一个有趣的更新是Google Assitant将在“短短几周内”内置于地图导航软件Waze中。

说“Hi Google,让我们开车”就可以进入驾驶模式,这个模式拥有一个一个极简主义的仪表板视图,重点显示您在驾驶时可能需要的内容,如方向、音乐等提醒。

在驾驶模式中,Google Assitant可根据日历上的预定为你推荐最短的路线,而且你的视线完全不需要离开路,就能打电话或完成其他任务。

并且今年晚些时候可以在任何使用Google智能助理的手机上使用。

另外在大会前一天,谷歌汽车操作系统Android Auto的新设计也被公开,新增暗色主题,看上去更为简洁大方,在导航的同时允许用户同屏访问多个应用。

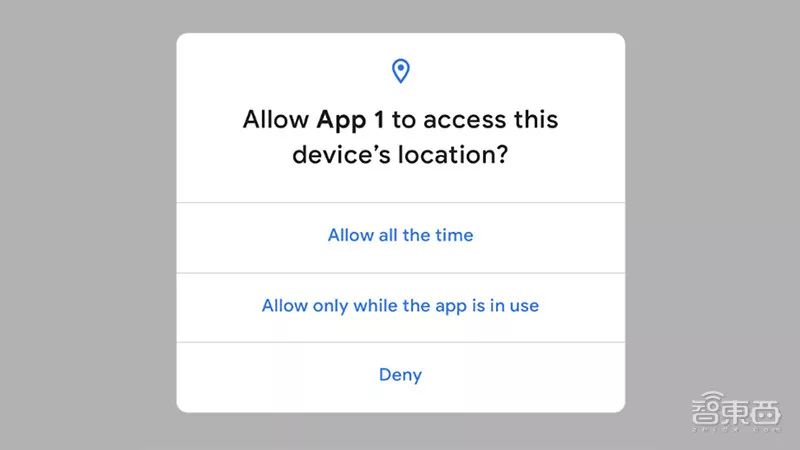

6.安全隐私:更多隐私设定,强调

Federated Learning

“

以隐私与安全为核心,开发我们的技术

”

,这是 Pichai 介绍过前面如此多强大的 AI 应用之后强调的重点。

在整个主题演讲中至少四次强调了安全隐私。

实际上过去一年多中,陷入隐私问题的不只是 Facebook,作为一家主要依靠广告攫取利润的公司,Google 掌握的个人数据并不会比 Facebook 少,而隐私问题也不会比 Facebook 更小。

谷歌已经在Chrome中使用了隐身模式(Incognito mode)超过十年,如今Google Maps和YouTube也都将推出该功能。

它就像在Chrome中一样,用户可以在地图上搜索某个地点,并在一个区域内自动导航,你的数据和位置记录并不会与你的用户相连。

“

我们想要使用更少的数据,为用户做更多的事。

”Federated Learning为谷歌的这一愿景提供了解决方案。

2016 年,谷歌提出

Federated Learning

用于解决

安卓手机终端用户在本地更新模型的问题,从而保障数据交换时的信息安全、保护终端数据和个人数据隐私,保证合法合规的前提下,在多参与方或多计算结点之间开展高效率的机器学习。

以谷歌 Gboard 为例,单独的设备上学习无法为用户主动推荐经常用到的词汇,但加上

Federated Learning

,就能在用户多次使用相关词汇之后自动推荐。如今,大量设备的 Gboard 都已经使用到了

Federated Learning

,在输入时为用户推荐单词与表情。

7.Live Caption:为视音频实时生成字幕

Pichai介绍说,全世界有5亿聋哑人,谷歌希望通过实时语音转录文本,让听不见世界的人也能和其他人高效沟通。

一位听力障碍人士在利用谷歌的 Live Transcribe「听」其他人讲话。

除了宣布在持续不断研究Live Transcribe这项转录技术外,Pichai重点介绍了一项新功能——Live Caption。

Live Caption可实现在线语音转录文本,能为任何音频或视频源添加了实时字幕。Pichai称甚至关闭视频声音,也可以生成字幕。

另外一个例子是Live Relay,该功能可帮助有听力障碍的人打电话,可以将对方的语音生成实时文字。

更贴心的是,Live Relay还利用了Google智能预测和回复功能。对打字内容做出预测。

不要担心打字速度跟不上语音,一切实时甚至“提前”进行,转写质量也很高,打字速度能跟上语音通话的速度。

这项技术也被叫作:不开口就能打电话。

聋哑人群体能更好享受智能手机和AI的便利了。

这些AI新应用也会在新安卓系统Android Q中能够使用。

8.Project Euphonia:帮助有语言障碍者高效沟通

在这一环节的最后,Pichai宣布推出Project Euphonia,以探讨AI如何更好地理解那些有语言障碍和其他类型语音模式的人。

在全球,有数百万的患者因为中风、帕金森、肌肉萎缩等疾病导致语言障碍,对于他们来说,难以与人交流,是一件让人极其沮丧的事情。

现在,Google 正在尝试解决这个难题——通过收集大量的语言障碍患者的对话数据,藉由 AI 技术进行建模,最终让小小的手机,也能够识别出语言障碍患者想表达的意思。

这是 2019 年 Google I/O 大会上极具人文主义的一幕,而这份人情味的背后,是 Google 深耕已久的 AI 技术在发光发热。

发布新一代安卓系统一直是谷歌I/O雷打不动的常规流程,Android Q的测试版在1个月前已经上线,并在4月份更新。

在更有用、更温情的 AI 面前,Android Q 反而变成了整场演讲中最为无趣的环节。在版本号来到两位数的时候,谷歌宣布,全球目前有25亿台Android设备,有180+合作伙伴。

此次谷歌发布的Android Q围绕着“

创新、安全和隐私

”三大关键词。

而整个 Android Q 的部分,实际上除了某些小修小补的功能之外,其实

更多还是对刚才 AI 应用落地的补充

。

另外还有一些其他亮点包括:

另一项重大更新是新支持与安全性相关的可单独更新的Android OS Framework模块。它们在后台进行无线更新,并且无需用户重新启动即可应用更新。

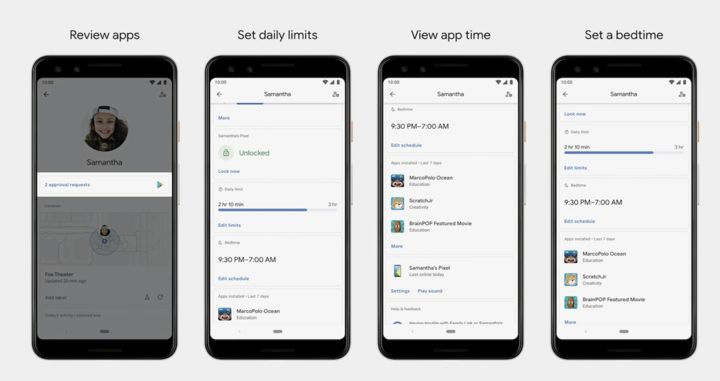

系统中还增添家长

控制模式

,家长可以对孩子玩手机的时间进行设置,这种设置可以具体到每一个应用程序的时间花费上,妈妈再也不用担心小孩沉迷于手机!

从今天起,Android Q的Beta版可用于13个品牌的21种设备,包括所有Pixel手机。

这13个手机品牌包括Pixel、一加、TEcno、小米、ASUS、华为、索尼、诺基亚、OPPO、LG、Essential、vivo、realme 。

这是谷歌首次在 I/O 开发者大会(而不是下半年的硬件发布会上)宣布新款 Pixel 智能手机,不出所料,它们就是 Pixel 3a 和 Pixel 3a XL。

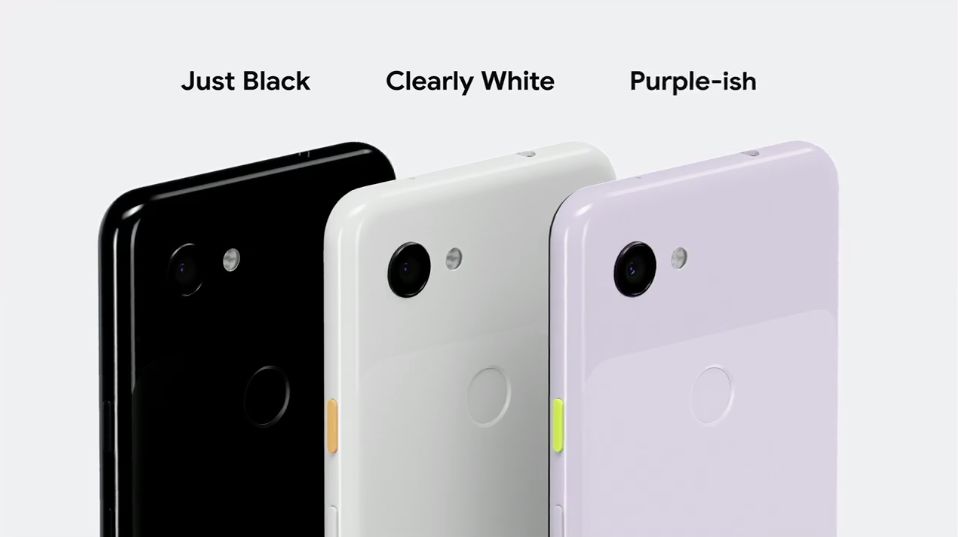

Pixel 3a 的整体设计与 Pixel 3 系列风格相似,但规格更小,入门价格只有旗舰机型的一半,3a 起售价格 399 美元,即日起开放销售。

3a 屏幕是 5.6 英寸,3a XL 则是 6 英寸。两款手机都保留了耳机插孔,并有亮黑、净白、有点紫三种颜色可以选择。

两款手机都采用中端处理器,不支持无线充电。不过,它们的后置摄像头与 Pixel 3 系列相同,这意味着相机拍摄质量与旗舰机型相同,并且也提供免费的无限量云存储。

Pixel 3a 保留了大受欢迎的增强夜拍功能。谷歌提供了 Pixel 3a 和 Phone X 的样张对比,夜景拍摄效果明显比 Phone 要强。

电池方面,单次充电可续航 30 小时。且快充 15 分钟,即可增加 7 小时续航。